目录

信息论基础

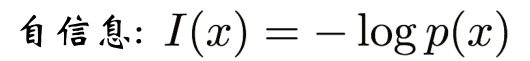

自信息

定义:

p(x)表示概率,如果 概率p(x)是确定性的度量,则自信息是对不确定性的度量

分两种情况,

情况一,独立事件的自信息

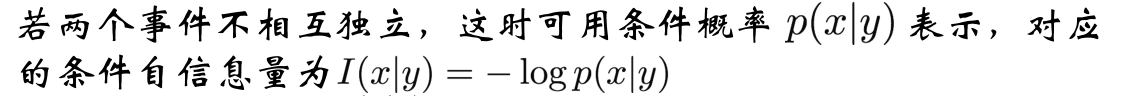

情况二,两个事件不独立的自信息

这里有个概念,就是非独立事件的概率求法是p(x|y) = p(xy)/p(y)

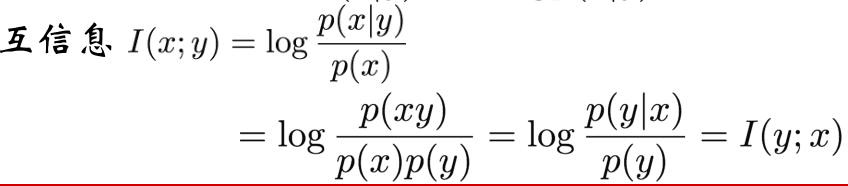

互信息的求法

熵

对平均变量的平均不确定性的度量

信息(信源)熵

通俗讲,信息熵也是熵,是对自信息量的一个期望值,遍历所有的先验概率空间的先验概率分布取值并乘上对应的自信息进行累加。

从上可以直到,H(X)表示的是一个期望,那么必定是大于等于0的,反过头看熵所定义的函数(表达一共概率分布函数到实值的映射)

看左边那个图,x(0,1),对应y都是正的,x(1,2),对应y都是负的。为什么为负呢?这不和刚才说的相悖了吗?其实是不矛盾的,因为熵函数的自变量x实际是上是p(x),即概率分布函数,p(x)肯定是大于0小于1的,换句话说,真正的函数图像应该是在x(0,1)之间的,如右图所示。

信息熵表示信源的平均不确定度,平均自信息量表示消除不确定度所需要信息的量度,两者数值上相等,但是意义不同

条件熵

那么,进一步

![]()

联合熵

条件熵和联合熵的关系

熵的基本性质

1.非负性

2.对称性

同一个熵函数,中的所有变量可以互换

3.确定性

4.最大熵定理

5.条件熵小于无条件熵

最大熵模型

最终可以概况为概率模型,最后的取值为概率值,大于某个阈值判为正,小于某个阈值判为负。

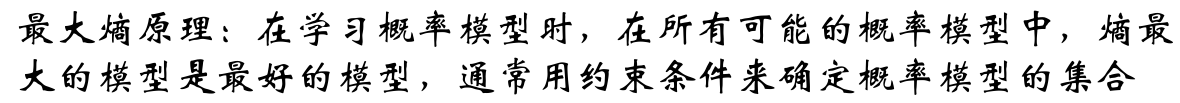

最大熵原理

目标:

最大熵模型的构建

可行解是其中一种解,也可以有其他解。但当没有先验的时候,最稳妥的是平均投,这就是可行解的由来。熵越大,模型越好

f(x,y) 是一个指示函数。

当采样趋于无穷的时候,采样分布相等于原分布,那就是两个模型中的信息期望是相等的。

依据熵的定义来建模。

最大熵模型求解问题转换为了约束优化问题,一般用拉格朗日法来求解。

要求是凸的才可以转换为对偶问题来求解。

求解过程:

反过头来,再看,整个过程就是下面的样子。

另一个求解方法

550

550

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?