赛题描述

赛事地址:科大讯飞锂离子电池生产参数调控及生产温度预测挑战赛

任务要求

初赛任务:初赛提供了电炉17个温区的实际生产数据,分别是电炉上部17组加热棒设定温度T1-1 ~ T1-17,电炉下部17组加热棒设定温度T2-1~T2-17,底部17组进气口的设定进气流量V1-V17,选手需要根据提供的数据样本构建模型,预测电炉上下部空间17个测温点的测量温度值。

数据集介绍

初赛任务:初赛提供了电炉17个温区的实际生产数据,分别是电炉上部17组加热棒设定温度T1-1 ~ T1-17,电炉下部17组加热棒设定温度T2-1~T2-17,底部17组进气口的设定进气流量V1-V17,选手需要根据提供的数据样本构建模型,预测电炉上下部空间17个测温点的测量温度值。

评估指标

初赛考核办法采用测试集各行数据的加热棒上部温度设定值、加热棒下部温度设定值、进气流量3类数据作为输入,选手分别预测上部空间测量温度、下部空间测量温度。将选手预测的上部空间测量温度、下部空间测量温度与测试集数据的测量值进行比较。采用MAE平均绝对误差作为评价指标。

赛题分析

本次比赛为数据挖掘类型的比赛,聚焦于工业场景。本赛题实质上为回归任务,其中会涉及到时序预测相关的知识。

通过电炉空间温度推测产品内部温度,设计烧结过程的温度场和浓度场的最优控制律:

任务输入:电炉对应17个温区的实际生产数据,分别是电炉上部17组加热棒设定温度T1-1 ~ T1-17,电炉下部17组加热棒设定温度T2-1~T2-17,底部17组进气口的设定进气流量V1-V17;

任务输出:电炉对应17个温区上部空间和下部空间17个测温点的测量温度值。

值得注意的是预测目标为34个,所以需要我们进行34次模型训练和预测。

同时数据规模比较小,可以快速处理数据和搭建模型,对于机器要求8g内存即可。

本次为结构化赛题,包含电炉烧结每个时间段的流量、上下部设定温度,以及预测目标上下部测量温度值。

基于LightGBM模型

在处理这个问题时,我们主要考虑的是回归预测。一种常规的解决思路是运用机器学习技术,例如 LightGBM 或 XGBoost,或者借助深度学习方法进行实践。当我们选择自行搭建模型的路径时,我们将面临更为复杂的挑战,包括构建模型结构以及对数值数据进行标准化处理。

然而,一个简易的解决方案可能就在我们眼前,那就是直接使用现成的机器学习模型。这种方法具有明显的优势,其模型使用简单,数据预处理的需求也大大减少。

总的来说,我们需要经过以下步骤来解决本问题:

数据预处理

切分训练集与验证集

训练模型

生成最后的预测结果。

在实施这些步骤的过程中,我们需要根据模型的性质和数据的特点灵活调整,确保每一步的实施都能最大化模型的预测准确性,从而有效解决这个回归预测问题。

Baseline详解

导入需要的库:

import pandas as pd # 用于处理数据的工具

import lightgbm as lgb # 机器学习模型 LightGBM

from sklearn.metrics import mean_absolute_error # 评分 MAE 的计算函数

from sklearn.model_selection import train_test_split # 拆分训练集与验证集工具

from tqdm import tqdm # 显示循环的进度条工具

读取数据:

# 数据准备

train_dataset = pd.read_csv("./data/train.csv") # 原始训练数据。

test_dataset = pd.read_csv("./data/test.csv") # 原始测试数据(用于提交)。

submit = pd.DataFrame() # 定义提交的最终数据。

submit["序号"] = test_dataset["序号"] # 对齐测试数据的序号。

MAE_scores = dict() # 定义评分项。

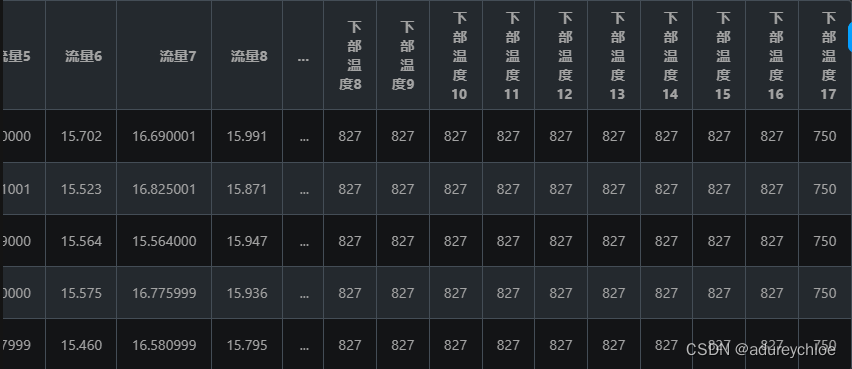

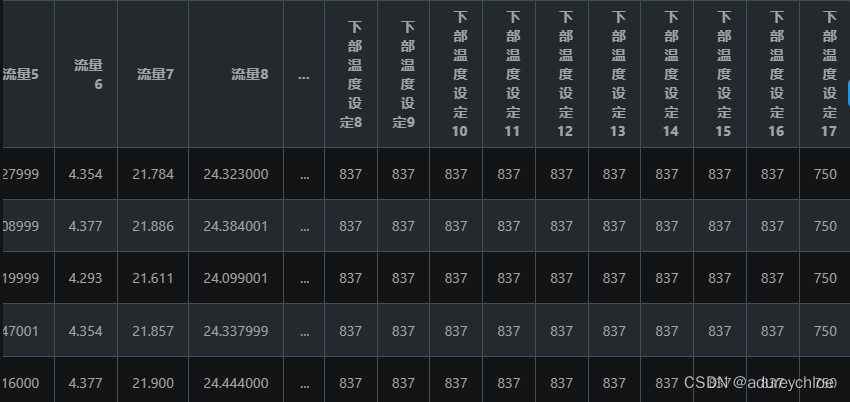

查看数据:

train_dataset.head()

test_dataset.head()

设置lgb参数:

# 参数设置

pred_labels = list(train_dataset.columns[-34:]) # 需要预测的标签。

train_set, valid_set = train_test_split(train_dataset, test_size=0.2) # 拆分数据集。

# 设定 LightGBM 训练参,查阅参数意义:https://lightgbm.readthedocs.io/en/latest/Parameters.html

lgb_params = {

'boosting_type': 'gbdt', #使用的提升方法,使用梯度提升决策树gbdt

'objective': 'regression', #使用的最小化指标

'metric': 'mae', #使用的评价指标

'min_child_weight': 5, #子节点中样本权重最小和,用于控制过拟合

'num_leaves': 2 ** 5, #每棵树上的叶子节点数,影响模型的复杂度

'lambda_l2': 10, #L2正则项的权重,用于控制模型的复杂度

'feature_fraction': 0.8, #随机选择特征的比例,用于防止过拟合

'bagging_fraction': 0.8, #随机采样的比例,用于防止过拟合

'bagging_freq': 4, #随机采样的频率,用于防止过拟合

'learning_rate': 0.05, #学习率

'seed': 2023, #随机数种子,保持结果的可重复性

'nthread' : 16, #线程数

'verbose' : -1, #可视化开关,-1为不打印,0为打

}

no_info = lgb.callback.log_evaluation(period=-1) # 禁用训练日志输出。

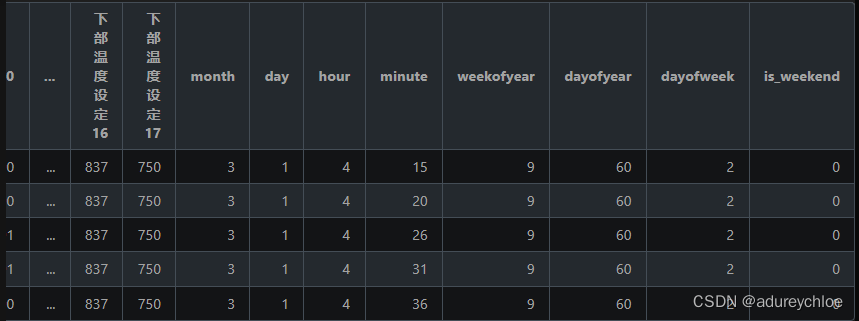

进行特征工程,主要是时间文本转换为时间格式,生成年、日、小时、分钟等时间特征:

# 时间特征函数

def time_feature(data: pd.DataFrame, pred_labels: list=None) -> pd.DataFrame:

"""提取数据中的时间特征。

输入:

data: Pandas.DataFrame

需要提取时间特征的数据。

pred_labels: list, 默认值: None

需要预测的标签的列表。如果是测试集,不需要填入。

输出: data: Pandas.DataFrame

提取时间特征后的数据。

"""

data = data.copy() # 复制数据,避免后续影响原始数据。

data = data.drop(columns=["序号"]) # 去掉”序号“特征。

data["时间"] = pd.to_datetime(data["时间"]) # 将”时间“特征的文本内容转换为 Pandas 可处理的格式。

data["month"] = data["时间"].dt.month # 添加新特征“month”,代表”当前月份“。

data["day"] = data["时间"].dt.day # 添加新特征“day”,代表”当前日期“。

data["hour"] = data["时间"].dt.hour # 添加新特征“hour”,代表”当前小时“。

data["minute"] = data["时间"].dt.minute # 添加新特征“minute”,代表”当前分钟“。

data["weekofyear"] = data["时间"].dt.isocalendar().week.astype(int) # 添加新特征“weekofyear”,代表”当年第几周“,并转换成 int,否则 LightGBM 无法处理。

data["dayofyear"] = data["时间"].dt.dayofyear # 添加新特征“dayofyear”,代表”当年第几日“。

data["dayofweek"] = data["时间"].dt.dayofweek # 添加新特征“dayofweek”,代表”当周第几日“。

data["is_weekend"] = data["时间"].dt.dayofweek // 6 # 添加新特征“is_weekend”,代表”是否是周末“,1 代表是周末,0 代表不是周末。

data = data.drop(columns=["时间"]) # LightGBM 无法处理这个特征,它已体现在其他特征中,故丢弃。

if pred_labels: # 如果提供了 pred_labels 参数,则执行该代码块。

data = data.drop(columns=[*pred_labels]) # 去掉所有待预测的标签。

return data # 返回最后处理的数据。

test_features = time_feature(test_dataset) # 处理测试集的时间特征,无需 pred_labels。

test_features.head(5)

训练模型并进行预测:

# 从所有待预测特征中依次取出标签进行训练与预测。

for pred_label in tqdm(pred_labels):

# print("当前的pred_label是:", pred_label)

train_features = time_feature(train_set, pred_labels=pred_labels) # 处理训练集的时间特征。

# train_features = enhancement(train_features_raw)

train_labels = train_set[pred_label] # 训练集的标签数据。

# print("当前的train_labels是:", train_labels)

train_data = lgb.Dataset(train_features, label=train_labels) # 将训练集转换为 LightGBM 可处理的类型。

valid_features = time_feature(valid_set, pred_labels=pred_labels) # 处理验证集的时间特征。

# valid_features = enhancement(valid_features_raw)

valid_labels = valid_set[pred_label] # 验证集的标签数据。

# print("当前的valid_labels是:", valid_labels)

valid_data = lgb.Dataset(valid_features, label=valid_labels) # 将验证集转换为 LightGBM 可处理的类型。

# 训练模型,参数依次为:导入模型设定参数、导入训练集、设定模型迭代次数(5000)、导入验证集、禁止输出日志

model = lgb.train(lgb_params, train_data, 5000, valid_sets=valid_data, callbacks=[no_info])

valid_pred = model.predict(valid_features, num_iteration=model.best_iteration) # 选择效果最好的模型进行验证集预测。

test_pred = model.predict(test_features, num_iteration=model.best_iteration) # 选择效果最好的模型进行测试集预测。

MAE_score = mean_absolute_error(valid_pred, valid_labels) # 计算验证集预测数据与真实数据的 MAE。

MAE_scores[pred_label] = MAE_score # 将对应标签的 MAE 值 存入评分项中。

submit[pred_label] = test_pred # 将测试集预测数据存入最终提交数据中。

submit.to_csv('submit_result.csv', index=False) # 保存最后的预测结果到 submit_result.csv

保存文件:

# 保存文件并查看结果

submit.to_csv('submit_result.csv', index=False) # 保存最后的预测结果到 submit_result.csv。

print(MAE_scores) # 查看各项的 MAE 值。

最后结果是7.94826。

改进baseline

早停法

由于模型有过拟合的风险,所以可以通过早停来让模型在一段时间不能得到提升后提前结束训练。lgb中可以通过添加参数来实现。

lgb_params = {

'boosting_type': 'gbdt', #使用的提升方法,使用梯度提升决策树gbdt

'objective': 'regression', #使用的最小化指标

'metric': 'mae', #使用的评价指标

'early_stopping_round':20, #早停,如果20轮没有提升就停止训练

'min_child_weight': 5, #子节点中样本权重最小和,用于控制过拟合

'num_leaves': 2 ** 5, #每棵树上的叶子节点数,影响模型的复杂度

'lambda_l2': 10, #L2正则项的权重,用于控制模型的复杂度

'feature_fraction': 0.8, #随机选择特征的比例,用于防止过拟合

'bagging_fraction': 0.8, #随机采样的比例,用于防止过拟合

'bagging_freq': 4, #随机采样的频率,用于防止过拟合

'learning_rate': 0.05, #学习率

'seed': 2023, #随机数种子,保持结果的可重复性

'nthread' : 16, #线程数

'verbose' : -1, #可视化开关,-1为不打印,0为打

}

添加特征

尝试提取更多特征,这里尝试添加交叉特征、历史平移特征、差分特征、和窗口统计特征;每种特征都是有理可据的,具体说明如下:

(1)交叉特征:主要提取流量、上部温度设定、下部温度设定之间的关系;

(2)历史平移特征:通过历史平移获取上个阶段的信息;

(3)差分特征:可以帮助获取相邻阶段的增长差异,描述数据的涨减变化情况。在此基础上还可以构建相邻数据比值变化、二阶差分等;

(4)窗口统计特征:窗口统计可以构建不同的窗口大小,然后基于窗口范围进统计均值、最大值、最小值、中位数、方差的信息,可以反映最近阶段数据的变化情况。

在时间特征函数中添加:

# 交叉特征

for i in range(1,18):

data[f'流量{i}/上部温度设定{i}'] = data[f'流量{i}'] / data[f'上部温度设定{i}']

data[f'流量{i}/下部温度设定{i}'] = data[f'流量{i}'] / data[f'下部温度设定{i}']

data[f'上部温度设定{i}/下部温度设定{i}'] = data[f'上部温度设定{i}'] / data[f'下部温度设定{i}']

# 历史平移

for i in range(1,18):

data[f'last1_流量{i}'] = data[f'流量{i}'].shift(1)

data[f'last1_上部温度设定{i}'] = data[f'上部温度设定{i}'].shift(1)

data[f'last1_下部温度设定{i}'] = data[f'下部温度设定{i}'].shift(1)

# 差分特征

for i in range(1,18):

data[f'last1_diff_流量{i}'] = data[f'流量{i}'].diff(1)

data[f'last1_diff_上部温度设定{i}'] = data[f'上部温度设定{i}'].diff(1)

data[f'last1_diff_下部温度设定{i}'] = data[f'下部温度设定{i}'].diff(1)

# 窗口统计

for i in range(1,18):

data[f'win3_mean_流量{i}'] = (data[f'流量{i}'].shift(1) + data[f'流量{i}'].shift(2) + data[f'流量{i}'].shift(3)) / 3

data[f'win3_mean_上部温度设定{i}'] = (data[f'上部温度设定{i}'].shift(1) + data[f'上部温度设定{i}'].shift(2) + data[f'上部温度设定{i}'].shift(3)) / 3

data[f'win3_mean_下部温度设定{i}'] = (data[f'下部温度设定{i}'].shift(1) + data[f'下部温度设定{i}'].shift(2) + data[f'下部温度设定{i}'].shift(3)) / 3

# 对平移后的空值进行填充

data = data.fillna(method='bfill')

这里要注意在平移之后第一个值会变成nan(因为没有前一个值),包括窗口统计的前3个值,因此需要用后填充的方式将其填充。

经过这两个操作后分数变为7.51948。

由于时间关系,暂时只做这两个改进,后续会进行更多探索。

2319

2319

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?