目标检测论文阅读:Bridging the Gap Between Anchor-based and Anchor-free Detection via Adaptive Training Sample Selection

论文链接:https://arxiv.org/abs/1912.02424

在https://www.zhihu.com/question/3595的问题下看到了一篇挺有意思的文章,去看了下。这篇paper的cascade r-cnn其实很多地方有点像:都是围绕着iou阈值和采样这方面做了一些文章;本身论述风格也很舒服,先从anchor-based与anchor-free的性能差异来着手。

1. 背景

anchor-based之前介绍过,目前主流有两种,一种是类似corner那种做关键点检测的,另一种则是FCOS那种每个点做一个单独的样本,paper重点讨论的是后者。先看一下retinanet和fcos的结构图:

抛出FCOS的center-ness分支,其实二者非常相似,但从网络来说,唯一的差别就是retinanet最后预测的通道数多了一个A的系数,用来标识每个位置的不同anchor。

那么问题来了,为什么两者性能差异这么大?只是预测方式的不同会产生如此巨大的Gap吗?

2. 实验分析

paper为了做公平的对比,做了如下两件事:

- 统一算法差异,如backbone和loss function等

- 将retinanet的anchor数量设置为1,每个location仅预测一个格子,和anchor-free预测一个样本对应

此时,两者的差异只剩下回归和分类的不同。回归差异主要来源于初始状态不同,一个从点回归预测距离,一个从框回归预测偏差:

分类差异主要是划分正负样本的不同,retinanet通过iou来进行匹配,同时gt大小也要符合每个level的scale;而FCOS则是主要通过location是不是在点的内部以及各个level的scale:

paper做的一个工作就是,把这两种不同的采样方式(基于iou/基于spatial和scale),以及两种不同的回归方式(box/point)两两组合,探究主要影响性能的因素,四组结果和对应的状态如下:

红色代表已有算法,绿色代表新组合出来的算法;我们发现,其实回归方式对性能几乎没有影响,影响最大的是分类的方式,更确切地讲,是划分正负样本不同所带来的差异。

作者没有说明这种现象产生的原因,个人理解,主要是因为anchor还涉及到一个初态的问题。即使anchor的中心点在目标内部,但是如果anchor设置的不好,也不容易得到比较好的正样本,anchor-free的方式则没有这个问题。因为anchor设置的有可能好,有可能不好,anchor设置得好,就需要高一点的iou去筛选样本;anchor初始状态不佳,就需要低iou去筛选样本。

3. 改进方法

作者提出了一种全新的ASTT模块,说白了其实就是一个自适应的Iou阈值计算模块,可以算每个level的阈值,方法如下:

简单来说:

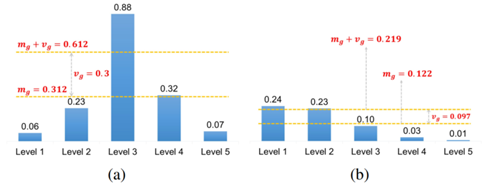

- 针对每个gt,计算它在各个level上和它最接近的k个anchor(根据anchor和gt中心点的距离)

- 计算每个level上,k个anchor的iou的平均值,假设有L个level,可以得到L个均值

- 计算2中L个均值的平均值和方差,两者的和作为最终阈值

说白了,这个模块其实做的事情就是:判断gt适合扔到哪个level上,同时根据anchor初始状态的好坏,给一个更恰当的阈值;之所以加上方差,就是为了防止有某个level的数据特别高(例如图(a))的情况;而平均值则可以计算anchor初始状态相对gt的好坏,作者说这样每个gt大概都可以得到0.2*kL个正样本

4. 实验结果

如果没有ASTT,anchor越多性能就越好,但是加上ASTT即使一个anchor性能也很不错。

ASTT也可以用到anchor-free上,具体方法是假设location位置处是一个8倍下采样率大小的正方形。另外这里的center sampling其实是类似foveabox的一种机制,只有gt中距离中心点最近的若干个点才被划分为正样本,有一定的提升效果但不如ASTT。

最终的实验结果:

原paper收录了特别多的检测算法的数据,ASTT应该是效果最好的。

最后关于这篇文章的思考和讨论,强烈建议大家去本文开始的链接看看作者本人的回答和一些讨论,珠玉在前,我就不献丑了。

174

174

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?