文章目录

意义

NER是信息提取、问答系统、句法分析、机器翻译等应用领域的重要基础工具,在自然语言处理技术走向实用化的过程中占有重要地位。

定义

NER就是通过序列标注对实体边界和实体类别进行预测,从而识别和提取出相应的命名实体。

任务目标

一般来说,NER的任务就是识别出待处理文本中三大类(实体类、时间类和数字类)、七小类(人名、机构名、地名、时间、日期、货币和百分比)命名实体。

- TODO 某个比赛形成的,待查

中文NER vs 英文NER

中文文本不同于英文文本,需要预先对其进行分词(基于字的方法),尽管分词工具有很多,但是分词效果不太可能是完美的。(易造成错误累积)

分词错误,就会直接影响实体边界的预测,导致识别错误,这在开放领域是很严重的问题。

常用模型

目前英文NER效果最佳的模型是LSTM-CRF。

中文

基于字符

虽然训练集规模变大,训练时间变长,但是研究表明,对于中文NER,基于字符的方法优于基于词的方法。

但由于没有进行分词,所以基于字符的方法无法利用句子中的单词信息(无法识别词汇边界)。比如一句话“南京市长江大桥”,如果没有单词信息,识别结果很可能为:“南京“,”市长”,“江大桥”。

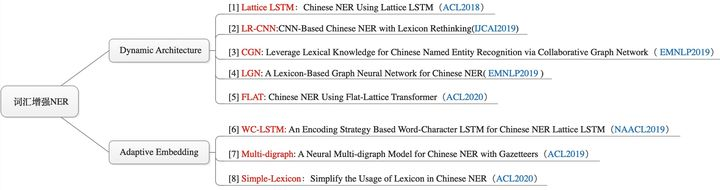

词汇增强Lattice

- 两种主线方法:

- Dynamic Architecture:设计一个动态框架,能够兼容词汇输入;

- Adaptive Embedding :基于词汇信息,构建自适应Embedding;

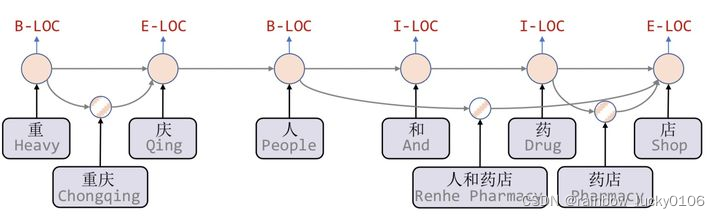

Chinese NER Using Lattice LSTM

https://zhuanlan.zhihu.com/p/143272435

通过Lattice LSTM表示句子中的词组,将潜在的词汇信息融合到基于字符的LSTM-CRF中。

- 潜在词组是指在字典中存在的以该字结尾的合理词组

FLAT: Chinese NER Using Flat-Lattice Transformer(2020 ACL)

Lattice-LSTM采取的RNN结构无法捕捉长距离依赖,同时引入词汇信息是有损的,同时动态的Lattice结构也不能充分进行GPU并行。

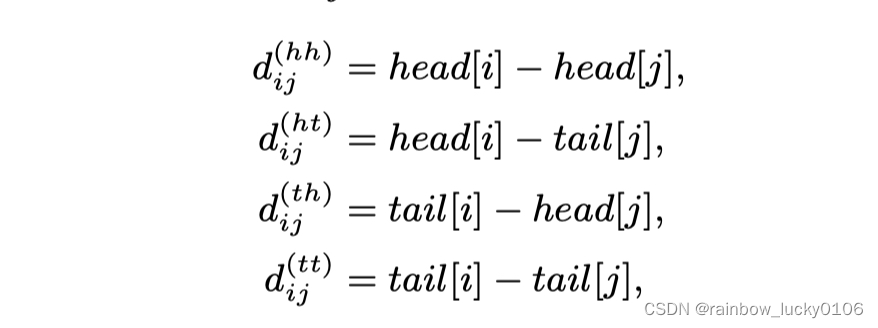

- Flat-Lattice Transformer:对于每一个字符和词汇都构建两个head position encoding 和tail position encoding.

- 词的head:词的开始位置。

- 词的tail:词的结束位置。

- 相对位置编码:用四种相对距离来表示xi, xj之间的关系。

Transformer在NER上效果不佳,解决方案

https://zhuanlan.zhihu.com/p/137315695

TENER: Adapting Transformer Encoder for Named Entity Recognition

效果不佳原因:距离\方向性的感知

对于NER任务来说,位置和方向信息是十分重要的。在「Inc.」前的单词更可能的实体类型是「ORG」;在「in」后的单词更可能为时间或地点。而对于方向性的感知会帮助单词识别其邻居是否构成一个连续的实体。

由于Transformer采取self-attention机制 =》 位置无偏

本文探讨了命名实体识别(NER)在中文和英文文本中的挑战,指出中文NER需要处理分词问题。LSTM-CRF模型在英文NER表现优秀,而中文NER则倾向于基于字符的方法。LatticeLSTM和Flat-LatticeTransformer是两种解决词汇信息融合的模型,后者通过相对位置编码改进Transformer在NER上的性能。针对Transformer在位置感知上的不足,引入了sinusoidal position embedding。

本文探讨了命名实体识别(NER)在中文和英文文本中的挑战,指出中文NER需要处理分词问题。LSTM-CRF模型在英文NER表现优秀,而中文NER则倾向于基于字符的方法。LatticeLSTM和Flat-LatticeTransformer是两种解决词汇信息融合的模型,后者通过相对位置编码改进Transformer在NER上的性能。针对Transformer在位置感知上的不足,引入了sinusoidal position embedding。

5622

5622

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?