参考

http://www.cnblogs.com/jerrylead/archive/2011/03/13/1982639.html

http://blog.csdn.net/sinat_22594309/article/details/61615946

http://blog.csdn.net/v_july_v/article/details/7624837

理解SVM

函数间隔->几何间隔->拉格朗日算子->KTT条件

函数间隔

全局样本上的函数间隔

几何间隔

全局样本上的几何间隔

拉格朗日对偶

有不等式约束的极值问题求法

KKT条件

最优化间隔分类器

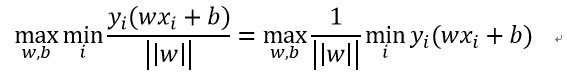

目标:最大化几何间隔

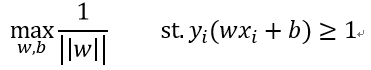

求最小的那一项里就是我们的函数间隔,函数间隔有什么性质?可控可变乖巧听话,所以我们令所有样本的函数间隔都大于等于1,这样后面一项就变成1了,那么优化目标就变成

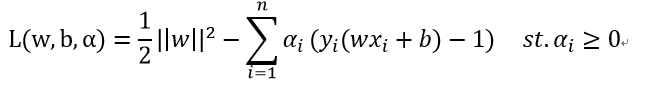

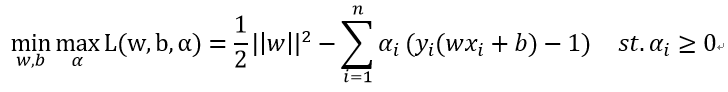

可以把优化问题变成一个带约束的最小化问题,利用拉格朗日乘子法,构建拉格朗日函数

求这个函数的最大值,由于alpha始终大于等于0,[若alpha取小于0,那么最大值为无穷大]。所以对于函数间隔不是1的点而言,其对应的alpha一定等于0才能取到最大值,因此我们就有了拉格朗日函数的最大值就是第一项,我们想优化的目标函数,因此优化目标变成了

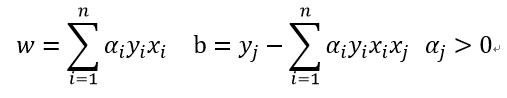

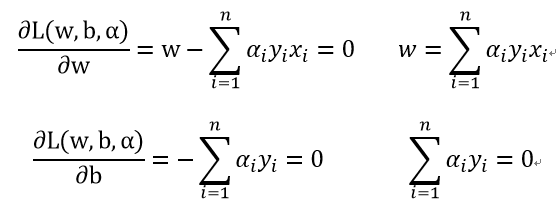

这里根据拉格朗日对偶性将这个极小极大问题转换成极大极小问题,也就是先对w,b求最小值,再求对alpha的最大值。极小问题就转化成求偏导为0,也就是

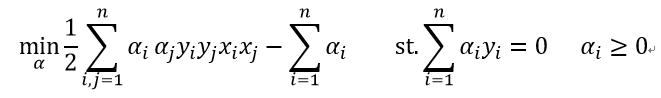

有了这两个等式,我们再把他们回代到拉格朗日函数当中,有

现在拉格朗日函数中需要优化的参数变成了alpha一个,现在只要求得了alpha的最佳值就解决了我们一开始的优化问题,也就是最后需要我们做的工作就是

实际的应用中,当我们解决了上述最优问题之后,我们再回过来求w,b的最优值。W的值很明显,根据上面求导所得的公式进行计算就成,但b的取值怎么求呢?这需要我们回到梦开始的地方,一开始我们就做了一个约束,要求对所有的样本函数间隔都大于等于1,一会儿就要用到这个。首先,alpha不可能全为0,假如alpha全为0则w也为0,我们知道样本有正负两类,这样y(wx+b)=yb不能保证始终大于1,所以必有不等于0的alpha,而对于不等于0的alpha对应的函数间隔必然为1能保证拉格朗日函数的极大值与我们一开始的优化目标等价,所以通过找到一个支持向量,使用 b=yi−wxi:

我们来观察一下上面这个式子,alpha中大部分都是0的,只在少数函数间隔为1的样本处不为0,那么这样的话w,b的取值就只和这些样本有关,其他的样本根本没有地位啊,为了突出这些样本与众不同的地位,我们把它们称为支持向量,超平面的选择之和他们有关~

6222

6222

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?