作业: https://shimo.im/docs/3AB1IwSkwBwZlbMY

参考: https://blog.csdn.net/roger_royer/article/details/90552633#_2

https://blog.csdn.net/qq_39422642/article/details/78676567

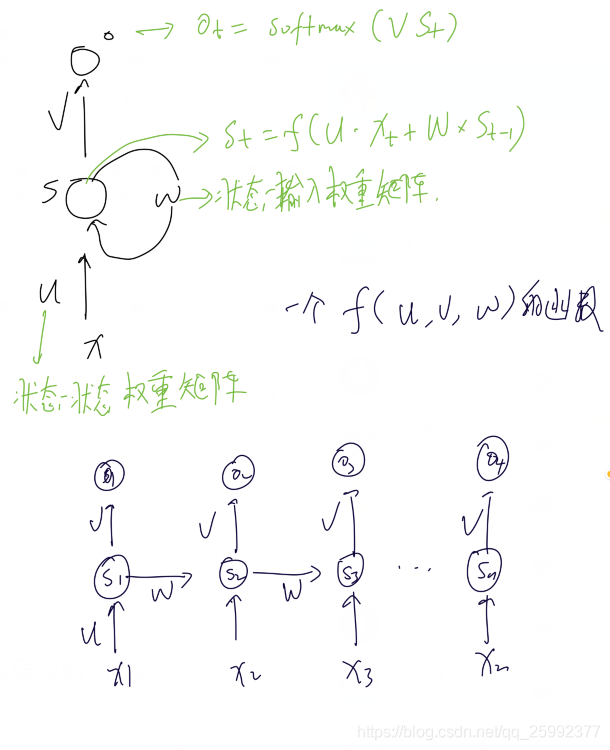

RNN的结构

循环神经网路阔以看作是在时间维度上进行权重共享的网络。RNN实际上是一个单元结构重复使用。

提出的背景,优缺点。

由于之前普通的神经网络的假设是元素之间是相互独立的,而在现实生活中,有一些在时间序列上相关的变量,不可以使用这种神经网络了,而是需要根据上下文进行预测。这个过程依赖于当前的输入和当前状态下的记忆。

RNN反向传播

RNN的反向传播和DNN的反向传播类似,共享了U,W,V,b,c五种参数,在反向传播时进行更新。

RNN的问题

RNN理论上阔以解决序列数据的问题,但是也有DNN一样的梯度消失的问题。

BPTT算法

由于RNN是基于时间的反向传播,所有RNN的反向传播有时候也叫做了BPTT(back-propagation through time).

前馈神经网络中网络的输出仅依赖于当前的输入,输入的长度也是固定的。而在时序相关的问题中,输入是不固定的,同时需要考虑到整个序列状态的影响。

双向RNN

双向RNN是通过节点t之后的数据来预测节点t的结果。双向RNN需要的内存是单项RNN的两倍。

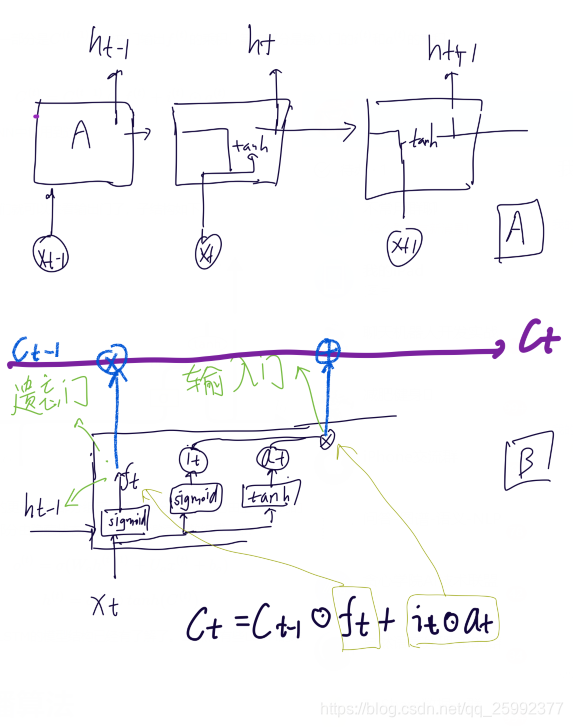

LSTM的结构,提出背景和优缺点

long short term memory, 阔以避免常规的RNN的梯度消失。LSTM相对于RNN,多了一个细胞态,用来整合在内部结构中遗忘门和输入门操作的结果。其中遗忘门用于决定上一个状态输出的h(t-1)保留的概率,输入门为对输入做sigmoid和tanh的操作并求hadamard积。如下图所示,A为RNN的结构,B为LSTM的结构。

memory network

在问答中使用,其中input text为先验知识或者(QB),表示为向量特征,使用这些向量来更新记忆数组,这时将输入与记忆数组兰溪起来,根据输入选择与之相关的记忆单元,存在超参数k,为与之相关度的排序的内容。在response部分,大致也是求词之间的相关度排序,没看懂。参考: https://blog.csdn.net/irving_zhang/article/details/79094416

5217

5217

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?