Zero-Shot Text-to-Image Generation 论文阅读笔记

摘要:

基于零样本(zero-shot)生成。使用两亿个文本-图像对训练。

公开源码(https://github.com/openai/DALL-E)不是很完善,缺了比如text encoder等关键部分。

这论文写得emmm不堪入目。

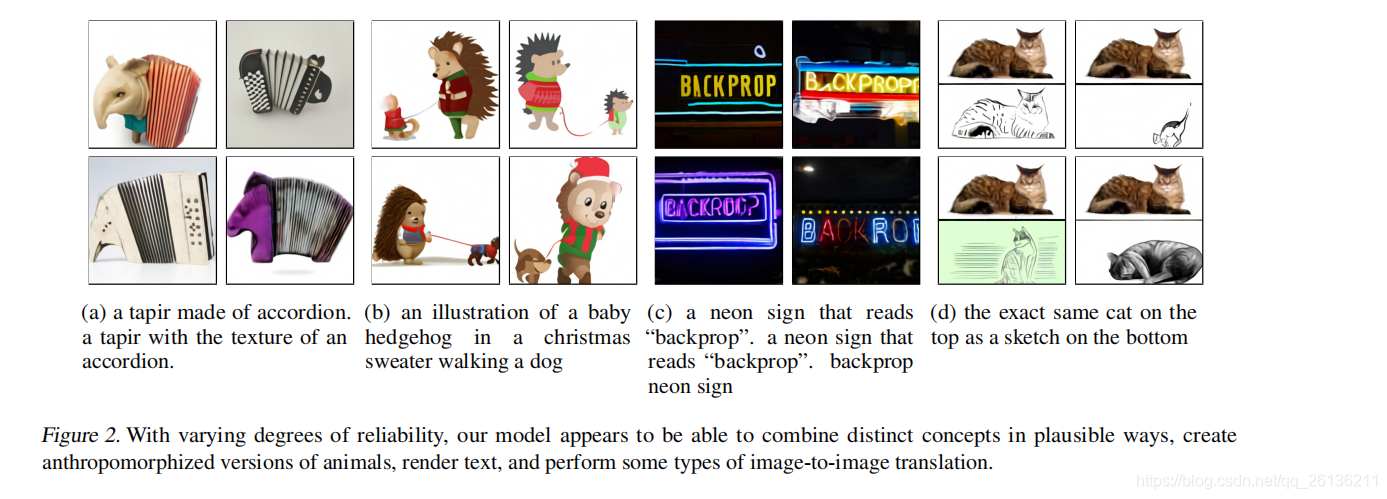

效果:

方法

训练阶段分两部分:

- 阶段一,压缩图片。训练一个discrete variational autoencoder (dVAE),即离散的变分自编码器来压缩256x256大小的RGB图片到32x32的image tokens,每个token有8192个可能值。(?)

- 将256个用BPE编码的text tokens和image tokens 连接在一起,然后训练一个自回归的transformer来建模text和image共同的分布。

整体思路是这样,细节看不太懂,之后再说。

本文探讨了Zero-Shot Text-to-Image Generation的研究,该技术通过训练一个离散变分自编码器(dVAE)压缩图片,并使用自回归Transformer建模文本和图像的联合分布。尽管源码公开,但关键组件如textencoder缺失,论文质量欠佳。该方法旨在实现基于文本描述的图像生成。

本文探讨了Zero-Shot Text-to-Image Generation的研究,该技术通过训练一个离散变分自编码器(dVAE)压缩图片,并使用自回归Transformer建模文本和图像的联合分布。尽管源码公开,但关键组件如textencoder缺失,论文质量欠佳。该方法旨在实现基于文本描述的图像生成。

3686

3686

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?