首先需要了解一个假设。如何来定义一个信息的信息量的大小,把信息量可以看成是一个事件给人们带来的“惊讶程度”,比如一个很常见的事情发生,就认为这个事件的信息量比较小,而一个很稀有的事件发生了,那么就认为这个事件的信息量比较大。比如:太阳升起这种稀疏平常的事件,我们就认为它没有什么有效信息,约等于不说。而夏天突然天降大雪,这种小概率事件的信息,在定量描述上,我们就认为它具有更高的信息量。

信息量与事件概率的关系:1、信息量h(x)的大小与概率p(x)大小满足递减规律,当概率取1时,信息量的值应该为零,当概率趋近于0时,认为信息量区域无穷大,信息量的值应始终是大于等于零的。2、两个不相关的事件同时发生的的信息量h(x,y)应该等于两个事件单独发生的信息量之和h(x,y)=h(x)+h(y)。所以很自然的一种信息量的描述形式是:h(x) = −log2 p(x)

对于一个随机变量X来说,其平均信息量可以表示为单个概率的信息量关于分布p(X)的期望:

这就是随机变量的熵。对数的底数是无关紧要的,当以e为底时,熵的单位为nat,当以2为底时,熵的单位是bit。

熵的概念来源于物理学,是描述系统中无序度的一个概念,系统中的原子分子越杂乱无序,则熵越高。在信息学中,也包含类似的含义。一个随机变量的如果是均匀分布,则被认为是比集中取一个或几个值的状态更加‘无序’的状态,分析H(X)也可以知道,当p(X)为均匀分布时,H(x)取得最大值。

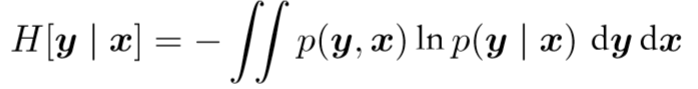

条件熵:

可以得到H(y|x)=H(x,y)-H(x),同时也符合启发式猜想:在x的条件下y的熵等于x,y同时发生的熵减去x发生的熵。

互信息:

![]()

从贝叶斯观点来看,p(x)看成是先验概率,p(x|y)看成是后验概率,那么互信息可以看成是由于知道y的值而造成x的不确定的减少。

1055

1055

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?