这篇文章主要思想为作者利用拉普拉斯金字塔的思想构建了一个网络,来解决超分过程中参数过多或无法很好的拟合高倍超分中的非线性映射 ,首先SRCNN由于SRCNN对低分辨率图像做了一个插值上采样的预处理因此后面 经过卷积层的时候也会有同样大小的参数,比如说6464变成128128则卷积层的参数就扩大了两倍,因此SRCNN扩大了大量的参数,FSRCNN在低分辨率下提取特征,这样相对于SRCNN减少了大量参数,但是由于是在最后一步作上采样因此在采样因子很大的时候可能无法完整的非线性映射,造成信息丢失,VDSR只是在SRCNN的基础上加了残差虽然可以减少参数但仍然包含大量参数,而DRCN虽然通过循环网络减少了深度上的参数但是由于仍旧做了插值所以参数仍旧很多

为了解决这些问题本文采用拉普拉斯金子塔的方法构建了一个网络,首先解释下拉普拉斯金子塔的思想,拉普拉斯金字塔来自于高斯金字塔,高斯金字塔通过高分辨率图片经过高斯滤波也就是一个高斯模糊核卷积后下采样得到一系列低分辨率图片,层数越高分辨率越低类似于下图

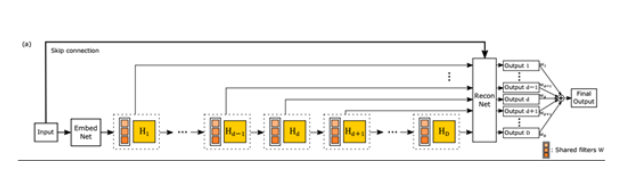

高斯金字塔在下采样时为去掉偶数行和偶数列从而使图像分辨率减小1/2,但这也产生了一个问题因为丢失的另外1/2像素值找不回来了,也就是说在高斯金字塔中从最高层进行上采样并不是从最底层进行下采样的逆过程,因为像素丢失所以从最高层进行上采样的效果远不如原来采样层的图像,所以便引出了拉普拉斯金字塔,拉普拉斯金字塔基本形式是从高斯金字塔顶层开始将最顶层扩大两倍生成与第三层等大小的图像之后作差便可以得到第三层变为第四层损失的细节,而拉普拉斯金字塔本质上就是由每一层插值与下一层形成残差从而构成的残差金字塔,本文这个网络就是利用了拉普拉斯金字塔这种差的思想,为了解决较大上采样因子时可能无法很好的学习非线性映射的问题,本文选择了逐层上采样,即将一个上采样到八倍的网络分解为2 * 2 * 2,上层低分辨率图片经过卷积提取特征后与直接进行2倍插值的图片逐元素相加后与标签图像作损失,其实这就类似于拉普拉斯金字塔,初始的lr图像相当于拉普拉斯金字塔的顶层,将初始源图像上采样直接传输到输出,形成残差,而这里明显不可以用拉普拉斯金字塔的方法直接用下一层减上一层,因为这是一个深度网络,并不单单是为了恢复一张图片而是为了使网络学习到参数从而恢复高分辨率图像,因此通过卷积的非线性映射进行学习,而每一个上采样后都会与标签图像进行损失比较从而约束生成的残差,其实也是为了防止信息丢失,毕竟网络未采用密集网络,损失为均方差损失

Deep Laplacian Pyramid Networks for Fast and Accurate Super-Resolution

最新推荐文章于 2021-09-02 23:02:40 发布

746

746

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?