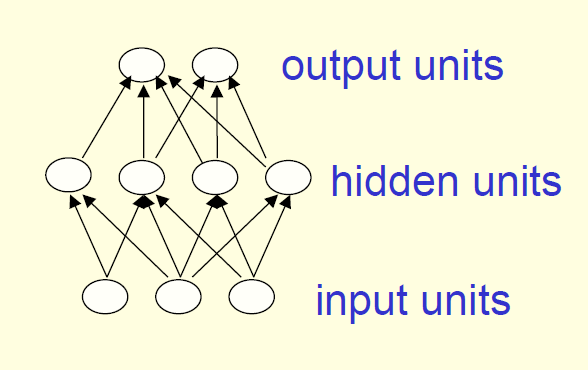

1、前馈神经网络(Feed-forward neural networks)

前馈神经网络是实际应用中最常见的网络结构,它包含一个输入层(input units),一个输出层(output units)和一到多个隐含层(hidden units),如图。如果包含多个隐含层,我们称之为深度神经网络(deep neural networks)。

神经网络在输入层与输出层之间进行一系列转换(transfermission)的计算,使得网络的每一层都会得到一个新的输入状态。在前一层关联度低的两个输入到新的一层可能会提高关联度,相反,在前一层关联度高的两个输入到新的一层也可能会降低关联度。这种结构的优点在于,例如在语音识别任务中,我们希望将不同人所说的相同的词关联度提高,而把同一个人所说的不同的词关联度提高,那么就可以应用到网络结构的特性。

为了实现网络的这种特性,需要将每一层节点的激励函数(activities)设为前一层输出的非线性函数。

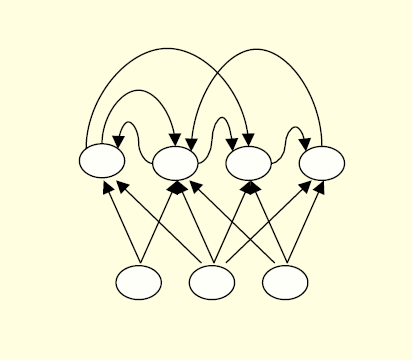

2、循环神经网络(Recurrent networks)

循环神经网络比起前馈神经网络更加功能强大,在它的链接结构中存在有向环(如下图),这意味着由一个节点出发,沿着箭头的方向前进,有可能会回到起点。

这种网络结构可以产生十分复杂的变化,使训练过程变得困难。目前研究者仍致力于寻找一种有效的训练方法,因为循环神经网络一旦训练成型就可发挥巨大的作用。

此外,相比于前馈神经网络,循环神经网络更接近于现实中生物学上的神经结构。

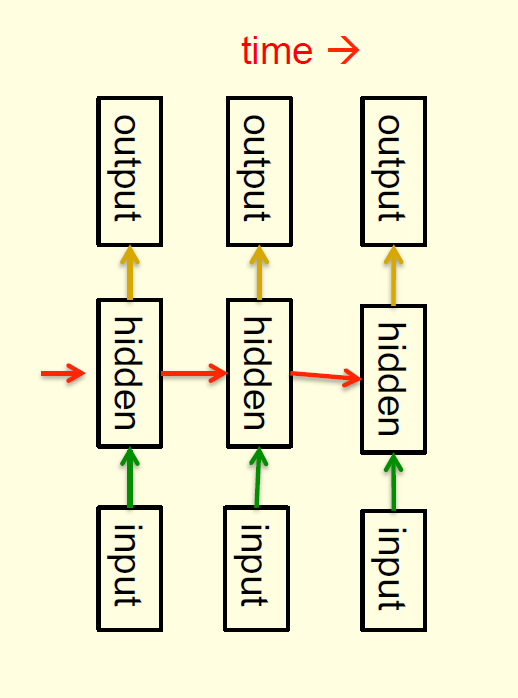

循环神经网络可以对序列化数据进行建模(如下图)。

其中连接的隐含层具有时序记忆特征,即在时序中某一时刻隐含层节点的状态决定了下一时刻隐含层节点的状态。

与前馈神经网络不同的是,我们在时序中的每一时刻都使用相同的权值,也就是说,对于任意时刻产生的输入和输出,隐含层的权值矩阵都是相同的。

循环神经网络能够将隐含层中的信息保留相当长的时间,即所谓的记忆特性,但通过训练网络来应用这一特性十分困难,

下图是应用循环神经网络实现的自动文本生成,程序每次输出单个字符,最后得到这样一段文本。虽然可读性较差,但文本的语法结构还是能够证明神经网络的强大功能的。

3、对称连接网络(Symmetrically connected networks)

对称连接网络与循环神经网络较为相似,不同的是,对称连接网络的节点连接是对称的,即相反方向的连接具有相同的权值。对称的特性使它比起循环神经网络更容易分析,但使它的功能受到了限制,例如在对称结构的网络中不存在有向环,即由一个节点出发不可能回到原点。

没有隐含层的对称网络称为Hopfield网络。

有隐含层的对称网络称为玻尔兹曼机。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?