概念

池化层是一种用于减少特征图(feature map)大小的层级。它通过对输入的特征图进行某种形式的聚合操作,例如最大池化或平均池化,从而降低了特征图的空间维度,减少了参数数量和计算负担。

池化层的作用有以下几点:

- 降维和减少计算量:通过池化操作,可以减少后续层级的输入数据量,从而降低整体模型的计算负担,提升计算效率。

- 保留重要特征:池化层可以在保留重要信息的同时减少不必要的细节,有助于网络对于输入数据的关键特征进行提取。

- 平移不变性:池化层对输入特征图的小平移具有一定的不变性,即使输入图像稍微移动,经过池化层后的输出也不会发生明显变化。

- 提升模型的泛化能力:通过降低维度和提取关键特征,池化层有助于减少过拟合风险,提升模型的泛化能力。

总的来说,池化层在卷积神经网络中起到了对特征进行降维和抽象表示的作用,有助于网络有效地学习和提取输入数据中的关键信息。

torch.nn.MaxPool2d 是 PyTorch 中用于二维最大池化操作的模块,以下是创建二维最大池化层对象时的参数:

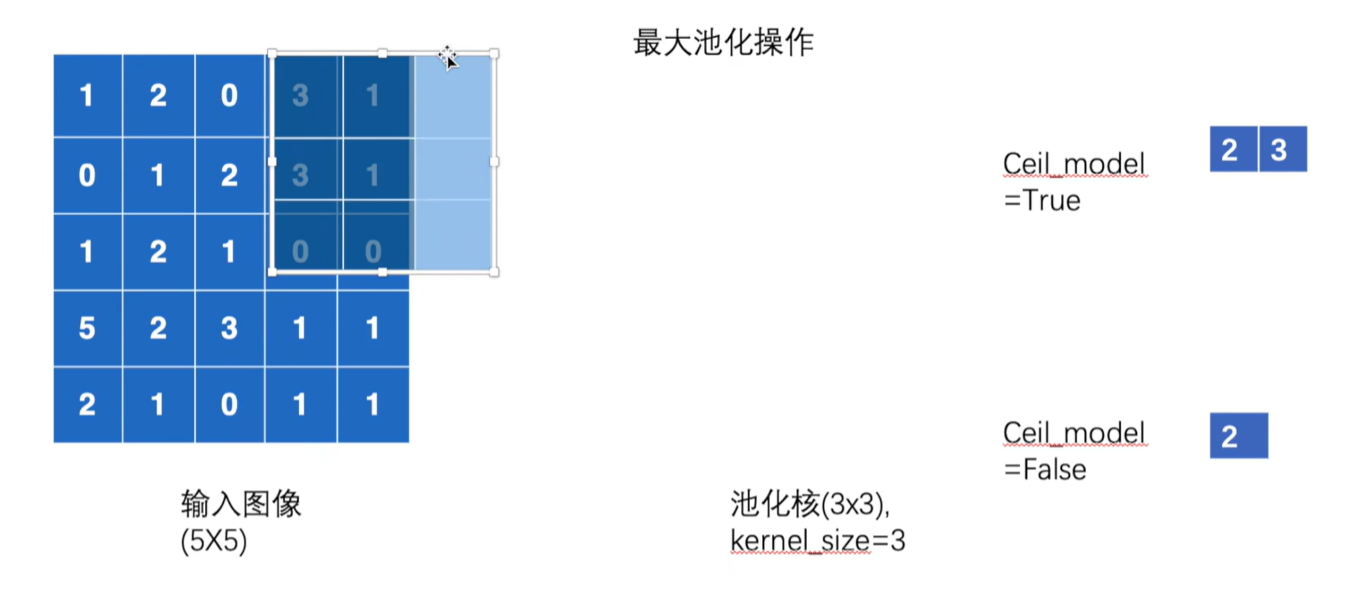

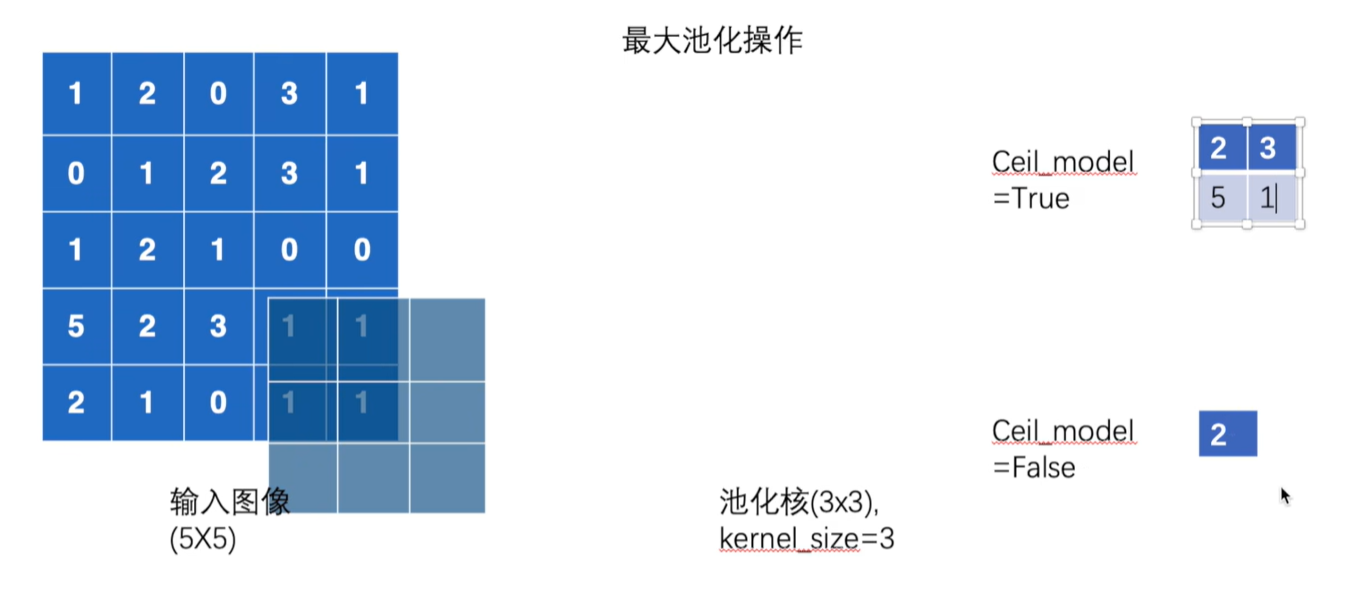

- kernel_size: 这是指池化窗口的大小,也就是在进行最大池化操作时每次取最大值的窗口大小。

- stride: 这是指池化窗口在输入数据上移动的步长。默认值:步长与池化窗口大小相同。

- padding: 这是指在进行池化操作之前,对输入数据进行的填充操作。填充可以在窗口周围添加额外的值,以便更好地处理边界情况。

- dilation: 这个参数控制着窗口中元素的步幅。增加

dilation可以使得池化操作在输入上更加稀疏。

- return_indices: 如果设置为 True,

MaxPool2d操作将会返回每个最大值的索引,这对后续的torch.nn.MaxUnpool2d操作很有用。 - ceil_mode: 当设置为 True 时,输出形状的计算会使用 ceil 而不是 floor,这可能会导致输出形状稍微增加。(ceil向上取整,floor向下取整)

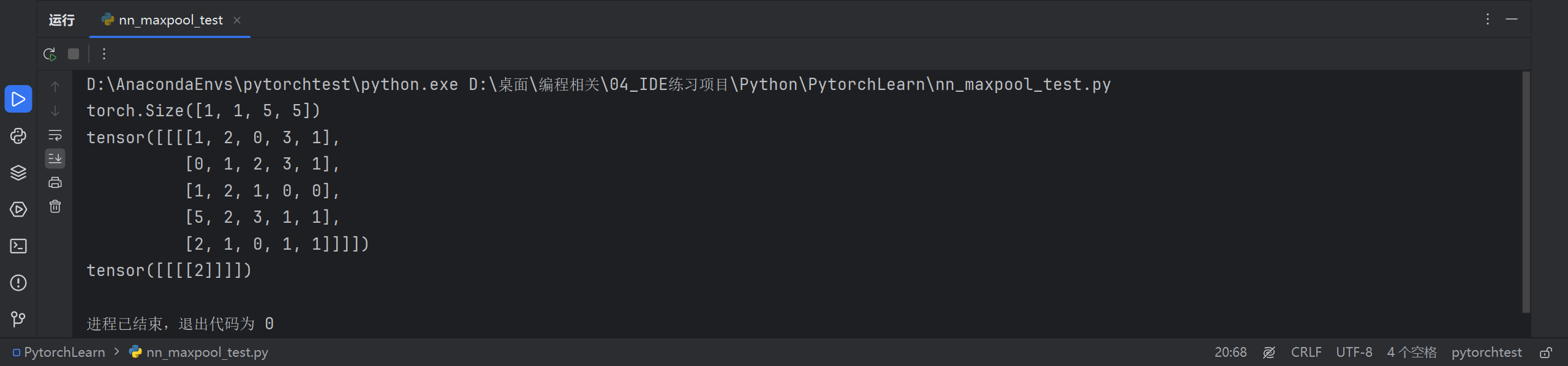

示例

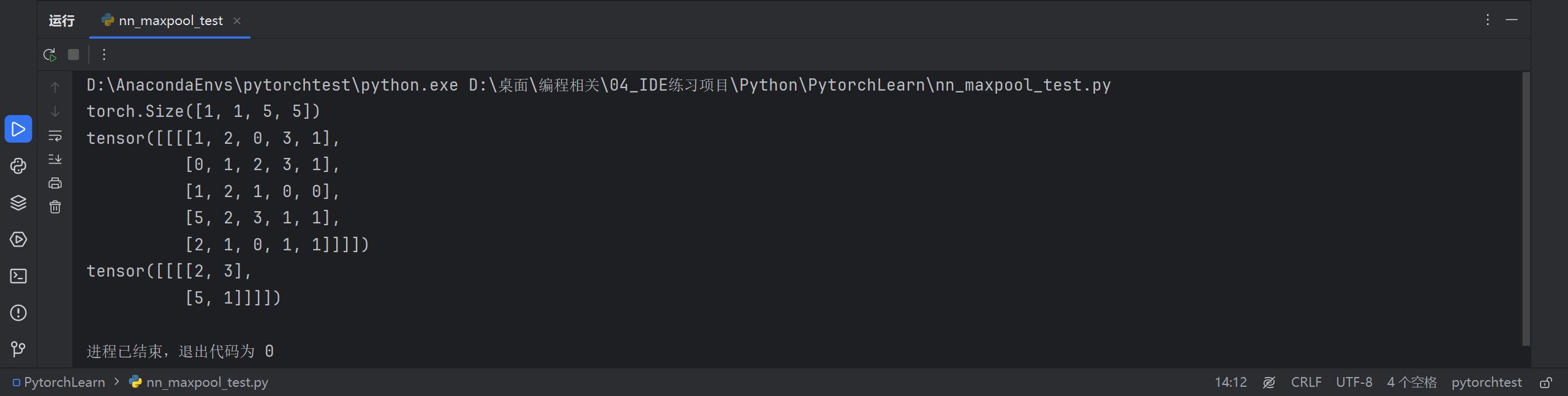

import torch

from torch import nn

input = torch.tensor([[1, 2, 0, 3, 1],

[0, 1, 2, 3, 1],

[1, 2, 1, 0, 0],

[5, 2, 3, 1, 1],

[2, 1, 0, 1, 1]])

input = torch.reshape(input, (-1, 1, 5, 5))

# shape参数:其中 -1 表示该维度的大小由其他维度和原始张量的总元素个数推断而来。

# 因此,这里将原始的二维张量转换成了一个四维张量,第一个维度大小为 1,

# 第二个维度大小为 1,后面两个维度大小为 5,对应于原始张量的行和列。

print(input.shape)

print(input)

class MyMaxPool(nn.Module):

def __init__(self):

super(MyMaxPool, self).__init__()

self.maxpool1 = nn.MaxPool2d(kernel_size=3, ceil_mode=False)

def forward(self, input):

output = self.maxpool1(input)

return output

mymaxpool = MyMaxPool()

output = mymaxpool(input)

print(output)

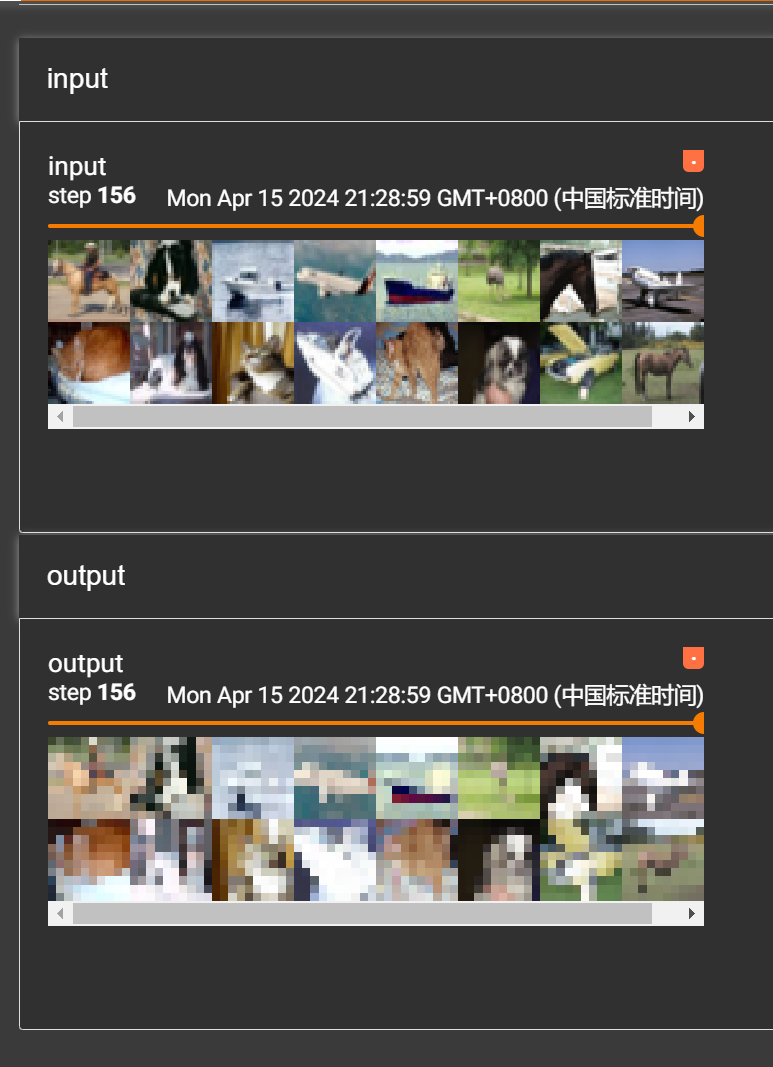

import torch

import torchvision

from torch import nn

from torch.utils.data import DataLoader

from torch.utils.tensorboard import SummaryWriter

dataset = torchvision.datasets.CIFAR10(root='./dataset', train=False, download=True,

transform=torchvision.transforms.ToTensor())

dataloader = DataLoader(dataset, batch_size=64)

class MyMaxPool(nn.Module):

def __init__(self):

super(MyMaxPool, self).__init__()

self.maxpool1 = nn.MaxPool2d(kernel_size=3, ceil_mode=False)

def forward(self, input):

output = self.maxpool1(input)

return output

writer = SummaryWriter("logs_maxpool")

step = 0

mymaxpool = MyMaxPool()

for data in dataloader:

imgs, targets = data

writer.add_images("input", imgs, step)

output = mymaxpool(imgs)

writer.add_images("output", imgs, temp)

step += 1

writer.close()

使用tensorboard展示一下input和output。

本文详细介绍了池化层在卷积神经网络中的作用,包括降维、特征提取、平移不变性和泛化能力提升。特别关注了PyTorch中的MaxPool2d模块,以及如何在实际项目中使用它进行二维最大池化操作。

本文详细介绍了池化层在卷积神经网络中的作用,包括降维、特征提取、平移不变性和泛化能力提升。特别关注了PyTorch中的MaxPool2d模块,以及如何在实际项目中使用它进行二维最大池化操作。

4411

4411

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?