第12次周报

摘要

This week studied an article that uses LSTM structure to solve the problem of natural language inference。In this article, the authors use BiLSTM and tree-LSTM to build a network to solve the natural language reasoning problem: Can derive hypothesis h from a premise p?

本周学习了一篇使用LSTM结构解决自然语言推理问题的文章。在这篇文章中,作者使用BiLSTM和tree-LSTM来搭建网络解决自然语言推理问题:即能否从一个前提p中推导出假设h?

文献阅读

《Enhanced LSTM for Natural Language Inference》

作者:Qian Chen、Xiaodan Zhu、Zhenhua Ling、Si Wei、Hui Jiang、Diana Inkpen

摘要:

推理和推理是人类和人工智能的核心。用人类语言进行建模推理是非常具有挑战性的。在本文中,作者提出了用于自然语言推理的神经网络模型,在斯坦福自然语言推理数据集上达到了88.6%的准确率。该模型与之前使用非常复杂的网络体系结构的顶级模型不同,作者首先演示了这种基于链式lstm的序列推理模型优于之前的所有模型,包括那些使用更复杂的网络架构的模型。在此基础上,作者进一步表明,通过在局部推理建模和推理组合中显式地考虑递归架构,实现了额外的改进。特别是,合并语法解析信息有助于实现我们的最佳结果:即使添加到已经非常强的模型中,它也能进一步提高性能。

模型介绍:

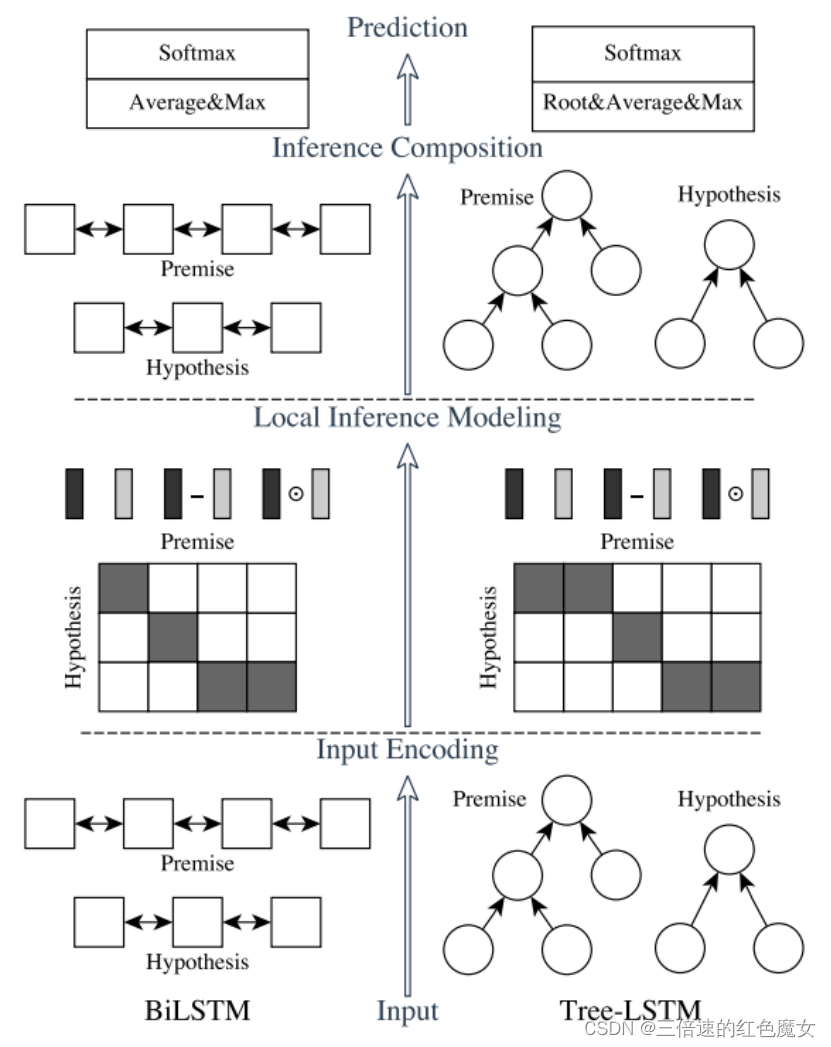

该自然语言推理网络模型由以下主要组件组成:输入编码、局部推理建模和推理组成,如下图所示:

图的左边表示本文要说明的ESIM的顺序NLI模型,右边使用了名为Tree-LSTM的变种LSTM结构,用于做句子的语法分析。

前提和假设:

a =(a1,……,ai)和b =(b1,……,bj),其中a是一个前提,b是一个假设。ai或bj∈Rl是l维向量的嵌入,可以用一些预先训练的单词嵌入进行初始化,并用解析树进行组织。目标是预测一个标签y,它表示a和b之间的逻辑关系。

输入编码(Input Encoding)

输入编码:作者首先使用双向LSTM(BiLSTM)编码输入的前提和假设。BiLSTM学习了如何表示一个单词及其上下文。稍后,作者还将使用BiLSTM来执行推理组合来构建最终的预测,其中BiLSTM对局部推理信息及其交互进行编码。作者在输入序列a上将BiLSTM在时间i时生成的隐藏(输出)状态写为¯ai,¯bj同理:

(作者也尝试使用了BiGRU,但发现在NLI任务中,表现不如Bilstm好)

局部推理建模( Local Inference Modeling)

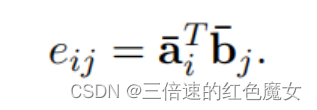

推理的局部性建模需要使用软对齐来关联前提和假设之间的相关子组件。软对齐层将计算注意权值用于得到一对隐藏状态元组<¯ai,¯bj>(前提与假设)的相似性。

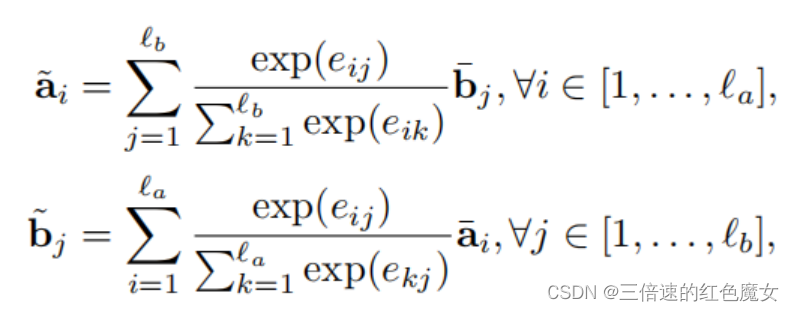

计算的注意权重用到下面的公式里,获得前提和假设之间的局部相关性。

接着使用下述公式进一步增强了所收集到的局部推理信息。

ma和mb就是增强型局部推理信息。作者期望这样的操作可以帮助锐化元组中元素之间的局部推理信息,并捕获如矛盾等推理关系。

推理组成( Inference Composition)

作者使用了组成层(The composition layer)来组成增强的局部推理信息ma和mb。作者继续使用BiLSTM按顺序组成局部推理信息。它们用于捕获局部推理信息ma和mb,以及这里的上下文用于推理组合。

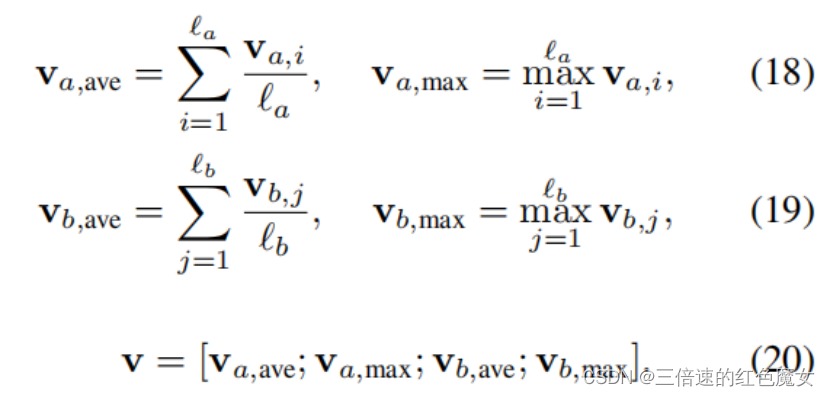

最后,作者将上述得到的结果向量代入如下式子转换为一个具有池化的固定长度的向量,并将其提供给MLP分类器。

该MLP有一个带有tanh激活函数的隐藏层,和一个softmax的输出层,以确定总体推理关系。

模型性能

数据集:斯坦福自然语言推理(SNLI)语料库

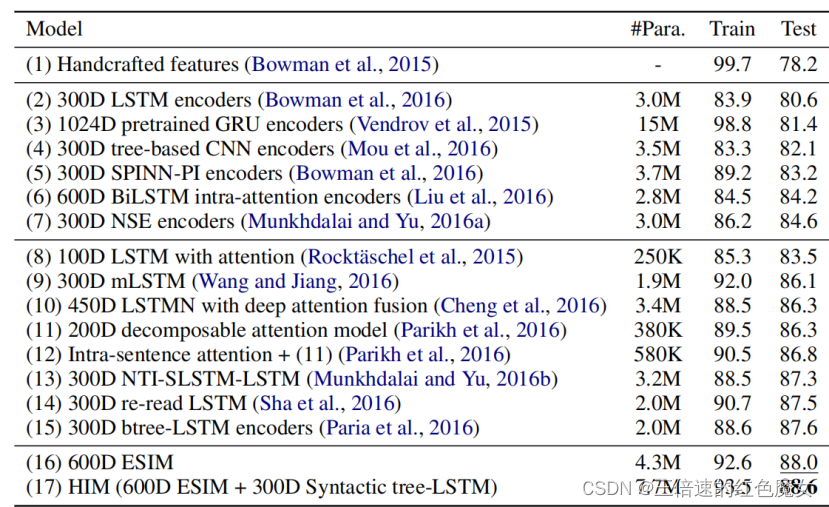

ESIM是作者在本文中讨论的模型。上图描述了各种模型在SNLI上的准确性。作者的最终的模型达到了88.6%的准确率,是最佳结果,从表中可以看出,ESIM模型达到了88.0%的准确率,已经优于之前所有的模型,包括那些使用更复杂的网络架构的模型。

研究成果

作者的成果主要有如下两点:

1.设计基于链式lstm的序列推理模型ESIM性能优于之前所有的模型

2.通过在局部推理建模和推理组合中显式地考虑递归架构,合并语法解析信息有助于实现最佳结果:即使添加到表现已经非常好的模型中,它也能进一步提高性能

总结

本周由于考试临近科目众多,占用了不少时间,主要阅读了文献,浅层了解了RNN结构,下周主要任务还是阅读文献,以及了解RNN相关结构。

348

348

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?