0、写在前面

本文是一个学习链接博客。网上已有许多参考文档,故不再重复。我从找到的学习链接中筛选出我认为写得清晰、通俗易懂的部分截取给大家,并加上了我学习过程中的笔记标注。来源已标注,感谢各位大佬博主!

1、Data Parallel 工作原理 & 梯度计算

pytorch多gpu DataParallel 及梯度累加解决显存不平衡和显存不足问题_gaoyelu的博客-CSDN博客

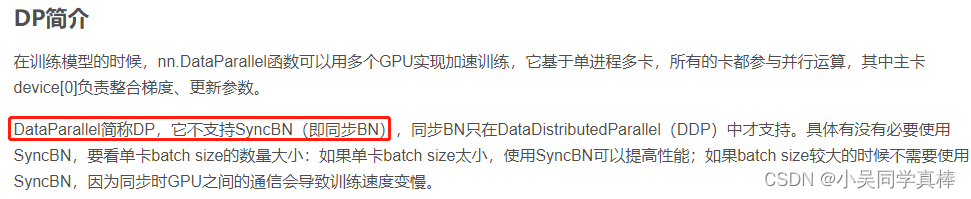

2、Data Parallel 暂时没有 PyTorch 官方的同步,但 DDP 有。

DataParallel下的Batch Normalization_44070509的博客-CSDN博客

3、Data Parallel 的 BN 层前向计算示意图

Pytorch多GPU的计算和Sync BatchNorm - 知乎

4、BN 的前向、反向传播及其计算公式

BN(Batch Normalization)与Multi-GPU BN - AI备忘录

5、SyncBN 的前向、反向传播及其计算公式

BN(Batch Normalization)与Multi-GPU BN - AI备忘录

本文介绍了PyTorch中DataParallel的工作原理,以及如何使用它来解决显存不平衡和不足的问题。同时,对比了DataParallel与SyncBatchNorm在批归一化处理上的差异,解释了SyncBN如何实现跨GPU的同步批归一化,确保模型在多GPU环境中的收敛一致性。

本文介绍了PyTorch中DataParallel的工作原理,以及如何使用它来解决显存不平衡和不足的问题。同时,对比了DataParallel与SyncBatchNorm在批归一化处理上的差异,解释了SyncBN如何实现跨GPU的同步批归一化,确保模型在多GPU环境中的收敛一致性。

908

908

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?