文章目录

** **http://activepony.com/shen-du-xue-xi/mu-biao-jian-ce/mu-biao-jian-ce-ping-jie-zhi-biao/

一、基础概念

1.1 IOU(Intersection Over Union)

IOU阈值用来表示两个边界框之间的重合度

1.2 TP、FP、FN、TN

True Positive (TP): A correct detection正确预测. Detection with IOU ≥ threshold

False Positive (FP): A wrong detection错误预测. Detection with IOU < threshold

False Negative (FN): A ground truth not detected未被预测的目标

True Negative (TN): Does not apply. It would represent a corrected misdetection. 在对象检测任务中,有许多在图像内没有检测到目标的边界框。因此,TN是所有正确分辨的未检测到目标的边界框,在评价指标中,这个度量不使用。

1.3 Precision精度

正确预测占全部预测的百分比:

1.4 Recall查全率

正确预测占所有真值框的百分比:

二、度量

2.1 Precision x Recall 曲线

Precision x Recall曲线是评估目标检测器性能的好方法,因为通过为每个对象类别绘制一条曲线来改变置信度。

如果特定类别的目标检测器的精度随查全率的提高而保持较高,则认为该检测器良好,这意味着如果改变置信度阈值,则查准率和查全率仍然很高。识别优质物体检测器的另一种方法是寻找一种仅能识别相关物体(0个False Positives =高精度)的查找器,找到所有地面真实物体(0个False Negatives =高召回率)。

不良的物体检测器需要增加检测到的物体的数量(增加误报=较低的精度)才能检索所有地面真实物体(高召回率)。因此,Precision x Recall曲线通常以高精度值开始,并随召回率的增加而减小。您可以在下一个主题(平均精度)中看到Prevision x Recall曲线的示例。

2.2 Average Precision(AP)平均精度

比较对象检测器性能的另一种方法是计算Precision x Recall曲线的曲线下面积(AUC)。由于AP曲线通常是上下弯曲的锯齿形曲线,因此比较同一图中的不同曲线(不同的检测器)通常不是一件容易的事,因为这些曲线往往会频繁地相互交叉。

平均精度(AP):可以帮助我们比较不同目标检测器。AP是在0到1之间的所有召回值上平均的精度。

最初计算AP是插值11个等距点,求11个召回值上的精度的平均值。从2010年开始PASCAL VOC计算AP的方法已经改变,插值使用所有数据点,而不是仅如其论文所述插值11个等距点。

(1)11点插值方法:

是在查全率为

是在查全率为 时的精度。

时的精度。

插值所有点方法:

是在查全率为

是在查全率为 时的精度。

时的精度。

2.3 平均精度(AP)计算案例

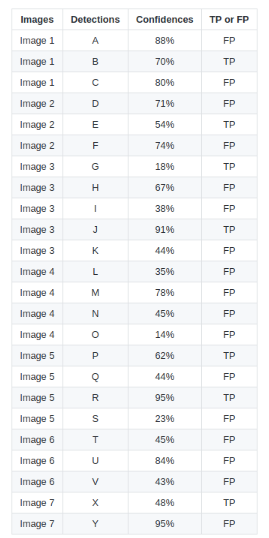

有7张图像,15个绿色边界框表示的真值框,24个红色边界框表示的预测的框。每个预测边界框有一个置信度,预测框由字母(A,B,…,Y)标识。

下表显示了预测边界框及其相应的置信度。最后一列将检测结果标识为TP或FP。在此示例中,如果IOU为30%,则认为是TP ,否则为FP。

某些图像中,有多个预测边界框与真值框重叠(图像2、3、4、5、6和7),对于这种情况,具有最高IOU的预测边界框被认为是TP,而其他被认为是FP。

通过TP或FP计算检测的精度(Precision)和召回值(Recall)来绘制Precision xRecall曲线。首先按置信度对检测进行排序,为每个检测计算精度和召回率,如下表所示:

绘制精度和查全率值,以下“ 精度x查全率”曲线:

11点插值计算AP:

11点内插平均精度的想法是在一组11个查全率(0,0.1,…,1)上的精度平均

通过应用11点插值:

所有点插值计算AP:

通过插值所有点,平均精度(AP)可以解释为Precision x Recall曲线的近似AUC。目的是减少曲线中摆动的影响。通过应用前面介绍的方程式,可以获得面积。通过查看从最高(0.4666)到0(从右到左的图)的召回率,我们还可以从视觉上获得内插的精度点,并且随着我们降低召回率,我们会收集最高的精度值如下图所示:

查看上图,可以将AUC分为4个区域(A1,A2,A3和A4):

计算总面积,得到AP:

两种不同插值方法之间的结果略有不同,默认实现与VOC PASCAL相同的AP计算方法:所有点插值。

参考:https://github.com/rafaelpadilla/Object-Detection-Metrics#precision-x-recall-curve

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?