PCPL(predicate-correlation perception learning scheme)阅读笔记

(谓词联系感知学习策略)

针对问题

VG数据集长久以来的难题:谓词类的长尾效应过于严重导致结果很容易预测为头部类,并且谓词类之间并不是相互独立的,在很多场景下会是包含等等的关系,因此可以利用谓词与谓词之间的关联信息。

作者提到:当前比较普遍的重调节策略(re-banlance strategy, 例如重采样,调节权重等) 会导致模型在尾部数据过拟合。作者认为这是因为重调整策略对于谓词的出现频率比较敏感,而对于谓词之间的联系不敏感,但是对于场景图生成来说这些谓词之间的关系反而更重要。

因此本文提出了PCPL,目的是利用不同谓词类别之间的联系来自适应寻找loss权重

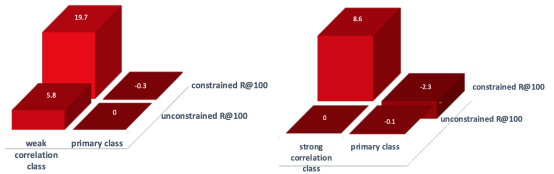

通过实验对比发现在使用re-weight策略时,谓词与谓词之间弱关联时,re-banlance会提升尾部类的指标并且对头部类影响较小;但是如果谓词与谓词之间存在强关联时,会导致在尾部数据过拟合,即尾部类的指标提升但是会导致与其有关联的头部类指标降低

论文流程

要衡量类与类之间的距离,本文中使用类中心的间距作为衡量类相关程度的指标,因为一般来说关联程度大的类之间的距离会更近一点。

不同场景下谓词类与谓词类之间的关联程度不一定相同,即谓词类之间的关联程度不是一成不变的,所以这里作者在计算类中心时使用的是可学习方式,并不是直接对整个数据集进行聚类统计(这种方式下类与类之间的关联程度是固定的)

论文流程示意图如下所示:

① 与其他论文一样首先使用faster RCNN检测出proposals

② 对每个proposal的位置进行编码,与视觉特征一起输入到上下文信息编码模块中

③ 在上下文信息编码模块中使用自注意力机制获取上下文特征

④ 对每个proposal预测类别标签,并对标签进行编码

⑤ 上下文特征与标签编码进行融合得到关系谓词的视觉表示特征向量(Relationship Representations)

⑥ 为每一类关系谓词的类中心初始化一个表示向量(文中未说明初始化方式)

⑦ 将relationship representations输入到节点更新网络(对应前面提到的可学习方式计算类中心)更新节点特征

⑧ 计算各类中心的间距e,然后使用所示的公式计算对应的权重

文中提到在PCPL方法中尽管强相关的谓词类被赋予的权重比较小,但是他们能够从其它相关类受益;与此同时其它类(弱相关的谓词等)的损失比重增大,这也有利于提升性能(感觉解释的有些牵强,为什么权重小了还会有提升,或者说关联类是怎么影响的)

实验结果

2072

2072

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?