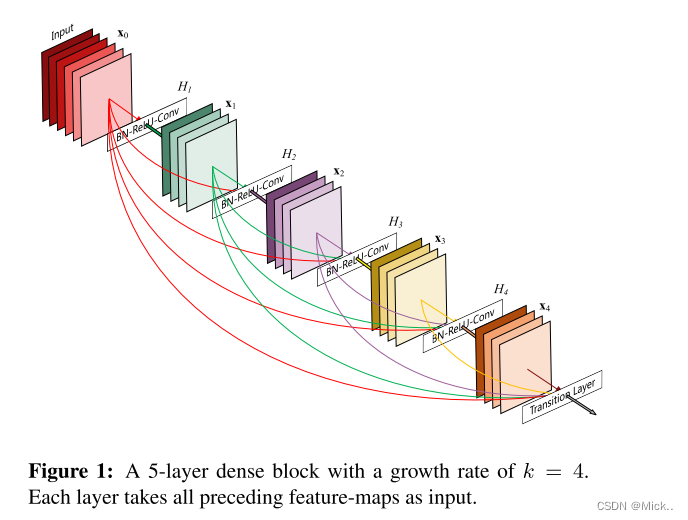

最近的工作表明,如果卷积网络在靠近输入的层和靠近输出的层之间包含较短的连接,则它们可以更深入,更准确和有效地进行训练。具有L层的传统卷积网络具有L个连接-每个层及其后续层之间有一个连接。对于每个层,将所有先前层的特征图用作输入,并将其自己的特征图用作所有后续层的输入。密集连接具有几个引人注目的优点: 它们缓解了消失梯度问题,加强了特征传播,鼓励了特征重用,并大大减少了参数的数量。

引言

卷积神经网络 (cnn) 已成为视觉对象识别的主要机器学习方法。尽管神经网络的概念在20年前就已经出现,但是直到现在(2017年)才发展出初具规模的深度神经网络。最初的LeNet5 [19] 由5层组成,VGG具有19 [28],仅去年高速公路网络 [444] 和残差网络 (ResNets) [11] 已超过100层屏障。

随着cnn变得越来越深,一个新的研究问题出现了: 随着有关输入或梯度的信息通过许多层,可能会出现梯度消失。ResNets [11] 和公路网络 [444] 通过身份连接将信号从一个层旁路到下一个层。随机深度 [13] 通过在训练过程中随机掉落层来缩短resnet,以允许更好的信息和梯度流。FractalNets [17] 反复组合几个具有不同数量卷积块的平行层序列,以获得较大的标称深度,同时在网络中保持许多短路径。尽管这些不同的方法在网络拓扑和训练过程中有所不同,但它们都具有一个关键特征: 它们创建了从早期层到后来层的短路径。

订阅专栏 解锁全文

订阅专栏 解锁全文

827

827

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?