主要参考资料:

B站视频《CUDA Python 科普之夜 | 手把手教你写GPU加速代码》

Github链接: https://github.com/sangyy/CUDA_Python

CPU与GPU比较

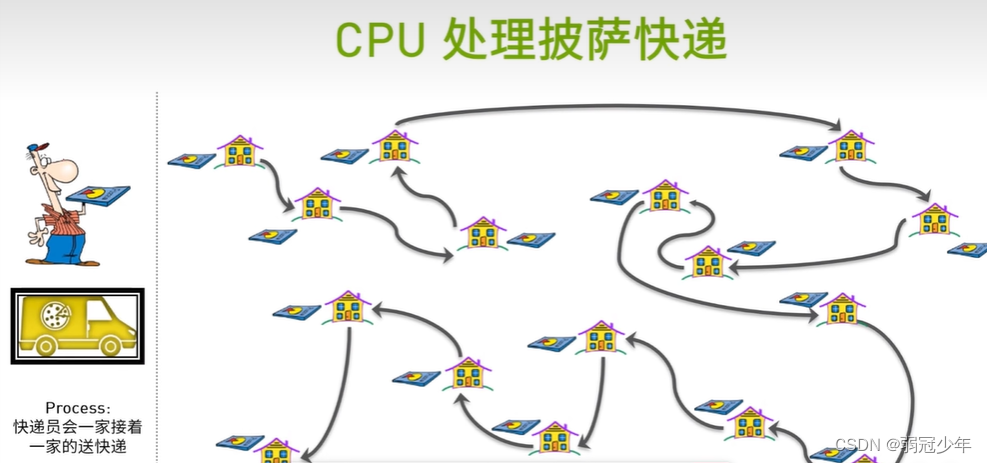

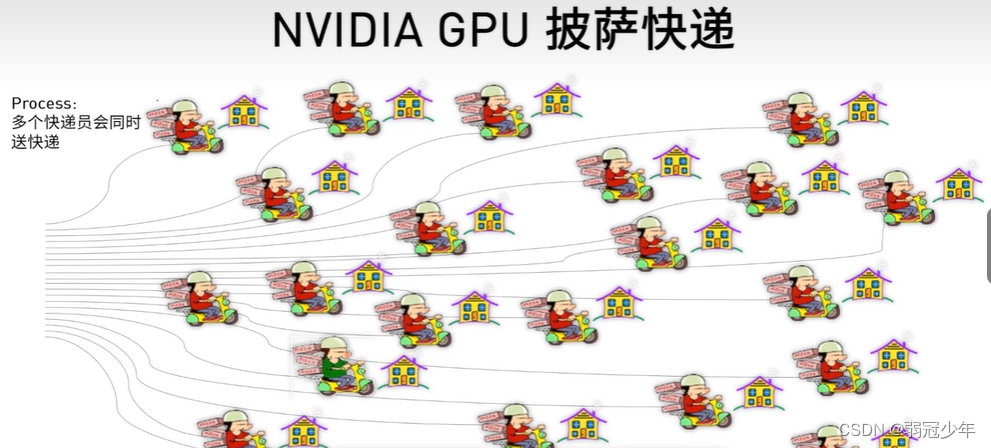

之前有听过一个比喻说,CPU里面的核心像是一个博士生,能完成高级运算,算得也快,但是所有事都得极少的几个人来完成;GPU像是有几千甚至上万的小朋友在里面,虽然每个小朋友能力不强,但是他们也只需要完成加减法计算就可以了。

抽象出来就是一个是串行计算,一个是并行计算,都有各自的应用领域。

底下两个图是另一种比喻:

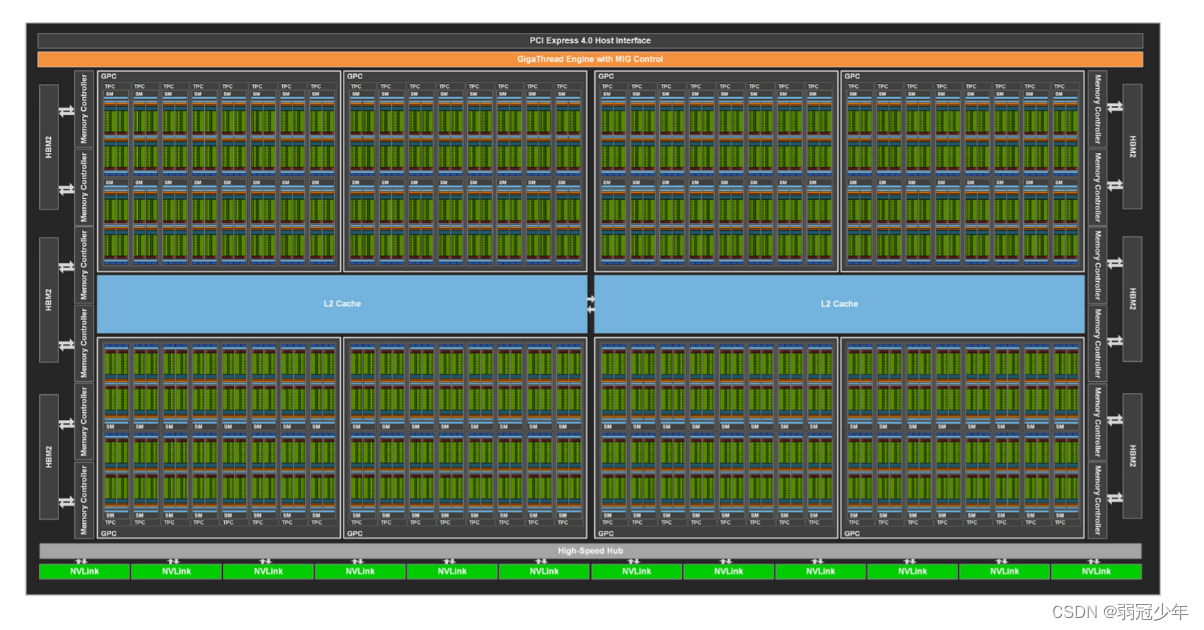

上面说地比较抽象,拿GA100举例,它包含了:

(1)8192 FP32 CUDA Cores(用于计算的核心)

(2)128个SM(SM指stream multiprocessor,即流多处理器,可以方便一块线程之间的协作)

(3)每个SM包含64个FP32 CUDA Core,4个第三代Tensor Core

这是GA的整体硬件图

SM(流多处理器)框图

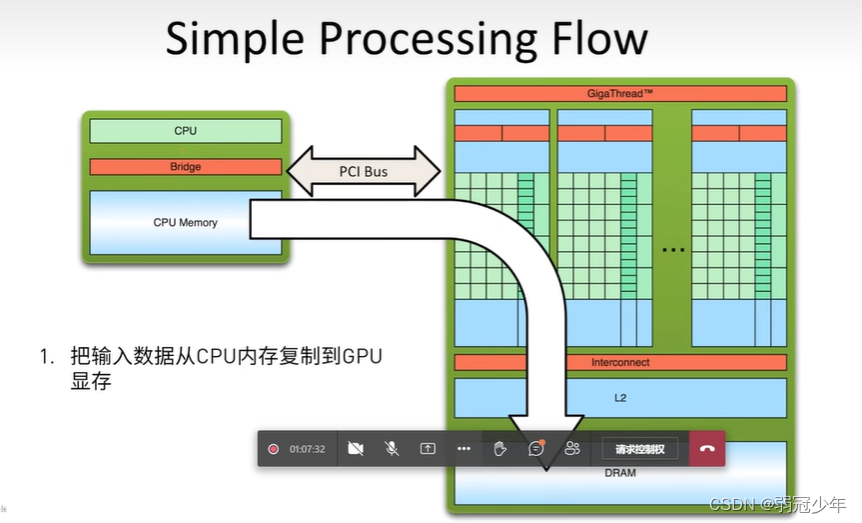

CPU+GPU工作流

上面说了GPU只是一个协处理器,没错,它就是打杂的!

因此一般它是配合CPU一起工作的,可以简单概括成三个过程。

(1)将输入数据从CPU内存复制到GPU显存

(2)在GPU芯片上缓存数据,加载GPU程序并执行

(3)将计算结果从GPU显存复制到CPU内存中

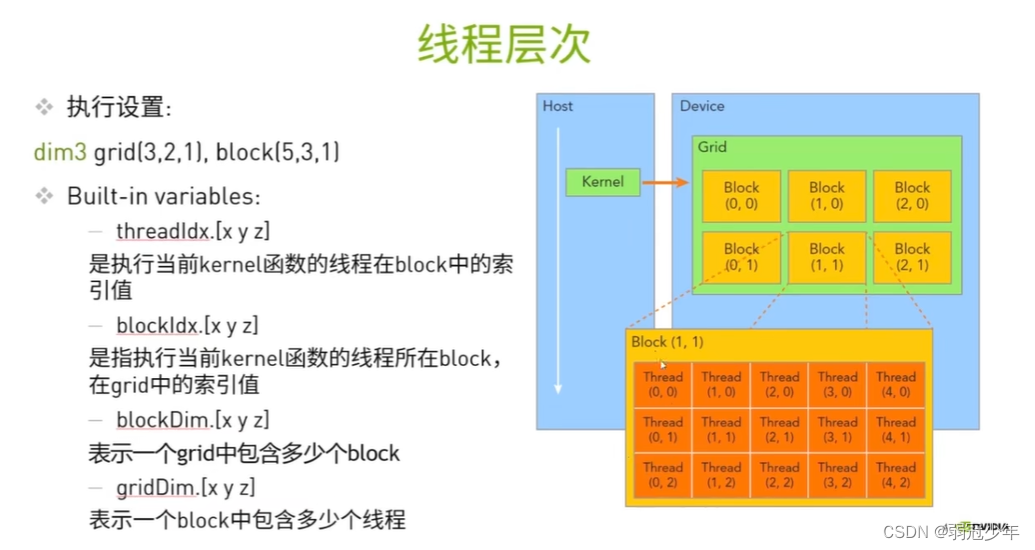

这里有两个术语,Host是指CPU和内存,Device是指GPU和显存。

GPU的最小运行单位是Thread线程,多个Thread线程组成一个Block块,多个Block块组成一个Grid网格。

CUDA介绍

GPU只是个协处理器,跑不了像WIindows、Linux这样的操作系统,但是它有自己的运行框架CUDA(Compute Unified Device Architecture)。

CUDA框架包含开发库、运行期环境(它的系统)和硬件驱动。

因此CUDA可以使用C/C++或者其他高级语言像Python、Java来编程。

其中CUDA C/C++有下面几个特性:

(1)基于C/C++

(2)支持异构编程的扩展方法

(3)简单明了的APIs,能够轻松的管理存储系统

CUDA、cuDNN和Pytorch三个框架的关系

CUDA是英伟达的一个计算架构,最终留出的API接口也主要是图像、矩阵、向量的这类的数学运算。

cuDNN是对CUDA的封装,是英伟达提供的一个深度学习的库,例如向前和向后卷积,池化,规范化和激活层。

PyTorch是一个深度学习框架,可以调用CUDA和CUDNN来加速。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?