线性支持向量机,Linear Support Vector Classification.

与参数内核为线性的SVC类似(SVC(kernel=‘linear’)),但使用liblinear而非libsvm实现,因此在选择惩罚和损失函数时更具灵活性,并能更好地扩展到大量样本

SVC(kernel=’linear’)和LinearSVC()是类似的,只不过LinearSVC()是通过liblinear实现的;而SVC(kernel=’linear’)通过libsvm实现的;相较于SVC(kernel=’linear’),LinearSVC)(在选择惩罚和损失函数时更具灵活性,并能更好地扩展到大量样本

一、算法思路

本质都是SVM中的一种优化,原理都类似,详细算法思路可以参考博文:三、支持向量机算法(SVC,Support Vector Classification)(有监督学习)

二、官网API

class sklearn.svm.LinearSVC(penalty='l2', loss='squared_hinge', *, dual='warn', tol=0.0001, C=1.0, multi_class='ovr', fit_intercept=True, intercept_scaling=1, class_weight=None, verbose=0, random_state=None, max_iter=1000)

这里的参数还是比较多的,具体的参数使用,可以根据官网给的demo进行学习,多动手尝试;这里就以一些常用的参数进行说明。

导包:from sklearn.svm import LinearSVC

①惩罚项penalty

惩罚项的选择,指定惩罚中使用的规范

l2惩罚是SVC使用的标准,l1会导致coef_向量稀疏

正则化说白了就是对损失函数的一种约束限制

在线性回归中,L1正则化也称为Lasso回归,可以产生稀疏模型

在线性回归中,L2正则化也称为Ridge回归,可以获得很小的参数,防止过拟合

指定惩罚中使用的规范。l2 “惩罚是 SVC 使用的标准。l1” 会导致 coef_ 向量稀疏。

‘l1’:添加L1正则化

‘l2’:添加L2正则化,默认,L2正则化是SVC的使用标准

SVC()中可以选择None,而LinearSVC()中没有

具体官网详情如下:

使用方式

LinearSVC(penalty='l2')

②损失函数loss

loss,指定损失函数

hinge是标准SVM损失函数(如SVC类使用,而squared_hinge是hinge损失函数的平方

不支持 penalty=‘l1’ 和 loss=‘hinge’ 的组合

因为penalty='l2’是SVC的使用标准,loss='hinge’是标准SVM损失函数,只有这样配套的才可以搭配使用

‘hinge’:标准SVM损失函数

‘squared_hinge’:hinge损失函数的平方

具体官网详情如下:

使用方式

LinearSVC(loss='squared_hinge')

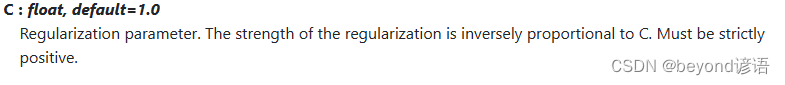

③正则化参数C

正则化强度与C成反比,惩罚是L2正则化的平方,C是一个浮点数类型

具体官网详情如下:

使用方式

LinearSVC(C=2.0)

④dual

是否选择解决对偶或原始优化问题的算法,默认为True

“auto”:将根据 n_samples、n_features、loss、multi_class 和 penalty 的值自动选择参数值

如果 n_samples < n_features,且优化器支持选择 loss、multi_class 和 penalty,那么 dual 将设为 True,否则设为 False

具体官网详情如下:

⑤随机种子random_state

如果要是为了对比,需要控制变量的话,这里的随机种子最好设置为同一个整型数

具体官网详情如下:

使用方式

LinearSVC(random_state=42)

⑤最终构建模型

LinearSVC(penalty=‘l2’,loss=‘squared_hinge’,C=2.0,random_state=42)

三、代码实现

①导包

这里需要评估、训练、保存和加载模型,以下是一些必要的包,若导入过程报错,pip安装即可

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import joblib

%matplotlib inline

import seaborn as sns

from sklearn.preprocessing import LabelEncoder

from sklearn.model_selection import train_test_split

from sklearn.svm import LinearSVC

from sklearn.metrics import confusion_matrix, classification_report, accuracy_score

②加载数据集

数据集可以自己简单整个,csv格式即可,我这里使用的是6个自变量X和1个因变量Y

fiber = pd.read_csv("./fiber.csv")

fiber.head(5) #展示下头5条数据信息

③划分数据集

前六列是自变量X,最后一列是因变量Y

常用的划分数据集函数官网API:train_test_split

test_size:测试集数据所占比例

train_size:训练集数据所占比例

random_state:随机种子

shuffle:是否将数据进行打乱

因为我这里的数据集共48个,训练集0.75,测试集0.25,即训练集36个,测试集12个

X = fiber.drop(['Grade'], axis=1)

Y = fiber['Grade']

X_train, X_test, y_train, y_test = train_test_split(X,Y,train_size=0.75,test_size=0.25,random_state=42,shuffle=True)

print(X_train.shape) #(36,6)

print(y_train.shape) #(36,)

print(X_test.shape) #(12,6)

print(y_test.shape) #(12,)

④构建LinearSVC模型

参数可以自己去尝试设置调整

lsvc = LinearSVC(penalty='l2',loss='squared_hinge',C=2.0,random_state=42)

⑤模型训练

就这么简单,一个fit函数就可以实现模型训练

lsvc.fit(X_train,y_train)

⑥模型评估

把测试集扔进去,得到预测的测试结果

y_pred = lsvc.predict(X_test)

看看预测结果和实际测试集结果是否一致,一致为1否则为0,取个平均值就是准确率

accuracy = np.mean(y_pred==y_test)

print(accuracy)

也可以通过score得分进行评估,计算的结果和思路都是一样的,都是看所有的数据集中模型猜对的概率,只不过这个score函数已经封装好了,当然传入的参数也不一样,需要导入accuracy_score才行,from sklearn.metrics import accuracy_score

score = lsvc.score(X_test,y_test)#得分

print(score)

⑦模型测试

拿到一条数据,使用训练好的模型进行评估

这里是六个自变量,我这里随机整个test = np.array([[16,18312.5,6614.5,2842.31,25.23,1147430.19]])

扔到模型里面得到预测结果,prediction = lsvc.predict(test)

看下预测结果是多少,是否和正确结果相同,print(prediction)

test = np.array([[16,18312.5,6614.5,2842.31,25.23,1147430.19]])

prediction = lsvc.predict(test)

print(prediction) #[2]

⑧保存模型

lsvc是模型名称,需要对应一致

后面的参数是保存模型的路径

joblib.dump(lsvc, './lsvc.model')#保存模型

⑨加载和使用模型

lsvc_yy = joblib.load('./lsvc.model')

test = np.array([[11,99498,5369,9045.27,28.47,3827588.56]])#随便找的一条数据

prediction = lsvc_yy.predict(test)#带入数据,预测一下

print(prediction) #[4]

完整代码

模型训练和评估,不包含⑧⑨。

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import joblib

%matplotlib inline

import seaborn as sns

from sklearn.preprocessing import LabelEncoder

from sklearn.model_selection import train_test_split

from sklearn.svm import LinearSVC

from sklearn.metrics import confusion_matrix, classification_report, accuracy_score

fiber = pd.read_csv("./fiber.csv")

# 划分自变量和因变量

X = fiber.drop(['Grade'], axis=1)

Y = fiber['Grade']

#划分数据集

X_train, X_test, y_train, y_test = train_test_split(X, Y, random_state=0)

lsvc = LinearSVC(penalty='l2',loss='squared_hinge',C=2.0,random_state=42)

lsvc.fit(X_train,y_train)

y_pred = lsvc.predict(X_test)

accuracy = np.mean(y_pred==y_test)

print(accuracy)

score = lsvc.score(X_test,y_test)#得分

print(score)

test = np.array([[16,18312.5,6614.5,2842.31,25.23,1147430.19]])

prediction = lsvc.predict(test)

print(prediction) #[2]

本文介绍了线性支持向量机LinearSVC,其基于liblinear库,具有灵活的惩罚和损失函数选择。文章详细解释了算法原理,参数解释,包括penalty(如L1和L2正则化),loss函数(如hinge和squared_hinge),以及如何在sklearn库中使用这些参数进行模型训练和评估。

本文介绍了线性支持向量机LinearSVC,其基于liblinear库,具有灵活的惩罚和损失函数选择。文章详细解释了算法原理,参数解释,包括penalty(如L1和L2正则化),loss函数(如hinge和squared_hinge),以及如何在sklearn库中使用这些参数进行模型训练和评估。

342

342

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?