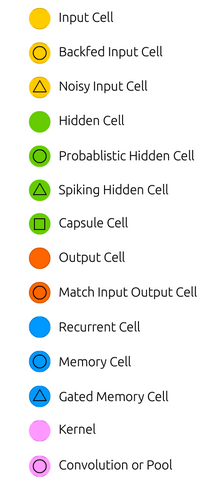

所有的节点是这样表示的

分别为:

输入节点

反馈输入节点

噪声输入节点

隐藏节点

概率隐藏节点

脉冲隐藏节点

胶囊节点

输出节点

对比输入输出节点

递归节点

记忆节点

记忆门节点

核

卷积和池化

前馈神经网络Feed forward neural networks (FF or FFNN)

前馈神经网络和感知机,是径直从头开始输入的,它们从前面一个节点得到信息,然后向后传输信息,一个竖着的神经网络一般描述为一层,其中输入层,隐藏层,输出层都是并行的,一个单独的层中间的节点是没有联系的,通常是和前后两层有联系,最简单的实际网络有两个输入节点,一个输出节点,可以用来模拟逻辑门。我们通常用反向传播来训练FFNN,给神经网络输入成对的数据,输出一个数据。这是监督学习,不是无监督学习,我们只给它输入信息,让网络填补空白,反向传播的错误,通常是输入和输出之间的差异的一些变化。考虑到网络中拥有足够的颖仓神经元,理论上可以模拟输入和输出的关系。实际上,它们的使用是非常有限的,但它们通常与其他网络结合形成新的网络。

径向基函数(RBF)网络 是以径向基函数为激活函数的FFNN网络。没有别的了。并不意味着它们没有自己的用途,但是大多数具有其他激活功能的FFNN没有自己的名称。这主要与在正确的时间发明它们有关。

递归神经网络,也称作循环神经网络RNN

循环神经网络是具有隐含状态的,在隐藏层的每个节点,节点与节点自己是有联系的,在同一层中,节点与节点之间也是有联系的,前后层节点之间也是有联系的,但是输入层和输出层,节点之间是 肯定没有联系的,一个节点的输入有可能是上一层,有可能是同一层的其他节点,也有可能是节点自己。RNN最大的问题就是随着时间的推移,可能会发生梯度消失而无法学习的问题(这个问题在后面的LSTM中得到缓解),信息随着时间的推移迅速丢失,就像非常深的FFNN在深度上丢失信息,直观地说,这不是什么问题,因为这些只是权重,而不是神经元状态,但时间权重实际上是存储过去信息的位置;如果权重达到0或1000 000,则以前的状态就不会具有很高的信息量。

循环神经网络是具有隐含状态的,在隐藏层的每个节点,节点与节点自己是有联系的,在同一层中,节点与节点之间也是有联系的,前后层节点之间也是有联系的,但是输入层和输出层,节点之间是 肯定没有联系的,一个节点的输入有可能是上一层,有可能是同一层的其他节点,也有可能是节点自己。RNN最大的问题就是随着时间的推移,可能会发生梯度消失而无法学习的问题(这个问题在后面的LSTM中得到缓解),信息随着时间的推移迅速丢失,就像非常深的FFNN在深度上丢失信息,直观地说,这不是什么问题,因为这些只是权重,而不是神经元状态,但时间权重实际上是存储过去信息的位置;如果权重达到0或1000 000,则以前的状态就不会具有很高的信息量。

RNN在NLP领域运用的很多,其实一般来说,数据是呈序列的,比如是一句话,比如是股票成交量,外汇率等待,就可以放进去预测。

长短记忆神经网络 LSTM Long Short Term Memory Networks

LSTM就是用来解决RNN 梯度消失的问题的,LSTM试图通过明确定义记忆节点,来解决梯度消失问题,每个节点都有输入输出和遗忘门,这些门的功能就是以阻止或者允许信息流通过来保护信息的,输入门决定前一层的信息存储在单元中的数量,输出层在另一端接受作业,并缺点下一层要接受多少信息的,遗忘门看似非常奇怪,但是有时候这是有益的遗忘,就像人读书一样,读下一章,那就把之前章节不重要的信息给忘记,只留下重要的信息一样。注意,每个门对前一个神经元中的一个细胞都有权重,因此需要更多的资源来运行。

LSTM就是用来解决RNN 梯度消失的问题的,LSTM试图通过明确定义记忆节点,来解决梯度消失问题,每个节点都有输入输出和遗忘门,这些门的功能就是以阻止或者允许信息流通过来保护信息的,输入门决定前一层的信息存储在单元中的数量,输出层在另一端接受作业,并缺点下一层要接受多少信息的,遗忘门看似非常奇怪,但是有时候这是有益的遗忘,就像人读书一样,读下一章,那就把之前章节不重要的信息给忘记,只留下重要的信息一样。注意,每个门对前一个神经元中的一个细胞都有权重,因此需要更多的资源来运行。

4095

4095

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?