将总结的一些神经网络记录,复习

1998_Le-net

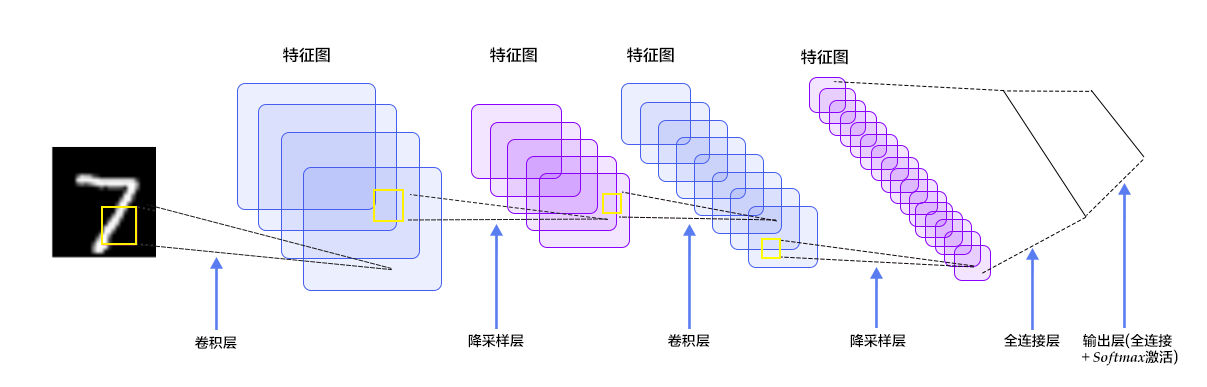

图:

网络描述:

LeNet是卷积神经网络的祖师爷LeCun在1998年提出,用于解决手写数字识别的视觉任务。自那时起,CNN的最基本的架构就定下来了:卷积层、池化层、全连接层。如今各大深度学习框架中所使用的LeNet都是简化改进过的LeNet-5(-5表示具有5个层),和原始的LeNet有些许不同,比如把激活函数改为了现在很常用的ReLu。

它是一个6层网络结构:由三个卷积层,两个下采样层和一个全连接层组成(图中C代表卷积层,S代表下采样层,F代表全连接层)。其中,C5层也可以看成是一个全连接层,因为C5层的卷积核大小和输入图像的大小一致,都是5*5。

特点,优点:

(1)卷积+池化+非线性变化

(2)使用最大池化层

(3)使用的激活函数为:relu

(4)全部使用5x5的卷积核

Parameters、FLOPS

代码:

keras实现:

class LeNet:

@staticmethod

def build(width, height, depth, classes, weightsPath=None):

# initialize the model

model = Sequential()

# first set of CONV => RELU => POOL

model.add(Convolution2D(20, 5, 5, border_mode="same",

input_shape=(depth, height, width)))

model.add(Activation("relu"))

model.add(MaxPooling2D(pool_size=(2, 2), strides=(2, 2)))

# second set of CONV => RELU => POOL

model.add(Convolution2D(50, 5, 5, border_mode="same"))

model.add(Activation("relu"))

model.add(MaxPooling2D(pool_size=(2, 2), strides=(2, 2)))

# set of FC => RELU layers

model.add(Flatten())

model.add(Dense(500))

model.add(Activation("relu"))

# softmax classifier

model.add(Dense(classes))

model.add(Activation("softmax"))

# if weightsPath is specified load the weights

if weightsPath is not None:

model.load_weights(weightsPath)

return model

pytorch实现:

class LeNet(nn.Module):

def __init__(self):

super(LeNet,self).__init__()

#Conv1 和 Conv2:卷积层,每个层输出在卷积核(小尺寸的权重张量)和同样尺寸输入区域之间的点积;

self.conv1 = nn.Conv2d(1,10,kernel_size=5)

self.conv2 = nn.Conv2d(10,20,kernel_size=5)

self.conv2_drop = nn.Dropout2d()

self.fc1 = nn.Linear(320,50)

self.fc2 = nn.Linear(50,10)

def forward(self,x):

x = F.relu(F.max_pool2d(self.conv1(x),2)) #使用 max 运算执行特定区域的下采样(通常 2x2 像素);

x = F.relu(F.max_pool2d(self.conv2_drop(self.conv2(x)),2))

x = x.view(-1, 320)

x = F.relu(self.fc1(x)) #修正线性单元函数,使用逐元素的激活函数 max(0,x);

x = F.dropout(x, training=self.training) #Dropout2D随机将输入张量的所有通道设为零。当特征图具备强相关时,dropout2D 提升特征图之间的独立性;

x = self.fc2(x)

return F.log_softmax(x, dim=1) #将 Log(Softmax(x)) 函数应用到 n 维输入张量,以使输出在 0 到 1 之间。

1884

1884

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?