前言

由于Dify默认通过简单的配置快速搭建一个基于 LLM 的对话机器人,对话是不支持文件上传的,只能简单文字对话。这样过于弱鸡不可能每次需要分析文档就先去知识库上传文档再回来对话,过于繁琐。

自定义工作流编排上传文件读取文档内容

创建一个新的应用,选择Chatflow

选择功能,打开文件上传功能,点击设置按钮,自定义文件上传属性设置

现在聊天助手已经支持对话文件上传了,但是DeepSeek并不知道文档里面有什么信息,这个时候需要添加节点提前识别出文档的内容

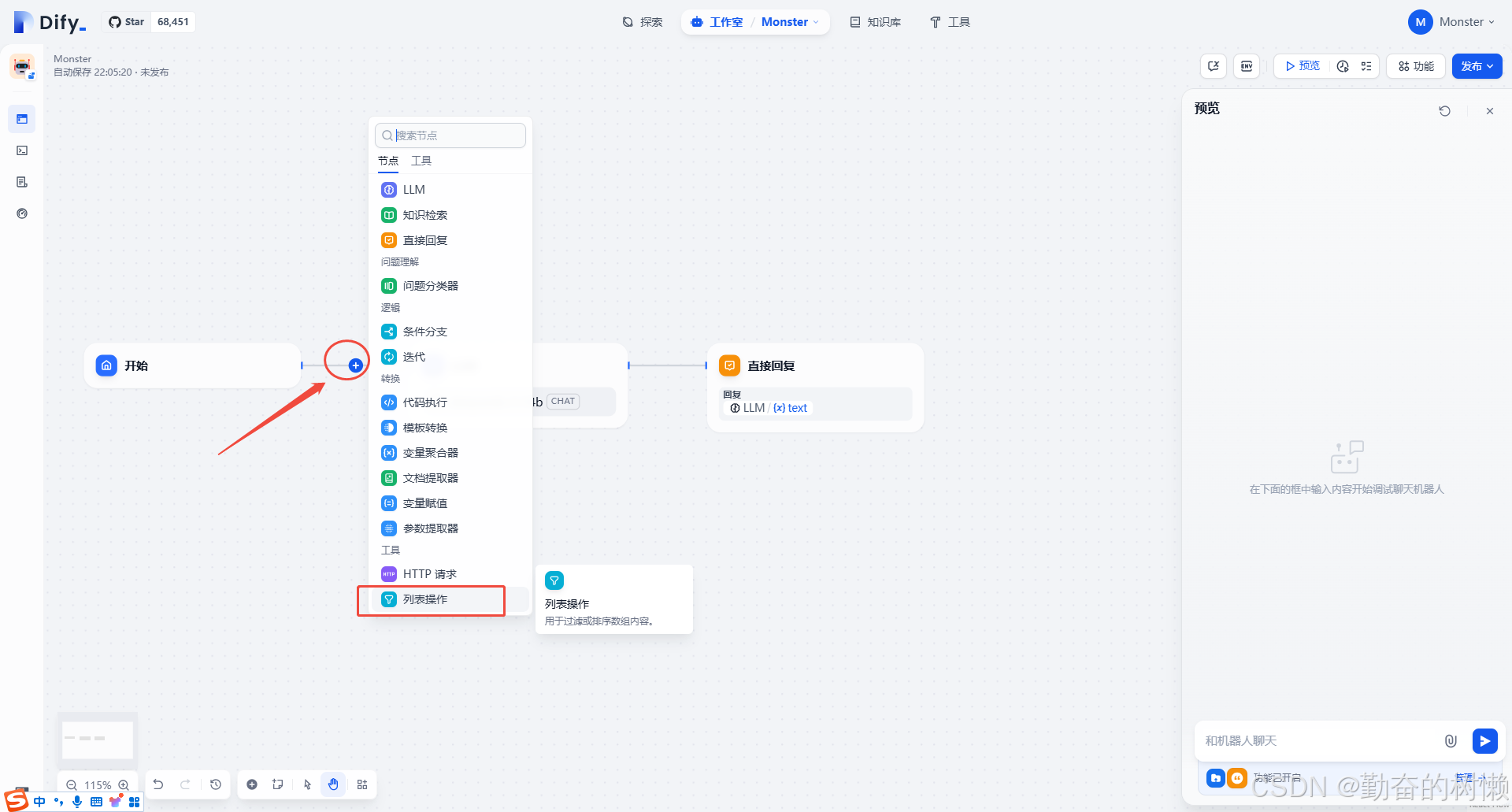

在AI模型节点的前面加上一个列表操作的节点,用来识别对话的时候是否上传了文件

设置变量为文件,开启过滤条件,属性为文档

继续在列表操作节点后面添加一个文档提取器,把上传的文档数据识别出来

输出变量可以选择数组、第一个和最后一个,我这里对话上传文件设置了可以上传多个,这里选择了数组

接着更新LLM设置,上下文选择我们文档提取器,等于把文档提取器识别的信息丢给DeepSeek

然后直接输出,修改为我们文档提取器的内容

运行测试一下,现在已经实现对话上传文档对话了。

上传文件加知识库对话

现在已经实现了上传文件且能识别出文档的信息对话了,但是没有关联本地知识库。

继续完善编排

在开始后面加个条件分支判断

选择文件不为空就继续下一个节点到列表操作,否则去知识检索

设置知识检索,引用你的知识库,下一节点到DeepSeek模型

设置LLM,上下文优先查询引用的本地知识库,然后下一节点直接回复

测试效果,对话上传文档问里面的信息,然后文字问些本地知识库信息都能识别到。

3443

3443

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?