1.全连接神经网络

全连接神经网络中,对n-1层和n层而言,n-1层的任意一个节点,都和第n层所有节点有连接。即第n层的每个节点在进行计算的时候,激活函数的输入是n-1层所有节点的加权,这个激活函数是非线性的。它的缺点就是权重太多了,计算量很大。

它可作用于大多数场景

2.卷积神经网络

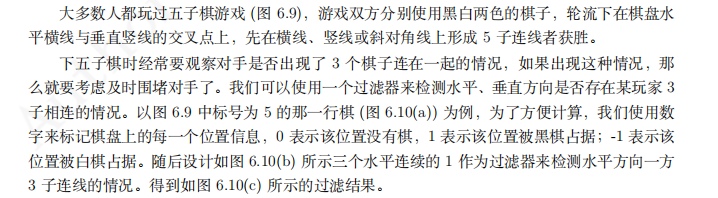

2.1走五子棋的例子

2.2卷积核

卷积核:负责检测对应的一个特征。

卷积核的大小也影响网络的架构,早期习惯使用77,99的大卷积核,近来发现研究大的卷积核可以用多个33的卷积核来代替,同时总体参数也减少了。

**因而目前主流卷积神经网络都倾向于33大小的卷积核。**

卷积核的参数是由网络通过学习得到的。

2.3通道

每一个卷积操作的结果一般称为一个通道(channel),也称为一个映射(map)

卷积隐藏层通道的个数反映了网络在这一层的特征检测能力。

通常卷积神经网络越靠近输出层其通道数就越多,但每一个通道的数据规模越来越小。

2.4池化

池化操作不需要任何参数,这大大减少了参数的个数。

池化操作与卷积操作相似,也具有大小f、步长s、扩展p等概念,

池化操作分为两种:最大池化和平均池化。

2.5全连接层

池化和全连接层在卷积神经网络中的作用越来越被淡化,有些卷积神经网络甚至抛弃了全连接层。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?