HBase Java API编程

一、任务要求:

(1)createTable(String tableName, String[] fields)

创建表,参数tableName为表的名称,字符串数组fields为存储记录各个域名称的数组。要求当HBase已经存在名为tableName的表的时候,先删除原有的表,然后再创建新的表。

主要代码:

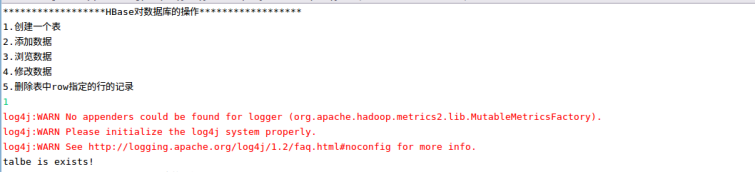

运行结果:

用HBase shell中查看

(2)addRecord(String tableName, String row, String[] fields, String[] values)

向表tableName、行row(用S_Name表示)和字符串数组files指定的单元格中添加对应的数据values。其中fields中每个元素如果对应的列族下还有相应的列限定符的话,用“columnFamily:column”表示。例如,同时向“Math”、“Computer Science”、“English”三列添加成绩时,字符串数组fields为{“Score:Math”,”Score;Computer Science”,”Score:English”},数组values存储这三门课的成绩。

主要代码:

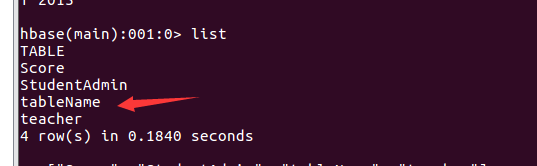

运行结果:

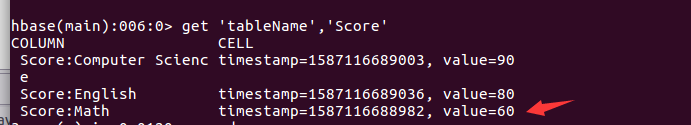

用HBase shell中查看

确实添加了三组数据

(3)scanColumn(String tableName, String column)

浏览表tableName某一列的数据,如果某一行记录中该列数据不存在,则返回null。要求当参数column为某一列族名称时,如果底下有若干个列限定符,则要列出每个列限定符代表的列的数据;当参数column为某一列具体名称(例如“Score:Math”)时,只需要列出该列的数据。

主要代码:

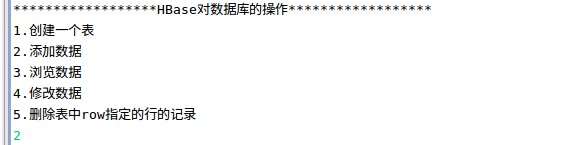

运行结果:

与用HBase shell中查看的结果一致。

(4)modifyData(String tableName, String row, String column)

修改表tableName,行row(可以用学生姓名S_Name表示),列column指定的单元格的数据。

主要代码:

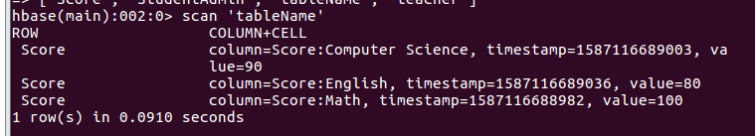

运行结果用HBase shell查看:

Math的分数由100变成了60,修改成功。

(5)deleteRow(String tableName, String row)

删除表tableName中row指定的行的记录。

主要代码:

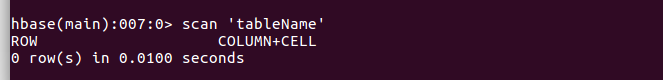

运行结果用HBase shell 查看

没有数据,成功删除了。

二、完整代码实现

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.hbase.*;

import org.apache.hadoop.hbase.client.*;

import org.apache.hadoop.hbase.util.Bytes;

import java.io.IOException;

import java.util.Scanner;

public class HBaseAPI {

public static Configuration configuration;

public static Connection connection;

public static Admin admin;

public static long ts;

public static void main(String[] args) throws IOException {

Scanner in = new Scanner(System.in);

while (true) {

System.out

.println("******************HBase对数据库的操作******************");

System.out.println("1.创建一个表");

System.out.println("2.添加数据");

System.out.println("3.浏览数据");

System.out.println("4.修改数据");

System.out.println("5.删除表中row指定的行的记录");

int a = in.nextInt();

switch (a) {

case 1:

createTable("tableName", new String[] { "Score" });

break;

case 2:

String[] fields = { "Score:Math", "Score:Computer Science",

"Score:English" };

String[] values = { "100", "90", "80" };

addRecord("tableName", "Score", fields, values);

break;

case 3:

scanColumn("tableName", "Score");

break;

case 4:

modifyData("tableName", "Score", "Math", "60");

break;

case 5:

deleteRow("tableName", "Score");

break;

}

}

}

// 建立连接

public static void init() {

configuration = HBaseConfiguration.create();

configuration.set("hbase.rootdir", "hdfs://localhost:9000/hbase");

try {

connection = ConnectionFactory.createConnection(configuration);

admin = connection.getAdmin();

} catch (IOException e) {

e.printStackTrace();

}

}

// 关闭连接

public static void close() {

try {

if (admin != null) {

admin.close();

}

if (null != connection) {

connection.close();

}

} catch (IOException e) {

e.printStackTrace();

}

}

// 创建表

public static void createTable(String myTableName, String[] fields)

throws IOException {

init();

TableName tableName = TableName.valueOf(myTableName);

if (admin.tableExists(tableName)) {

System.out.println("talbe is exists!");

} else {

HTableDescriptor hTableDescriptor = new HTableDescriptor(tableName);

for (String str : fields) {

HColumnDescriptor hColumnDescriptor = new HColumnDescriptor(str);

hTableDescriptor.addFamily(hColumnDescriptor);

}

admin.createTable(hTableDescriptor);

System.out.println("create table success");

}

close();

}

// 添加数据

public static void addRecord(String tableName, String row, String[] fields,

String[] values) throws IOException {

init();

Table table = connection.getTable(TableName.valueOf(tableName));

for (int i = 0; i != fields.length; i++) {

Put put = new Put(row.getBytes());

String[] cols = fields[i].split(":");

put.addColumn(cols[0].getBytes(), cols[1].getBytes(),

values[i].getBytes());

table.put(put);

}

table.close();

close();

}

// 浏览数据

public static void scanColumn(String tableName, String column)

throws IOException {

init();

Table table = connection.getTable(TableName.valueOf(tableName));

Scan scan = new Scan();

scan.addFamily(Bytes.toBytes(column));

ResultScanner scanner = table.getScanner(scan);

for (Result result = scanner.next(); result != null; result = scanner

.next()) {

showCell(result);

}

table.close();

close();

}

public static void showCell(Result result) {

Cell[] cells = result.rawCells();

for (Cell cell : cells) {

System.out.println("RowName:" + new String(CellUtil.cloneRow(cell))

+ " ");

System.out.println("Timetamp:" + cell.getTimestamp() + " ");

System.out.println("column Family:"

+ new String(CellUtil.cloneFamily(cell)) + " ");

System.out.println("row Name:"

+ new String(CellUtil.cloneQualifier(cell)) + " ");

System.out.println("value:" + new String(CellUtil.cloneValue(cell))

+ " ");

}

}

// 修改数据

public static void modifyData(String tableName, String row, String column,

String val) throws IOException {

init();

Table table = connection.getTable(TableName.valueOf(tableName));

Put put = new Put(row.getBytes());

Scan scan = new Scan();

ResultScanner resultScanner = table.getScanner(scan);

for (Result r : resultScanner) {

for (Cell cell : r

.getColumnCells(row.getBytes(), column.getBytes())) {

ts = cell.getTimestamp();

}

}

put.addColumn(row.getBytes(), column.getBytes(), ts, val.getBytes());

table.put(put);

table.close();

close();

}

//删除表中row指定的行的记录

public static void deleteRow(String tableName, String row)

throws IOException {

init();

Table table = connection.getTable(TableName.valueOf(tableName));

Delete delete = new Delete(row.getBytes());

table.delete(delete);

table.close();

close();

}

}

1754

1754

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?