点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达

生成式多标签零样本学习

作者:Akshita Gupta; Sanath Narayan; Salman Khan; Fahad Shahbaz Khan; Ling Shao; Joost van de Weijer

源码链接: https://github.com/akshitac8/Generative_MLZSL

摘要

多标签零样本学习旨在将图像分类到多个未见类别中,这些类别在训练期间没有可用数据。测试样本还可以包含泛化变体中的已见类别。现有方法依赖于从已见类别中学习共享或标签特定的注意力。然而,在多标签设置中,计算未见类别的可靠注意力图在推理期间仍然是一个挑战。相比之下,最先进的单标签生成对抗网络(GAN)基于的方法学习直接从相应的类属性嵌入合成类特定视觉特征。然而,在零样本设置的背景下,从 GAN 合成多标签特征仍未被探索。当单个图像中同时出现多个对象时,一个关键问题是如何在属性级别、特征级别和跨级别(跨属性和特征级别)有效地融合多类信息以合成多标签特征。据我们所知,我们的工作是第一个解决(泛化)零样本设置中多标签特征合成问题的工作。我们基于跨级别融合的生成方法在三个零样本基准测试中表现优于现有技术:NUS-WIDE、Open Images 和 MS COCO。此外,我们展示了我们的融合方法在 MS COCO 上的零样本检测任务中的泛化能力,与现有方法相比取得了有利的性能。

关键词

泛化零样本学习,多标签分类,零样本目标检测,特征合成。

I. INTRODUCTION

多标签分类是一个具有挑战性的问题,任务是识别图像中的所有标签。多标签分类的典型例子包括 MS COCO [1] 和 NUS-WIDE [2] 数据集,其中一张图像可能包含多个不同的类别(标签)。大多数最近的多标签分类方法通过利用注意力机制 [3]、[4]、[5]、递归神经网络 [6]、[7]、[8]、图 CNN [9]、[10] 和标签相关性 [11]、[12] 来解决这个问题。然而,这些方法并没有解决多标签零样本分类的问题,即在测试时将图像分类到多个新的“未见”类别中,而在训练期间没有给出任何相应的视觉示例。与零样本学习(ZSL)不同,测试样本可以属于在泛化零样本学习(GZSL)中看到或未见的类别。在这里,我们解决了大规模多标签 ZSL 和 GZSL 的具有挑战性的问题。

现有的多标签(G)ZSL 方法通过利用全局图像表示 [13]、[14]、结构化知识图 [15] 和基于注意力的机制 [16] 来解决问题。与多标签设置不同,单标签(泛化)零样本学习,其中一张图像包含至多一个类别标签,已经得到了显著的关注 [17]、[18]、[19]、[20]、[21]、[22]、[23]、[24]、[25]、[26]。最先进的单标签(G)ZSL 方法 [25]、[26]、[27]、[28]、[29]、[30]、[31] 是生成性的。这些方法利用生成模型(如生成对抗网络(GAN)[32] 和变分自编码器(VAE)[33])的强大功能来合成未见类别特征。通常,使用特征合成生成器来构建单标签特征。由于其能够通过学习已见类别(真实)特征的底层数据分布来合成未见类别(假)特征,生成方法目前在单标签 ZSL 中占据主导地位。然而,现有的 ZSL 框架中的生成器仅合成单标签特征。据我们所知,为多标签 ZSL 设计一个特征合成生成器的问题尚未被探索。

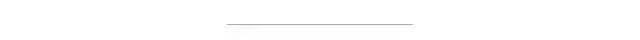

在这项工作中,我们通过引入基于生成范式的方法来解决多标签(泛化)零样本学习问题。在设计生成性多标签零样本方法时,主要目标是从相应的类属性(嵌入)合成语义一致的多标签视觉特征。多标签视觉特征可以通过两种方式合成。i) 一种方法是在生成器的输入处整合类特定属性嵌入,以产生全局图像级嵌入向量。我们称这种方法为属性级融合(ALF)。在这里,图像级嵌入表示图像中正标签的整体分布(见图 1)。由于 ALF 中的生成器执行全局图像级特征生成,因此它能够更好地捕获图像中的标签依赖性(标签之间的相关性)。然而,由于没有明确编码关于各个类别的区分信息,这种基于全局嵌入的特征生成具有较低的类别特定区分能力。ii) 第二种方法是单独合成来自类特定嵌入的特征,然后在视觉特征空间中整合它们。我们称这种方法为特征级融合(FLF),如图 1 所示。尽管 FLF 在合成特征时更好地保留了类别特定区分信息,但它并没有明确编码图像中的标签依赖性,因为特征是独立于彼此合成的。这激发了我们探索多标签特征合成的替代融合方法。

在这项工作中,我们引入了一种替代的融合方法,它结合了 ALF 的标签依赖性和 FLF 的类别特定区分能力,在多标签特征合成期间。我们称这种方法为跨级特征融合(CLF),如图 1 所示。CLF 方法利用每个单独级别的特征,并关注双级别上下文(来自 ALF 和 FLF)。结果,各个级别的特征适应自己以产生丰富的合成特征,然后汇聚以获得 CLF 输出。除了多标签零样本分类,我们还研究了所提出的多标签特征生成 CLF 方法在(泛化)零样本目标检测中的应用。

贡献:我们提出了一种多标签(泛化)零样本学习的生成方法。据我们所知,我们是第一个探索零样本设置中多标签特征合成问题的工作。我们研究了三种不同的融合方法(ALF、FLF 和 CLF)来合成多标签特征。我们的 CLF 方法结合了 ALF 的标签依赖性和 FLF 的类别特定区分能力。此外,我们将我们的融合方法集成到两个代表性的生成架构中:f-CLSWGAN [25] 和 f-VAEGAN [26]。我们希望我们简单有效的方法可以作为一个坚实的基线,并有助于促进生成性多标签零样本学习的未来研究。

我们的方法在 NUS-WIDE [2]、Open Images [34] 和 MS COCO [1] 上进行了评估。我们的 CLF 方法在所有数据集上的性能都优于 ALF 和 FLF。此外,CLF 在 Open Images 大规模数据集上,在 top-K 预测中的 GZSL F1 分数上分别比现有技术高出 18.7% 和 17.6%(K ∈ {10, 20})。我们还在 MS COCO 上评估了 CLF 的(泛化)零样本目标检测,取得了与现有方法相比有利的结果。

II. GENERATIVE SINGLE-LABEL ZERO-SHOT LEARNING

如前所述,最先进的单标签零样本学习方法 [25]、[26]、[27]、[28]、[29]、[30] 是生成性的,利用生成模型(例如,GAN [32]、VAE [33])的力量来合成未见类别特征。这里,每张图像被假定有一个单一的对象类别标签(例如,CUB [35]、FLO [36] 和 AWA [24])。

问题表述:设 表示图像的编码特征实例, 表示来自已见类别集合 的相应类别标签。设 表示与已见类别 互不相交的未见类别集合。这里,已见和未见类别的总数由 表示。所有已见和未见类别之间的关系由类别特定的语义嵌入 描述。为了学习 ZSL 和 GZSL 分类器,现有的单标签 GAN 基于方法 [25]、[26]、[28]、[29] 首先使用已见类别特征 和相应的类别嵌入 学习生成器。然后,学习到的生成器和未见类别嵌入 被用来合成未见类别特征 。进一步,合成的特征 与真实的已见类别特征 一起被用来训练最终分类器 和 。

通常,基于 GAN 的单标签零样本框架利用特征合成生成器 和判别器 。 和 在两个玩家的最小最大游戏中相互竞争。当 试图准确区分真实图像特征 和生成特征 时, 试图通过生成语义上接近真实特征的特征来愚弄 。由于需要合成类特定特征,因此采用条件 Wasserstein GAN [37] 由于其更稳定的训练,通过在嵌入 上对 和 进行条件化。这里, 学习从相应的单标签嵌入 合成类特定特征 ,由 给出。然而,生成器在现有的零样本学习框架中仅合成单标签特征。据我们所知,为多标签零样本学习范式设计一个特征合成生成器的问题尚未被探索。

III. 生成式多标签零样本学习

在现实世界的任务中,大多数涉及多标签识别,其中图像可以包含多个和广泛的类别标签(例如,Open Images [34])。在零样本学习设置中,多标签分类变得更加具有挑战性,测试集要么只包含看不见的类别(ZSL),要么同时包含看到和看不见的类别(GZSL)。在这项工作中,我们提出了一种生成式多标签零样本学习方法,利用生成模型的能力来学习看到类别的潜在数据分布。这有助于通过合成(假的)看不见类别的特征来模仿全监督设置。与单标签设置不同,多标签特征合成需要准确整合多个类别信息,这些类别在图像中共同出现。因此,在多标签特征合成中,准确融合每个标签嵌入的类别信息变得至关重要。

问题表述:与单标签零样本学习不同,这里, 表示多标签图像的编码特征实例, 对应于来自看到类别标签集合 的多热标签。设 表示图像的多标签特征实例, 表示其具有 个正类的多热标签。然后,图像的属性集可以表示为 ,其中 。这里,我们使用类名的GloVe [38] 向量作为属性 ,如 [16] 中所述。现在,生成器的任务是学习从关联的嵌入向量 合成多标签特征 。在训练 G 之后,合成对应于看不见类别的多标签特征。然后,将合成的特征和真实看到的类别特征一起部署,用于训练最终分类器 和 。

A. 生成式多标签特征合成

为了合成多标签特征,我们引入了三种融合方法:属性级融合(ALF)、特征级融合(FLF)和跨级特征融合(CLF)。

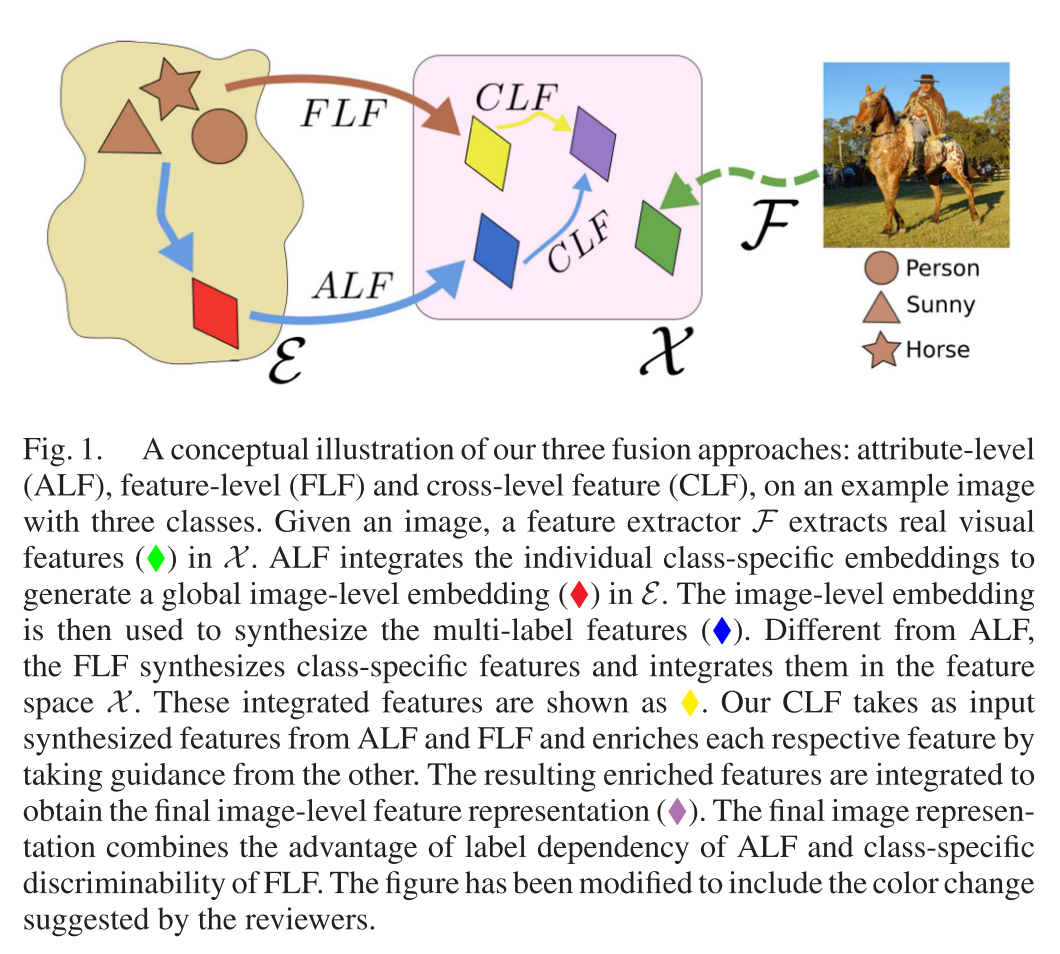

属性级融合:在属性级融合(ALF)方法中,从一组对应于图像中多个标签的类特定嵌入向量中获得全局图像级嵌入向量。图像级嵌入表示图像中正标签的全局描述。全局嵌入 通过对个别类嵌入 求平均获得。然后,嵌入 与噪声 一起输入生成器 以合成特征 。属性级融合由以下公式给出:

和

图 2(a) 显示了从嵌入 合成特征 。ALF 中的生成器 执行全局图像级特征生成,从而捕获图像中的标签依赖性(标签之间的相关性)。然而,由于没有明确编码关于各个类别的区分信息,这种从全局嵌入生成的特征具有较低的类别特定区分性。

特征级融合:这里,我们引入了特征级融合(FLF)方法,它单独从类特定嵌入中合成特征。这使得 FLF 方法能够更好地保留合成特征中的类别特定区分性。与整合类嵌入的 ALF 不同,FLF 首先将 个类特定嵌入 输入 并生成 个类特定潜在特征 。然后通过平均操作将这些特征整合,以获得最终合成特征 。特征级融合(FLF)由以下公式表示:

和

图 2(b) 显示了从个别嵌入 合成特征 。我们从公式 (2) 观察到,对于固定的噪声 ,生成器 为类别 合成固定的潜在特征 ,无论图像中是否存在其他类别。因此,虽然生成的潜在特征 更好地保留了图像中存在的正类别 的类别特定区分信息,但 独立于彼此合成它们。结果,合成的特征 没有明确编码图像中的标签依赖性。

正如上文讨论的,上述两种融合方法(ALF 和 FLF)在合成多标签特征时都有缺点。接下来,我们引入一种融合方法,结合了 ALF 的标签依赖性和 FLF 的类别特定区分性的优势。

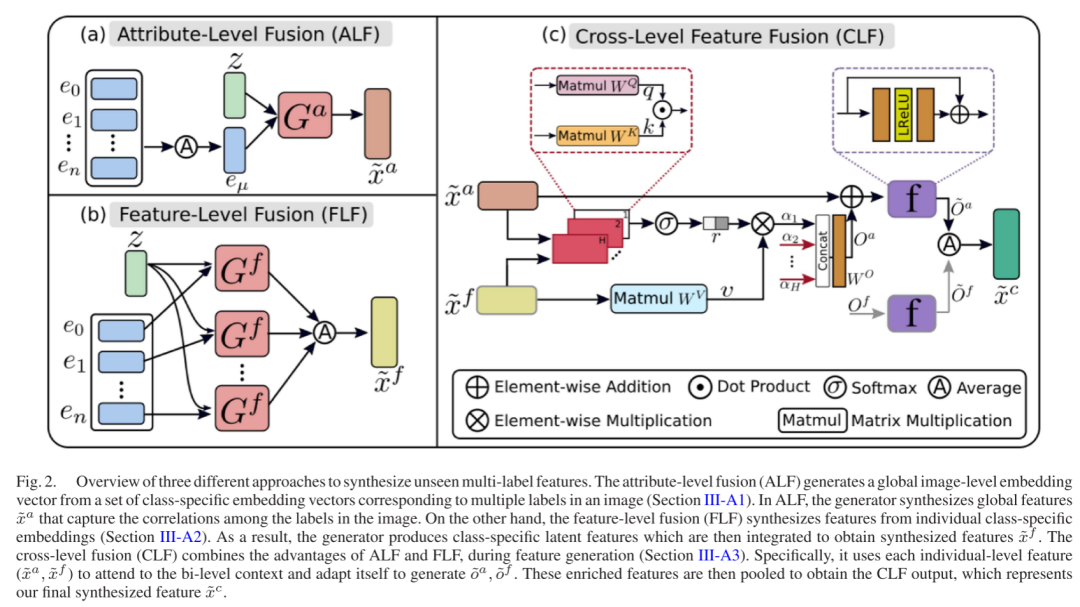

跨级特征融合:提出的跨级特征融合(CLF)旨在结合 ALF 和 FLF 的优势。CLF 方法(见图 2(c))在特征生成阶段结合了 ALF 的标签依赖性和 FLF 的类别特定区分性。为此,将 和 前馈到特征融合块。受多头自注意力 [39] 的启发,特征融合块通过从另一个分支获取指导来丰富每个相应特征。具体来说,我们通过堆叠个别特征 和 创建一个矩阵 。然后,使用总共 个投影头将这些特征线性投影到低维空间()以创建查询-键-值三元组,

其中 并且 。对于每个特征,其当前形式的状态保留在“值”嵌入中,而从每个输入特征派生的查询向量用于找到它与从两个特征获得的键的相关性,如下所述。

给定每个头的这些三元组,特征经历两个级别的处理:i) 在三元组上的内部头部处理,以及 ii) 跨头部处理。对于第一种情况,使用以下公式将每个查询向量与来自两个特征的“键”相关联。从 softmax 函数()得到的归一化关系分数()用于重新加权相应的值向量,从而获得注意力特征 ,

其中

为了在所有头部之间聚合信息,这些来自每个头部的低维注意力特征被连接并通过一个输出层处理,以生成原始的 维输出向量 ,

其中 是一个可学习的权重矩阵。在获得自注意力特征 之后,从输入到注意力特征添加了一个残差分支,并通过一个小型残差子网络 进一步处理,以帮助网络首先关注局部邻域,然后逐渐关注其他级别的特征,

使得

这鼓励网络选择性地向源向量 添加补充信息。最后,我们对矩阵 沿行维度进行均值池化,以获得单个跨级融合特征 ,

跨级融合特征 通过有效地融合 ALF 和 FLF 生成的特征获得(见图 3)。因此, 明确编码了图像中的标签之间的相关性,以及图像中存在的正类别的类别特定区分信息。接下来,我们描述将我们的 CLF 集成到代表性生成架构中以进行多标签零样本分类。

B. 多标签零样本分类

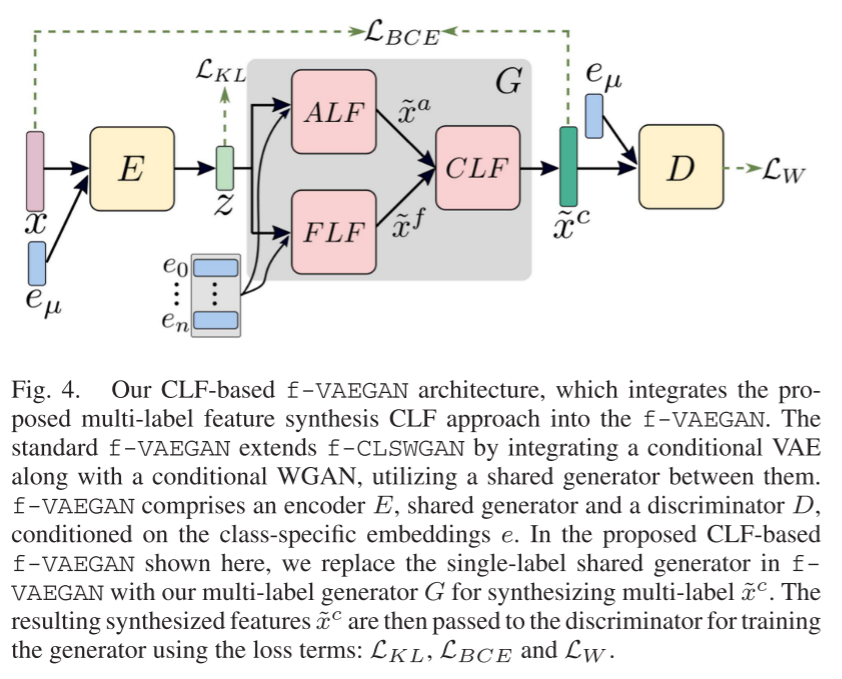

我们将我们的融合方法集成到两个代表性的生成架构中(f-CLSWGAN [25] 和 f-VAEGAN [26])以进行多标签零样本分类。由于 CLF 集成了 ALF 和 FLF,我们仅在这里描述将 CLF 集成到两个分类框架中。接下来,我们描述将 CLF 集成到 f-CLSWGAN 中,然后是 f-VAEGAN。

简单来说,f-CLSWGAN 包括一个条件 WGAN,条件是嵌入 ,以及一个看到类别的分类器 。我们用我们的多标签特征生成器(CLF)替换了 f-CLSWGAN 的标准生成器,以合成多标签特征 。得到的多标签 WGAN 损失由以下公式给出:

其中 是使用 (5) 为看到类别合成的, 是惩罚系数, 是 和 的凸组合。此外,使用在看到类别上训练的分类器 ,鼓励生成器合成适合最终 ZSL/GZSL 分类的特征。我们 CLF 基于 f-CLSWGAN 在多标签设置中的最终训练目标由以下公式给出:

其中 表示预测的多标签 和特征 的真实多标签 之间的标准二元交叉熵损失。

除了 f-CLSWGAN,我们还将在 f-VAEGAN [26] 框架中集成我们的 CLF 以执行多标签特征合成。f-VAEGAN 通过结合条件 VAE [33] 和条件 WGAN,利用它们之间的共享生成器来扩展 f-CLSWGAN。有关 f-VAEGAN 的更多详细信息,我们参考 [26]。类似于我们前面描述的 CLF 基于 f-CLSWGAN,我们用我们的多标签生成器(CLF)替换了 f-VAEGAN 中的单标签共享生成器,以合成多标签 。得到的 CLF 基于 f-VAEGAN 类似于标准 f-VAEGAN 进行训练,使用原始的损失公式 [26]。图 4 显示了我们的 CLF 基于 f-VAEGAN 架构,用于多标签(泛化)零样本分类。

IV. 实验

数据集:我们在三个基准数据集上评估我们的方法:NUS-WIDE [2]、Open Images [34] 和 MS COCO [1]。NUS-WIDE 数据集包含近 270K 张图像,有 81 个人工标注的类别,以及从 Flickr 用户标签中获得的 925 个标签。与 [14]、[16] 中一样,925 个和 81 个标签分别用作看到和看不到的类别。Open Images (v4) 是一个大规模数据集,有 900 万训练图像以及 41,620 个验证图像和 125,456 个测试图像。它是部分标注的,包括人工和机器生成的标签。这里,选择至少有 100 个训练图像的 7,186 个标签作为看到类别。选择测试集中最常见的 400 个不在训练数据中的标签作为看不到的类别,如 [16] 中所述。MS COCO 数据集分为训练和验证集,分别有 82,783 张和 40,504 张图像。在这里,我们执行多标签零样本实验,使用与 [40]、[41] 中相同的分割(65 个看到和 15 个看不到的类别)。

评估指标:与 [16]、[42] 一样,我们使用 F1 分数(在 top-K 预测中)和平均精度均值(mAP)来评估我们的零样本分类方法。F1 分数捕捉了模型在每张图像中正确排列标签的能力,而 mAP 指标捕捉了模型对每个标签的图像排名准确性。

多标签组合:合成用于学习最终多标签 ZSL 和 GZSL 分类器的多标签特征需要仅包含看不到的类别的多标签组合,以及包含看到和看不到类别的组合。为了获得这些组合,首先,给定训练集中的一组看到类别的多标签组合,我们随机将看到类别更改为它们对应的最近看不到的类别(基于类别嵌入在词嵌入空间 E 中的距离)。这使我们能够获得仅涉及看不到的类别和看到-看不到类别的不同多标签组合。因此,我们的方法有助于获得更有可能在测试分布中出现的多标签组合。

实施细节:遵循现有的零样本分类工作 [14]、[16],我们使用预训练的 VGG-19 骨干网络从多标签图像中提取特征。使用 FC7 层输出的图像级特征(大小为 d = 4096)作为我们 GAN 的输入。我们使用 l2 归一化的 300 维 GloVe [38] 向量,对应于类别名称,作为嵌入 ,如 [16] 中所述。编码器 E、鉴别器 D 和生成器 和 是具有 4096 个隐藏单元和 Leaky ReLU 非线性的两层全连接(FC)网络。我们 CLF 中的头数 H 设置为 8。CLF 中的子网络 是一个具有 8192 个隐藏单元的两层 FC 网络。特征合成网络用 10^-4 的学习率训练。WGAN 用 (batch size, epoch) 为 (64,50)、(128,1) 和 (64,70) 在 NUS-WIDE、Open Images 和 MS COCO 上训练。对于 f-CLSWGAN 变体,α 设置为 0.1,而在 f-VAEGAN 变体中 λ 设置为 10。ZSL 和 GZSL 分类器: 和 分别用 (batch size, learning rate) 为 (300, 10^-3)、(100, 10^-4) 和 (100, 10^-3) 在 NUS-WIDE、Open Images 和 MS COCO 上训练 50 个周期。我们使用 ADAM 优化器,其中 (β1, β2) 为 (0.5, 0.999) 进行训练。所有参数都是通过交叉验证选择的。

A. 消融研究

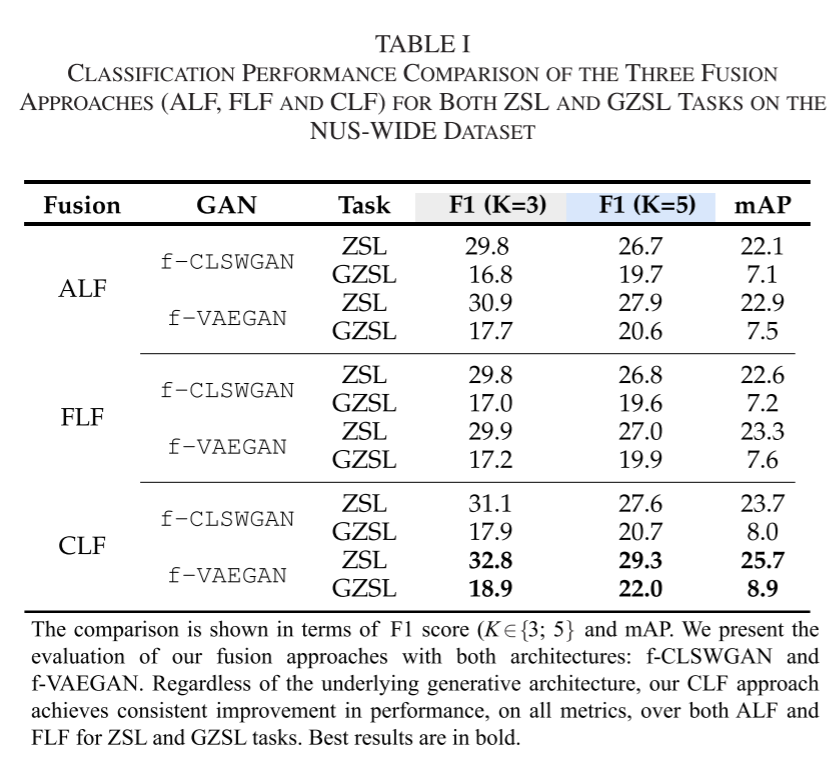

我们首先对我们的融合方法:属性级(ALF)、特征级(FLF)和跨级特征(CLF)在 NUS-WIDE 数据集上进行消融研究。我们评估了我们的融合策略与两种架构:f-CLSWGAN 和 f-VAEGAN。表 I 显示了在 ZSL 和 GZSL 任务中,F1 分数(K∈{3, 5})和 mAP 的比较。在 ZSL 的情况下,基于 ALF 的 f-CLSWGAN 达到了 22.1 的 mAP 分数。基于 FLF 的 f-CLSWGAN 获得了类似的性能,mAP 分数为 22.6。基于 CLF 的 f-CLSWGAN 达到了改进的性能,mAP 分数为 23.7。同样,基于 CLF 的 f-CLSWGAN 在 F1 分数(K∈{3, 5})方面一致优于基于 ALF 和 FLF 的 f-CLSWGAN。在 GZSL 的情况下,ALF 和 FLF 分别获得了 16.8 和 17.0 的 F1 分数(K = 3)。我们的方法以 17.9 的 F1 分数实现了改进的性能。同样,CLF 在 F1 分数(K = 5)和 mAP 指标方面也优于 ALF 和 FLF。

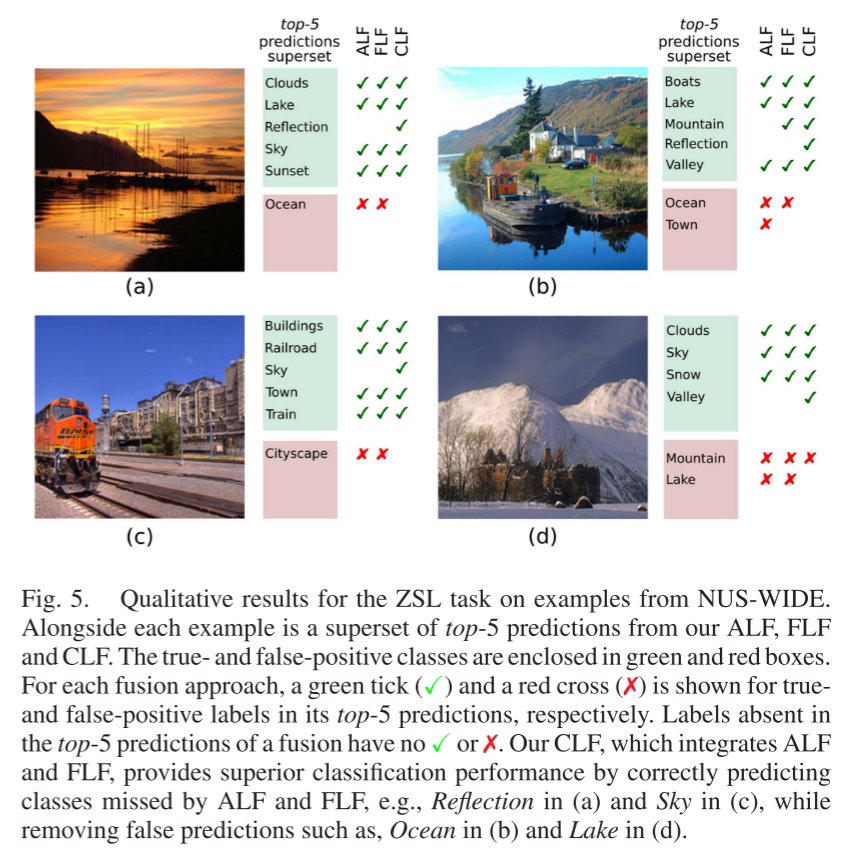

正如在 f-CLSWGAN 中一样,我们也观察到 CLF 方法在更复杂的 f-VAEGAN 中集成时,无论在 ZSL 还是 GZSL 任务中,都能一致地提高性能,优于 ALF 和 FLF。在 ZSL 的情况下,我们的 CLF 基于 f-VAEGAN 比 ALF 和 FLF 在 mAP 方面分别实现了 2.8% 和 2.4% 的绝对增益。同样,CLF 基于 f-VAEGAN 在 F1 分数方面也一致优于 ALF 和 FLF。此外,CLF 基于 f-VAEGAN 在 GZSL 的情况下也比其他两种融合方法表现更好。图 5 显示了 CLF 与 ALF 和 FLF 的定性结果比较。更多的定性结果在第 VI 节中说明。

上述结果表明,我们的 CLF 方法在 ZSL 和 GZSL 任务中,无论底层架构如何,都能一致地优于 ALF 和 FLF。此外,当在 f-VAEGAN 中集成我们的 CLF 时,获得了最佳结果。除非另有说明,否则从这里开始我们将 CLF 基于 f-VAEGAN 称为“我们的方法”。

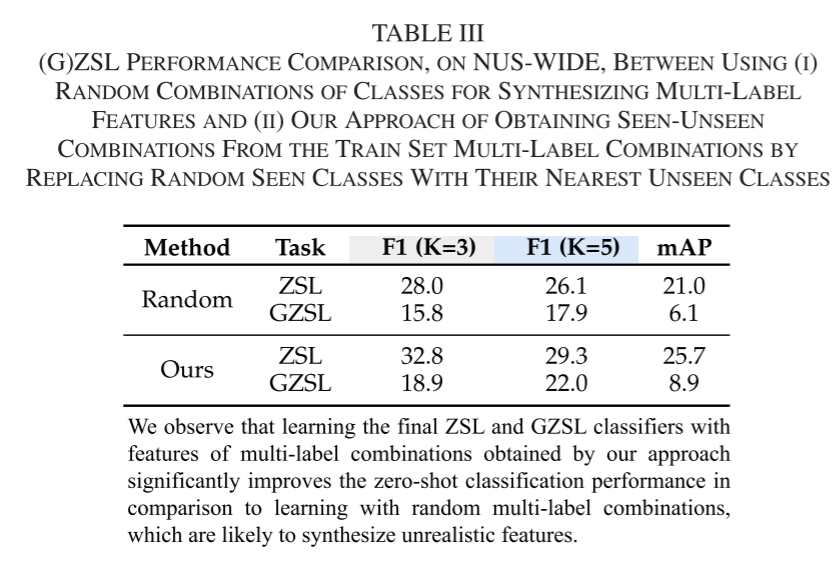

改变用于特征合成的多标签组合:在这里,我们进行了一项实验,以分析从完全随机的多标签组合生成不真实图像的效果,并在表III中报告结果。我们观察到,与我们用最近的未见过类替换可见类的方法相比,使用随机组合会降低多标签分类性能。具体来说,对于WML任务,与采用随机多标签特征相比,我们的方法在F1(K = 3),F1(K = 5)和mAP方面分别获得了4.8,3.2和4.7的增益。我们也观察到类似的趋势,在情况下的GALML任务。

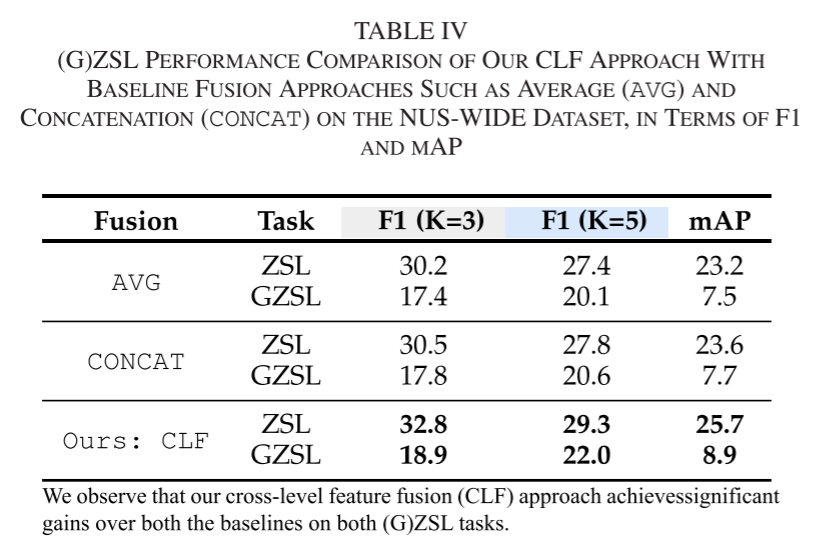

改变融合:在这里,我们将我们的跨级别特征融合(CLF)与两个融合基线进行比较:i)平均ALF和FLF的输出; ii)连接ALF和FLF的输出,然后是MLP。表IV中列出的结果表明,我们的CLF方法在AVG和CONCAT上都获得了显著的收益。

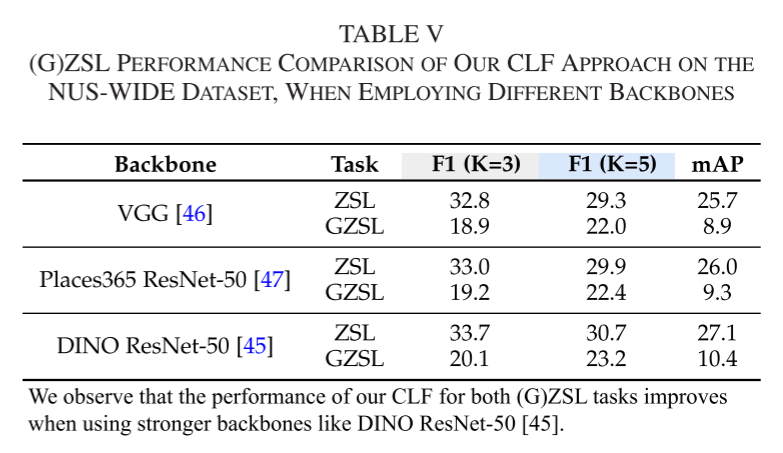

改变脊柱:在这里,我们对从不同主干提取的图像特征进行了实验,并在表V中报告了结果。我们观察到使用更强的主干可以提高ZSL和GZSL任务的分类性能。例如,在一个示例中,采用以自我监督方式预训练的ResNet-50(DINO [45])将mAP提高了1.4和1.5。此外,除非另有说明,否则我们采用VGG作为主干,以便与现有的多标签零触发方法进行公平比较[14],[16]。

B. 与最先进技术的比较

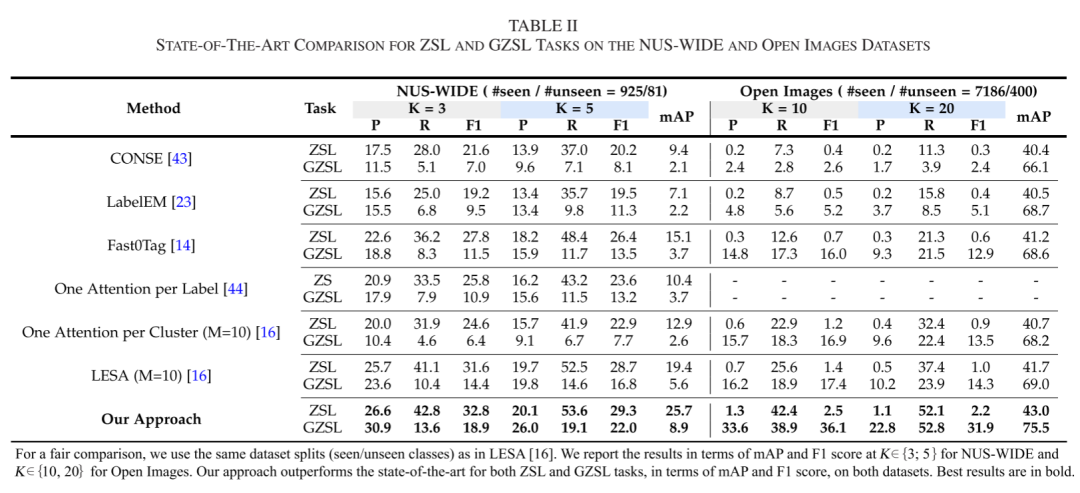

NUS-WIDE:表 II 显示了 ZSL 和 GZSL 任务的最新比较。结果以 mAP 和 F1 分数(K∈{3, 5})报告。此外,我们还为每个 F1 分数报告了精确度(P)和召回率(R)。对于 ZSL 任务,Fast0Tag [14] 通过在词向量空间中找到主方向来提前排名相关标签而不是不相关的标签,达到了 15.1 的 mAP。最近引入的 LESA [16],利用共享的多注意力来预测图像中的所有标签,在 Fast0Tag 上取得了改进的结果,mAP 为 19.4。我们的方法以 6.3% 的绝对增益在 mAP 方面超越了 LESA,成为最新技术。同样,我们的方法在 F1 分数(K∈{3, 5})方面也一致优于最新技术。对于 GZSL 任务,LESA 在现有方法中获得了改进的分类结果,mAP 为 5.6。我们的方法达到了 8.9 的 mAP 分数,比 LESA 有 3.3% 的绝对增益。同样,我们的方法在 F1 分数(K = 3 和 K = 5)方面也取得了一致的性能提升,比 LESA 分别提高了 4.5% 和 5.2%。

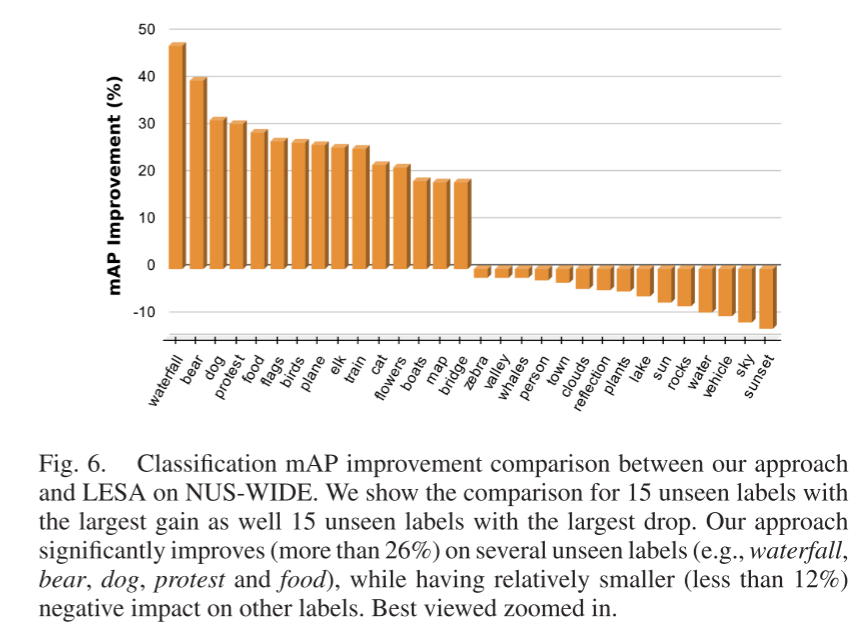

图6显示了我们的方法与LESA的分类比较,其中15个看不见的标签具有最大的性能增益,以及15个看不见的标签具有最大的下降。我们的方法在几个标签上显着改善(超过26%),如瀑布,熊,狗,抗议和食物,而对标签的负面影响相对较小(小于12%),如日落,人,天空,水和岩石。我们观察到我们的方法在动物类上特别好(13个中的11个)。总的来说,我们的方法在81个标签中的57个上优于LESA。

Open Images:表 II 显示了 ZSL 和 GZSL 任务的最新比较。由于测试集中只有 4,728 个看到类别的实例,GZSL 任务的 mAP 分数是通过平均 5,128 个(看到+看不到)类别的 AP 获得的,如 [34] 中所述。与 NUS-WIDE 相比,Open Images 有大量的标签,使得图像内的排名问题更具挑战性,这反映在表中的较低 F1 分数上。对于 ZSL 任务,LESA 获得了 1.4 和 1.0 的 F1 分数(K = 10 和 K = 20)。我们的方法对 LESA 有利,分别在 K = 10 和 K = 20 时获得了 2.5 和 2.2 的 F1 分数。对于 mAP 指标也观察到了类似的性能提升。值得注意的是,这个数据集有 400 个看不见的标签,这使得 ZSL 任务变得具有挑战性。与 ZSL 类似,我们的方法在 GZSL 上也取得了一致的性能提升,无论是在 F1 还是 mAP 方面都超过了现有技术。

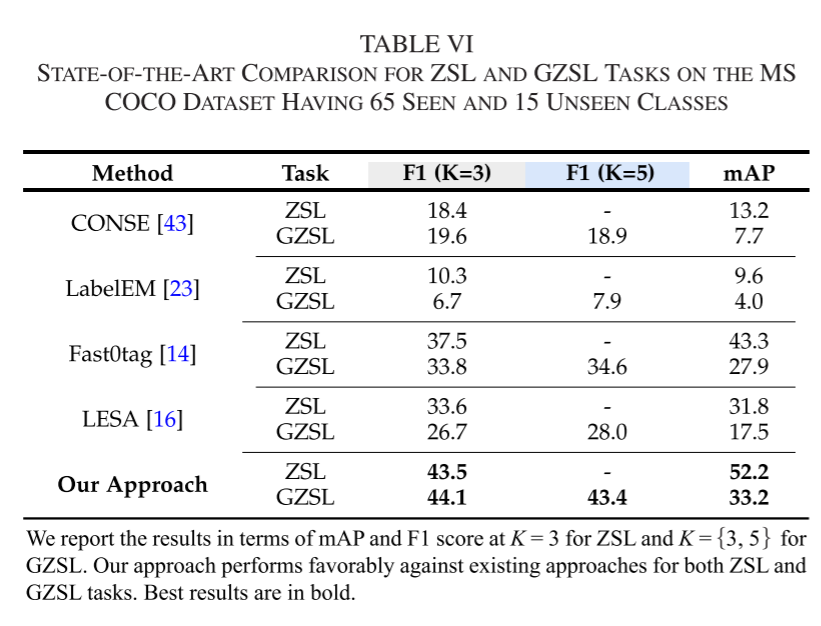

MS COCO:我们是第一个在这个数据集上评估零样本分类的。表 VI 显示了 ZSL 和 GZSL 任务的最新比较。由于验证集中每个图像中看不见的类别的最大数量是 3,我们只为 ZSL 任务的 K=3 报告了 F1。我们重新实现了 LabelEM、CONSE 和 Fast0tag,因为它们的源代码没有公开可用。对于 LESA,我们使用了作者提供的代码库获得结果。我们的方法在 ZSL 和 GZSL 任务的 mAP 和 F1 分数方面都优于现有方法。特别是,我们的方法在 ZSL 任务的 mAP 方面比 Fast0Tag [14] 高出 8.9%,在 GZSL 任务上高出 5.3%。对于两项任务的 F1 分数,我们的方法也取得了超过现有方法的显著增益。

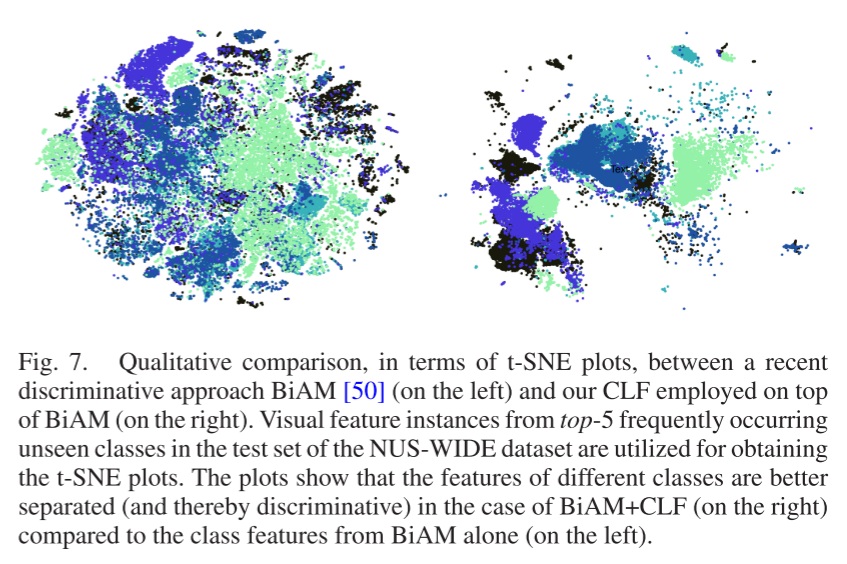

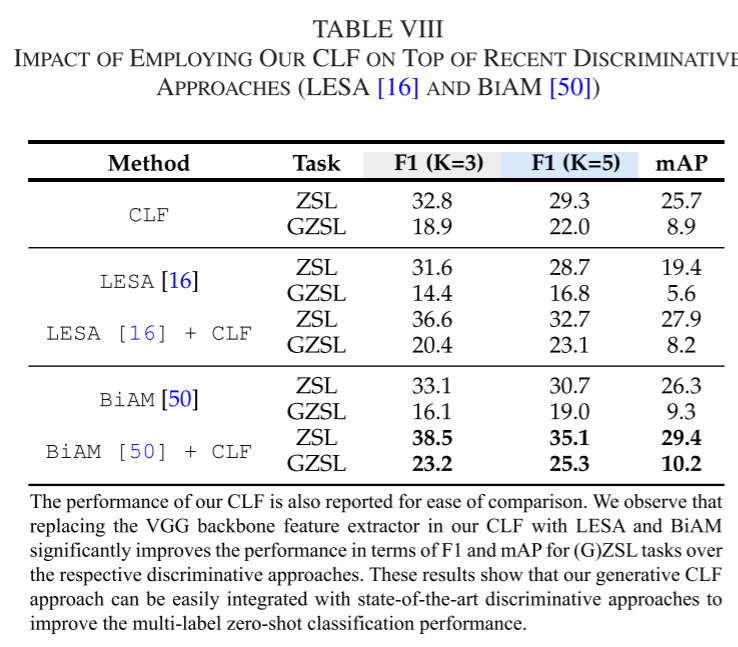

采用CLF与判别方法的影响:在这里,我们进行了一个实验,用于分析合成的多标签不可见类特征的改进可分辨性的效果。为此,我们采用最近的判别式多标签MAML方法LESA [16]和BiAM [50]作为多标签特征提取器,并在这些特征上学习我们的CLF。表VIII显示,在这些最新方法的基础上采用我们的基于融合的CLF时,GML和GML分类性能得到改善。这可能是由于单独在可见类多标签特征上训练的判别方法,从而依赖于视觉-语义联合空间中的映射来对新的不可见类进行分类。然而,在我们的CLF方法中,零镜头分类器对看不见的类有更好的了解,因为它们是使用合成的看不见的类特征来学习的。此外,在图7中,t-SNE图显示了在BiAM特征上学习CLF时看不见的类别特征可辨别性的改善[50]。

C. 在提出的分割上的最先进技术比较

现有方法用于评估 NUS-WIDE 和 Open Images 上的多标签 (G)ZSL 任务的看到/看不到类别分割 [14]、[16] 并不严格符合零样本范式。这是因为用于特征提取的背景数据集 ImageNet [51] 的类别与 NUS-WIDE 和 Open Images 的一些看不到类别重叠。注意,这个问题不会出现在 MS COCO 实验中,因为背景是在移除重叠的 ImageNet 类别后重新训练的,如 [41] 中所述。因此,为了符合 ZSL 范式,我们为 NUS-WIDE 和 Open Images 提出了新的看到/看不到类别分割,确保预训练的 ImageNet 类别与各自数据集中新的看不到类别之间没有重叠。

NUS-WIDE:我们首先预处理数据以消除任何标签不一致。在原始的 925/81 分割中,有多对具有相同类别但拼写略有变化的类别,例如 harbor-harbour、window-windows、animal-animals。每对中的这些类别被合并,并在提出的分割中被视为一个单一类别。此外,原本在看不到集合中的类别,如果与 ImageNet 类别重叠,则移至看到类别集合。同样,一些没有与 ImageNet 类别重叠的看到类别被移至看不到集合,以平衡分割。因此,NUS-WIDE 的提出的 (G)ZSL 分割包含 837 个看到类别和 84 个看不到类别。

Open Images:原始的 400 个看不到类别只出现在测试集中,并且在 5.5 百万训练图像中没有相应的注释。因此,只有与 ImageNet 类别重叠的看不到类别被移除并不再考虑。这导致提出的分割中保留了 367 个看不到类别。此外,按照 [16] 的方法,测试实例在评估 ZSL 任务时如果没有这些 367 个看不到类别的注释,则不考虑。此外,由于测试图像中不到 3 和 5 个看不到类别的百分比分别接近 95% 和 99%,我们在 ZSL 任务中计算 K∈{3, 5} 的 F1 分数。然而,我们保留了 GZSL 的 K∈{10, 20},如 [16] 中所述。有关这两个数据集提出的分割中类别的更多详细信息在附录中提供,可在线获取。

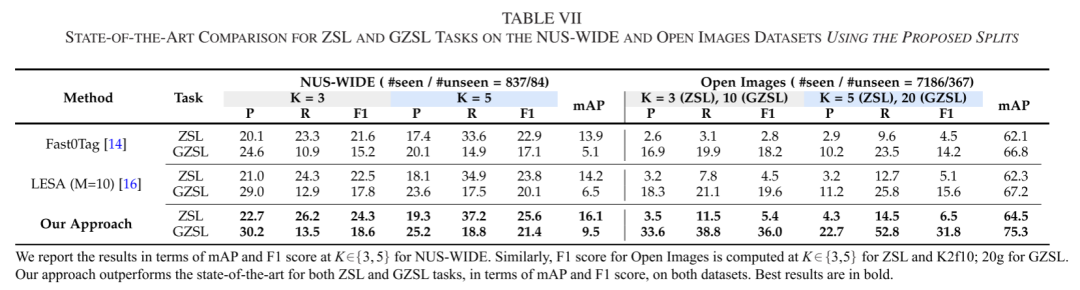

表 VII 显示了我们的方法与现有方法(Fast0Tag [14] 和 LESA [16])在 NUS-WIDE 和 Open Images 提出的分割上的性能比较。我们的方法与现有方法相比表现良好,在 GZSL 任务的 mAP 上比 LESA 高出高达 3% 和 8.1%。同样,我们的方法在 ZSL 和 GZSL 的 F1 分数方面也取得了一致的性能提升。这些结果强化了无论看到/看不到类别分割如何,我们的方法在多标签 ZSL 和 GZSL 任务中都优于现有方法。

D. 标准多标签分类

除了零样本分类,我们还评估了我们的方法在标准多标签分类上的性能,其中训练和测试期间的所有类别标签都是相同的。表 IX 显示了在 NUS-WIDE 上与现有技术的比较,使用了 81 个人工注释的标签。与 [16] 一样,我们去除了测试实例中没有任何 81 个标签集合对应类别的实例。在现有方法中,CNN-RNN 和 LESA 分别达到了 28.3 和 31.5 的 mAP 分数。我们的方法通过实现 46.7 的 mAP 分数超越了现有方法。我们的方法在 F1 分数方面也优于这些方法。

同样,我们还在大规模的 Open Images 数据集上评估 [34]。表 X 显示了 Open Images 上标准多标签分类的最新比较,使用了 7,186 个类别进行训练和评估方法。与 [16] 一样,测试样本在评估期间如果缺少这 7,186 个类别的标签,则在测试期间被移除。此外,由于测试集中只有 4,728 个真实类别,因此按照 [34] 的方法,mAP 分数是这些类别的 AP 的平均值。在现有方法中,Fast0Tag [14] 和 LESA [16] 分别在 K = 20 时达到了 13.1 和 14.5 的 F1 分数。我们的方法通过实现 32.7 的 F1 分数超越了现有方法。我们的方法在 mAP 分数方面也优于现有方法。因此,这些性能提升表明,无论在哪个数据集上,我们的方法在标准多标签分类任务上都是有效的。

V. 扩展到零样本目标检测

最后,我们还评估了我们的多标签特征生成方法(CLF)在零样本目标检测(ZSD)上的性能。ZSD 旨在同时对以前看不见的对象进行分类和定位。在泛化设置中,测试集包含看到和看不到的对象类别(GZSD)。最近,[41] 中的工作介绍了一种零样本检测方法(SUZOD),其中特征是有条件合成的,并且与流行的 Faster R-CNN 框架 [54] 集成。特征生成阶段由语义嵌入空间中看到和看不到类别的分类损失共同驱动。他们的方法通过为每个感兴趣区域(RoI)构建单标签特征来解决多标签零样本检测问题。与 SUZOD [41] 不同,我们首先通过整合随机集合的个别单标签 RoI 特征来生成多标签特征。

为了生成训练我们多标签特征生成(CLF)方法的多标签特征,我们首先从训练图像中获得前景和背景区域的单标签特征,如 SUZOD [41] 中所述。这些单标签特征来自 Faster R-CNN 框架 [54] 中的 ROI Align 层的输出,并对应于区域提议网络(RPN)获得的单个提议。然后,将图像的前景 RoI 对齐的看到类别特征随机组合以生成多个多标签特征。然后,将得到的看到类别 RoI 特征通过 Faster R-CNN 中的 ROI Align 层之后的两层全连接网络传递,以获得 1024 维的多标签特征。然后,使用得到的看到类别 RoI 特征作为训练我们多标签特征生成(CLF)方法的真实特征。在训练 CLF 之后,合成单标签看不到类别特征,并用于训练看不到类别的分类器。然后,将学习到的分类器与 Faster R-CNN 的分类器头部结合,如 SUZOD [41] 中所述。然后,将查询图像输入修改后的 Faster R-CNN 框架以获得看不见类别的检测。

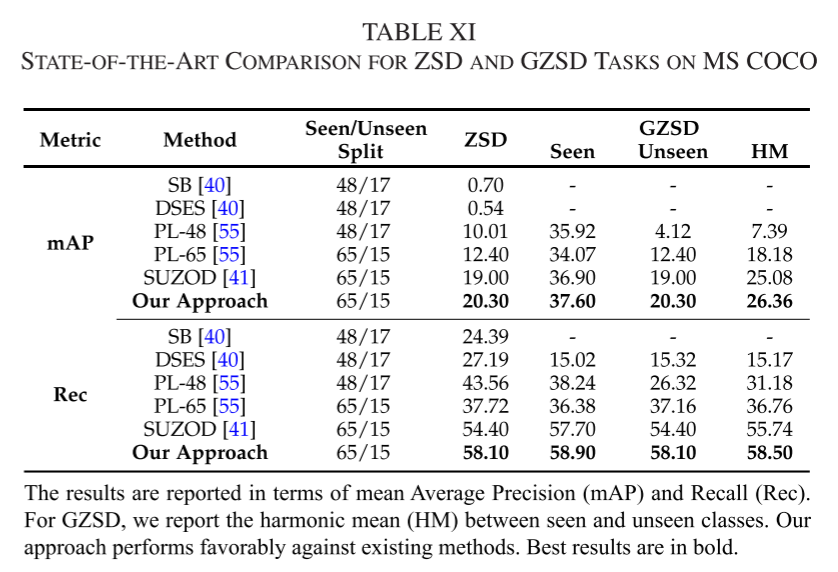

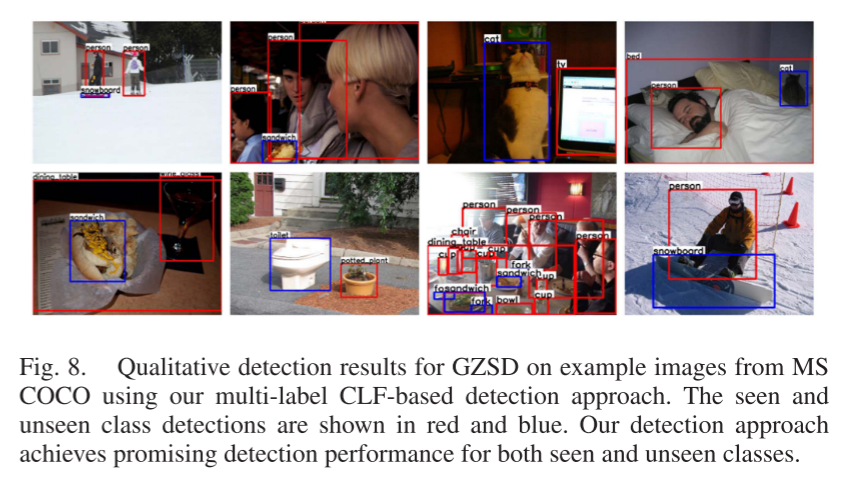

表 XI 显示了在 MS COCO 上 ZSD 和 GZSD 检测任务的最新比较,以 mAP 和召回率衡量。对于 GZSD,报告了看到和看不到类别性能的调和平均值(HM)。与 SUZOD [41] 类似,我们还报告了使用 f-CLSWGAN 作为底层生成架构的结果。极性损失方法(PL-65)[55] 在 ZSD 任务上达到了 12.4 的 mAP,而单标签特征生成方法的 SUZOD [41] 达到了改进的性能,即 19.0 mAP。我们的方法以 1.3% 的显著增益在 mAP 方面对 SUZOD 表现有利。此外,当 PL-65 [55] 在 ZSD 上达到 37.72 的召回率时,SUZOD 方法 [41] 达到了 54.4 的召回率。我们的 CLF 基于多标签特征生成方法在与现有方法比较时表现良好,ZSD 的召回率为 58.1。同样,我们的方法在 GZSD 的 mAP 和召回率方面也取得了一致的改进。图 8 显示了使用我们 CLF 方法的 GZSD 的定性检测结果。看不见类别的检测用蓝色边框表示,而看到类别的预测用红色表示。

VI. 额外的定性结果

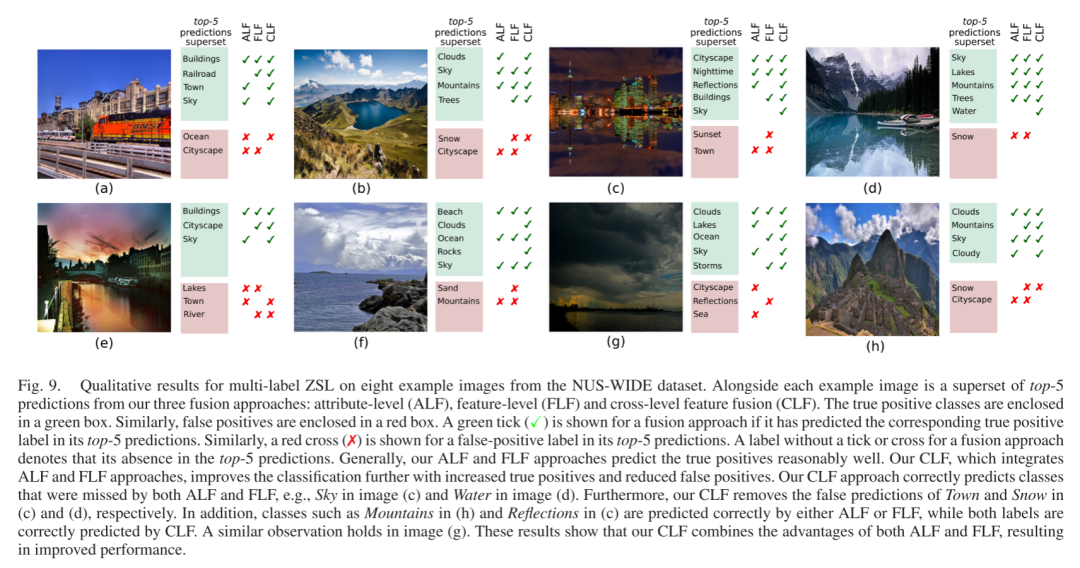

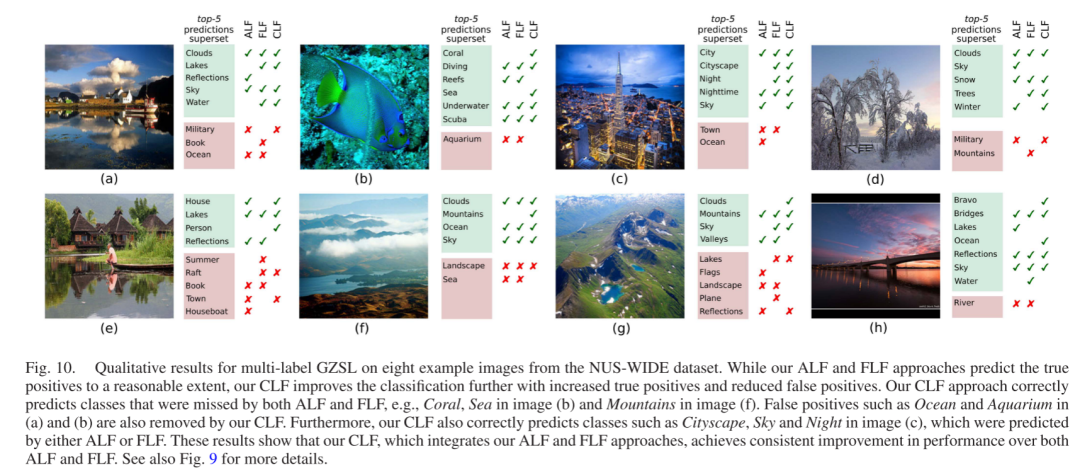

多标签零样本分类:图 9 和图 10 显示了来自 NUS-WIDE 数据集测试集的多标签零样本学习(ZSL)和泛化零样本学习(GZSL)的额外定性结果。每个图包括九个示例图像。每个示例图像旁边都有一个列表,列出了我们三种融合方法:属性级(ALF)、特征级(FLF)和跨级特征融合(CLF)的 top-5 预测的超集。与图像中真实类别相匹配的预测标签用绿色框包围。同样,与真实类别不匹配的预测标签用红色框包围。如果一种融合方法在其 top-5 预测中预测了相应的真正例标签,则会显示一个绿色勾选(✓)。类似地,如果一种融合方法在其 top-5 预测中预测了相应的假正例标签,则会显示一个红色交叉(✗)。如果融合方法没有在 top-5 预测中包含某个标签,则没有勾选或交叉。

一般来说,我们观察到我们的 ALF 和 FLF 方法在它们的 top-5 预测中相当合理地预测了真正例。此外,我们结合了 ALF 和 FLF 优势的 CLF 方法,通过增加真正例和减少假正例,进一步提高了分类性能。我们的 CLF 方法正确预测了 ALF 和 FLF 都错过的类别,例如图 9(c) 中的 Sky 和图 9(f) 中的 Clouds。此外,我们的 CLF 还去除了图 9(d) 中的 Snow 和图 10(c) 中的 Town 等假正例。我们的方法还正确预测了 Mountain(图 9(h))、Railroad(图 9(a))、Lakes(图 9(g))和 Cityscape、Sky 和 Night(图 10(c))等类别,这些类别要么被 ALF 预测,要么被 FLF 预测。这些结果表明,我们的 CLF 方法结合了 ALF 和 FLF 的优势,从而提高了性能。

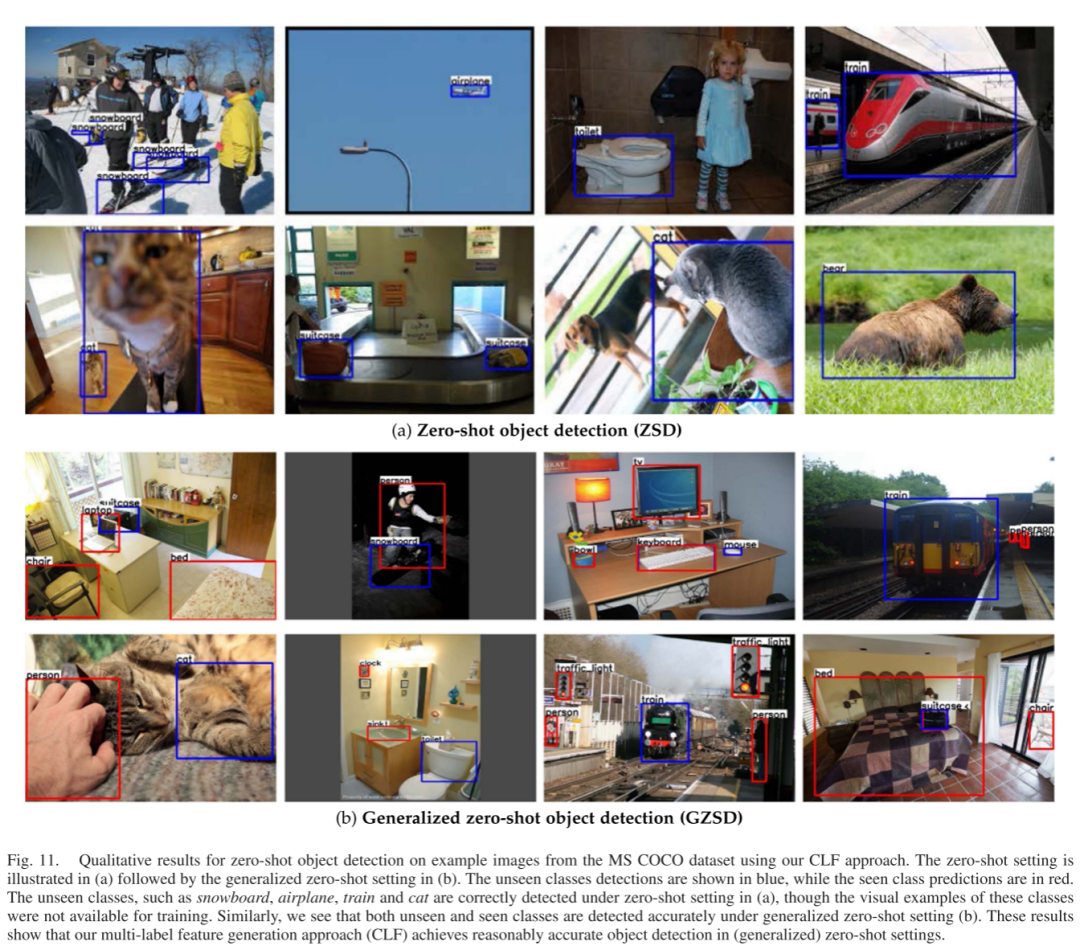

零样本目标检测:图 11 显示了使用我们的 CLF 方法在 MS COCO 数据集的示例图像上进行零样本目标检测的额外定性结果。图 11(a) 展示了只有看不见类别被检测到的零样本设置,随后是图 11(b) 中的泛化零样本设置,其中检测到既看到又看不到的类别。在零样本设置中被检测到的看不见类别用蓝色边框表示,而在泛化零样本设置中,看到类别的预测用红色表示。我们观察到,尽管在训练期间没有这些类别的视觉示例可用,如图 11(a) 所示,像 snowboard、airplane、train 和 cat 这样的看不见类别被正确检测出来。此外,在图 11(b) 所示的泛化零样本设置中,我们可以看到,无论是看到还是看不到的类别,都被准确检测出来。这些结果表明,我们的多标签特征生成方法(CLF)在(泛化)零样本设置中实现了合理的目标检测准确性。

总之,我们的多标签特征生成(CLF)方法在各种任务上,包括(泛化)零样本多标签分类、标准多标签分类和(泛化)零样本检测,与现有方法相比,都表现出色。我们希望我们简单而有效的方法能够作为一个坚实的基线,并有助于促进未来在生成式多标签零样本学习领域的研究。

VII. 结论

我们研究了零样本设置中的多标签特征合成问题。为此,我们引入了三种融合方法:ALF、FLF 和 CLF。我们的 ALF 通过在生成器输入处整合类特定属性嵌入来合成特征。FLF 单独从类特定嵌入中合成特征,并在特征空间中进行整合。我们的 CLF 结合了 ALF 和 FLF 的优势,利用每个个体级别特征并关注双级别上下文。因此,个体级别特征自我调整,产生丰富的合成特征,然后汇聚以获得最终输出。我们将融合方法集成到两个生成架构中。我们的方法在三个基准测试上超越了现有的零样本方法。此外,我们的方法在两个大规模基准测试上对标准多标签分类任务也表现良好。最后,我们还展示了我们的方法在(泛化)零样本检测中的有效性。我们希望我们简单而有效的方法能够作为一个坚实的基线,并有助于促进未来在生成式多标签零样本学习领域的研究。

声明

本文内容为论文学习收获分享,受限于知识能力,本文对原文的理解可能存在偏差,最终内容以原论文为准。本文信息旨在传播和学术交流,其内容由作者负责,不代表本号观点。文中作品文字、图片等如涉及内容、版权和其他问题,请及时与我们联系,我们将在第一时间回复并处理。

下载1:OpenCV-Contrib扩展模块中文版教程

在「小白学视觉」公众号后台回复:扩展模块中文教程,即可下载全网第一份OpenCV扩展模块教程中文版,涵盖扩展模块安装、SFM算法、立体视觉、目标跟踪、生物视觉、超分辨率处理等二十多章内容。

下载2:Python视觉实战项目52讲

在「小白学视觉」公众号后台回复:Python视觉实战项目,即可下载包括图像分割、口罩检测、车道线检测、车辆计数、添加眼线、车牌识别、字符识别、情绪检测、文本内容提取、面部识别等31个视觉实战项目,助力快速学校计算机视觉。

下载3:OpenCV实战项目20讲

在「小白学视觉」公众号后台回复:OpenCV实战项目20讲,即可下载含有20个基于OpenCV实现20个实战项目,实现OpenCV学习进阶。

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~

115

115

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?