白板推导系列三——线性回归

文章目录

前言

Part 1 最小二乘法

线性回归——最简单的模型

——矩阵形式表达和几何意义

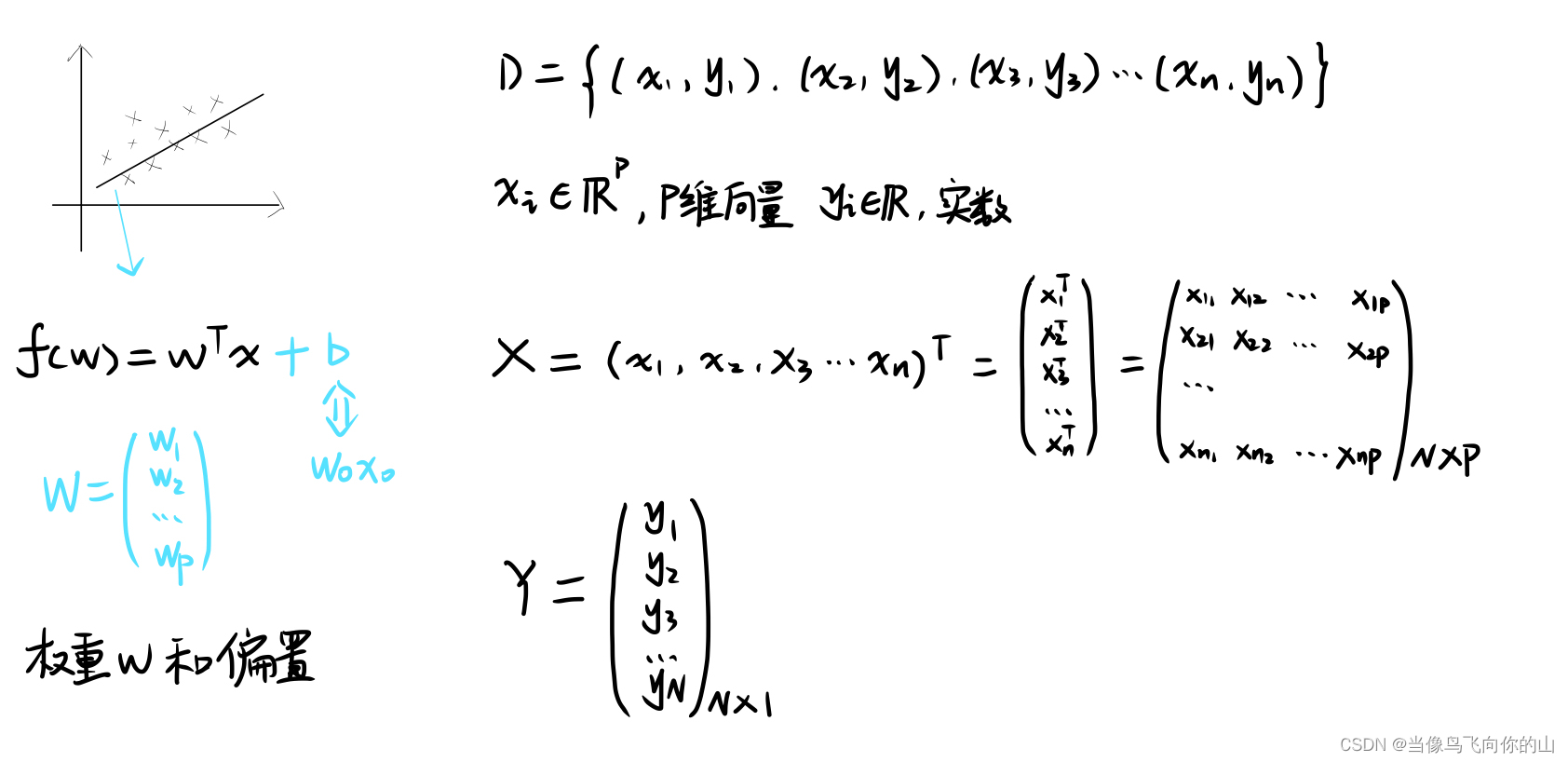

问题描述

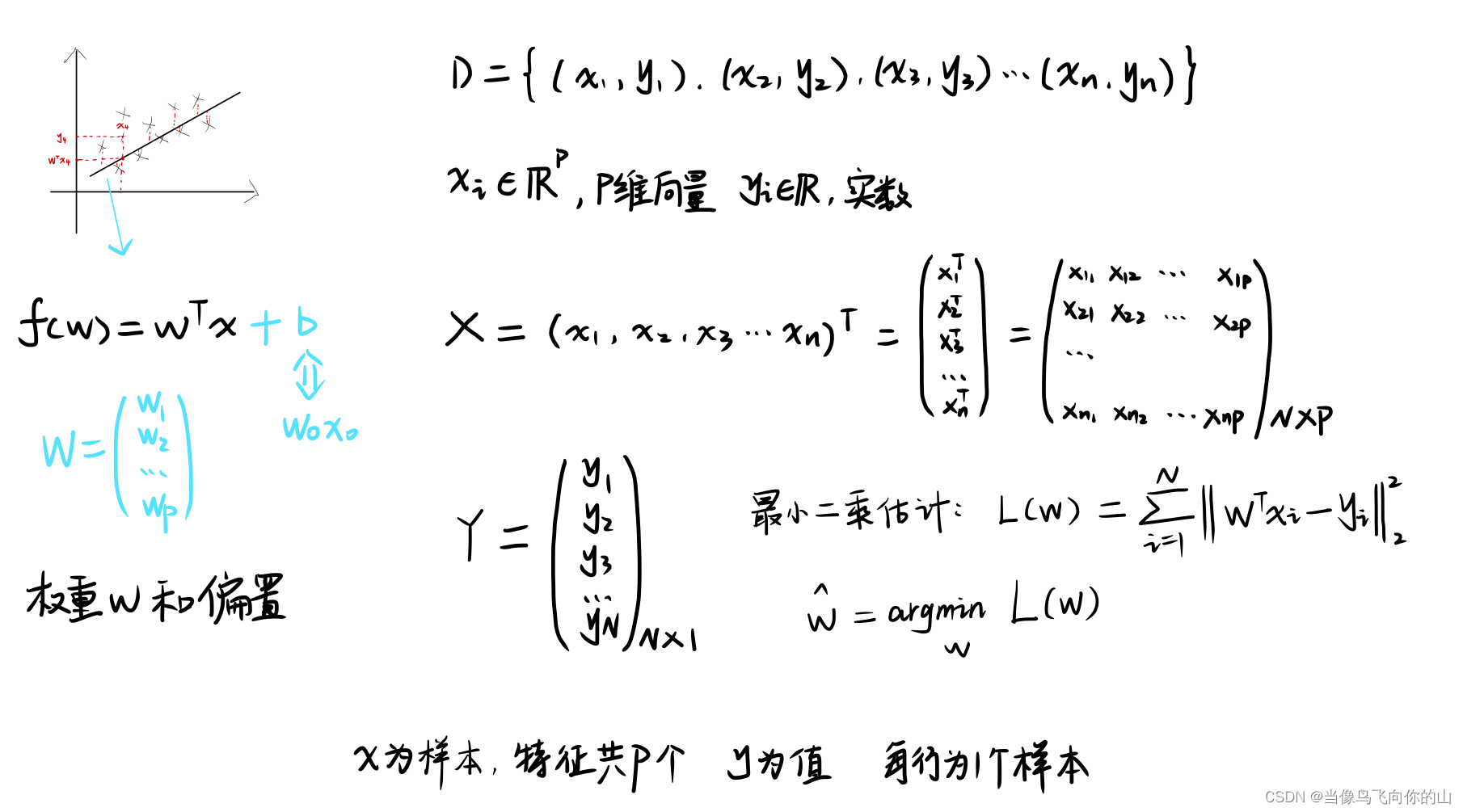

最小二乘参数估计

预测值和真实值差值的平方(L2范数的几何意义是绝对值)

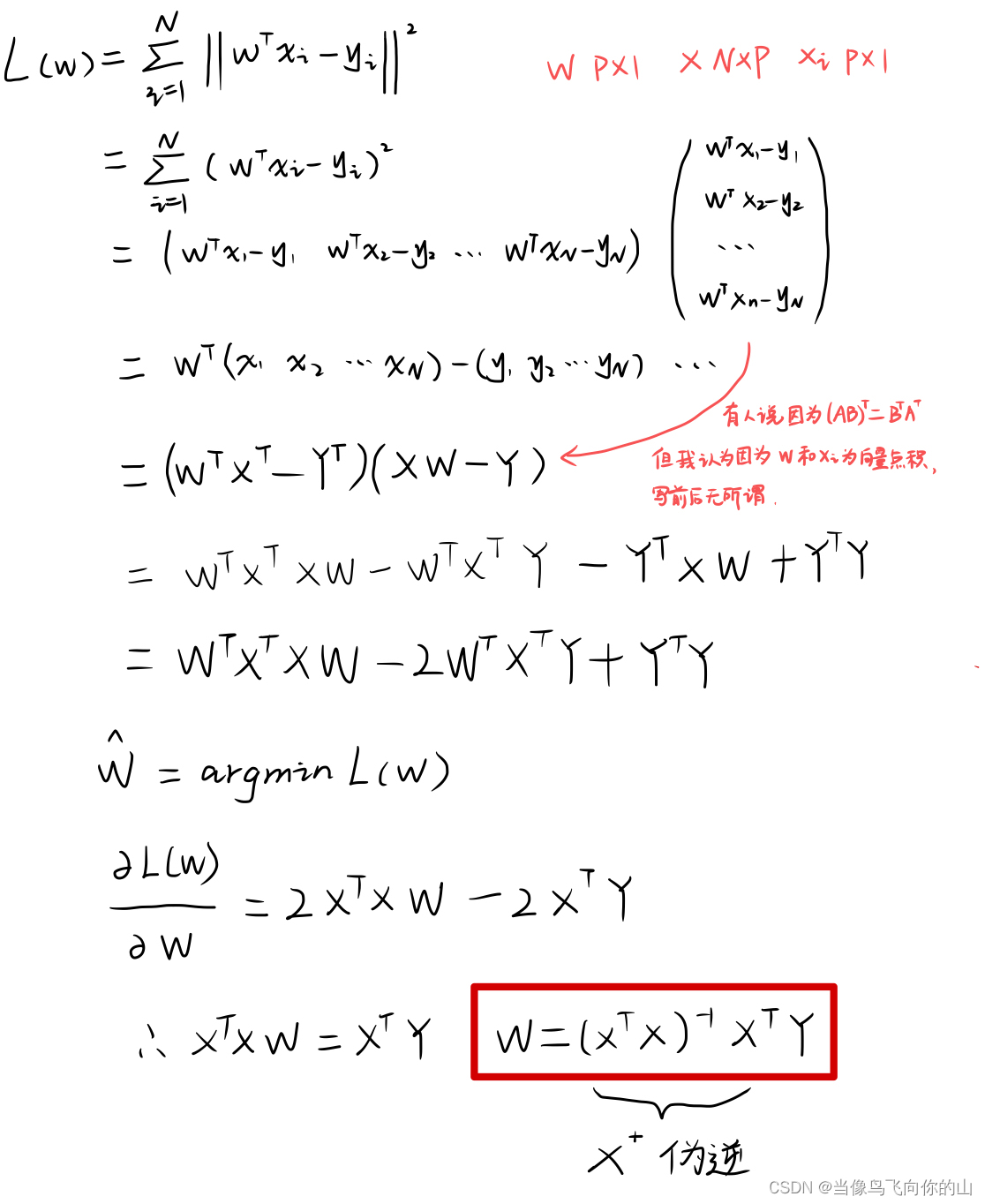

最小二乘法直接求解

——得到最小二乘估计的公式后,可以直接进行矩阵运算得到w的解。

——L(w) 为总的误差,由累加公式,可以看作误差分散在N个样本点上。

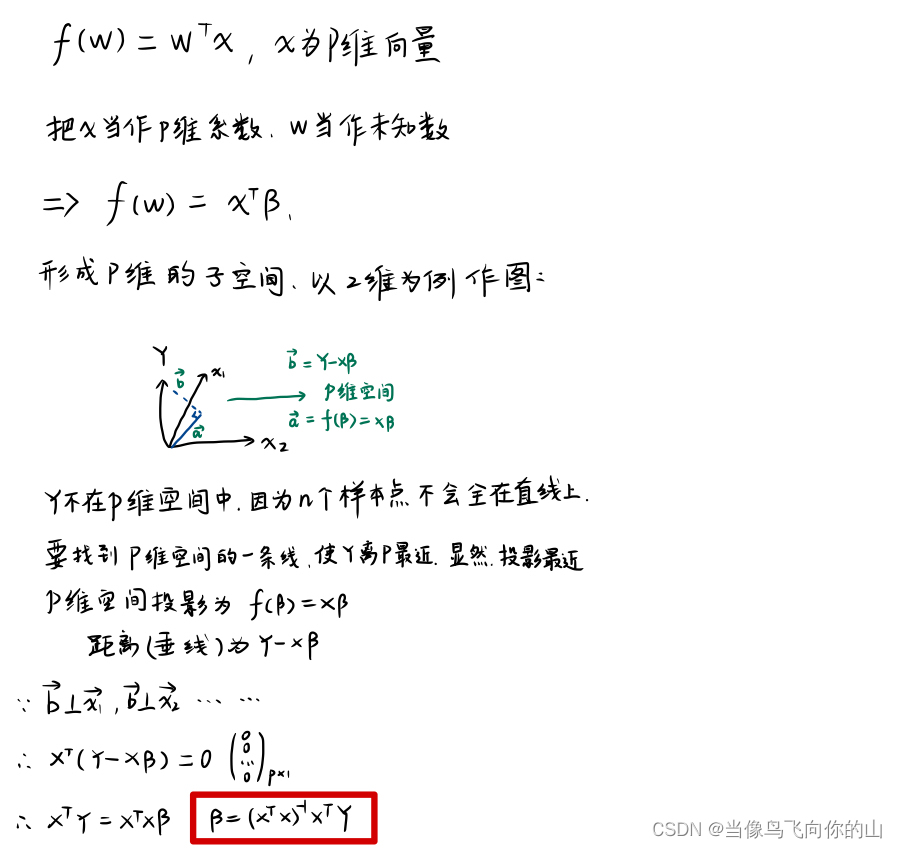

从几何意义求解最小二乘估计

——L(w) 为总的误差,可以看作是分散在p维特征上 。

——注意:W是一维向量,X是矩阵,f(w) 是标量,它的转置是自己,所以下图第三行可以理解为将 WTX 进行转置得到 WTTXT ,即WXT,即XTβ。

两种不同的思路的算法结果一致。

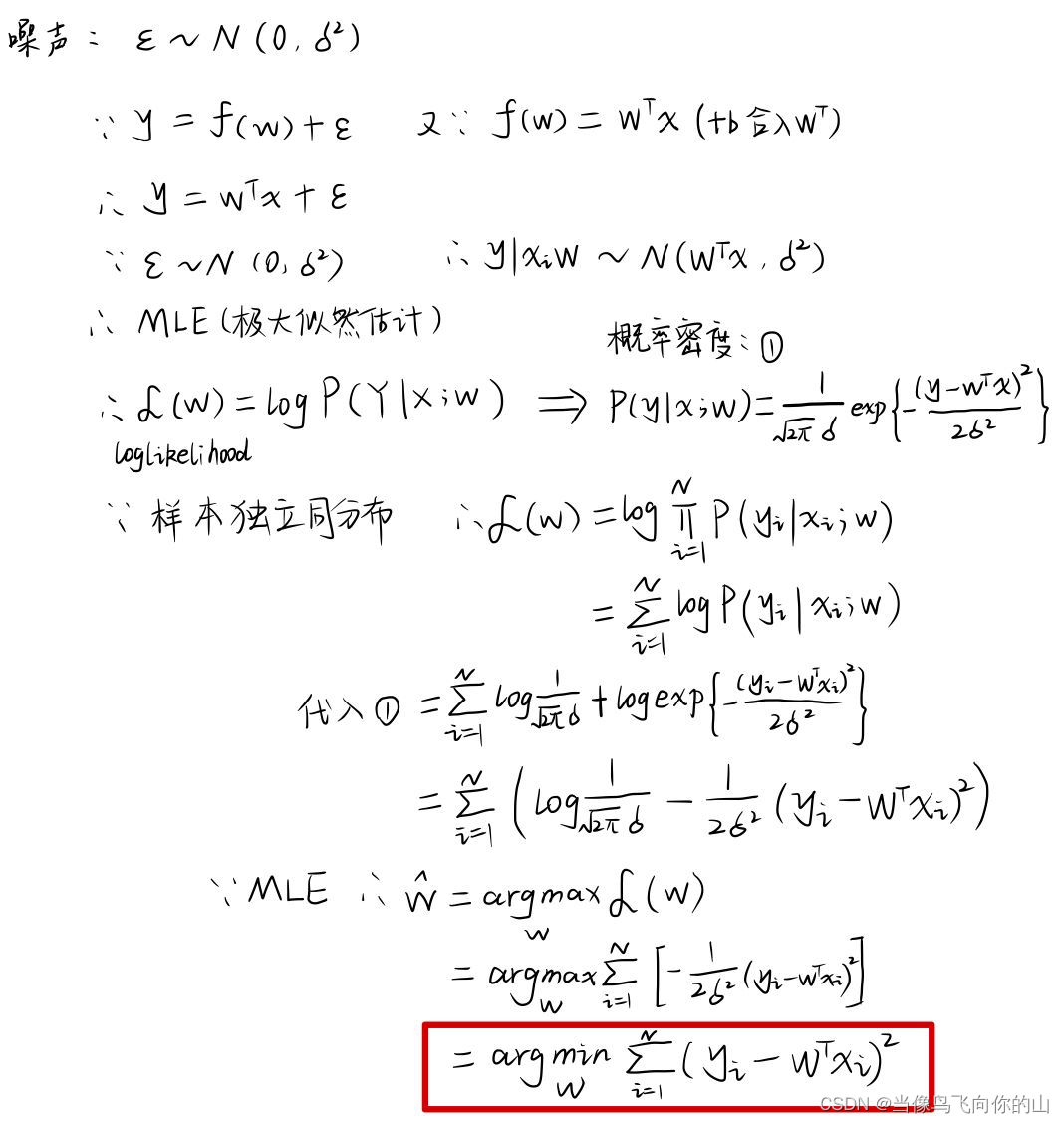

Part 2 概率视角

——结论:最小二乘法等价于噪声为高斯分布的极大似然估计(MLE)。

首先,数据具有随机性,包含一定的噪声,假设噪声服从高斯分布,则 y 也服从高斯分布,虽然两者均值不同。后面通过计算log似然函数来计算极大似然估计的解。

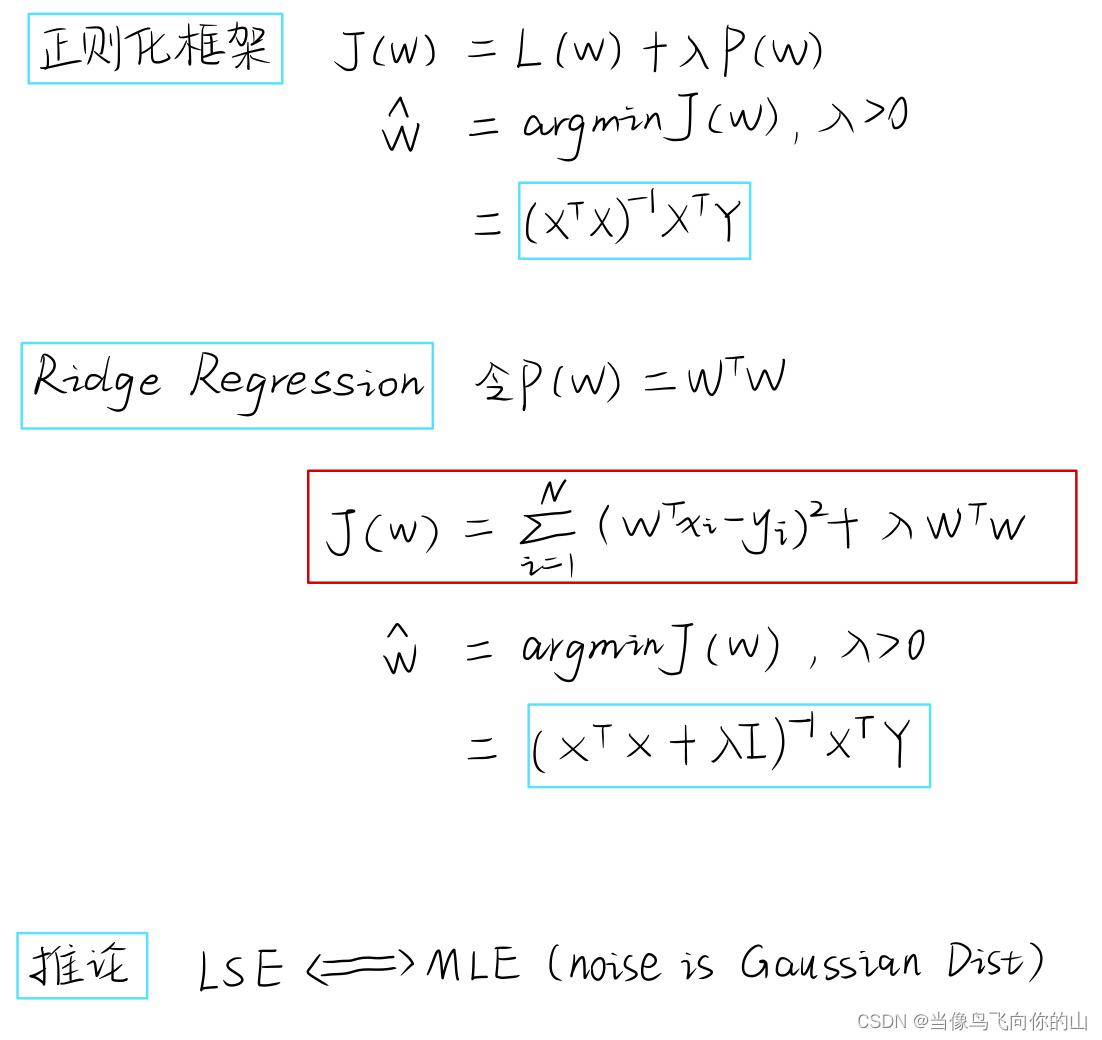

Part 3 正则化 岭回归 频率角度

——引入原因:观察线性回归的损失函数 L(w) 与 W 的解,很有可能 XTX 矩阵不可逆导致无法求解。

——问题背景:N个样本,P个特征,较好的情况是N>>P,但在样本数量不够或者特征数目非常多的时候,从数学方面矩阵不可逆,从拟合直线方面容易造成过拟合,从没有办法根据公式求解。

——过拟合解决方案:

- 增加数据

- 特征选择/特征提取 (降维 PCA)

- 正则化 (对参数空间W的一种约束)

正则化框架

——argmin(损失函数+惩罚项)

—— L1正则化项(Lasso) 和 L2 正则化项(Ridage 岭回归)

第二种L2范数的正则化项较为常用。

频率角度解释岭回归

——对目标函数进行求导可得岭回归的解,相比线性回归多了正则化项。

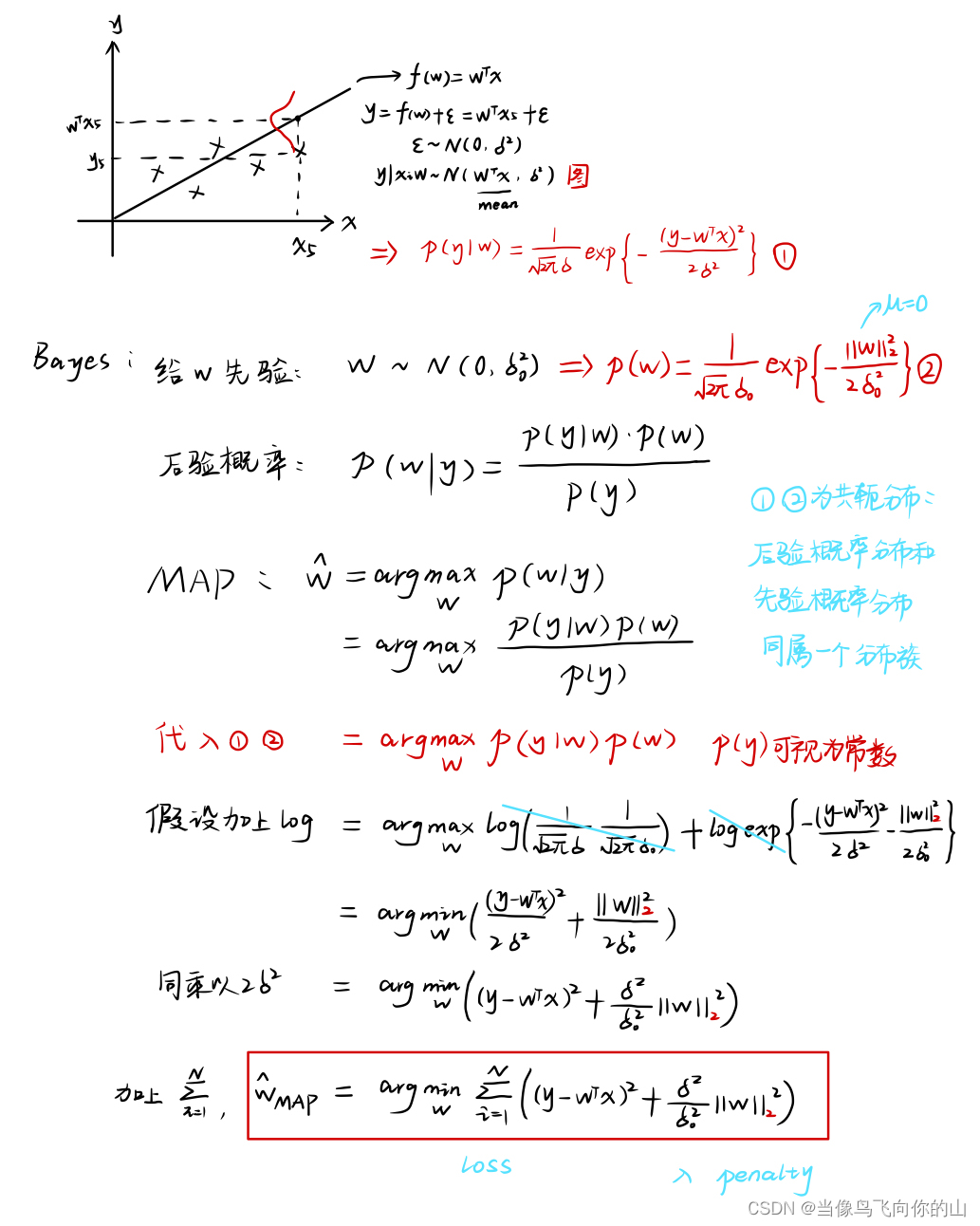

Part 4 正则化 岭回归 概率角度

——概率角度解释正则化框架(岭回归)

前置知识

已经证明,当噪声服从高斯分布时,最小二乘估计等价于极大似然估计,由于噪声服从正态分布,真实函数值也服从正态分布,如图。

贝叶斯角度

y 服从正态分布,具体的概念如图上画的,以预测值为均值的正态分布。

通过计算后验概率,进行最大后验估计,计算出岭回归的解。

课堂小结

机器学习的课程涉及到理论知识,但听老师读ppt又觉得很乏味,所以又继续了本科的找网课路线。这位清华博士大佬讲的很耐心,深入浅出。前面的数学知识我可能不补笔记了,后面的算法要坚持写!!

内心os:字体丑不要介意,主要是觉得敲公式太浪费时间 QAQ 涉及到的代码可以参考 吴恩达老师等老师网课对应的代码 或者网上有很多代码,我自己的时间也不多所以就不敲这些代码了,还有很多琐碎的工作要做 QUQ ~

388

388

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?