背景

五一期间,参加了机智流和浦语发起的LLAMA3超级课堂。

环境配置

conda create -n llama3 python=3.10

conda activate llama3

conda install pytorch==2.1.2 torchvision==0.16.2 torchaudio==2.1.2 pytorch-cuda=12.1 -c pytorch -c nvidia

下载模型

新建文件夹

mkdir -p ~/model

cd ~/model

因为使用的开发机,可以使用软连接,否则需要自己从git上拉取

ln -s /root/share/new_models/meta-llama/Meta-Llama-3-8B-Instruct ~/model/Meta-Llama-3-8B-Instruct

自行拉取

# 如果下面命令报错则使用 apt install git git-lfs -y

conda install git-lfs

git-lfs install

git clone https://code.openxlab.org.cn/MrCat/Llama-3-8B-Instruct.git Meta-Llama-3-8B-Instruct

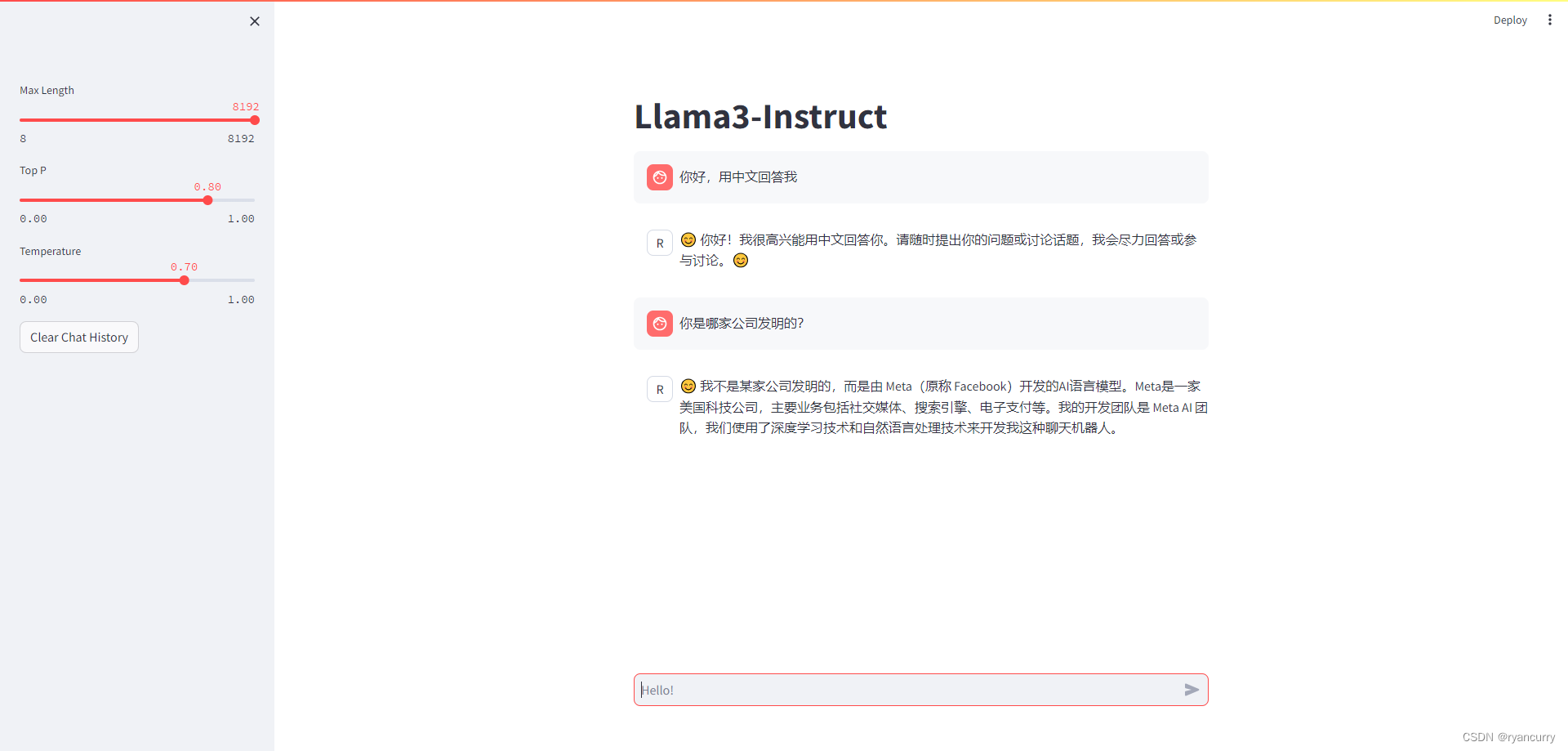

Web Demo 部署

cd ~

git clone https://github.com/SmartFlowAI/Llama3-Tutorial

安装 XTuner 时会自动安装其他依赖

cd ~

git clone -b v0.1.18 https://github.com/InternLM/XTuner

cd XTuner

pip install -e .

运行 web_demo.py

streamlit run ~/Llama3-Tutorial/tools/internstudio_web_demo.py \

~/model/Meta-Llama-3-8B-Instruct

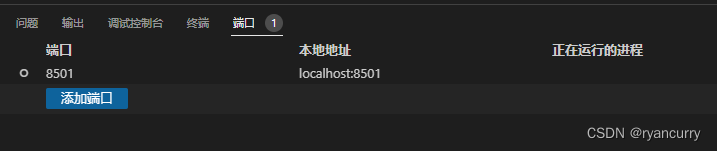

注意

提前添加好主机与开发机的端口映射

结果

访问:http://localhost:8501/

总结

因为有参考资料,demo的部署还是比较顺利的。

参考资料

https://github.com/SmartFlowAI/Llama3-Tutorial?tab=readme-ov-file

Tips

---------------------------------- 欢迎使用 InternStudio 开发机 ------------------------------

+--------+------------+----------------------------------------------------------------------+

| 目录 | 名称 | 简介 |

+--------+------------+----------------------------------------------------------------------+

| / | 系统目录 | 每次停止开发机会将其恢复至系统(镜像)初始状态。不建议存储数据。 |

+--------+------------+----------------------------------------------------------------------+

| /root | 用户家目录 | 您的所有开发机共享此目录,不受开发机的启停影响。强烈建议将 conda |

| | | 环境、代码仓库等所有数据存储在此目录下。 |

| | | 【注意】该目录有存储限额,超过限额后新写入的数据会被静默删除! |

+--------+------------+----------------------------------------------------------------------+

| /share | 共享目录 | 常用微调数据集、模型仓库、教程、xtuner 配置文件都存放在此。 |

+--------+------------+----------------------------------------------------------------------+

Tips:

1. 快速从本地上传文件:

scp -o StrictHostKeyChecking=no -r -P {端口} {本地目录} root@ssh.intern-ai.org.cn:{开发机目录}

*注:在开发机 SSH 连接功能查看端口号

2. 避免因终端关闭或 SSH 连接断开导致任务终止, 强烈建议使用 tmux 将实验进程与终端窗口分离:

https://www.ruanyifeng.com/blog/2019/10/tmux.html

3. 查看 GPU 显存和算力使用率: studio-smi

4. 使用InternStudio开箱即用的conda环境:

studio-conda -h

5. 将conda环境一键添加到jupyterlab:

lab add {YOUR_CONDA_ENV_NAME}

504

504

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?