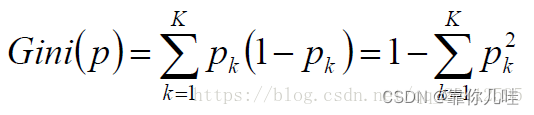

基尼指数和信息熵都是用来描述系统混乱度的量 数学形式不一样,干的事是一样的

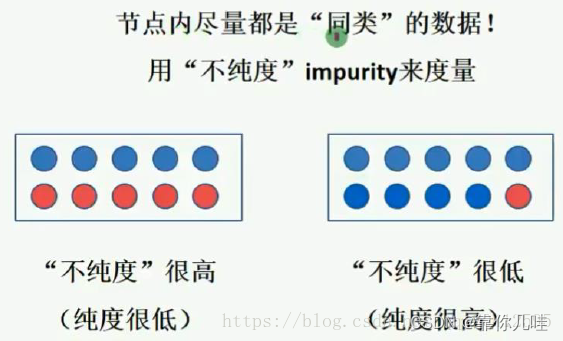

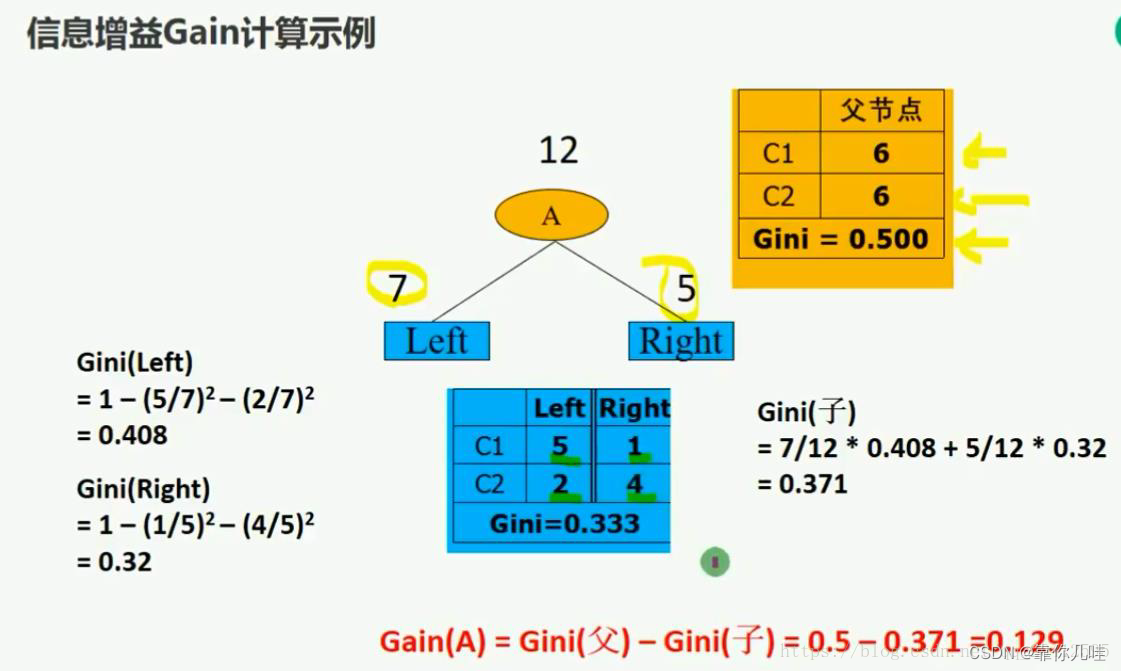

不纯度(impurity)--GINI系数:(不纯度就是混乱度)

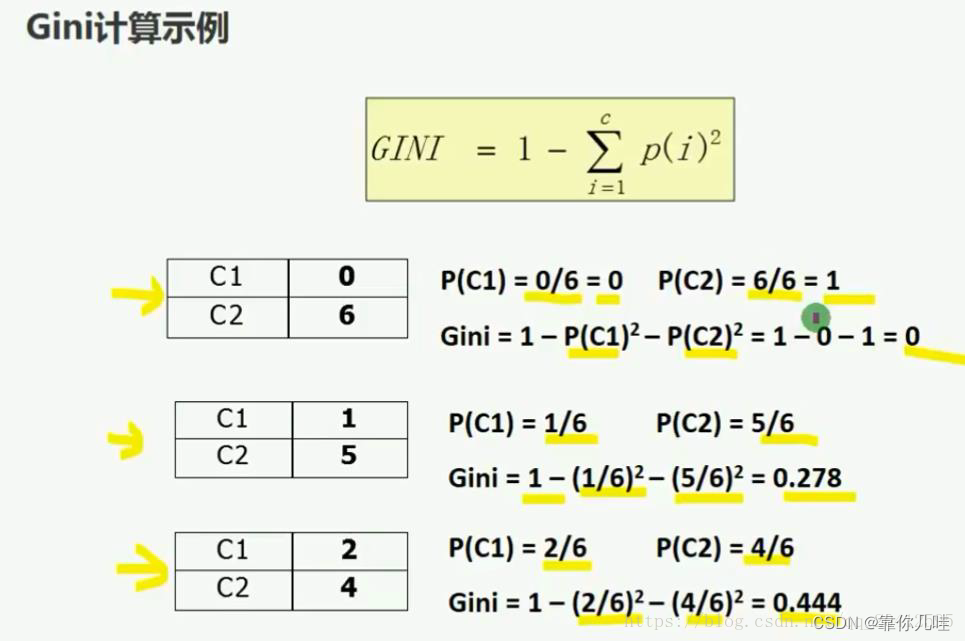

公式

例子(与信息熵干的是一件事)

决策树模型理解

二、决策树的学习(训练)过程

一棵决策树的生成过程主要分为以下3个部分:

特征选择:特征选择是指从训练数据中众多的特征中选择一个特征作为当前节点的分裂标准,如何选择特征有着很多不同量化评估标准标准,从而衍生出不同的决策树算法。

决策树生成: 根据选择的特征评估标准,从上至下递归地生成子节点,直到数据集不可分则停止决策树停止生长。 树结构来说,递归结构是最容易理解的方式。

剪枝:决策树容易过拟合,一般来需要剪枝,缩小树结构规模、缓解过拟合。剪枝技术有预剪枝和后剪枝两种。

第一步:如何切分特征(选择节点)--特征选择

问题:根节点的选择该用哪个特征呢?接下来呢?如何切分呢?

目标:通过一种衡量标准,来计算通过不同特征进行分支选择后的分类情况,找出来最好的那个当成根节点,以此类推。

衡量标准-熵、GINI系数(不纯度)

熵:熵是表示随机变量不确定性的度量

解释:说白了就是事物内部的混乱程度。

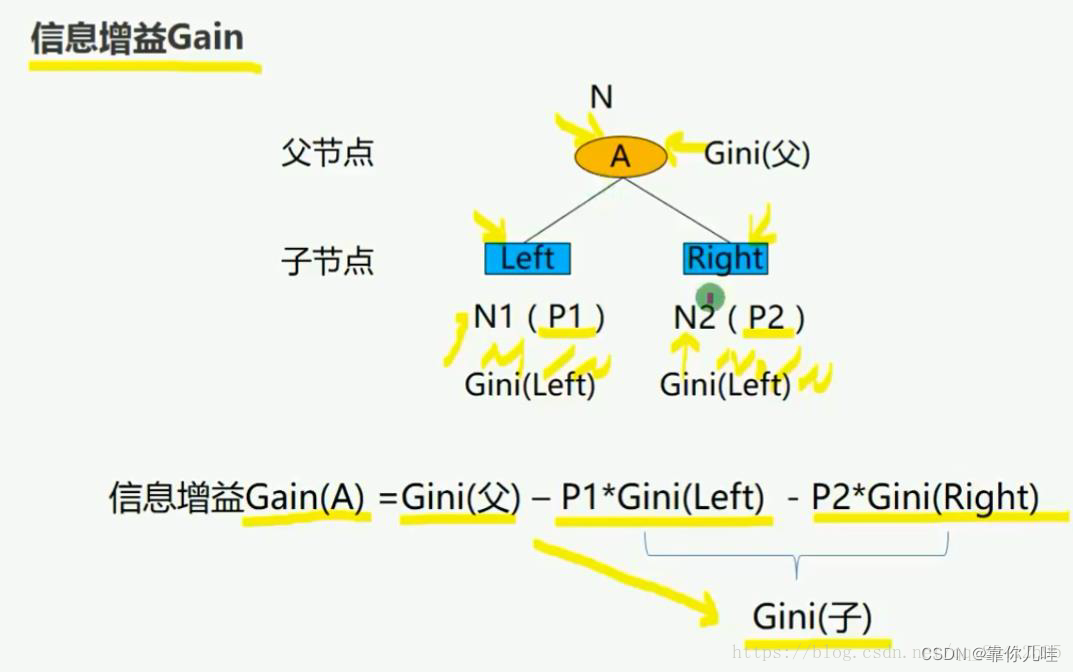

如何决策一个节点的选择呢?(如何确定一个分裂是最好的)

所以需要通过 特征挑选方法(信息增益法+增益率)

选择具有最高信息增益的特征作为测试特征,利用该特征对节点样本进行划分子集,会使得各子集中不同类别样本的混合程度最低,在各子集中对样本划分所需的信息(熵)最少(通过这样生成最优决策树)

(注意,信息增益既可以用熵也可以用GINI系数来计算)

9万+

9万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?