学习目标:

- 上周的实验跑的进度

- 上周精度论文的结果

学习内容:

- 上周的实验代码运行进展

PointCT这篇论文的0.01%进度代码还在调试,之前由于服务器出现点问题,所以就暂时停了一段时间,由于这个数据量比较大,计划是在最新的服务器上部署和运行,现在还在进程中。

SQN这篇论文代码是放在学院服务器上跑的,之前由于tensorflow版本搞错了,浪费一段时间,现在重新建了一个新的虚拟环境,重新安装tensorflow-1.11版本。现在搞好环境,在跑sh compile_op.sh这个指令的时候出了点问题,现在还在debug,可能后面需要请教下其他同学。

- 上周精读论文汇报

为了显著提高点云语义分割的性能,本文提出了一种构建大规模网络的新方法,并提供了一种有效的轻量化技术。

为了显著提高点云语义分割的性能,本文提出了一种构建大规模网络的新方法,并提供了一种有效的轻量化技术。

注:本文图片均来自原论文。

①引言

点云语义分割是环境感知的关键步骤,高性能分割算法有助于增强机器对3D世界的理解。与现有的点云数据转换方法进行了比较,如三维体素网格或二维点投影,直接处理原始点云可以避免在渲染过程中产生大量的中间数据和量化伪影。PointNet[1]和PointNet++[2]是使用神经网络直接处理非结构化点云数据的开创性尝试。为了提高分割精度,研究人员设计了许多设计复杂的神经网络结构,如SPG[3]、RandLA-Net[4]、BAAF-Net[5]、KPConv[6]和CBL[7]。

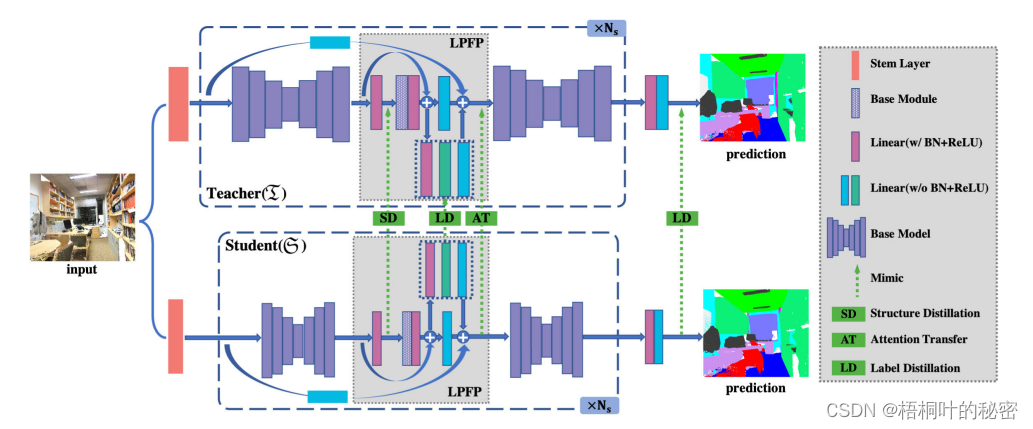

受Transformer在自然语言处理[8]、[9]和图像分析[10]、[11]中成功应用的启发,Point Transformer[12]在点云语义分割任务中引入了自关注算子。通过基网络层的迭代更新,提高了分割性能。然而,网络规模的限制可能会阻碍基础网络充分发挥其性能。构建一个高性能的大规模网络,以有限场景中的点云数据为支持,对于获得增强感知的卓越分割结果至关重要。本文设计了潜在点特征处理(latent point feature processing, LPFP)模块,为真值监督提供接口,以更好地训练浅层网络。LPFP模块仅由基网络中的特征处理模块组成,具有实用性和简便性。此外,该模块可以连接两个特征提取基础网络,深化网络,提供更高层次的点云特征,最终提升整体的大规模网络分割性能。本文的另一个核心任务是开发大规模网络的轻量级版本。

②技术贡献

为了提高基点云语义分割网络的性能和压缩网络规模,提出了一种新的大规模网络构建和轻量化方法。主要贡献总结如下:

LPFP模块用于连接基点云语义分割网络,构建可扩展的大规模网络。LPFP针对不同的基础网络由相应的特征处理模块组成,保证了大规模网络结构的一致性。

•提出新颖的点云结构和注意力蒸馏方法,将丰富的暗知识从教师网络转移到学生网络,引导压缩后的学生网络特征分布与教师网络特征分布收敛。

•提出的轻量化方法PCLN在不同阶段采用不同的蒸馏方法,可以有效地组合不同的蒸馏信息。提出的PCLN方法能够在保持与教师网络相近的分割性能的同时,对学生网络的参数进行大量压缩。

•提出的大规模网络构建和轻量化方法具有高度的泛化性,可以在保持参数数量相似的情况下显著提高基础网络的性能。在不同的基网上进行了实验,验证了该方法的性能。

③方法介绍

LPFP(Latent Point Feature Processing)模块

LPFP(Latent Point Feature Processing)模块

LPFP模块是文章中提出的一种中间模块,用于连接基础网络(如PointNet++和Point Transformer)。LPFP模块有两个主要功能:

特征信息传递:LPFP模块作为一个桥梁,将前一个网络层的特征信息传递到下一个网络层,从而实现深层次的特征提取。

真实监督信号接口:LPFP模块还提供了一个真实监督信号的接口,用于避免浅层网络的过拟合问题。

LPFP模块的设计包括以下几个关键点:

基础网络处理单元:LPFP模块中的每个单元都包含一个基础网络的编码器特征提取模块,用于处理潜在特征。

多层感知机(MLP):在LPFP模块中,MLP用于输出中间阶段的预测概率,并将这些概率映射回主分支的特征维度。

结构一致性:LPFP模块在大规模网络中保持结构一致性,以确保不同基础网络之间的兼容性。

PCLN方法是文章中提出的用于压缩点云语义分割网络的轻量化技术。

PCLN方法包括三种关键的点云蒸馏技术:

点云结构蒸馏:通过计算点云中的点对相似性,构建一个亲和矩阵,然后将这个结构知识从教师网络转移到学生网络。

注意力转移:利用激活值的均值函数将输入点特征映射到注意力图中,然后将教师网络的注意力信息转移到学生网络。

标签蒸馏:使用教师网络的预测标签作为软目标,通过KL散度损失来训练学生网络,使其预测方向与教师网络一致。

PCLN方法的设计考虑了以下几个方面:

不同蒸馏方法的组合:PCLN方法结合了结构蒸馏、注意力转移和标签蒸馏,以实现从教师网络到学生网络的丰富知识转移。

参数和计算量的减少:通过减少特征通道的数量,PCLN方法在保持性能的同时显著减少了学生网络的参数和计算量。

性能优化:通过调整不同蒸馏损失的权重,PCLN方法能够优化学生网络的性能。

④部分结果展示

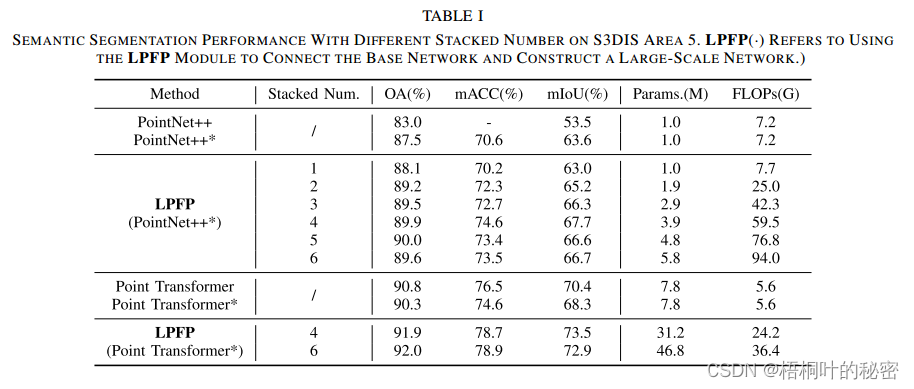

在表1中,PointNet++和Point Transformer表示根据PointNeXt的训练策略再现的结果,并作为基线。PointNet++和Point Transformer是原论文的成果。在对S3DIS数据集进行训练期间,PointNeXt将每个场景的最大点数设置为24,000,这大大低于Point Transformer中使用的80,000个点。点变压器*的训练速度大大提高,其性能可能会略有下降,与原来的设置相比。表1表明,通过LPFP构建大规模网络可以显著提高分割性能。

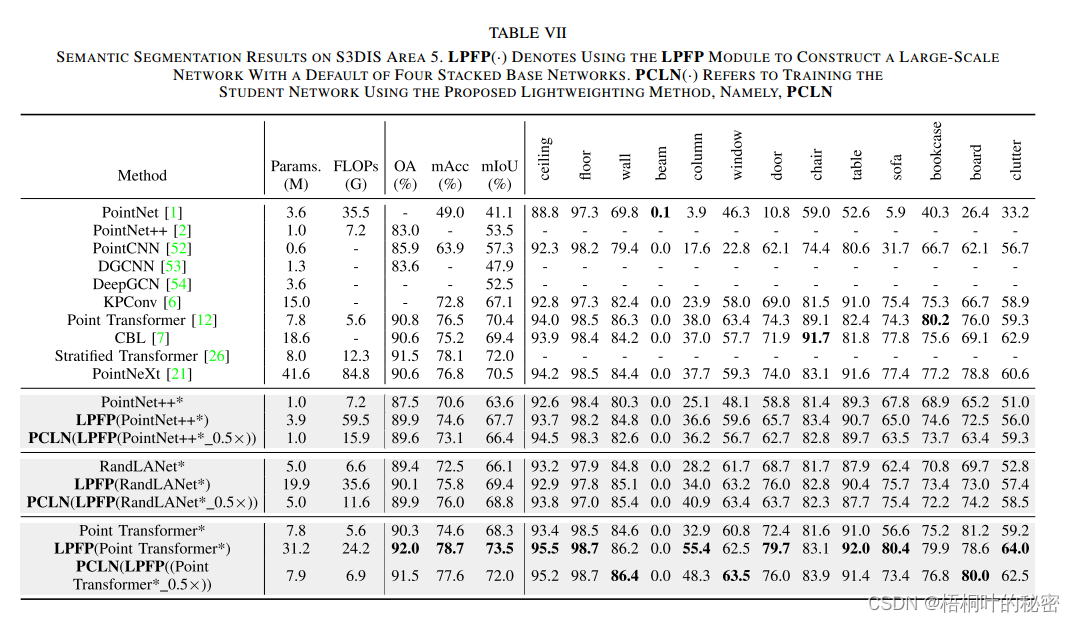

语义分割结果在s3dis区域5。Lpfp(·)表示使用Lpfp模块构建一个大规模网络,默认为四个堆叠的基础网络。Pcln(·)表示使用提出的轻量化方法训练学生网络,即Pcln。

语义分割结果在s3dis区域5。Lpfp(·)表示使用Lpfp模块构建一个大规模网络,默认为四个堆叠的基础网络。Pcln(·)表示使用提出的轻量化方法训练学生网络,即Pcln。

⑤总结与展望

本文提出了一种新的大规模网络构建和轻量化方法,以显著提高基础网络的点云语义分割性能。在构建大型网络时,该方法充分探索了如何设计以基网特征提取与聚合模块为核心,连接多个基网的LPFP。在轻量化过程中,压缩学生网络的训练由从教师网络中转移过来的三种暗知识指导,即点云结构信息、点云注意力和点云预测标签。本文提出的方法的鲁棒性已经通过几个基本网络和不同类型的数据集进行了验证。

⑥思考与讨论

Q : 如何确保LPFP模块在不同基础网络之间传递特征时保持特征的一致性和有效性?

A: LPFP模块通过使用与基础网络编码器相对应的特征处理模块来保持特征的一致性。此外,LPFP模块利用多层感知机(MLP)作为预测分支,输出中间阶段的预测概率,并将这些概率映射回主分支的特征维度,以此来监督和调整特征传递过程。

Q:文中提到的点云结构蒸馏在处理大规模点云数据时,如何有效减少内存消耗?

A: 点云结构蒸馏通过使用采样和聚合过程来减少内存消耗。具体来说,首先将LPFP模块的输出特征通过最远点采样(Farthest Point Sampling, FPS)进行下采样,然后以下采样点集中的每个点作为局部中心点,聚合邻近点的特征。这样可以在不牺牲太多信息的前提下,显著减少亲和矩阵的计算和存储需求。

Q:LPFP模块和PCLN方法在处理更大规模的数据集(例如,超出当前研究中使用的数据集规模)时,性能和效率如何?

学习时间:

- 2024年4月18日——2024年4月25日

638

638

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?