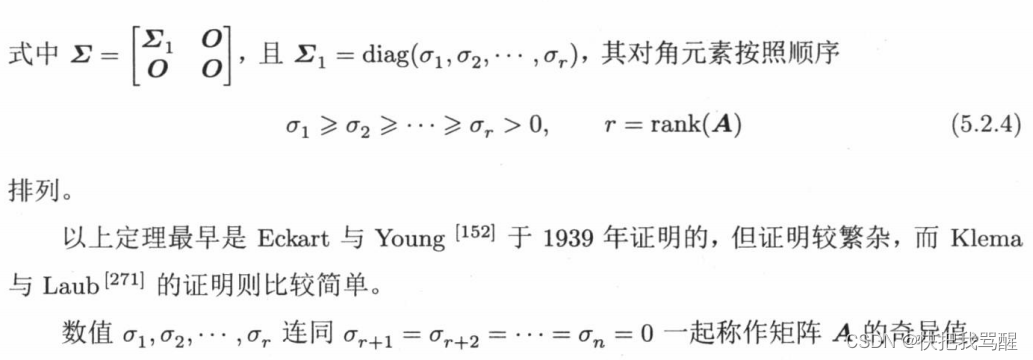

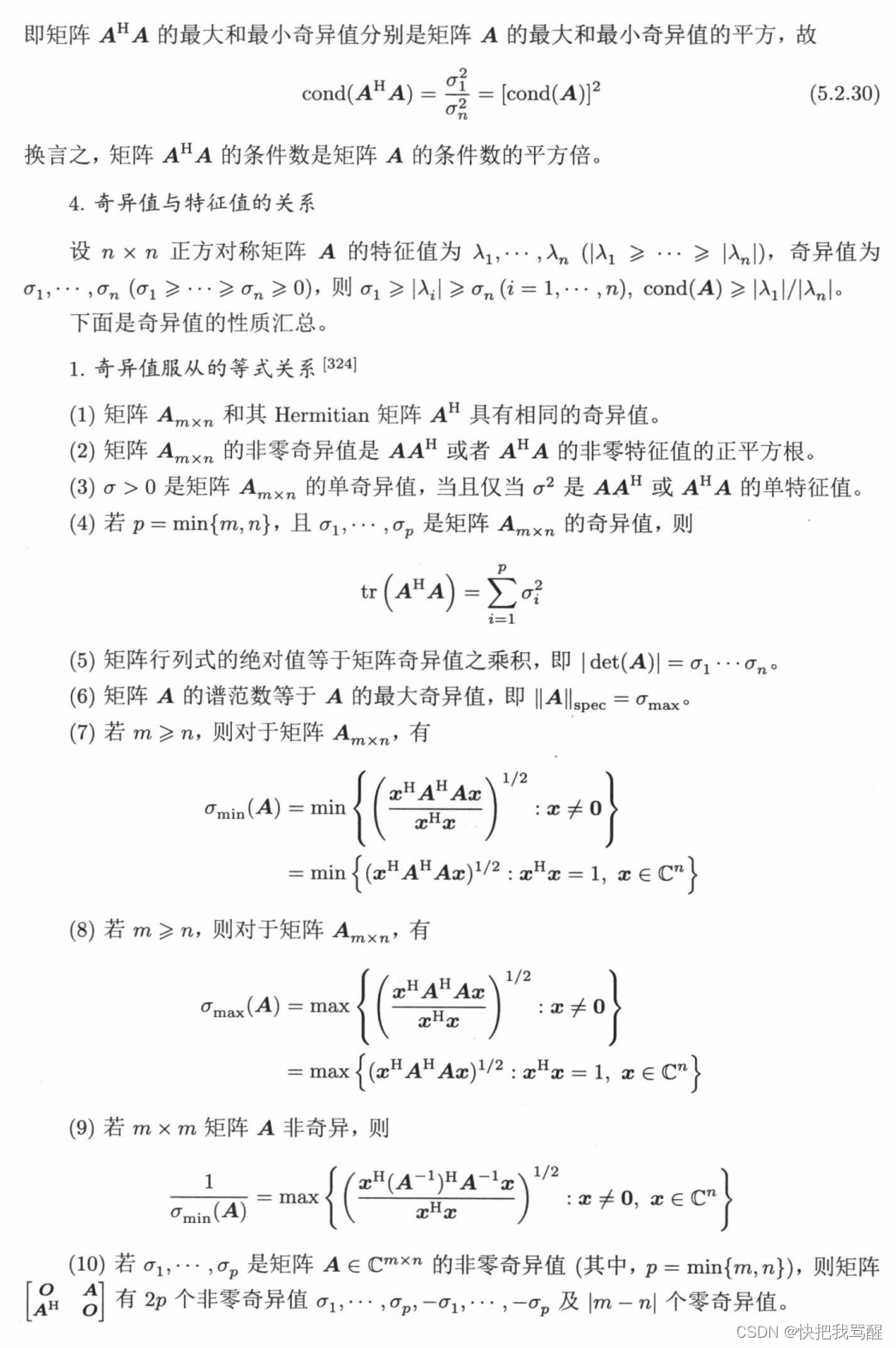

奇异值分解(Singular Value Decomposition,SVD)

具体见张贤达矩阵分析与应用P28

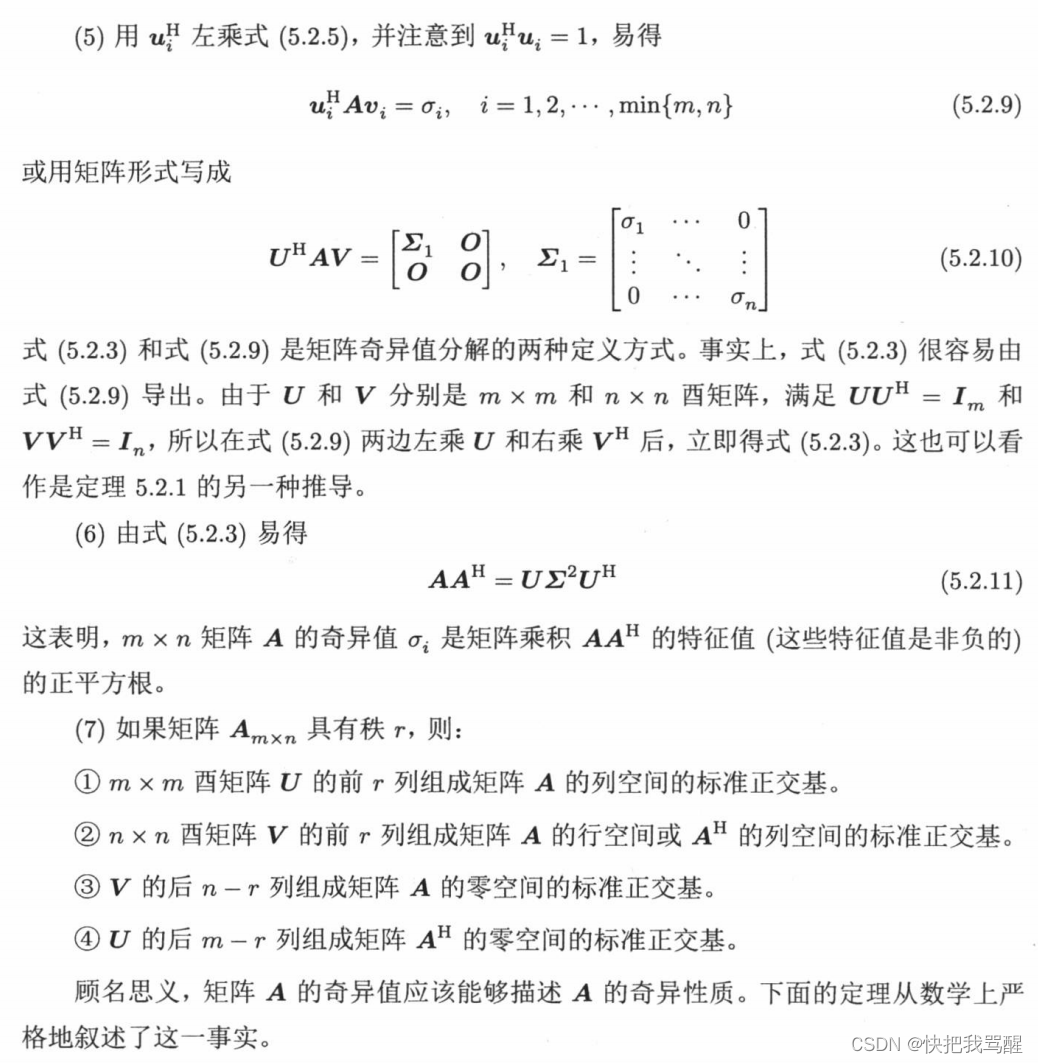

(5.2.11) 也说明了SVD和EVD的关系

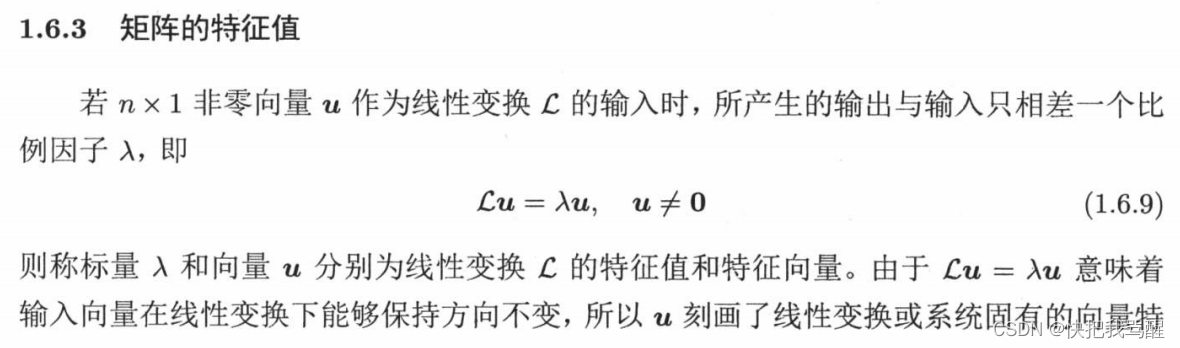

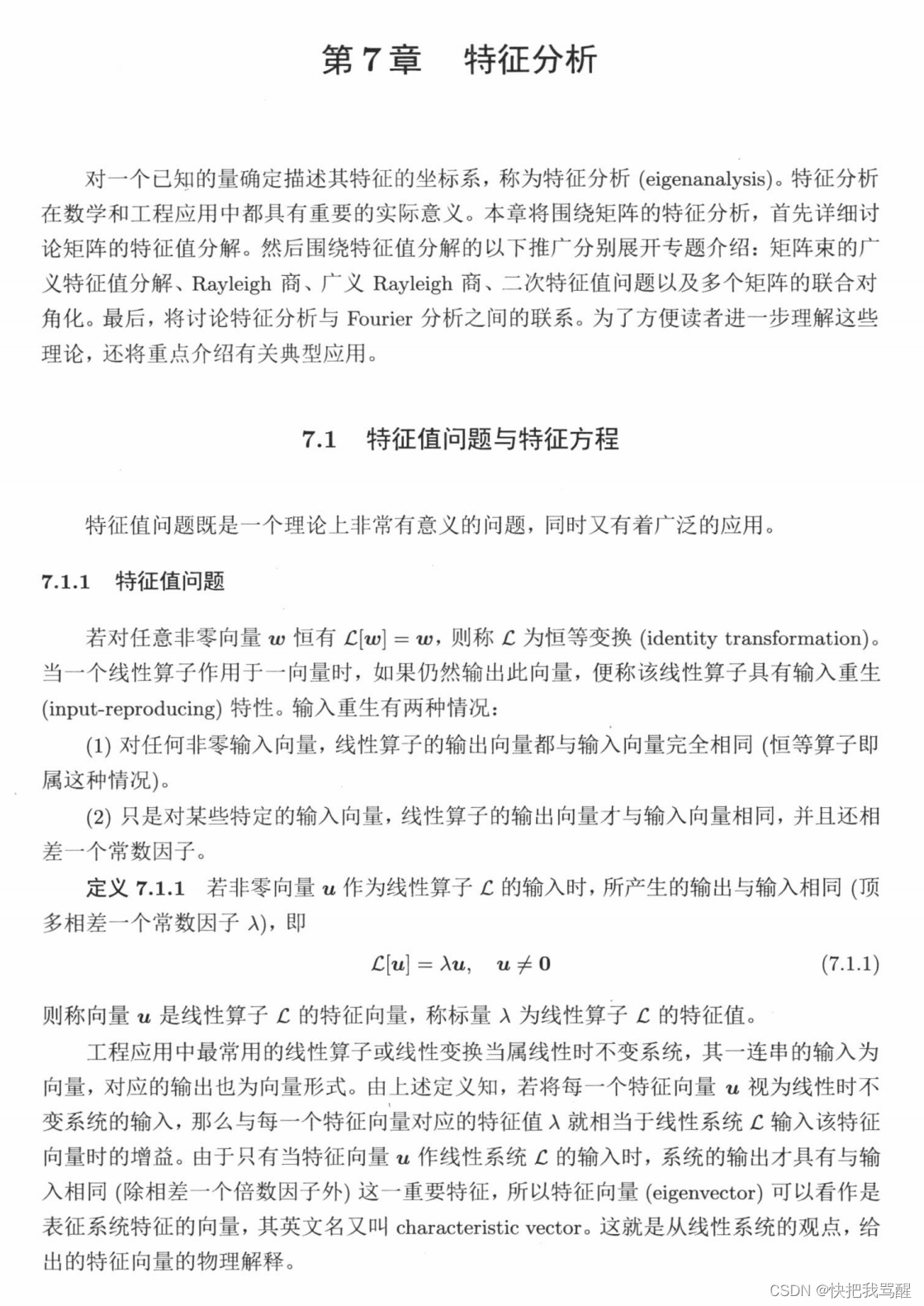

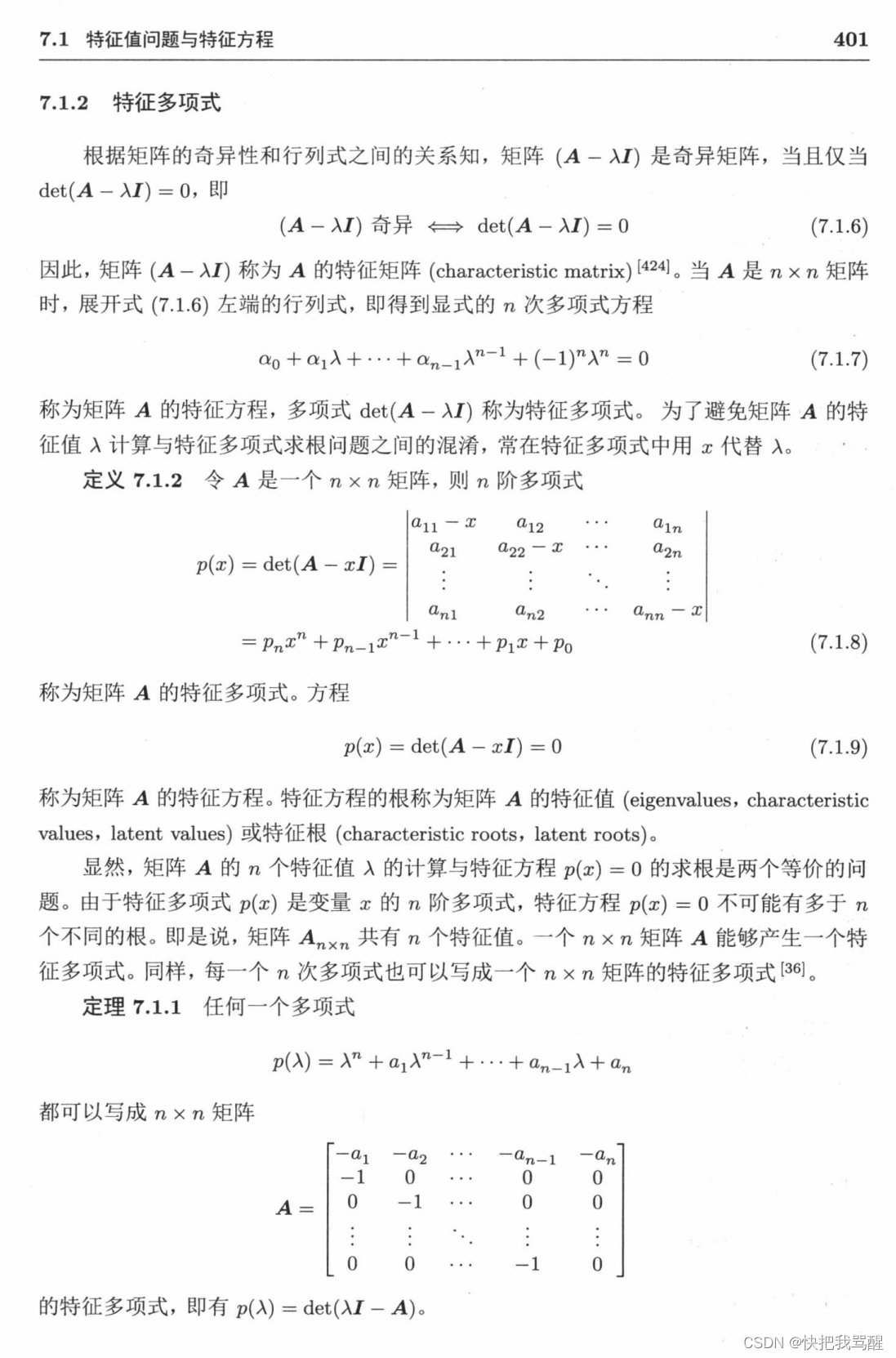

特征值分解(Eigenvalue Decomposition,EVD)

SVD和EVD基本概念

奇异值分解(Singular Value Decomposition,SVD)和特征值分解(Eigenvalue Decomposition,EVD)是矩阵分解的两种常见方法,它们在线性代数、统计学和机器学习等领域中经常被使用。虽然它们有一些相似之处,但也存在一些重要的区别。

-

定义和形式:

-

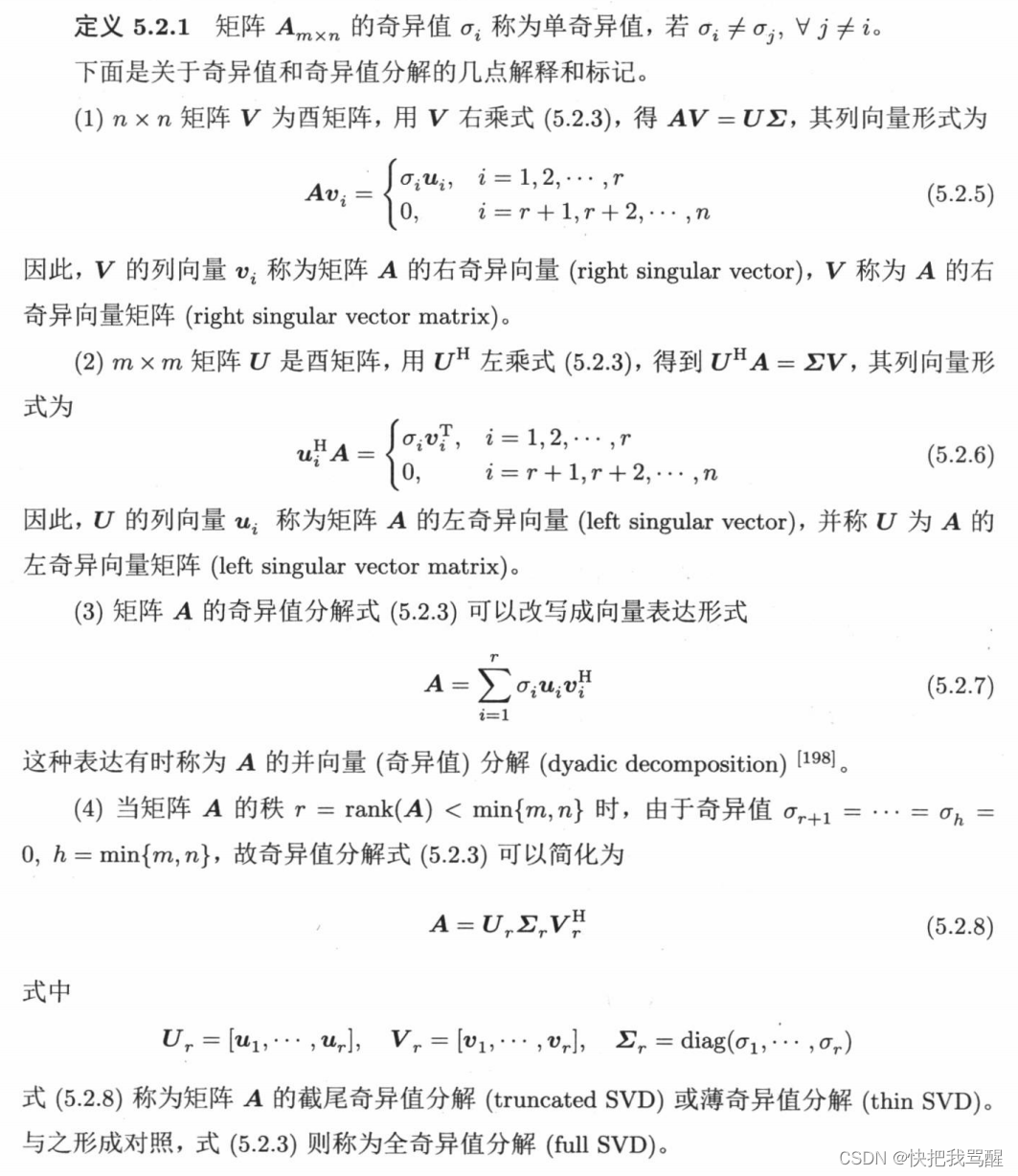

SVD(奇异值分解): 对于任意矩阵 ( A A A),SVD 将其分解为三个矩阵的乘积: ( A = U Σ V T A = U \Sigma V^T A=UΣVT),其中 ( U U U) 和 ( V V V) 是正交矩阵,( Σ \Sigma Σ) 是一个对角矩阵,对角线上的元素称为奇异值。

-

EVD(特征值分解): 对于一个方阵 ( A A A),EVD 将其分解为三个矩阵的乘积: ( A = Q Λ Q − 1 A = Q \Lambda Q^{-1} A=QΛQ−1),其中 ( Q Q Q) 是特征向量矩阵,( Λ \Lambda Λ) 是特征值矩阵。

-

-

适用条件:

-

SVD: 可以用于任何矩阵,包括非方阵。因此,SVD 可以应用于任何矩阵的分解,包括非方阵、矩阵的秩不满秩等情况。

-

EVD: 仅适用于方阵。如果矩阵不是方阵,需要使用广义特征值分解(Generalized Eigenvalue Decomposition)。

-

-

性质:

-

SVD: 奇异值是非负实数,而且是矩阵的奇异值分解总是存在的。

-

EVD: 特征值可以是复数,而且并非所有矩阵都具有特征值分解。

-

-

唯一性:

-

SVD: 对于任意矩阵,它的奇异值分解是唯一的。

-

EVD: 并非所有矩阵都具有唯一的特征值分解。有些矩阵可能有多个特征值分解。

-

尽管 SVD 和 EVD 在某些方面有相似性,但它们在应用和性质上有很大的区别。SVD 更加通用,适用于任意矩阵,而 EVD 主要用于方阵。在实际应用中,选择使用哪种分解方法通常取决于问题的性质和所处理的数据。

具体计算中的关系

让我们重新考察方阵 ( A A A) 的奇异值分解(SVD)和 ( A T A A^TA ATA) 的特征值分解(EVD)之间的关系。

对于方阵 ( A A A),假设它的奇异值分解为 ( A = U Σ V T A = U \Sigma V^T A=UΣVT),其中 ( U U U) 和 ( V V V) 是正交矩阵,( Σ \Sigma Σ) 是对角矩阵,对角线上的元素是奇异值。那么 ( A T A A^TA ATA) 的特征值分解为 ( A T A = W Λ W − 1 A^TA = W \Lambda W^{-1} ATA=WΛW−1),其中 ( W W W) 是特征向量矩阵,( Λ \Lambda Λ) 是特征值矩阵。

现在,我们有 ( A = U Σ V T A = U \Sigma V^T A=UΣVT),我们可以计算 ( A T A A^TA ATA):

[ A T A = ( U Σ V T ) T ( U Σ V T ) = V Σ T U T U Σ V T = V Σ T Σ V T A^TA = (U \Sigma V^T)^T (U \Sigma V^T) = V \Sigma^T U^T U \Sigma V^T = V \Sigma^T \Sigma V^T ATA=(UΣVT)T(UΣVT)=VΣTUTUΣVT=VΣTΣVT]

这里,( V V V) 是 ( A T A A^TA ATA) 的特征向量矩阵,( Σ T Σ \Sigma^T \Sigma ΣTΣ) 是 ( A T A A^TA ATA) 的特征值矩阵。

总结一下,对于方阵 ( A A A),其奇异值分解 ( A = U Σ V T A = U \Sigma V^T A=UΣVT) 中的 ( V V V) 与 ( A T A A^TA ATA) 的特征值分解 ( A T A = W Λ W − 1 A^TA = W \Lambda W^{-1} ATA=WΛW−1) 中的 ( V V V) 对应。特别地,( V V V) 是正交矩阵,正是 ( A T A A^TA ATA) 特征值分解中的特征向量矩阵。这就是它们之间的关系。

非常抱歉之前的混淆,感谢你的耐心。希望这次的解释更为准确清晰。

2753

2753

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?