目录

Abstract

由于可见-红外人再识别(VI Re-ID)中异构数据之间存在较大的分布差距,现有的范式往往存在多模态语义不对齐问题,无法正确对齐和比较局部细节。

在本文中,我们提出了一种新的学习VI Re-ID语义对齐表示的协调注意学习框架(CAL)。具体而言,我们设计了目标感知的一致性对齐范式,该范式允许在对齐异构样本时进行目标感知的注意适应(即根据被对齐的目标图像进行适应性注意调整)。这是通过利用情态对应的判别线索和设计有效的情态不可知的对应搜索策略来实现的。为了确保跨模态检索阶段的语义一致性,我们进一步提出了match蒸馏,该方法通过基于两部分图的相似性建模和跨模态知识交换来匹配跨模态的注意模式,并学习其潜在的语义相关性。在VI Re-ID基准数据集上的大量实验证明了该方法的有效性和优越性。

Introduction

人员重新识别(Re-ID)旨在将非重叠摄像机之间的人员身份联系起来。近年来,由于其在现实世界监控系统中的实际应用,引起了越来越多的关注。传统的人员Re-ID方法主要侧重于在可见(RGB)相机中检索相同的身份[48,29,16,23,10]。

尽管它们取得了显著的成功,但它们的适用性有限,因为可见光相机不能在光线不足的条件下(例如,在夜间)捕获判别信息。为了提高照明鲁棒性,红外摄像机被广泛应用于现实监控系统中,与可见光摄像机协同工作。这增加了探索可见红外人员再识别(VI Re-ID)问题的需求,该问题旨在将不同光谱摄像机拍摄的人员图像关联起来,以实现24小时监视系统中的长期人员跟踪。

与传统的基于rgb的再识别相比,由于可见光和红外图像之间的光谱特性差异,VI重新识别更具挑战性。这种数据异质性会导致特征空间的严重不对齐和类内的巨大差异,从而导致性能的显著下降。此外,与基于rgb的Re-ID任务类似,VI Re-ID也会受到姿势或背景变化的影响,从而导致难度增加

近年来,在缓解VI Re-ID模态差距方面的创造性工作激增[38,43,18,44,4,20]。然而,由于大多数现有方法只考虑从整个图像中学习全局表示,它们无法比较局部细节。此外,由于快速学习特征[6],基于全局特征的方法倾向于学习特定于模态的快速模式,使得学习到的特征容易集中在每个模态的不同区域,从而导致性能不佳。一个看似简单的解决方案是使用基于分裂的[29,8,20]、基于辅助模型的方法[26,19,28,1]或基于注意力的范式[18,16,33,27]来学习语义一致的局部特征,而不是使用全局模式。然而,这些方法也无法实现模态间的语义对齐,如图1所示,并且强制对齐这些语义不对齐的嵌入将不可避免地损害训练过程并影响性能。

图1所示。对典型局部特征学习范例的高层次概述。(a)基于分割的:手工条纹的语义并不总是正确对齐。(b)基于辅助模型:预训练的辅助模型由于域移位(特别是红外图像)而容易出错。©基于注意:由于模态间的分布差距,现有的具有较少描述性可学习原型的样式敏感注意模块往往不能关注语义一致的区域。(d) CAL (Ours):我们的方法可以通过判别区域挖掘、目标感知的风格不可知的注意和部分对齐的知识交换来学习协调注意。

与这些深度学习方法不同,人类视觉系统可以自然地避免不对齐问题,这要归功于他们的目标感知比较策略。考虑到比较两幅人物图像(分别称为“基础图像”和“目标图像”)的场景,人类视觉系统首先会识别目标图像中多个不同的关键区域(如面部和服装细节),然后将注意力引导到基础图像中的相应区域。通过这种方式,人类能够通过参考目标图像的关键区域,自适应地、准确地调整注意力,从而始终能够完美地进行部分到部分的比较。

这表明,从模态对应的目标图像中挖掘线索,探索一种有效的跨模态对应区域搜索策略,有助于缓解多模态语义错位问题。

在本文中,我们提出了一种新的协调注意学习(CAL)框架,它模仿人类视觉系统的目标感知比较行为来学习VI Re-ID的语义对齐表示。首先,我们设计了目标感知的一致性对齐(TCA)范式,其目的是在对齐异构嵌入时利用目标模态(即模态对应物)的判别性局部线索。提出的TCA包括三个部分:(1)判别区域挖掘:从每个训练样本的特征图中识别出多样性和判别性的关键区域;(2)目标感知风格不可知注意适配器:将从目标模态中选择的关键区域作为部分查询,并应用目标感知细化来适应特征注意,生成部分对齐嵌入;

在本文中,我们提出了一种新的协调注意学习(CAL)框架,它模仿人类视觉系统的目标感知比较行为来学习VI Re-ID的语义对齐表示。首先,我们设计了目标感知的一致性对齐(TCA)范式,其目的是在对齐异构嵌入时利用目标模态(即模态对应物)的判别性局部线索。提出的TCA包括三个部分:(1)判别区域挖掘:从每个训练样本的特征图中识别出多样性和判别性的关键区域;(2)目标感知风格不可知注意适配器:将从目标模态中选择的关键区域作为部分查询,并应用目标感知细化来适应特征注意,生成部分对齐嵌入;(3)部分对齐度量学习:根据部分对齐嵌入的身份标签对其进行聚类或分离。尽管这种目标感知的改进方案可以利用目标模态的线索来缓解模态差异,但它在推理过程中带来了更高的计算成本。因为它需要对所有查询库对执行,而库集通常很大。为此,我们进一步提出match蒸馏。首先,我们需要将生成的不同模态的零件查询关联起来,以保证后续的蒸馏是在语义一致的特征上进行的。这是通过用二部图建模它们对应的注意图的相关性,并进行跨模态查询匹配(CQM)来找到最优匹配来实现的。然后,设计了双级知识蒸馏损失,以允许在最匹配的查询之间进行跨模态知识交换。这有助于了解可见光和红外模态之间的潜在关系。经过MatchDistill的训练,每个模态都可以从对应的模态中学习知识,并且在推理过程中不需要跨模态交互。

总体而言,我们的贡献总结如下:•我们提出了协调注意学习(CAL),这是一种模仿人类行为并学习协调注意的目标感知训练范式,以缓解VI Re-ID的多式联运注意偏差问题。

•为了实现部分对齐度量学习,我们提出了Targetaware Concordant Alignment (TCA),它利用跨模态线索,并允许在对齐异构嵌入时进行自适应注意力调整。

•我们提出MatchDistill,它匹配跨模态的注意模式,并通过基于两部分图的相似性建模和跨模态知识交换来学习其潜在的语义相关性。

•广泛的实验表明,所提出的CAL在SYSU-MM01[38]和RegDB[25]数据集上都具有最先进的性能。

Related Work

可见-红外身份识别。近年来,可见-红外人体Re-ID (VI Re-ID)越来越受到人们的关注[43,17,39,12,20]。主流VI Re-ID范式致力于通过设计度量学习约束[45,42,40]、特征统计归一化[14,39,13]、合成辅助训练样本[34,3,49,24]或开发特定于模态和模态共享的特征学习范式[5,22,30]来弥合模态差距。

然而,这些方法只考虑从整个图像中学习全局表示,而没有考虑图像的局部信息,导致学习到的特征的表达能力有限。少数作品也尝试学习本地通过将特征映射分割成几个手工条纹,为VI Re-ID[8,20,41,47]提供特征。然而,由于检测盒不准确,姿势变化和遮挡,手工条纹并不总是对齐良好,导致性能不理想。

个人本地特征学习Re-ID。局部特征学习是人再识别的重要研究方向,学习部分聚合特征使模型具有抗不对准的鲁棒性。

它可以大致分为基于分裂的方法、基于辅助模型的方法和基于注意力的方法。基于分裂的方法[29,8,20]侧重于从水平划分的区域中学习局部特征,这些区域现在可以作为强部分特征学习基线。然而,由于检测盒不准确、姿态变化和遮挡,手工条纹的语义不能很好地对齐。基于辅助模型的方法[26,19,28,1]通常采用现成的辅助人工解析或姿态估计网络来获得语义上有意义的身体部位。然而,它们需要额外的计算成本,并且容易产生噪声估计,特别是当数据分布变化时。基于注意的方法侧重于利用注意机制来定位人体的区别部位,并取得了很大的成功[18,16,33,27]。然而,由于第1节讨论的多模态语义错位问题,这些方法不能直接应用于VI Re-ID的跨模态场景。

Methodology

Intuition of Target-aware Alignment

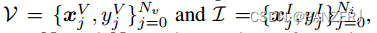

设x^k表示模态k的训练图像,其中k∈{V, I} (V表示可见模态,I表示红外模态)。可见光和红外的样本数据集是用 ,其中Nv和Ni为数据集中每个模态的样本个数,y^k_j为模态k的第j个样本对应的身份标签。可见-红外人物再识别的目标是根据特征相似度匹配跨模态的人物身份。因此,减少异质样本之间较大的类内差异至关重要。现有的范式通常试图通过直接优化来减少跨模态的类内变化

,其中Nv和Ni为数据集中每个模态的样本个数,y^k_j为模态k的第j个样本对应的身份标签。可见-红外人物再识别的目标是根据特征相似度匹配跨模态的人物身份。因此,减少异质样本之间较大的类内差异至关重要。现有的范式通常试图通过直接优化来减少跨模态的类内变化

式中,f表示特征提取器,d(·,·)表示特征之间的距离。然而,正如第1节所讨论的,注意力失调问题可能会损害训练过程并影响性能。因此,我们赋予模型根据被比较目标自适应调整注意力的能力,以达到注意共识。首先,引入判别区域挖掘(Discriminative Region Mining, DRM)模块,表示为γ(·),将全局特征分解为不同的关键身体部位。然后,我们设计了目标感知风格不可知注意力适配器(TSAA),允许根据任何给定的部分查询进行自适应风格不可知注意力调整,而不管图像样式如何。然后将特征提取器重新表述为f(x, p)来表示上述动态注意力调整过程,其中p表示给定的身体部位。减少跨模态类内变化的目标函数可以定义为

通过这种方式,被优化的嵌入可以实现语义一致性,因为使用相同的查询来引导特征注意(例如,f(x vi, γ(x i j)k)和f(x i j, γ(x i j)k)对应于相同的语义区域,因为它们使用相同的部分查询γ(x i j)k进行细化)。

这也允许跨模态交互,以促进模态之间的下划线关系的学习。整个管道如图2所示,下面的小节将介绍更多细节。

Target-aware Concordant Alignment

Discriminative Region Mining

判别区域挖掘模块旨在从骨干网衍生的特征映射X∈R C×H×W中发现多个不同的判别关键区域,其中C、H、W分别表示通道数、高度和宽度。我们的DRM包含两个阶段:零件评分和令牌选择和聚合。前者的目的是将标记(即X的空间向量)分类为Np个不同的部分,后者根据分数为每个部分选择top-k个标记并将其聚合,从而得出部分特征P。

部分得分

为了将特征映射分解为几个不同的判别区域,我们首先开发了一个简单的评分网络γθ来预测特征映射中每个标记的Np判别部分的分数。这里,Np是一个表示零件数量的超参数。具体而言,如图2所示,特征映射X首先经过多个不同尺度的max-pooling层(identity mapping为1 × 1,本文为3 × 3, 5×5),得到具有不同接受域的特征。然后将这些特征上采样并沿着通道维度进行连接。最后,将连接的特征映射馈送到沿空间函数使用softmax激活的逐点卷积层中,以预测每个部分的分数。

令牌选择和聚合

给定由γθ预测的分数,然后我们为每个部分选择得分最高的标记,并通过加权平均对它们进行汇总,以获得聚合的部分特征。其中,设S∈R (H·W)×Np表示由γθ产生的softmax层后的预测分数,设T∈R (H·W)×C表示x的平面化特征映射。token的选择和聚合过程可表示为

式中T表示top-k运算;S∈R (H·W)×Np表示被选择的区域,Nk表示被选择的令牌个数,α是控制选择比例的超参数,P∈R Np×C表示聚合的部分特征。选择top-k标记而不是保留所有标记有两个主要优点:(1)它有助于过滤掉可能给后续模块带来噪声线索的噪声标记;(2)可以增强所选区域的局部性,便于局部表征的学习。

辨别力约束

为了保证零件特征P包含判别信息,我们设计了判别约束损失,其表示为

其中Φk表示使用带有softmax激活的简单全连接层实现的部分特定分类器,y是当前样本的标签。

多样性的约束

如果只使用Eq.(4)来训练DRM,模型会倾向于选择几个相同的区域,从而导致性能次优。这可以归因于深度学习系统的快捷学习特征[6],即模型试图找到解决给定任务的最简单(但可能不是最优)解决方案。为了增强所选区域的多样性,我们进一步设计了多样性约束损失,定义为

其中triu(·,1)表示给定矩阵的上三角部分(不包括对角线)。当选择的关键区域变得过于相似时,这种多样性约束损失可以被视为对模型施加了明确的惩罚。

如图2所示,DRM模块不是跨模式共享的。这可以帮助学习更好的特定于模态的零件原型,并选择更多的判别区域,从而获得更好的性能。本设计将在第4节进行实证验证。

Target-aware Style-agnostic Attention Adapter

为了实现目标感知关注,以聚集的部分特征P为参考,对特征映射中的相关区域进行适当的定位是很重要的。一个简单的解决方案是直接应用缩放点积注意力[32],将P作为部分查询,将扁平特征映射T作为键和值,表示为

其中d为特征维数。然而,这种幼稚的解决方案简单地采用点积作为相似性度量,这可能导致不准确的注意力得分。由于不同模态的特征存在较大的分布偏移,使得它们难以用简单的点积运算进行适当的比较。为此,我们设计了目标感知风格不可知注意适配器(TSAA),其中包括一个更合理的相似度计算器。如图2 (b)所示,我们首先将实例规范化(in)[31]应用于部件查询P和特征映射X的每个标记,表示为

其中d为特征维数。然而,这种幼稚的解决方案简单地采用点积作为相似性度量,这可能导致不准确的注意力得分。由于不同模态的特征存在较大的分布偏移,使得它们难以用简单的点积运算进行适当的比较。为此,我们设计了目标感知风格不可知注意适配器(TSAA),其中包括一个更合理的相似度计算器。如图2 (b)所示,我们首先将实例规范化(in)[31]应用于部件查询P和特征映射X的每个标记,表示为

其中µ(·)和σ(·)表示计算实例级均值和标准差;TP是P派生的扁平特征映射(见Eq.(3))。这种设计的动机是IR和RGB图像之间的模态差距可以被解释为风格上的巨大差异,而in已被证明可以有效地减少风格差异[14,39,13]。然后,将归一化特征输入到多层感知器(mlp)中学习非线性投影并捕获特征的复杂模式。然后,我们计算mlp后投影特征的内积,并在空间维度上应用softmax函数来获得最终的相似度。然后我们可以通过使用计算出的相似度加权平均所有标记来应用空间注意力。此外,我们还应用查询引导的通道注意来强调特征映射中的重要通道并抑制不太重要的通道,其中通道注意分数是由MLP层将部分查询作为输入生成的。形式上,TSAA模块,表示为A(·;·),可表述为

式中,S表示空间相似性计算器,⊗表示通道方向乘法,M(·;θ)为参数为θ的MLP。TSAA有两个优点:(1)它允许基于任何给定的部分查询P而不考虑图像样式的风格无关的注意力调整,使其更容易实现注意力共识;(2)关注相关区域,强调相关渠道,自然可以弥合跨模态样本之间的差距。

Part-aligned Metric Learning

我们的部分对齐度量学习旨在减少部分对齐特征之间的跨模态类内差异。如图2 (a)所示,我们首先使用TSAA进行跨模态优化,因为它可以有效地弥合第3.2.2节讨论的跨模态样本之间的差距。跨模态细化定义为

其中tj是从小批量中随机选择的,y I I = y V j;f V,I和f I,V被称为交叉精炼特征。类似地,我们也使用

其中tj是从小批量中随机选择的,y I I = y V j;f V,I和f I,V被称为交叉精炼特征。类似地,我们也使用

获得自精炼的特征。由于f V,I I和f I,I I使用相同的查询(即pi I)进行细化,因此它们将关注相同的区域,因此可以视为部分特征。然后,我们设计了部分对齐中心损失(PCL)来增强这些语义对齐嵌入的可辨别性。令c k j表示模态k (k∈{V, I})中y k j类的批特征质心

获得自精炼的特征。由于f V,I I和f I,I I使用相同的查询(即pi I)进行细化,因此它们将关注相同的区域,因此可以视为部分特征。然后,我们设计了部分对齐中心损失(PCL)来增强这些语义对齐嵌入的可辨别性。令c k j表示模态k (k∈{V, I})中y k j类的批特征质心

其中S(j) = {i | yi = yj}。我们的PCL定义为:

其中S(j) = {i | yi = yj}。我们的PCL定义为:

这里,g和s的目的是聚集类内特征和分离类间特征,分别表示为

其中σ是为了避免优化“已经正确”的质心对而采用的边缘参数;[z]+ = max(z, 0);Y(·)为对应嵌入/质心的标号。

Cross-modal Knowledge Exchange

尽管交叉精化嵌入相对于目标模态产生较小的分布间隙,但在推理阶段使用交叉精化嵌入进行检索是不可行的。因为跨模态精化需要将部分特征P(使用模态对应的图像从DRM导出)作为查询,并使用Eq.(10)应用查询引导的注意力。这个过程需要对所有的查询库对执行,由于库集通常很大,这带来了很高的计算成本。为此,我们提出了一种新的解决方案MatchDistill,它允许DRM直接生成类似目标模态的部件特征。这是通过将异构查询pv和p1与我们的跨模态查询匹配算法相关联,并将特定于模态的知识传播到模态对应物的最佳匹配查询来实现的。为了清楚起见,这里我们只以匹配和传播知识从p1到pv为例,因为MatchDistill有一个对称的管道。如图2所示,在MatchDistill中,我们首先构造一个完全二部图G(U,V, E),其中顶点U和V分别表示pi和pv。E中的每条边连接U中的一个顶点和V中的一个顶点。边的权重是查询之间的语义相似度,通过Eq.(10)计算的注意掩码的点积来度量,公式为

其中w(·)为边的权值。这背后的想法很简单:如果pk1和pk2代表相同的语义区域,它们的注意力掩模应该具有高度的相似性。这有助于有效地对异构部件查询的语义关联进行建模。零件查询匹配问题可以表示为

其中M表示最优匹配的边(亦即∀(u, v)∈M, pv u与pv I v表示相同的语义区域)。我们用Kuhn-Munkres分配算法[15]解决了这个零件查询匹配问题(Eq.(17))。之后,由于所有(u, v)∈M对在语义上是对齐的,因此可以在它们之间进行互知识传播过程。具体来说,所提出的知识蒸馏分为两个层次,即特征层次和逻辑层次。对于特征级,我们建议对齐最匹配查询对的相似度映射。这等价于使最优二部图的权值最大化,表示为

对于logit水平,我们用

式中,p为后softmax分类概率,Dkl为Kullback-Leibler散度。通过上述跨模态知识传播,自精炼特征还可以捕获重要的信息,这些信息可以像交叉精炼特征一样有利于跨模态检索。

因此,在推理期间不需要执行交叉细化。另外,通过对Lkd1和Lkd2进行优化,我们观察到随着训练的进行,最优匹配M逐渐趋于稳定。这表明,在最后一个训练历元中出现次数最高的最优匹配,记为M,可以用于测试时间匹配。

Training and Inference

训练

总体训练目标定义为L=Lid+Lpcl+λ1Lkd1+λ2Lkd2+λ3Ldis+λ4Ldiv,(20)其中Lid为常用的身份分类损失;采用λ1、λ2、λ3、λ4来平衡不同的损耗。

推理

在推理过程中,我们首先根据M对DRM的学习原型(即DRM中点向卷积层的参数)进行重新排序,以确保自精嵌入可以在语义上对齐。然后,将各部分的余弦相似度之和作为比较度量。形式上,我th可见之间的相似性和j th红外样本是由滑p cos (f f V, V i, p, i, j, p),因为表示余弦相似度计算,下标p表示索引部分的尺寸。

1627

1627

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?