对比学习论文阅读:

对比学习论文阅读 simCLR A Simple Framework for Contrastive Learning of Visual Representations-CSDN博客

对比学习论文阅读 MOCO Momentum Contrast for Unsupervised Visual Representation Learning-CSDN博客

对比学习论文阅读 BYOL Bootstrap Y our Own LatentA New Approach to Self-Supervised Learning-CSDN博客

对比学习论文阅读 SimSiam Exploring Simple Siamese Representation Learning-CSDN博客

探索简单孪生表示学习

论文发现孪生网路可以在1没有负样本2没有大批量3没有动量编码器 (只通过禁止梯度回传)的情况下学习到特征表示

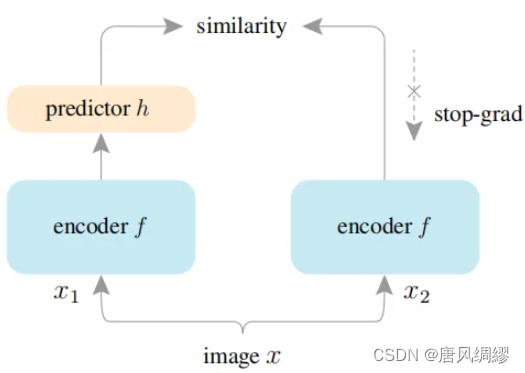

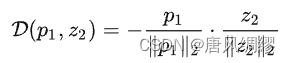

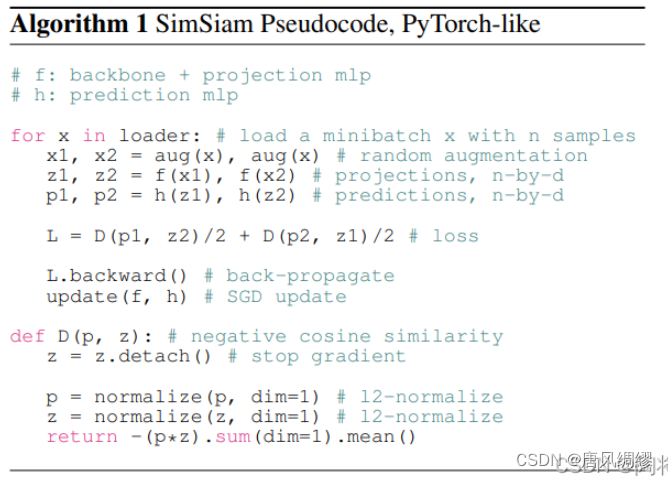

将图像x做增强后通过编码器f(backbone+投影MLP)提取特征,其中一方再通过一个预测MLP(记为h)对结果进行变换。定义D为双方余弦相似度的负值。该过程可以描述为![]() ,

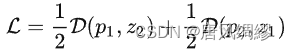

, ,定义损失函数为

,定义损失函数为 ---称为对称损失。

---称为对称损失。

损失函数作用于整个数据集,总损失是所有图像损失的平均,故最小的可能损失为-1

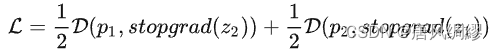

文章中最重要的概念是Stop-gradient梯度停止/禁止梯度回传。对损失函数进行简单修改:

实验:

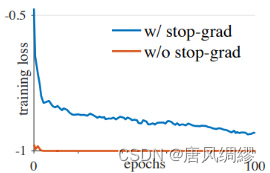

消融实验证明 去除sg,果然崩溃导致了退化解,后续作者还用实验证明退化解是“崩溃”导致的

去除sg,果然崩溃导致了退化解,后续作者还用实验证明退化解是“崩溃”导致的

之后作者通过各种实验来确定究竟是网络中的哪个结构避免了崩溃:

Sg:移除,则崩溃

预测头:移除,则崩溃。冻结预测头参数,则模型不收敛

Batch Size:影响不大

BN层:BN有助于训练优化,这与监督学习中BN的作用类似;但并未看到BN有助于避免“崩溃”的证据

损失函数:SimSiam的有效性不依赖于对称损失,只是论文设计的对称损失函数更加有效

伪代码:

880

880

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?