目录

注意力机制:我们会把我们的焦点聚焦在比较重要的事物上。

对于一个模型而言(CNN、LSTM),很难决定什么是重要的,什么是不重要的,由此注意力机制诞生了。

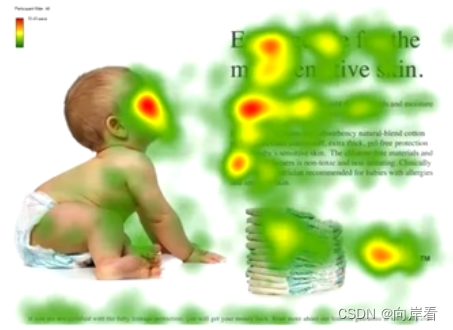

对于一张热力图而言,我们不难发现人类的注意力主要集中在该图的“红色”区域,这些“红色”区域(人脸、标题、段落开头)可能包含更多的更重要的信息。

一、注意力机制概念

从心理学角度上讲:

1.注意力是动物需要在复杂环境下有效管制的注意的点

2.在心理学框架上:人类根据随意线索和不随意线索选择注意点

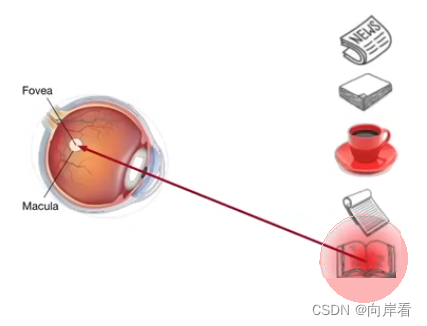

举个例子:在一堆单调黑白的物体中,有一个红色的咖啡杯,不由自主地会引起人们的注意,这种注意力为不随意线索,无目的,选择最鲜艳的目标。

那么,在喝完咖啡后呢,我们再看这一堆单调黑白的物体,去选择读书时,这时我们的注意力就是主动的了,是随意线索,有目标对象。

二、查询、键和值

- 卷积、全连接、池化层都只考虑不随意线索。

- 注意力机制则显示的考虑随意线索。

1. 随意线索被称之为查询(query)

2. 每个输入是一个值(value)

3. 不随意线索被称之为键(key)

注意力机制通过注意力汇聚(Attention pooling),将查询(随意线索)和键(不随意线索)结合在一起,实现对值(输入)的选择倾向

三、非参注意力池化层

给定数据(,

), i = 1,…,n,

为不随意线索key,

为输入value

平均池化是最简单的方案:

![]()

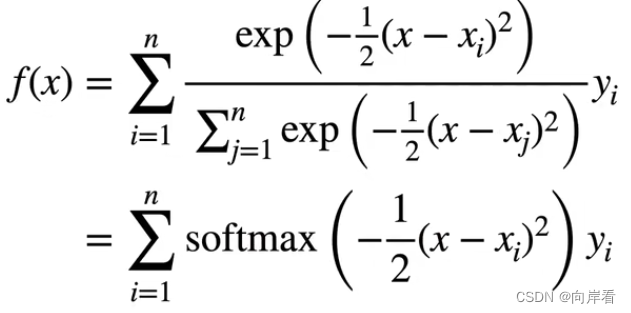

更好的方案是60年代提出的Nadaraya-Watson核回归:

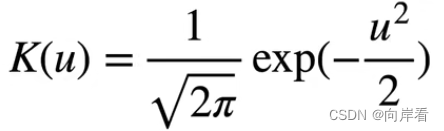

这里的K为高斯核,其定义为:

这里可以对比一下softmax函数公式:

不难看出Nadaraya-Watson核本质性上也是一个softmax函数:

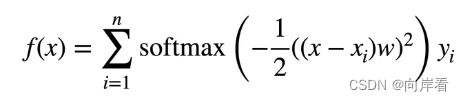

为了让注意力池化层可以进行学习,在非参数的基础上引入学习的w

1224

1224

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?