英特尔技术介绍:

Flash Attention

Flash Attention 是一种高效的注意力机制实现,旨在优化大规模 Transformer 模型中的自注意力计算。在深度学习和自然语言处理领域,自注意力是 Transformer 架构的核心组件,用于模型中不同输入元素之间的交互和信息整合。然而,随着模型规模和输入长度的增加,传统的自注意力机制的计算复杂度和内存需求迅速增长,这限制了模型的扩展性和效率。Flash Attention 主要通过以下几个方面优化自注意力的计算:

-

内存效率提升:Flash Attention 通过重新设计计算流程,减少了中间结果的存储需求。它通过分批处理输入序列,并在每个批次中计算注意力权重,从而减少了同时需要在内存中保持的数据量。

-

计算优化:该方法采用了一种新的计算策略,通过优化矩阵运算和利用现代硬件(如 GPU 和 TPU)的并行处理能力,显著提高了计算效率。例如,它可以更有效地利用内存带宽和计算单元。

-

减少冗余计算:在传统的注意力机制中,对于每一对输入元素都需要计算一个得分,而 Flash Attention 通过智能分组和预处理输入数据,减少了不必要的重复计算。

-

适应不同的硬件和场景:Flash Attention 设计灵活,可以根据不同的硬件配置和具体应用场景进行调整,以达到最佳的性能和效率平衡。

通过这些优化,Flash Attention 不仅能够处理更长的序列,而且能够在保持甚至提高模型性能的同时,降低资源消耗和提高处理速度。这使得它在处理大规模数据集或需要实时响应的应用中尤为有用。

总之,Flash Attention 是对传统 Transformer 自注意力机制的一种重要改进,它通过减少计算复杂度和内存需求,使得大规模模型的训练和推理变得更加高效。

Flash Decoding

Flash Decoding 是一种用于自然语言生成任务的高效解码方法,特别是在使用 Transformer 模型进行文本生成时。在自然语言处理中,解码是从模型生成输出的过程,例如在机器翻译、文本摘要或聊天机器人应用中生成连贯的文本。传统的解码方法,如贪婪解码、束搜索(Beam Search)等,虽然广泛使用,但在处理大规模模型或长文本时可能会遇到效率和扩展性问题。Flash Decoding 通过以下方式优化解码过程:

-

并行化处理:Flash Decoding 能够在生成每个词时更有效地利用并行计算资源。它通过同时处理多个解码步骤来减少序列生成的总时间,与传统的逐步生成方法相比,这种方法可以显著加速解码过程。

-

减少重复计算:在传统的解码过程中,每生成一个新词后,整个输入序列(包括所有已生成的词)通常会重新输入到模型中进行处理。Flash Decoding 通过智能缓存先前的计算结果,减少了这种重复计算的需要。

-

优化搜索策略:尽管 Flash Decoding 可以与传统的解码策略(如贪婪解码或束搜索)结合使用,但它也可能引入更高效的搜索算法来快速定位最优或近似最优的输出序列。

-

动态终止:Flash Decoding 可以根据生成文本的质量或其他实时评估指标动态决定何时停止解码,从而避免不必要的计算,并提高整体效率。

-

适应性调整:该方法能够根据不同的任务需求和硬件配置调整其性能,以实现在保证输出质量的同时最大化解码速度。

总的来说,Flash Decoding 是一种创新的解码技术,旨在提高文本生成任务中的解码速度和效率,特别适用于需要快速响应或处理大量数据的应用场景。通过减少计算负担和优化资源使用,Flash Decoding 能够使大规模 Transformer 模型的部署和实际应用变得更加可行和高效。

实验过程及结果:

个人心得:

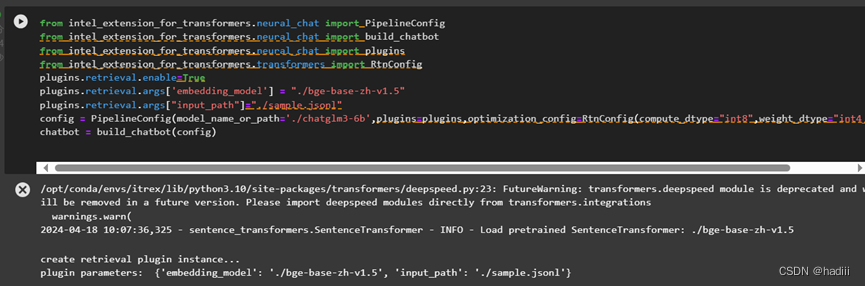

在这个实验中,我尝试将大型语言模型(LLM)与检索增强生成(RAG)相结合。这种组合的目的是利用LLM的生成能力和RAG的信息检索能力,以期提高回答问题的准确性和相关性。

实验的基本设定包括使用一个预训练的语言模型作为基础,通过RAG框架在回答过程中实时检索外部信息。具体来说,当模型接收到一个查询时,它首先对查询进行理解,然后利用RAG从一个大型的文档库中检索相关信息。这些信息被用作生成回答的上下文,从而帮助模型生成更加丰富和准确的内容。

在实验过程中,我观察到结合使用LLM和RAG可以显著提高回答的质量。特别是在处理专业或深度问题时,这种方法能够提供更多的细节和精确度,因为模型能够接入更广泛的知识库。此外,这种方法还有助于减少生成错误或不相关回答的情况,因为回答是基于检索到的具体证据生成的。

然而,这种方法也存在一些挑战。首先,依赖于外部知识库的质量和更新频率,如果知识库内容过时或质量不高,可能会影响回答的准确性。其次,检索和生成的过程需要相对较高的计算资源和时间,这可能会影响模型的实时响应能力。

总体来说,LLM结合RAG的实验表明这是一个有前景的方向,尤其是在需要高质量和信息丰富的答案的应用场景中。未来的工作可以集中在优化检索效率、扩展知识库的覆盖面以及提高系统整体的稳定性和可靠性上。

436

436

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?