python爬虫(一)

提示:文章内容只有稀少了专业词汇(其实只是我的知识面太窄了QAQ),绝对适合小白学习。

前提:小白已掌握python基础知识

文章目录

提示:以下是本篇文章正文内容,下面案例可供参考

一、概念性必要知识

1. 爬虫步骤

爬虫就是对网页数据进行爬取,通过一些规则来进行提取我们需要的数据即可。- 数据挖掘 ----> 爬取源代码

- 数据清洗 ----> 在众多源代码中得到我们需要的数据

2. 两种爬虫方式

- 通用爬虫(了解)

① 抓取网页,像百度谷歌这些搜索引擎

② 数据存储,把爬取的网页存到数据库

③ 预处理,就是数据清洗

④ 提供检索

绝大部分都是没有用的东西, - 聚焦爬虫(常用)

面向特定内容进行爬取,可以去确定需求

内容比较多,后面进行详细讲解…

3. 请求和响应(了解)

服务器里装的网站数据、前端网页信息、中间层(数据处理)、数据库。

用户 通过浏览器发送请求 到服务器的中间层(对请求进行解析,查询到数据) 通过数据再去前端响应

百度搜索 —> 输入搜索内容 —>返回结果页面

4. URL(统一资源定位符):就是网址

① 协议(http、https)

② host(IP地址、域名、eg:192.168…)

③ port(服务器端口号,一般是80,80可以省略)

④ path(访问资源的路径)

⑤ query-string (参数,发送给http服务器的数据)

例如:https://www.baidu.com/s?wd=pyhton

“?”后面就是参数,多个参数用“&”连接

5. Get和Post

- get:参数可以放在url,如https://www.baidu.com/s?wd=pyhton

- post:参数不能放在url,通常用于提交大量的数据,或者涉及到安全性的数据

二、第一个爬虫

1. 引入模块:request

引入模块的两种方式:- import urllib.request

- from urllib import request

2. 定义URL

url = r"http://www.baidu.com/"

“r” 防止url中存在转义字符(建议加 r)

注意:url中通常用http(因为https要比http安全一些,可能爬取不了)

3.发送请求

在urllib.request模块下有一个urlopen(),可以直接把url放在里面,当urlopen(url)方法执行时浏览器就会给百度的服务器发送请求(url中的内容),再通过read()方法来读取,最后用一个变量reponse来接收返回的信息

以下代码就是数据挖掘:

# 导入模块

from urllib import request

# 定义url

url = r"http://www.baidu.com/"

# 发送请求 获取响应信息

response = request.urlopen(url).read()

如果数据中存在中文会通过二进制的方式进行存储

4. 中文问题的解决方法

通过上面的代码我们得到的 response 是一个二进制类型(字节码),我们可以通过decode()方法进行解码, response = request.urlopen(url).read().decode这样我们就可以得到一个 str 字符串类型的 response ,这样就可以正常显示中文信息

总的一句话来说就是加一个decode()

5. 简单的数据清洗(正则表达式)

通过以上代码获取到百度的网页信息,接下来通过正则表达式来进行数据清洗得到我们需要的数据。

这里需要引入模块:import re(正则表达式的模块)

# 导入模块

from urllib import request

import re

# 定义url

url = r"http://www.baidu.com/"

# 发送请求 获取响应信息 request自动创建请求对象

response = request.urlopen(url).read().decode() #编码

# 数据清洗 得到我们需要的数据存放在变量pat中

pat = r"<title>(.*?)</title>" # 获取title标签中间的内容

# 变量data来存储我们需要的数据

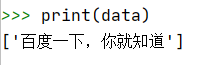

data = re.findall(pat,response) # 返回列表

这里涉及到了正则表达式的使用,推荐大家去编程胶囊学习一下。

注意:最后得到的 data 是一个 list 列表类型

总结

数据挖掘:通过urllib去获取信息

数据清洗:通过正则表达式进行数据清洗

最后得到整个网页中得到我们需要的信息

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?