下面就开始介绍如何使用图生图这个模块了。

基础用法

简单使用

点击“图生图标签”,点击之后就看到了如下图所示的画面。

在"生成"按钮旁边有"CLP反推提示词"和"DeepBooru"反推提示词,这两个都是根据图片获取提示词,但是有不同的区别。

CLP反推提示词更适用于写实风格的照片反推提示词

DeepBooru更适用于二次元风格的照片反推提示词

下面来进行实战

得到写实风格

通过传入图片,并使用CLP进行反推提示词,最后在点击生成图片。

可以看到生成的图片与原图比较相似。

得到二次元风格

使用DeepBooru进行反推提示词,最后在点击生成图片。

注意:在进行绘制时,要选择对应的模型,不然就会生成不对应的图片。

可以看到,在使用反推提示词时,并没有再次添加新的提示词,这样生成的图片其实有些不太好。在实际中应该添加上新的提示词和负向提示词。

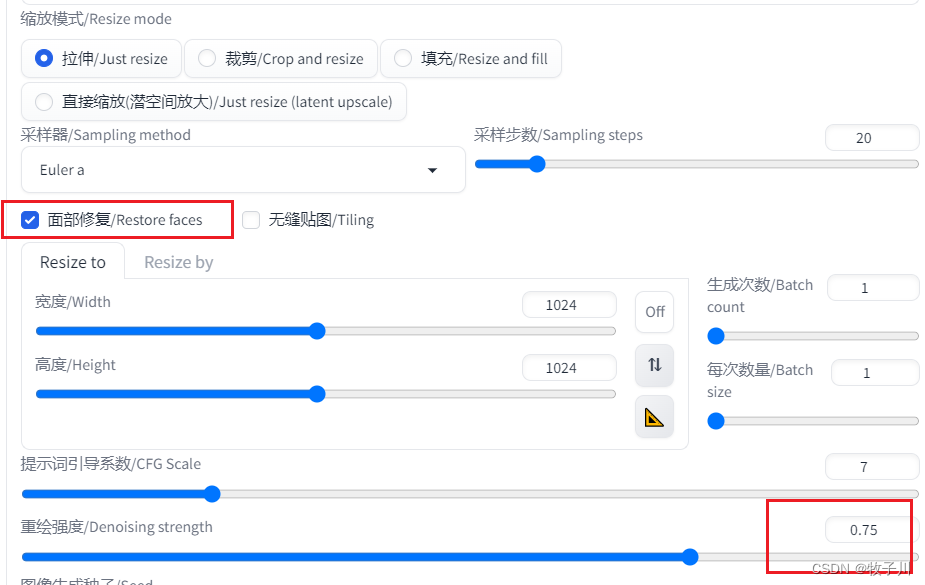

重绘幅度-Denoising

该参数默认值是0.75,表示的是生成的图片和原来的图片相似性有多大。取值范围:[0,1]

值越大,生成的图片和原来的图片越不相似。

我们来看看,设置不同的值时候,图片的差距是怎么样的。

首先,我们先设置为0

可以看到生成的图片与原图一模一样。

设置为0.25

可以看到生成的图片与原图差异不大,在脸部有变化。

设置为0.75

差异就很明显了。

设置为1

可以看到,差异变得更大了。

在一般情况下,Denosing设置的值一般在0.25到0.75左右,Denoising的值设置得越小,模型自由发挥的空间也就越小。

进阶用法

OpenPose Editor

OpenPose Editor是stable diffusion webui用于编辑人物姿势的插件。

默认情况下,我们的stable diffusion不会有这个tab,但是我们可以安装。可以参考下面的步骤进行安装

然后就在当前界面查找OpenPose,然后点击右边的Install,等待安装。

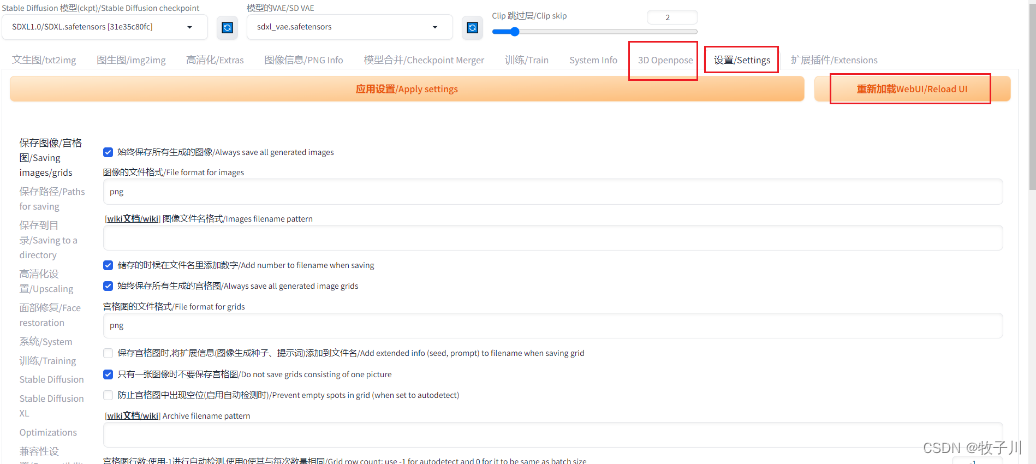

在完成安装后,到「设置/settings」点击【重新加载】就可以启用了

在生效后,我们的菜单上就多了一项「3D OpenPose」 ,我们可以自己修改姿势,当然,我们也可以上传一张照片,让他自动检测姿势。

在完成姿势的设置后,可以点击「文生图/Send to txt2img」或者「图生图/Send to img2img」,这样图片就出现在我们对应的页面了,或者点击下载也可以。

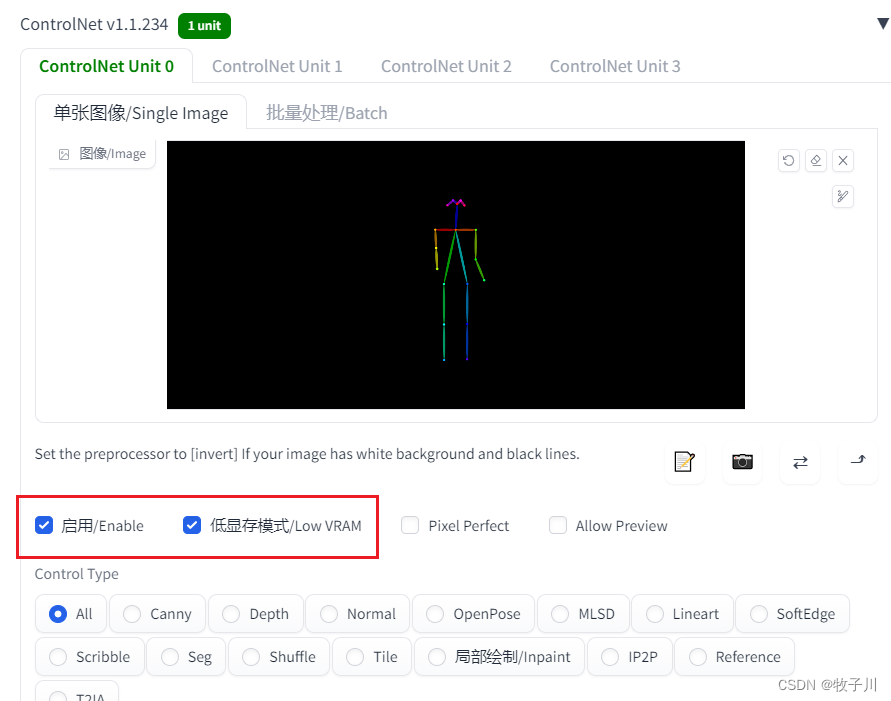

启用:是否启用ControlNet插件,不点击则不启用插件

低显存模式/Low VRAM:显卡显存在4G以下,选择它。

预处理器:我们使用ConltrolNet时,会上传一个模版图,这个预处理器就是来处理这个图的。使用OpenPose处理后的图,不需要预处理器,所以选none。

模型/Model:这里选的模型一般要和预处理的模型——对应。

Starting control SteplEnding Control Step: ControlNet模型从第几步开始引导图形生成以及何时退出。

可以看出生成的图片在动作上与原图有不同。

结语

那么,今天我们就介绍到这里。有兴趣的朋友可以关注我们,我们会持续更新本系列教程。

如果觉得不错,对你有帮助,可以关注我,在后续会发布更多的内容,也可以加入我们的星球,关注公众号,回复”星球“,获取邀请码,即可加入。如果不了解我们的星球是什么,可以看这篇文章,里面有详细介绍。

AI工具赋能,实现高效变现,实现提前下班_牧子川的博客-CSDN博客 https://blog.csdn.net/qq_48764574/article/details/132250585

https://blog.csdn.net/qq_48764574/article/details/132250585

我正在「AI高效率【工作、学习】」和朋友们讨论有趣的话题,你⼀起来吧?

https://t.zsxq.com/11KVfN0RChttps://t.zsxq.com/11KVfN0RC公众号 @AI宅玩貳号玩家,一个靠AI助力学习与工作的痴迷实践者。全网粉丝2万+,连续不间断更新小白也能玩的AI,让你提前2小时下班。

星球上面有什么:

电子竞赛专栏、深度学习专栏、AI辅助学习专栏、AI工具变现专栏等适合人群:

在校学生:希望我的经验可以帮助你解决你遇到问题,

开发人员:分享自己的经验,并且可以扩宽自己的道路,学习到更多的内容

希望用副业赚钱:我们有用AI变现的方式,可以帮助你实现用副业赚钱

硬性的标准其实限制不了无限可能的我们,所以啊!少年们加油吧!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?