什么是激活函数?

什么是激活函数&该选哪种激活函数?_哔哩哔哩_bilibili

深度学习笔记:如何理解激活函数?(附常用激活函数) - 知乎 (zhihu.com)

多种激活函数详解

详解激活函数(Sigmoid/Tanh/ReLU/Leaky ReLu等) - 知乎 (zhihu.com)

激活函数面试问答

算法面试问题二(激活函数相关)【这些面试题你都会吗】 - 知乎 (zhihu.com)

1.激活函数作用:引入非线性因素,提高了模型的表达能力。如果没有激活函数,那么模型就只有线性变换,可想而知线性模型能表达的空间是有限的。而激活函数引入了非线性因素,比线性模型拥有更大的模型空间。

2.主要常用的激活函数:

- Softmax

- Sigmoid

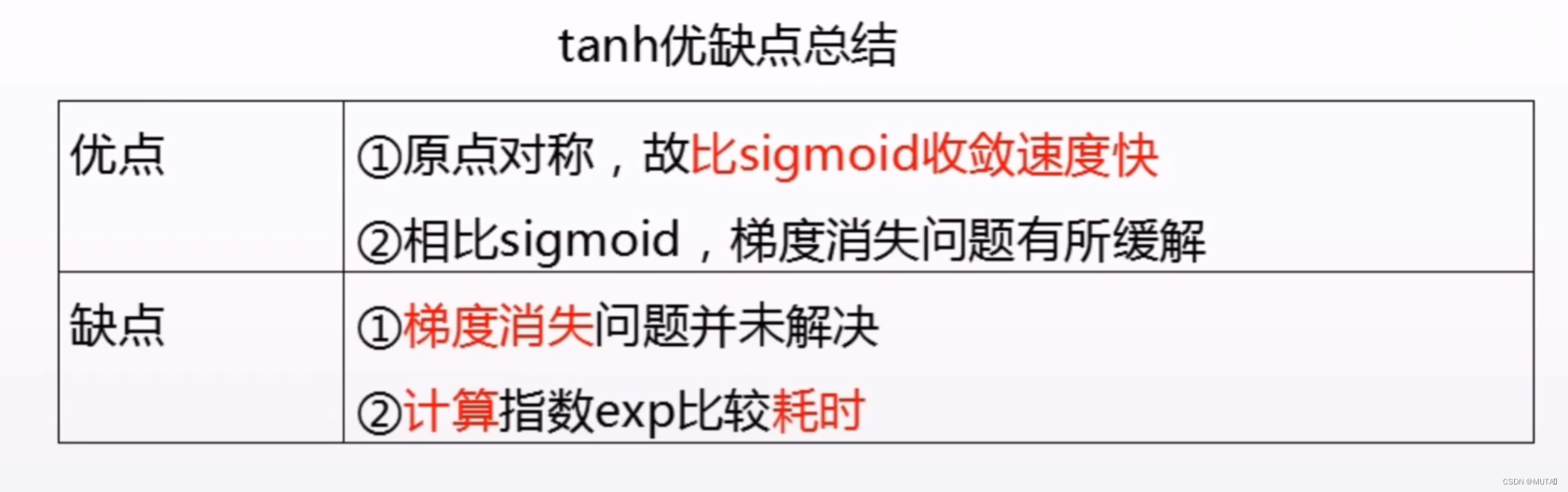

- Tanh

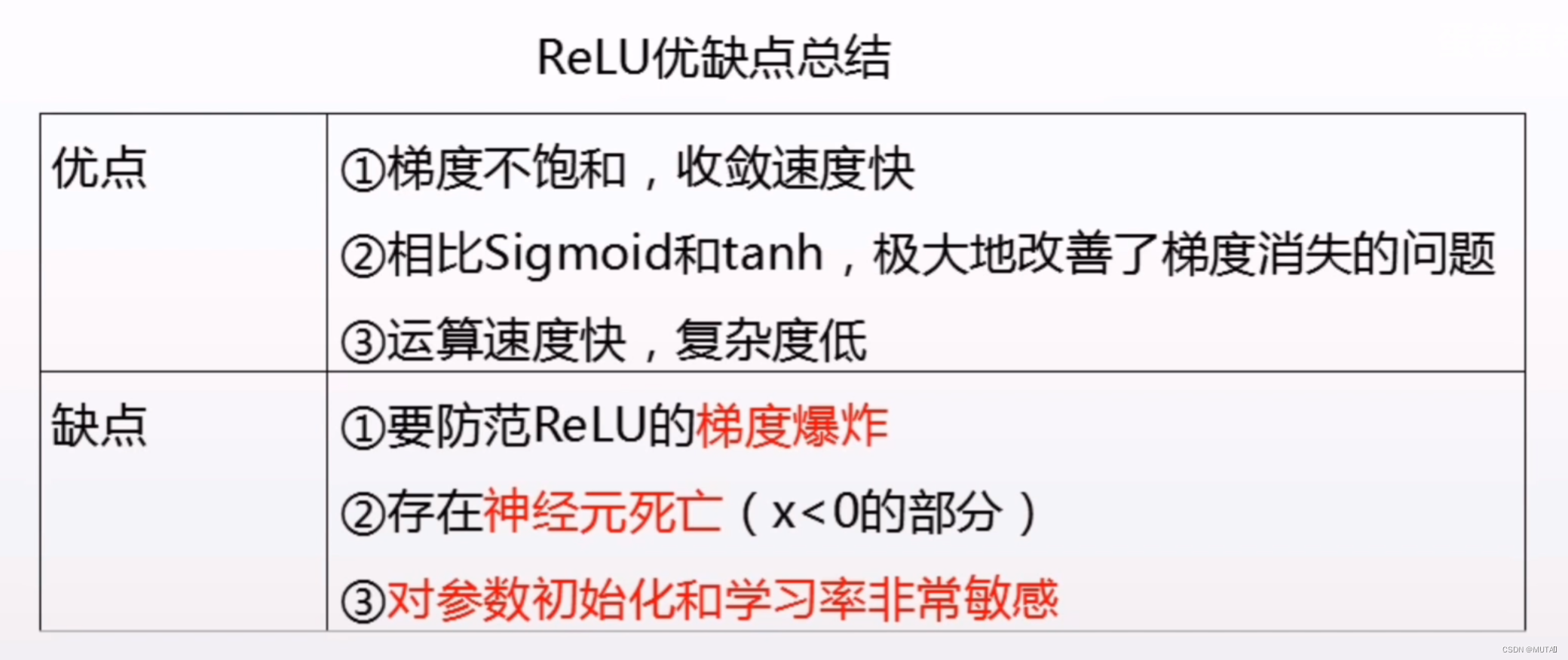

- ReLU(以及基于ReLU的改进系列:Leaky ReLU、ELU、PReLU等)

- Gelu(Gaussian Error Linear Unit,2016年被提出,直到2018年Bert开始使用才被重视)

- Swish(2017年google提出)

深度学习基础篇:如何选择正确的激活函数? - 知乎 (zhihu.com)(集中激活函数详解)

在 YOLO V5中,中间/隐藏层使用了 Leaky ReLU 激活函数,最后的检测层使用了 Sigmoid 形激活函数。而YOLO V4使用Mish激活函数。(34 封私信 / 80 条消息) relu激活函数比sigmoid效果好为什么还用sigmoid? - 知乎 (zhihu.com)(解释选用sigmoid原因)

3.如何选择激活函数:

- 用于分类器时,二分类为Sigmoid,多分类为Softmax,这两类一般用于输出层;

- 对于长序列的问题,隐藏层中尽量避免使用Sigmoid和Tanh,会造成梯度消失的问题;

- Relu在Gelu出现之前在大多数情况下比较通用,但也只能在隐层中使用;

- 现在2021年了,隐藏层中主要的选择肯定优先是Gelu、Swish了。

4331

4331

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?