2022

Forward Compatible Few-Shot Class-Incremental Learning

问题:之前的CIL重视新模型与旧模型之间的后向兼容性,忽视了新模型与未来模型的前向兼容性

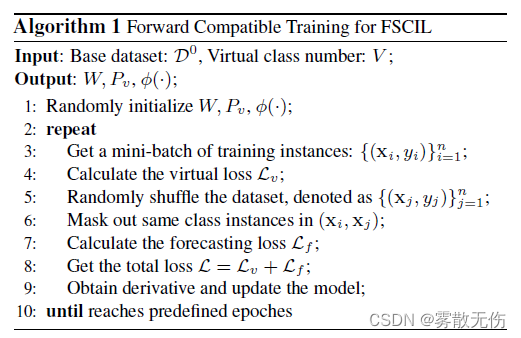

方法:

- 设置虚拟标签,每个物体在赋予真实标签的同时,拥有虚拟标签,从而让真实标签的特征空间更拥挤,让一个类别同时接近两个分布

- 设置虚拟物体,让现有的模型”提前“看到未来的类别,为未来的物体做准备(也是让现有的特征空间更拥挤一些)

疑惑:

针对虚拟标签,其设置是挺迷惑的,感觉它新增加的loss只是对学习的方向起到了一个“强化”的作用,但并没有指引出新的方向?

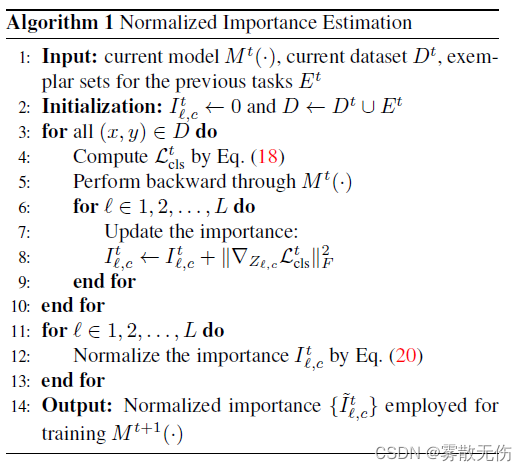

Class-Incremental Learning by Knowledge Distillation with Adaptive Feature Consolidation (CVPR)

方法:新的蒸馏项,通过泰勒展开式,本意在于引起特征变化的梯度写入损失函数;但由于这会带来太大的空间消耗,于是使用了一个上界来代替

贡献:本问主要对比PODNet和GeoDL,在CIFAR100和ImageNet 100/1000中实现了涨点。都是差不多一个点

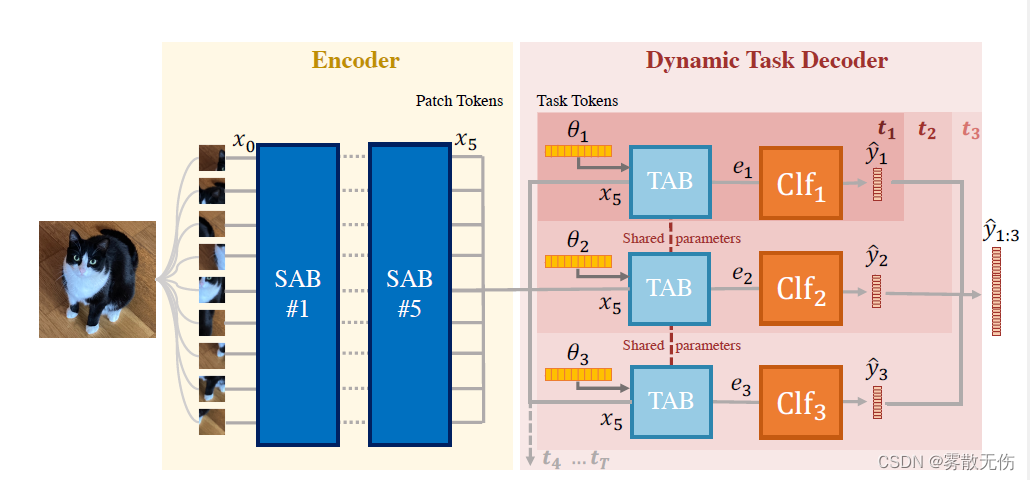

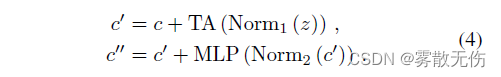

DyTox: Transformers for Continual Learning with DYnamic TOken eXpansion(CVPR)

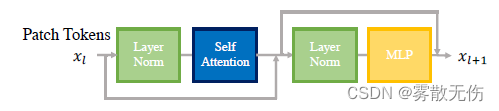

方法:采用transformer结构,在ViT的基础上进行改造,出现了TAB模块

SAB:

TAB:

贡献:将Transformer架构引入到incremental learning中,在长期记忆上效果更好(在数据库ImageNet1000上表现优于ImageNet100)

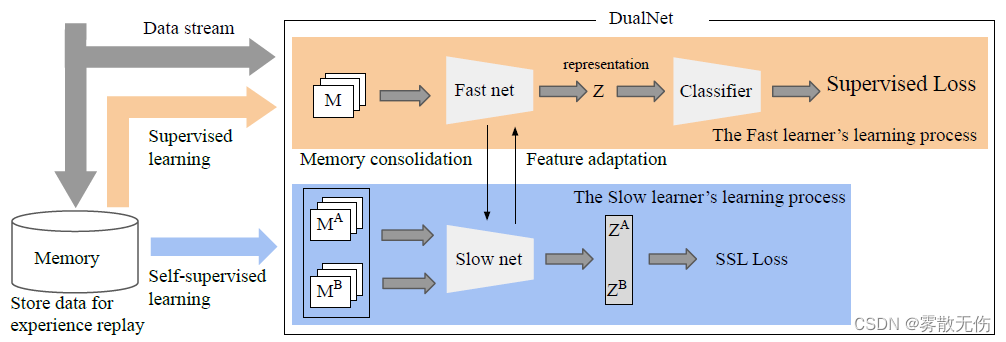

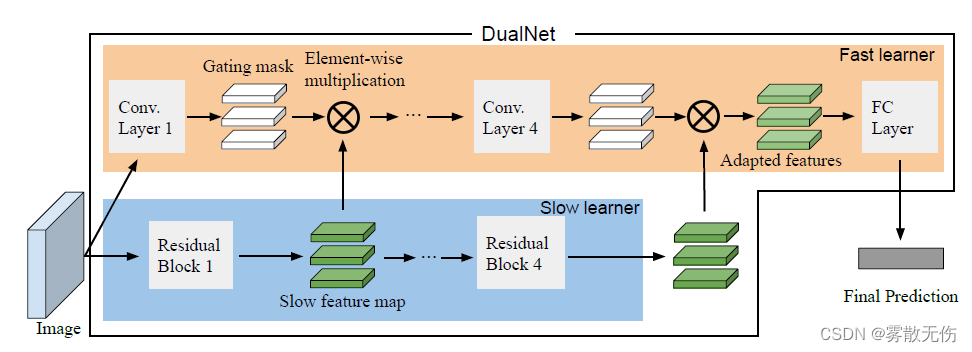

DualNet: Continual Learning, Fast and Slow(NeurIPS)

方法:来源于slow-fast,通过slow部分学习特征表示,通过fast部分学习更具体的预测。其中slow部分使用了自监督学习,而fast部分使用了监督学习

贡献:在Split miniImageNet-TA和Split miniImageNet-TF两个数据库上去的了较大的涨点

贡献:在Split miniImageNet-TA和Split miniImageNet-TF两个数据库上去的了较大的涨点

疑问:

- 这里的同步训练过程有些奇怪,原文中说的也不够清晰,代码中也并没能看出来

- 进行评测的两个数据库并不常见(对本文的质量有所怀疑)

DualPrompt: Complementary Prompting for Rehearsal-free Continual Learning(CVPR)

方法:将prompt引入到使用了transformer的incremental learning中,但是将prompt分为两类——G-prompt和E-prompt。其中G-prompt是全局使用的,而E-prompt似乎与任务(task)的匹配有关

贡献:在CIFAR-100的split任务上接近理论极限(86.51-90.85), 在Imagenet上去的了较大的突破,但距离理论极限仍有一定的距离(68.13-79.13)。最重要的是:该方法完全没有使用rehearsal

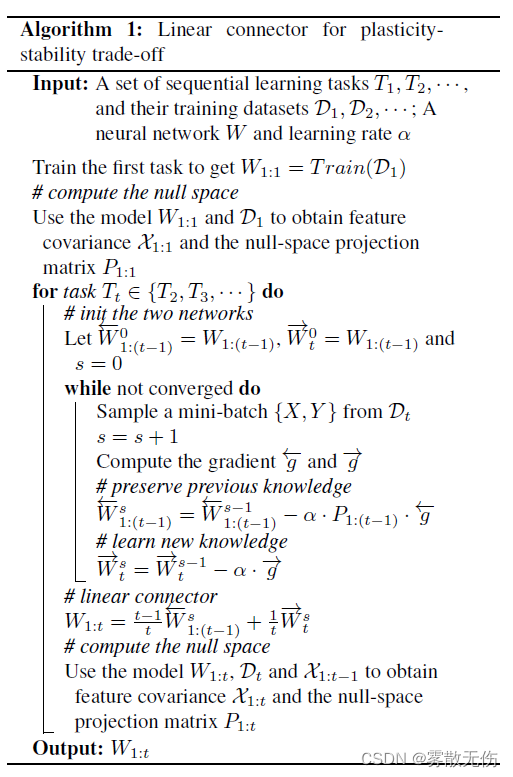

Better Plasticity-Stability Trade-off in Incremental Learning: A Simple Linear Connector(CVPR)

方法:基于一些观测结果(Obversation), 使用了一些不等式转化后的上界约束,提出一个简单的线性式,通过该线性式连接之前的模型参数和现在的模型参数。

贡献:

在CIFAR-100和TinyImagenet上取得了较大的涨点

2485

2485

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?