前言:Incremental Learning, 又名Lifelong learning, continuous learning。这些都可以视为关键词

2017

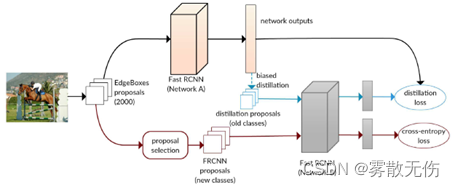

Incremental Learning of Object Detectors without Catastrophic Forgetting (ICCV)

问题: 使用CNN实现的object detection的incremental learning伴随着严重的遗忘现象,即学习新类别之后,对于原类别的识别能力大大下降

方法:采用了双网络结构,添加了distillation loss来防止新学习的网络发生太大的变化

贡献:实现了object detection的incremental learning,可以重复进行

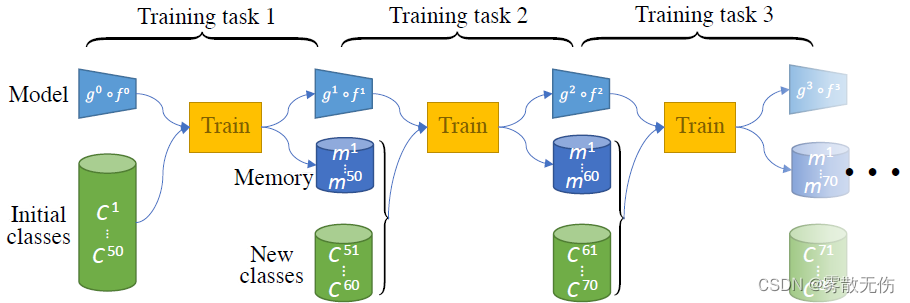

iCaRL: Incremental Classifier and Representation Learning(CVPR)

(*作为了解incremental learning整体流程的开篇论文,是比较合适的)

问题:针对数据流(data stream)的学习方式,具有明显遗忘现象(catastrophic forgettting)

方法:仅使用CNN作为feature extractor,使用最邻近方式作为classifier,使用classification loss和distillation loss对CNN进行训练

贡献:应该是incremental learning在深度学习上的提出者,提出了该问题的定义,并且给出了一个标准的解决范式

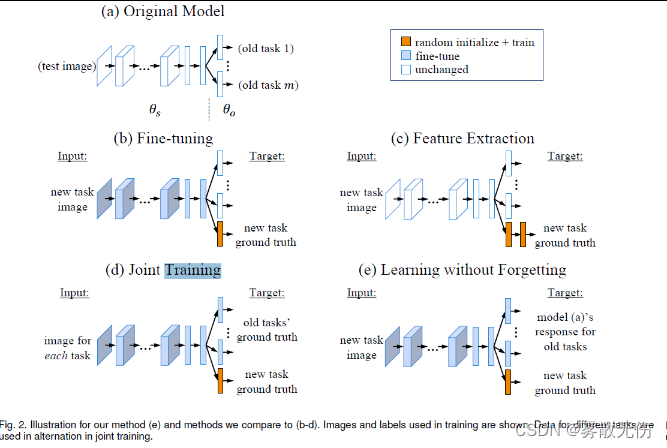

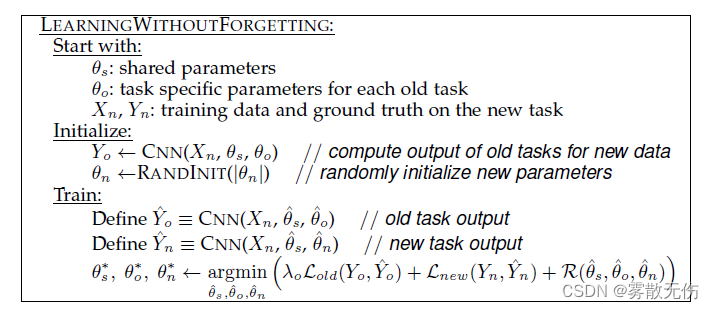

Learning without Forgetting(T-PAMI)

问题:传统使用的三种针对多任务训练的方法(Fine-tuning, Joint Training, Feature Extraction)各有不足

方法:总体而言,当面对新的任务时,LwF先使用了Feature Extraction的方法,再使用了Joint Training的方法进行训练,最后又使用了distillation进行参数的继承。但是这里的dsitillation仅针对旧任务就行。

2018

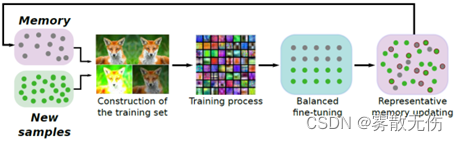

End-to-End Incremental Learning(ECCV)

问题:iCaRL的过程不是端到端的

方法:基本删去了iCaRL中的classification模块,在test时使用softmax代替。同时,在训练过程中,添加了balanced fine-tuning来进一步避免遗忘

贡献:实现了端到端的incremental learning的模型EEIL,相对iCaRL准确率提高

2019

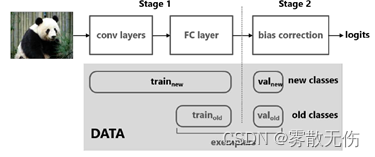

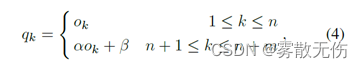

Large Scale Incremental Learning(CVPR)

问题:iCaRL和EEIL在进行太多次的incremental learning时,遗忘现象较为严重

方法:在新增class的全连接层之后添加一个小的线性函数,并使用val进行训练

贡献:发现了全连接层的影响,提出了小验证集的分割和线性函数的修正方法

2020

Adversarial Feature Alignment: Avoid Catastrophic Forgetting in Incremental Task Lifelong Learning(Neural Computation)

(*, 综述)

问题:incremental learning最核心的问题还是CF(Catastrophic Forgetting)

贡献:Incremental learning主要分为三种:Instance-incremental scenario(种类数固定,只有数量增加);class-incremental scenario(种类数和数量都变化);instance and class-incremental scenario(种类数和数量都增加)。优化的方向也主要有三种:structure(在原有的模型之外,增加新模型); regulation(对loss function进行调整,确保新模型与旧模型的一致,其中distillation loss最为常用);rehearsal and pseudo-rehearsal strategy(保留旧的数据,进行训练)

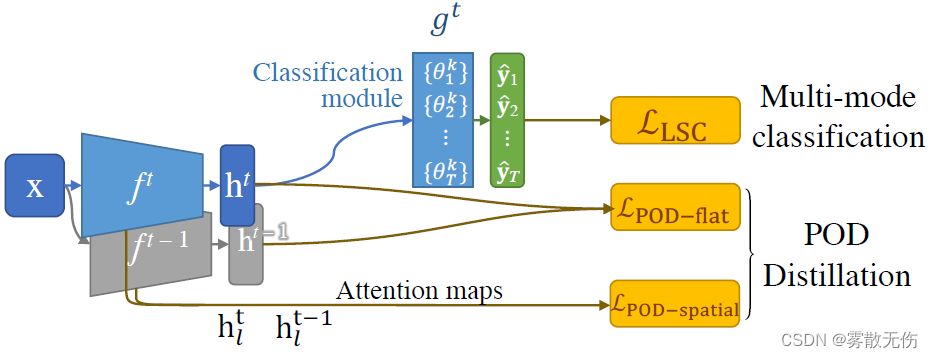

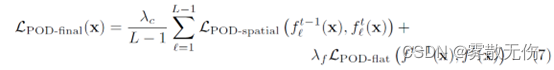

PODNet: Pooled Outputs Distillation for Small-Tasks Incremental Learning (ECCV)

问题:CF

方法:1. 使用有点疯的全局特征蒸馏,不过使用了L2 Loss,配合着池化一起使用 2. 对于分类器的优化(PODNet中将特征提取器和分类器分开讨论),将每个分类器分为K个小分类器,然后加和得到最终结果,避免提取特征与新增参数之间的similarity 3. 小分类器的初始化,使用了K-means

贡献:K个小分类器的提出,池化与提取特征之间关系的讨论

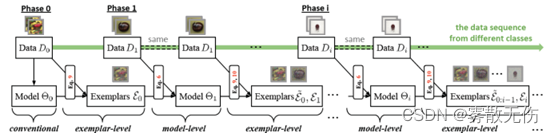

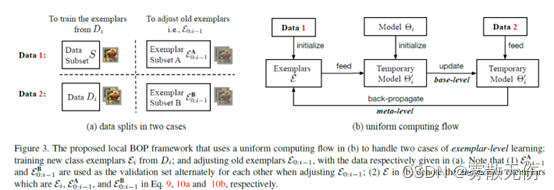

Mnemonics Training: Multi-Class Incremental Learning without Forgetting(CVPR)

问题:Multi-class incremental learning中exemplar的选择问题

方法:使用类似GAN的双向优化方法,不再在exemplar中储存具体的图片,而是将图片本身仅看作一种“变量”,与模型的参数一起优化

贡献:Mnemonics模型,从t-SNE图上来看,实现了exemplar更好的聚集效果(比较传统的herding)

2021

DER: Dynamically Expandable Representation for Class Incremental Learning(CVPR)

问题:CF

方法:采用特征提取器扩张的方法,每次检测到新的类别就保持原提取器不变,扩张新的提取器。其中又添加了auxiliary loss来辅助网络区分新旧类别,同时采用了mask方式来减少参数。(但是这似乎也不能彻底改变参数过多的事实吧?)

贡献:特征提取器扩展的方法,相对WA, BiC, RPSNet, iCaRL, UCIR, PODNet提高了准确率。

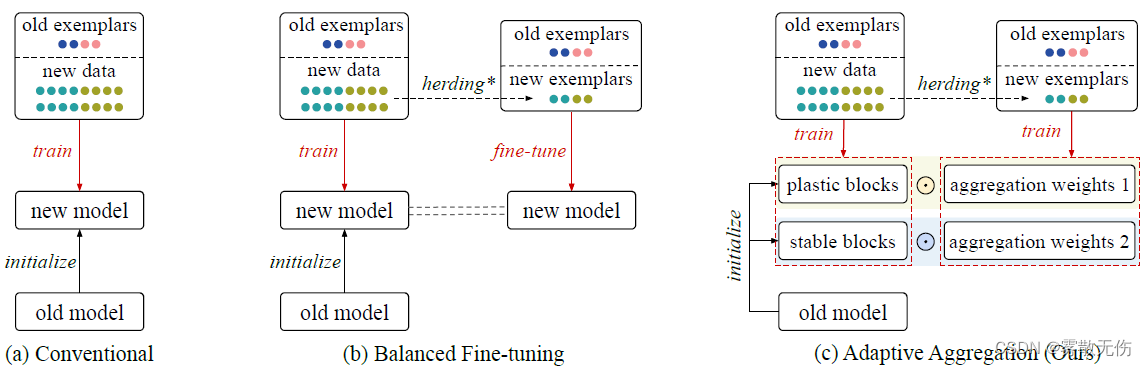

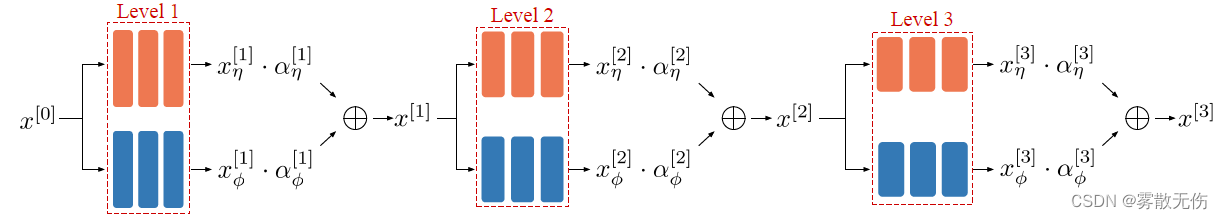

Adaptive Aggregation Networks for Class-Incremental Learning(CVPR)

问题:CF

方法:将残差网络分为两个部分(stable blocks和plastic blocks),其中plastic blocks正常更新,stable blocks仅在第一次更新,之后就按照neural-level(也可以是理解为卷积核级别)进行权重的缩放,更新的参数少很多。两者在融合时的参数,使用balanced dataset进行训练。

(Q:对于应该被stabilize的参数,和应该来作为plastic的参数,是否能够提出一种方法来规定一下呢?)

贡献:可以融入大多数的现有模型中(如iCaRL, LUCIR, Mnemonics,PODNet-CNN),大部分模型准确率提高

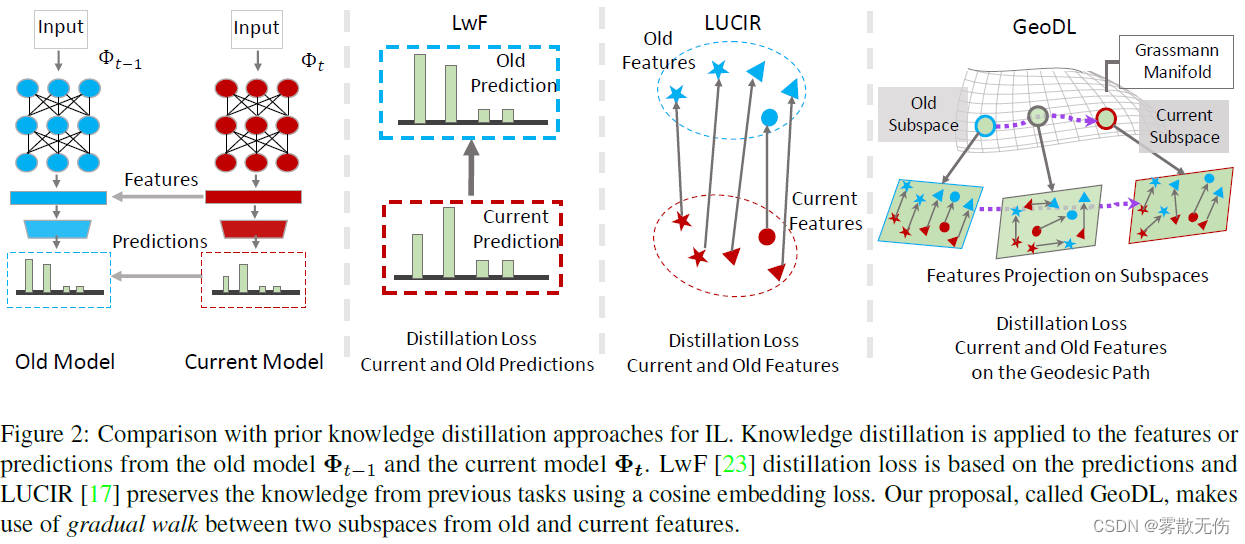

On Learning the Geodesic Path for Incremental Learning(CVPR)

问题:目前的distrillion loss使用的大多是欧式距离,没有考虑两个任务之间的“渐变”

方法:使用Feodesic Path代替欧式距离,衡量新旧特征(方法偏数学,不是很明白。。。)

贡献:一个新的distillation loss,相对欧式距离具有更好的抗遗忘性

Distilling Causal Effect of Data in Class-Incremental Learning(CVPR)

(* 因果推理与incremental learning的结合)

问题:CF现象的产生原因和相关解决方案的因果上原理目前没有得到解释

方法:通过因果推理图解释了CF现象产生的原因,还有目前的一些解决方案的因果性解释,并且利用因果图提出了新的distilliation方式,通过构建collide effect的方式使得原数据集D与预测结果Y产生关联。

贡献:对于LUCIR, PODNet, 实现了准确率的提高,同时也是将因果推理引入到了incremental learning中

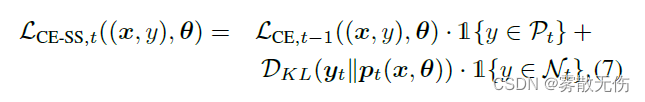

SS-IL: Separated Softmax for Incremental Learning(CVPR)

问题:incremental learning中的类别不均衡带来的影响,根本原因在于交叉熵损失函数

方法:针对于cross-entropy损失函数,作者进行了一个简单的改进,即将旧类别和新类别的概率分别进行softmax计算;

贡献:提高了benckmark上面的准确率,并证明TKD(task-wise knowledge distillation)比起GKD(global knowledge distillation)更具有优越性

954

954

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?