文章目录

摘要

本周学习关于机器学习的知识,并梯度下降调整模型参数的步骤进行理解,还学习一些深度学习定义和概念,并对两层神经网络模型反向传播更新参数的过程进行推导。通过这周的学习明白了机器学习的一般步骤。

Abstract

This week learns about machine learning and understands the steps of gradient descent to adjust model parameters, as well as some deep learning definitions and concepts, and derivation into the process of backpropagation of updated parameters in a two-layer neural network model. Through this week’s study, I learned the general steps of machine learning.

1. 机器学习

1.1 什么是机器学习(Machine Learning)?

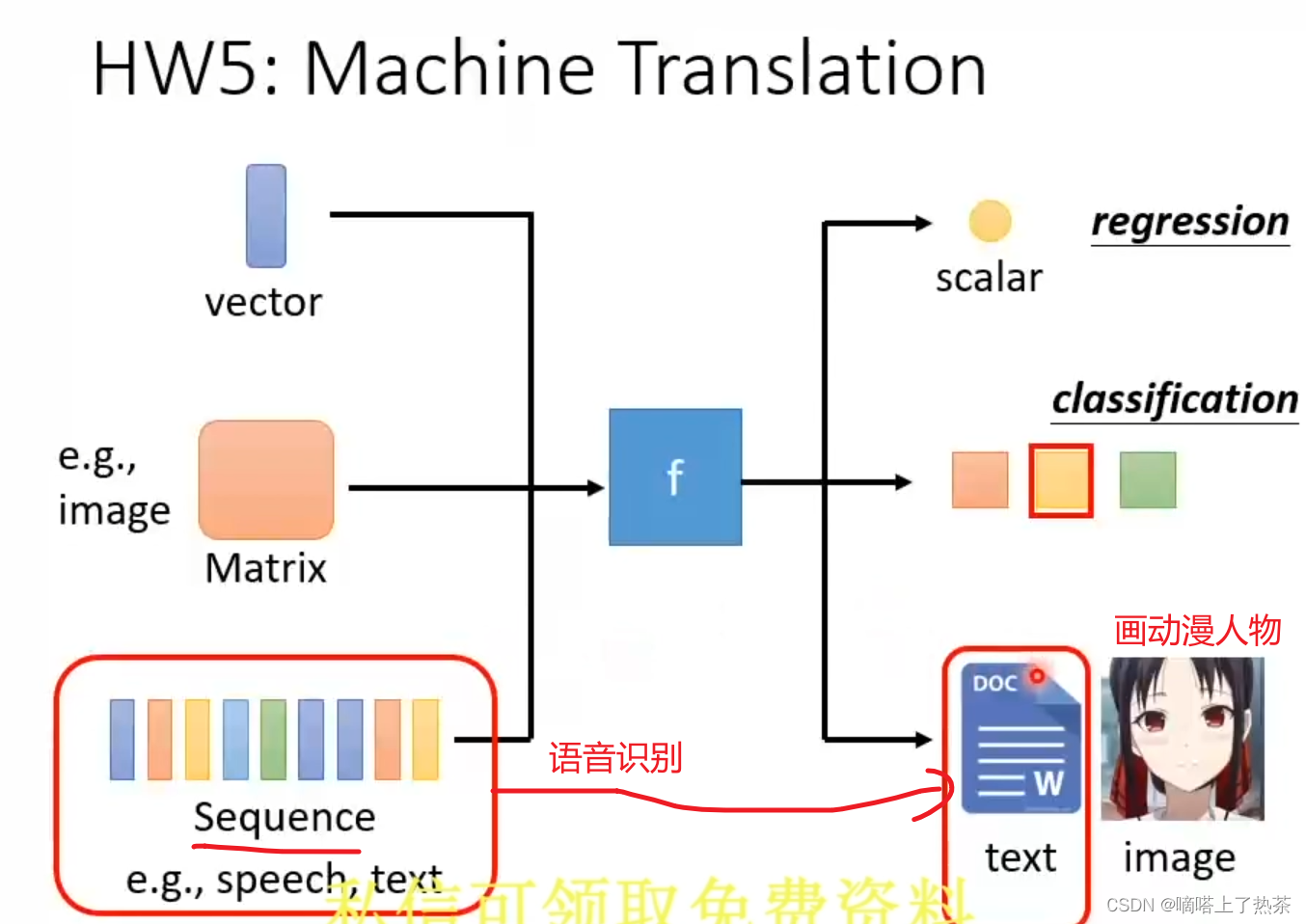

Machine Learning 约等于 Looking for Function(找到一个最优的函数)

eg:

- Speech Recognition 语音识别

- lmage Recognition 图像识别

- Playing Go (下围棋 下一步棋该如何走)

1.2 机器学习的分类

大体分为三类:

-

regression

-

classification

-

其他(语音识别,画图)

1. 机器学习

1.1 什么是机器学习(Machine Learning)?

Machine Learning 约等于 Looking for Function(找到一个最优的函数)

eg:Speech Recognition 语音识别

lmage Recognition 图像识别

Playing Go (下围棋 下一步棋该如何走)

1.2 机器学习的分类

大体分为三类:

-

regression

-

classification

-

其他(语音识别,画图)

还有一些机器学习类别/对模型的检验:

-

Supervised Learning eg:使用带标签的数据进行训练

-

Self-supervised Learning 在自监督学习中,用于预训练的任务被称为前置/代理任务(pretext task),用于微调的任务被称为下游任务(downstream task)

-

Reinforcement Learning (RL)强化学习

-

Anomaly Detection

-

Explainable AI eg:宝可梦和数码宝贝图片识别,model性能在测试集上表现十分好,但是经过Explainable AI发现所有的宝可梦图片是png,数码宝贝图片是jpeg。这样的model没有太大的意义。

-

Model Attack eg:猫的图像识别。训练好的模型在猫的图片检测到这张图片是猫的可能性是95%,但是把猫的图片进行细微改动(人眼看不出两张图片有任何不同),但是模型检测修改后的图片是猫的可能性变为0。

-

Domain Adaptation eg:黑白手写数字集改成彩色手写数字集 模型性能下降

-

Network Compression eg:减少一些不重要的参数(个人理解)?

-

Life-long Learning(终生学习)提出疑问:为何机器不能进行终身学习?

-

Meta Learning 机器自己写算法来进行分类等任务(不需要人类给予算法);Few-shot learning is usually achieved by meta-learning,Few-shot学习通常是通过元学习实现的。

-

Different types of Functions

-

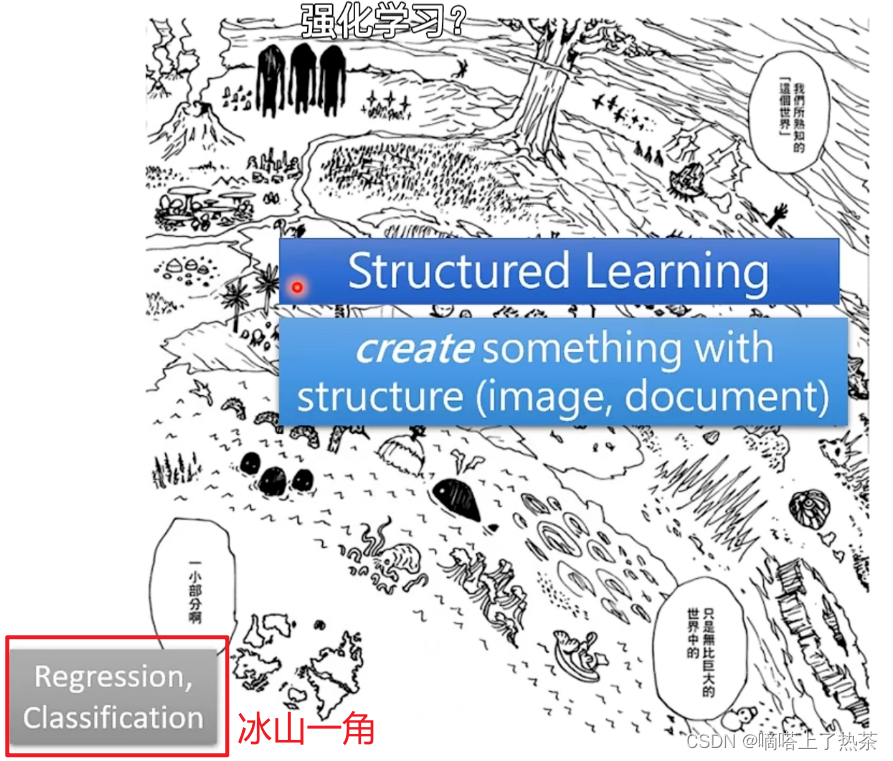

Structured Learning

2.机器学习/深度学习的步骤

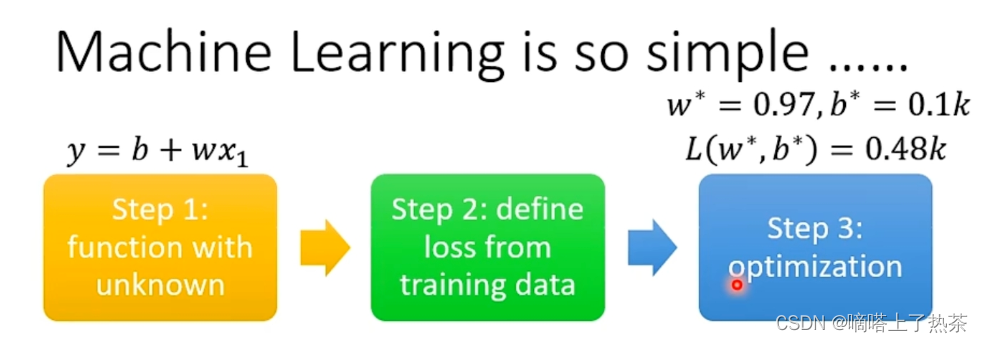

机器学习的一般步骤:

- 定义未知函数(model)

- 定义损失函数

- 优化未知函数(model)

举一元线性回归预测股票的例子来说明这三步的关系,首先先定义一元线性函数y=ax+b,这个y就是未知函数(model),使用均方误来当损失函数,即真实值(y)和预测值(y^)之间差值的平方当做损失函数,使用梯度下降进行model优化(也就是参数更新)。梯度下降终止的条件可以是达到一定次数(epoch),或者当平方误差小于一个数。

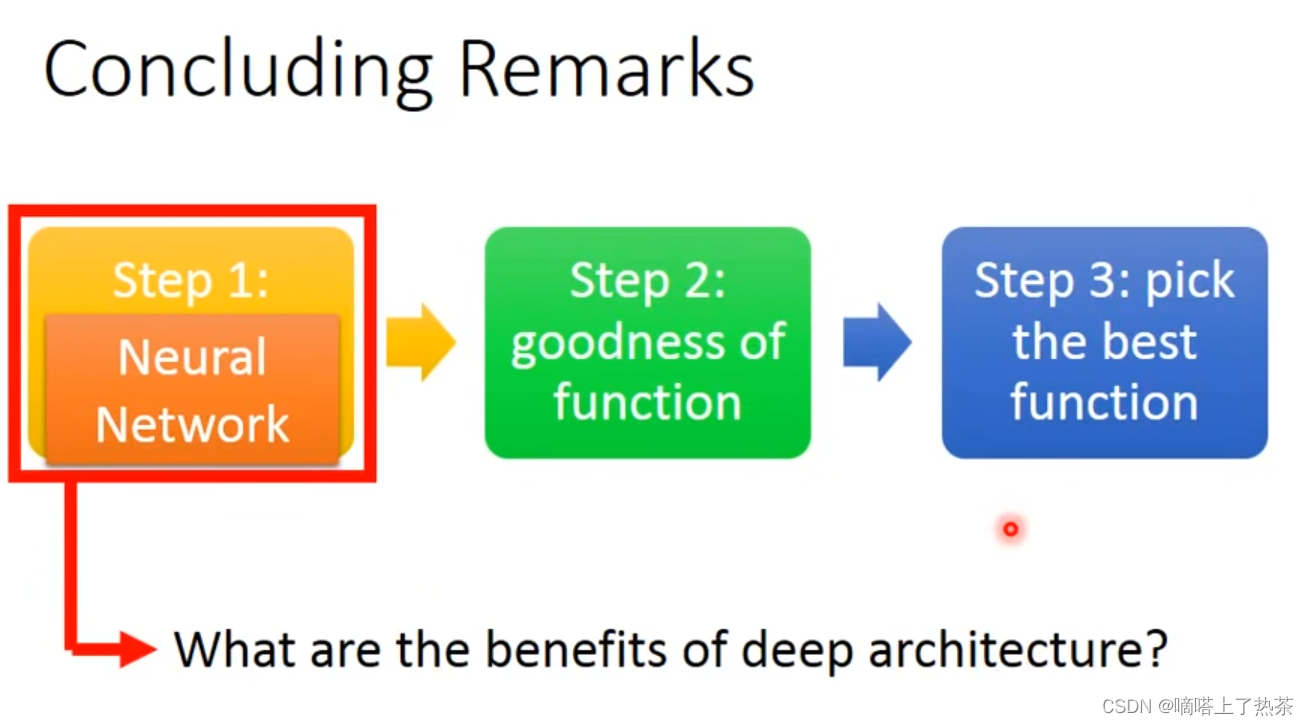

深度学习和机器学习基本一样。

NN的结构(structure)十分重要,决定着是否能找到一个好的function。

3. 深度学习基础

3.1 常见名词/概念

-

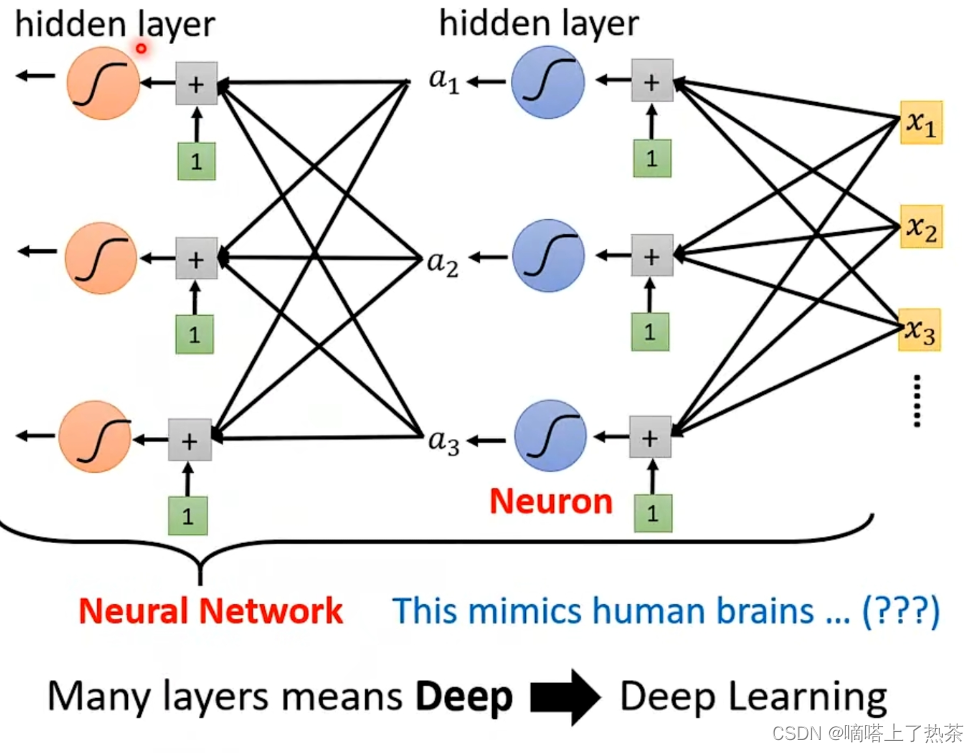

deep =many hidden layer

-

layer =many neuron

-

理论上,任意函数都可以由多个激活函数(relu)来拟合(即使用一层神经网络,多个神经元),那为何还要用深度学习deep(即使用多层神经网络)?后面会讲到

-

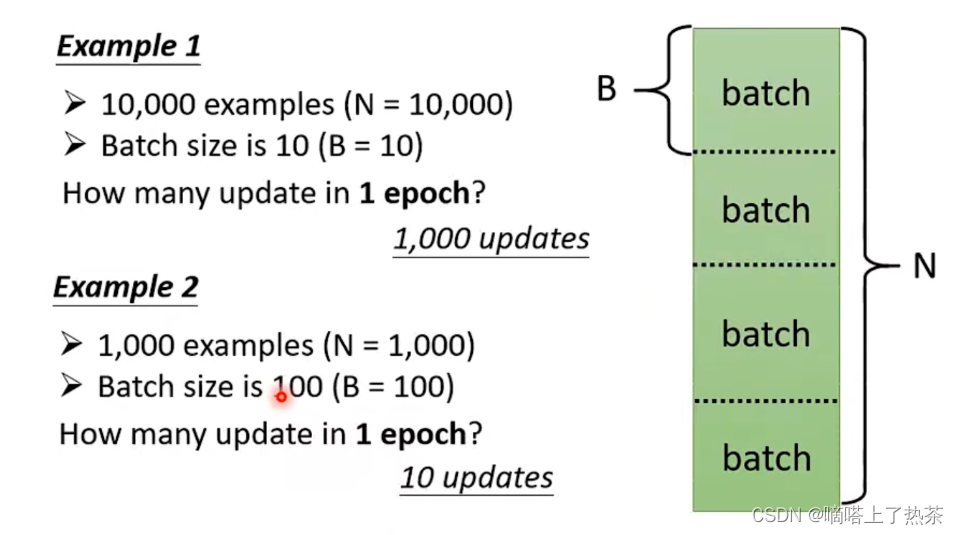

一次update :是指所有参数更新一次

-

一次epoch :是指使用所有batch样本(随机每个batch中的一个也行)使用一遍

-

样本的batch是超参数(hyperparameter)

-

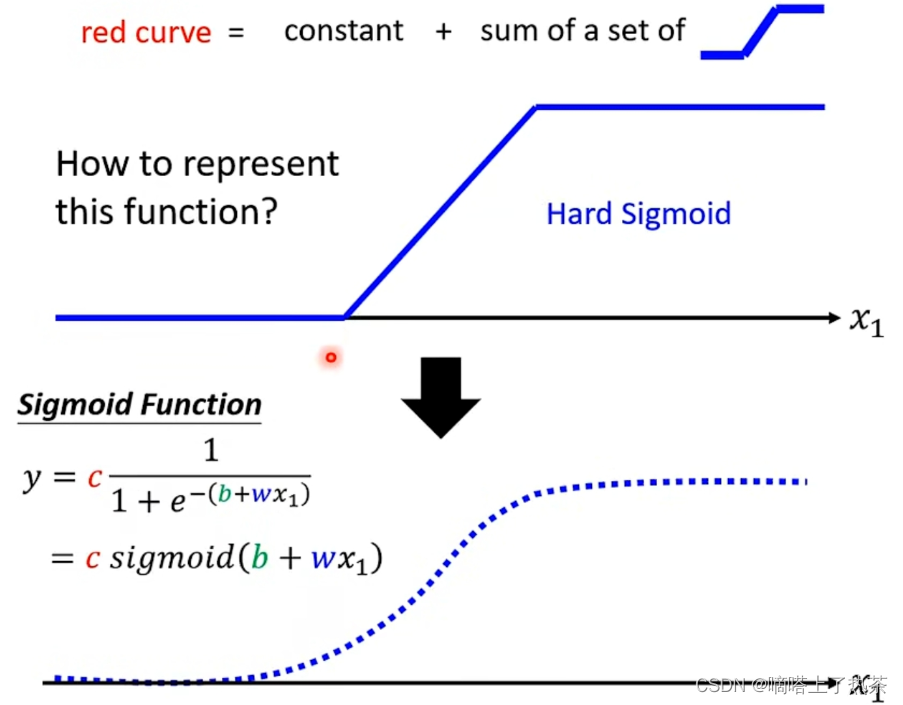

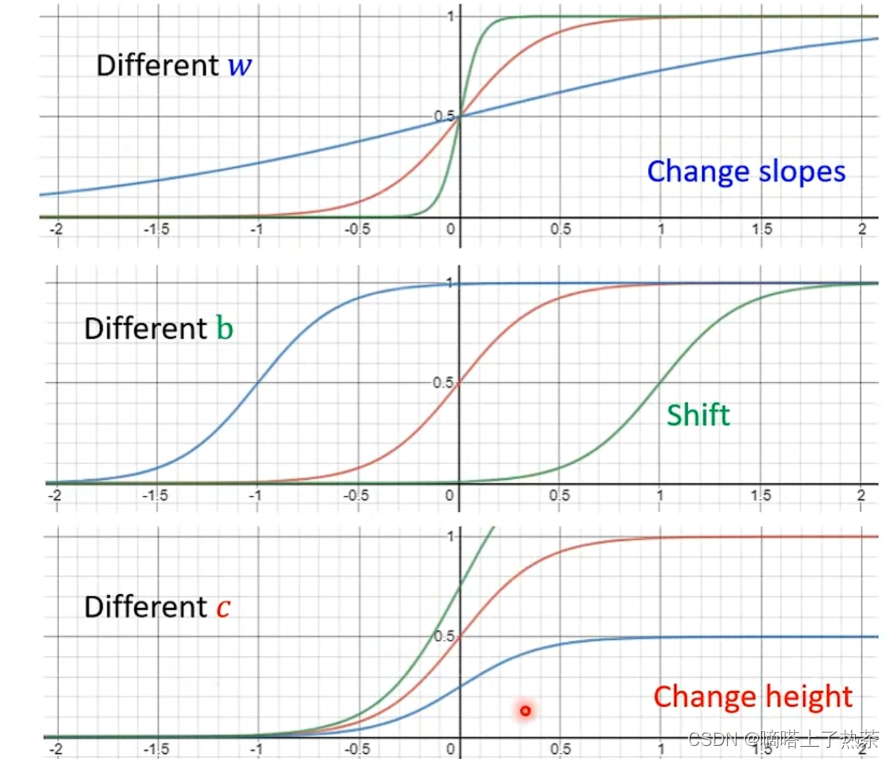

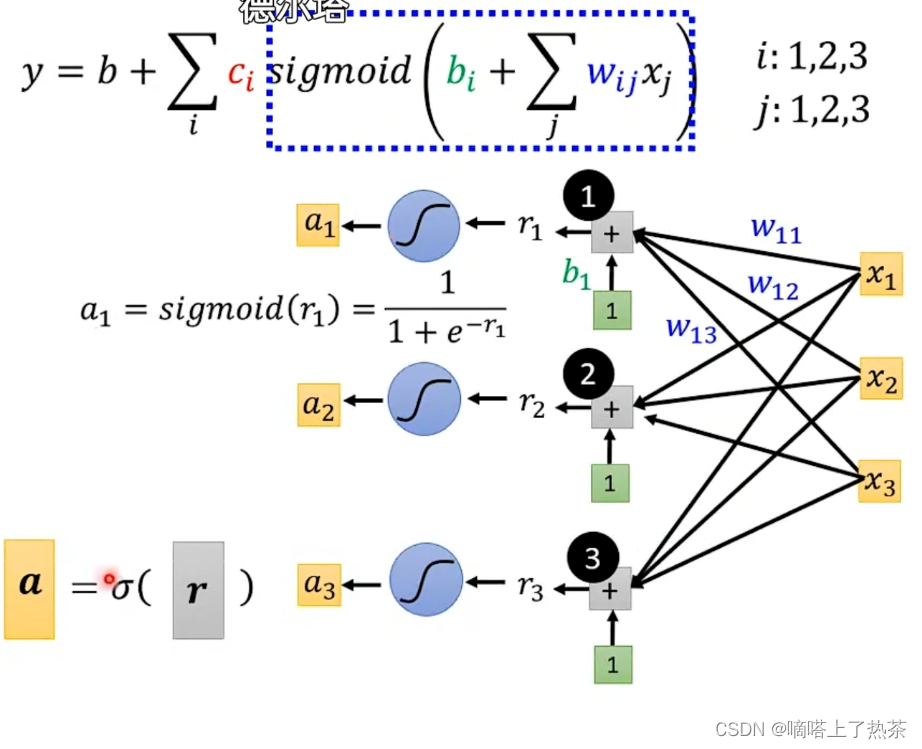

sigmoid函数和性质

调整上图函数的c ,b ,w得到不同的函数

-

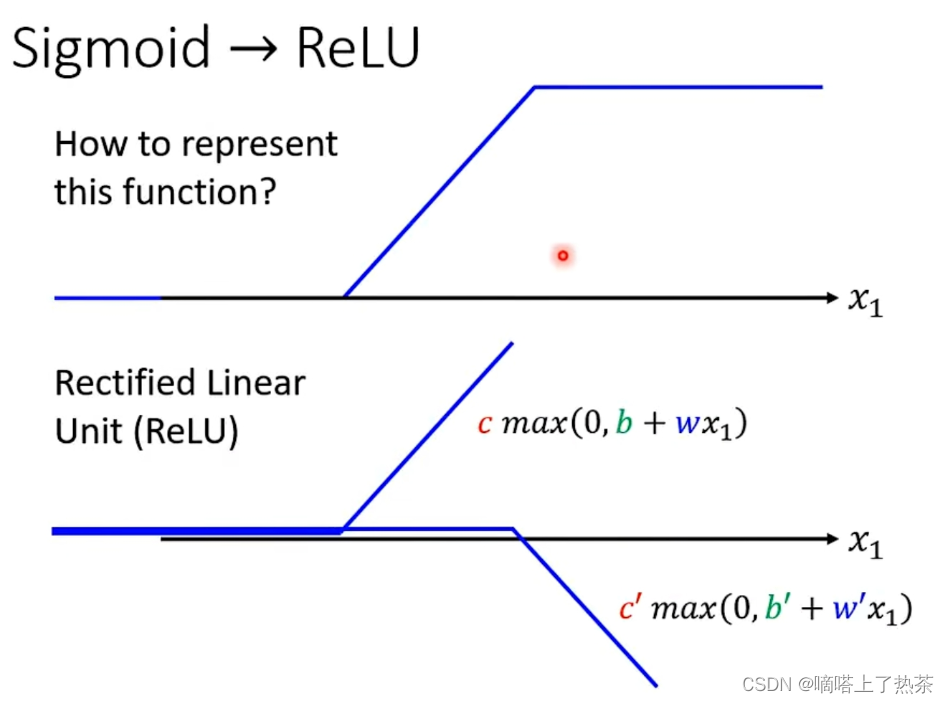

sigmoid和ReLU函数的关系:一个Hard sigmoid等于两个ReLU相加

-

全连接网络

例如下图中,所有的input都通过一个weight和bias输入到每一个神经元中。

如果是m层,将第n层的全部输出结果再通过weight和bias输入到下一层的每一个神经元中,依此类推。(m>n)

3.2 Gradient Descent(梯度下降)

3.2.1 梯度下降的缺点

梯度下降 gradient descent 终止迭代的条件:

- 设定次数(没有耐心的)

- 损失最小 (也就是导数为零的点,最终不需要调整梯度/斜率)

gradient descent 显而易见的缺点:有时只能找到局部local最优解,不是全局global最优解,但这不是gradient descent最大的问题,最大的问题是啥? 留下疑问,还未学到。

3.2.2 梯度下降更新参数

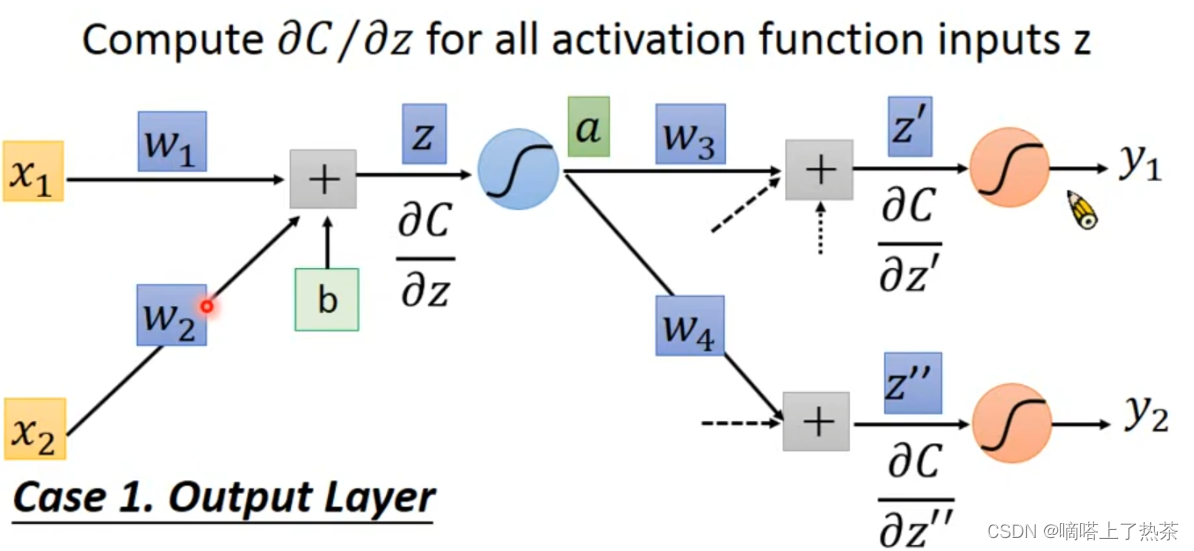

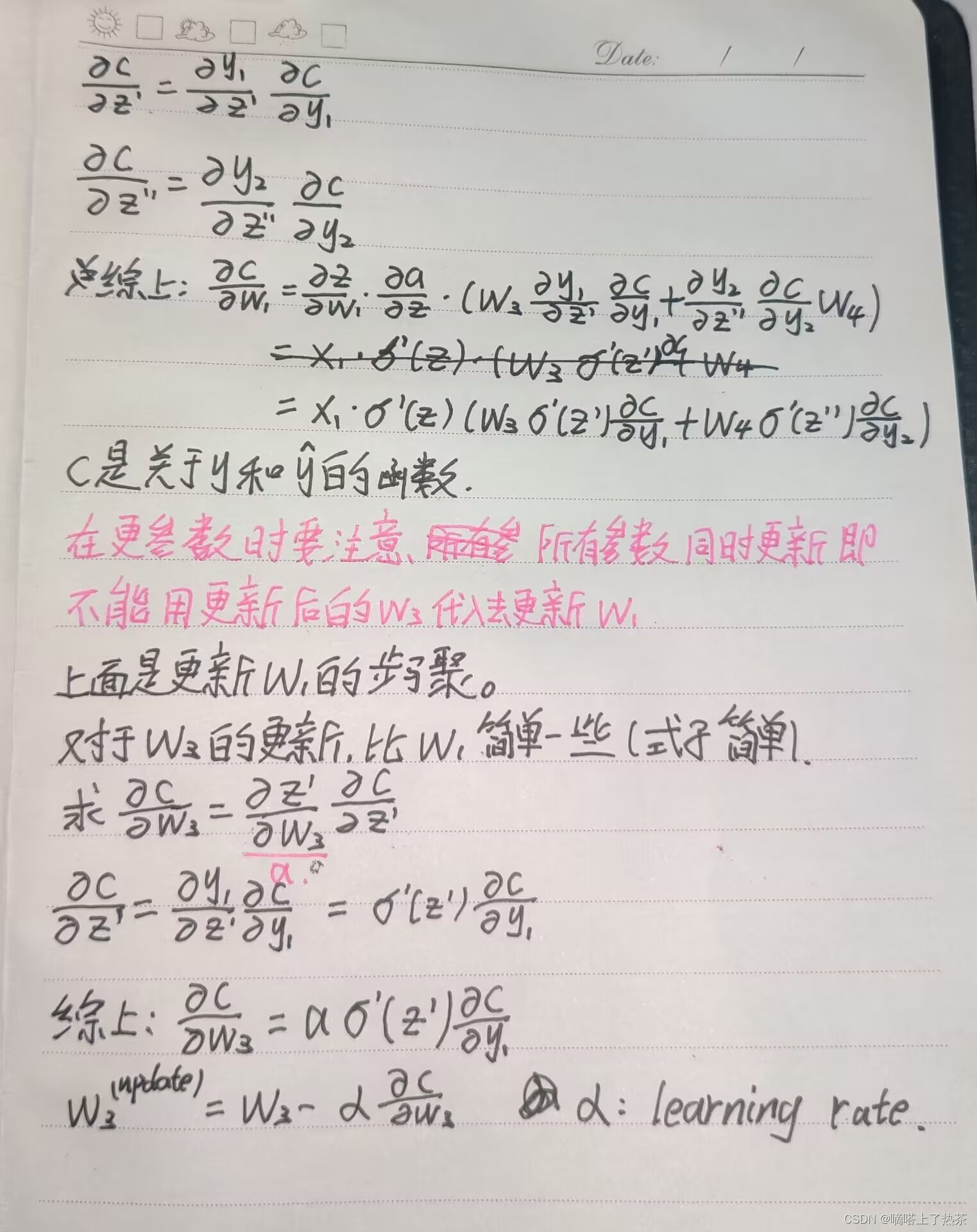

以下面的图为例简要推导前向传播和反向传播的过程。

- 前向传播(预测)

- 反向传播(更新参数)

8万+

8万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?