意义

意义在于:熟悉函数梯度饱和点,方便从向量上看出哪里出现了梯度消失。

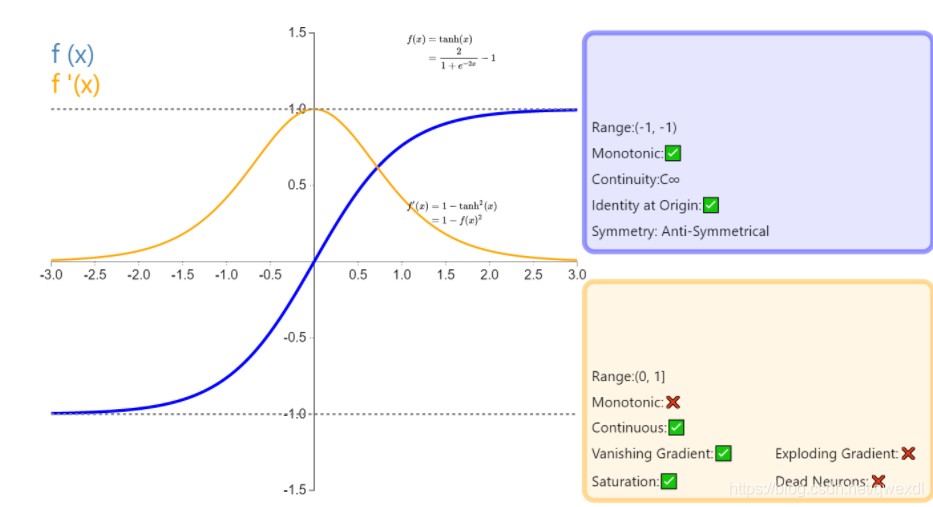

1. tanh

1.1 图像

1.2 调用

tf.nn.tanh

1.3 适用

比较常用的激活函数.

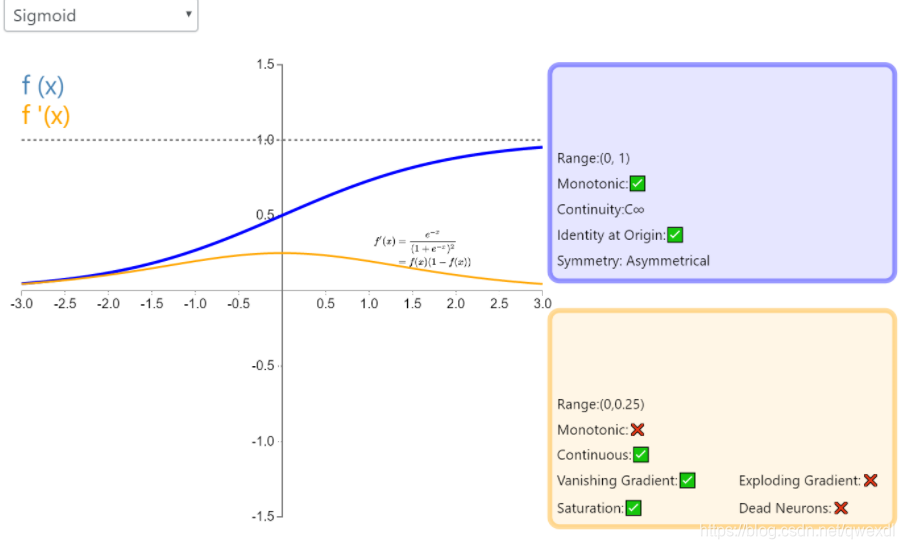

2. sigmoid

2.1 图像

注意:当值>=3时,就已经趋向于饱满了。

2.2 调用

tf.nn.sigmoid

2.3 适用

一般用于二分类问题中.

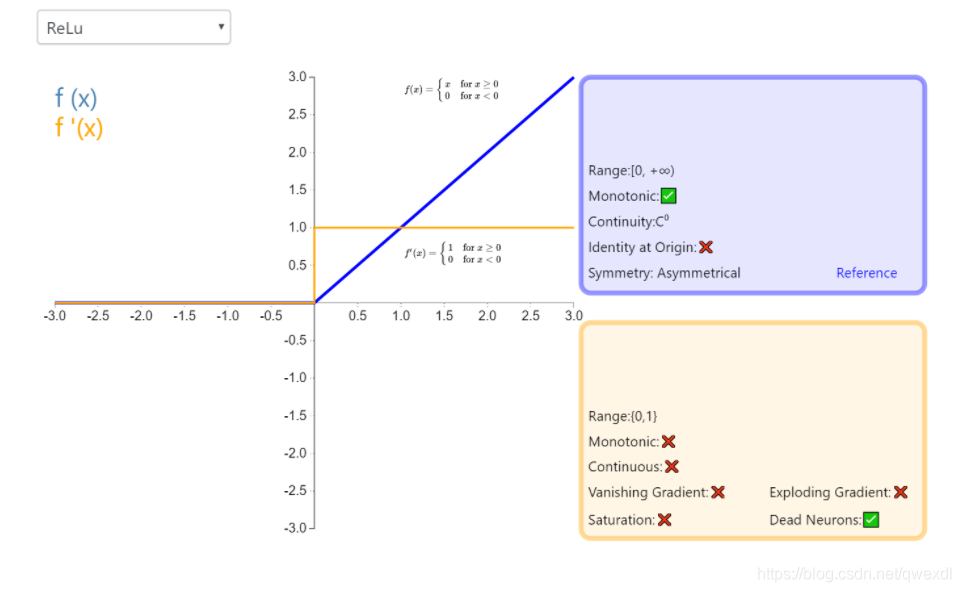

3. relu

3.1 图像

3.2 调用

tf.nn.relu

3.3 适用

如果向量中存在大量0,或者大量负数,可以考虑舍弃。

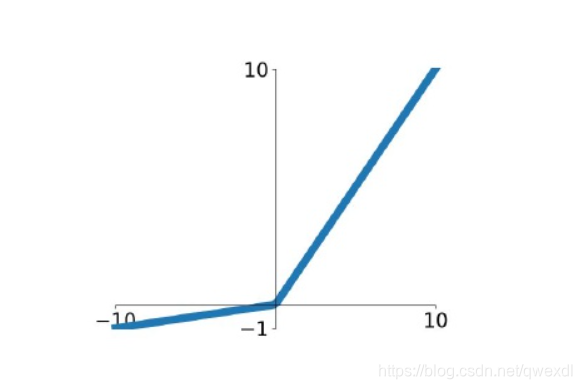

4. Leaky ReLU

4.1 图像

4.2 调用

tf.nn.leaky_relu

其中alpha参数表示负数时的梯度,默认是0.2。

4.3 适用

不可避免得出现大量的0和负数,没有普遍适用是因为:一般情况下,没有relu简单。

758

758

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?