线性回归简单介绍

1.回归模型概述

1.1 回归分析

变量X、Y之间存在某种密切但并非严格的函数关系。

其中,回归就是处理两个与两个以上变量之间互相依赖的定量关系的一种统计方法和技术。简单来说,就是通过一定概率分布描述变量之间的函数关系。

就好像,父亲身高较高的孩子,身高一般都不会低一样。两者有时候会进行一定的关联。但是却没有严格的划分。但是,回归并没有这么简单。假设上面说的那样,那么高的人越来越高,矮的人看上去越来越矮。它会遵循一定的约束力,使得会徘徊回归在中心位置上。

线性与非线性

线性的严格定义是一个严格的映射关系,其关系满足可加性和其次性,在平面坐标系体现的是一条直线。不满足线性即为非线性。

线性回归

如果只有一个自变量和一个因变量,则被称为一元线性回归。

期一般形式包括确定性关系和随机误差。

随机误差包括:影响因素确实、观测误差、其他随机的误差。

几个基本假设

1.2 回归建模模型

建立回归模型的流程如下:

-

需求分析明确变量:实际的需求,并且来确定因变量,以相关知识来取之有关的变量作为自变量。

-

数据收集加工:数据收集加工在于将收集到的数据进行清洗、加工并且根据数据情况调整解释变量,判断是某满足基本假设。

-

确定回归模型:了解数据集,使用绘图工具绘制变量样本散点图或者其他分析工具分析变量间的关系,根据结果选择回归模型。比如先线性回归模型,指数形式的回归模型等等。

-

模型参数估计:基于收集、整理的样本数据,估计模型中的相关参数。首先最常用的方法就是最小二乘法,在不满足基本假设的情况下使用岭回归、主成分回归等等。最小二乘法即通过最小化误差的平方和寻找数据的最佳函数匹配的方法。

-

模型检验优化:得到后的模型需要对模型进行统计意义上的检验。比如:回归方程的显著性检验、回归系数的显著性检验、拟合优度检验、异方差检验等等

-

模型部署应用:模型检测通过之后,使用模型进行相关的分析与应用。它包括因素分析、控制、预测等。

回归模型的特点:

- 模型简单

- 有坚实的统计理论支撑

- 定量分析各变量之间的关系

- 模型预测结果可以通过误差分析精确了解

缺点:

- 假设条件比较多且相对严格

- 变量选择对模型影响较大

2.一元线性回归

2.1 回归模型参数估计

回归方程从平均意义上表达的是变量y与x的统计规律性,其主要任务就是通过n组样本观察值,对回归常数和系数进行估计,得到最终方程。

2.2 参数估计

其中,对于参数估计而言,最常使用的是最小二乘估计。

最小二乘法

对于非负二次函数而言,求最小时主要是进行求导计算。得到后续的公式如下:

最大似然估计

它利用总体的分布密度或者概念分布的表达式及其样本所提供的信息求未知参数估计量的一种方法。其思路在于已知样本符合某种分布,但是分布具体参数未知。通过实验估算分布的参数。

其应用场景可以举一个小例子。比如说,甲和乙分别射中靶心的概率分别是0.8和0.6。一次甲和乙在进行射击时,有一个子弹射中靶心,问这个射中靶心是甲的概率是多少?

最大似然估计解决的是”模型已定,参数未知“的问题。就是已经发生一件既定的事实,问出现某一种情况的概率,或者参数最可能的取值。

无偏估计&有偏估计*

无偏估计就是用样本统计量来估计总体参数时的一种无偏推断,估计量的数学期望等于估计量的真实值。反之,有偏估计具有系统性偏差。

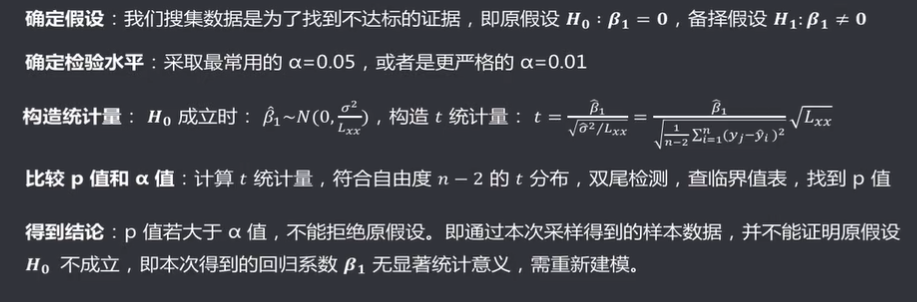

2.3 回归模型的显著性检验

回归系数是否显著:t检验

因变量与自变量之间是否存在线性关系,即回归系数是否等于0,。此时使用t检验进行判断。t检验适用如下:

回归方程是否显著:F检验

F检验是根据平方和分解式,直接从回归效果检验回归方程的显著性。由平方和分解式可以得到SSR越大,回归效果越好。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-S9preXfW-1626438235824)(…/…/…/…/…/AppData/Roaming/Typora/typora-user-images/image-20210712182852961.png)]

其次,构造F检验计算:

相关系数显著性检测:t检验

相关系数指的是变量之间线性相关程度的量,一般用字母r表示。其中皮尔逊相关系数比较常用表示。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-c3X75IPt-1626438235825)(…/…/…/…/…/AppData/Roaming/Typora/typora-user-images/image-20210712183643168.png)]

2.4 残差

对于一元线性回归而言,真实值与回归拟合值的差称为残差。

其中,以自变量x为横轴,残差为纵轴制作残差图来辅助对数据质量进行分析。如果一个模型满足所给出的基本假定,残差应该在0附近随机变化且变化的幅度不大。因为残差在残差图是以纵轴存在的。残差越小越说明拟合的效果越接近真实值。

比如以下的几个例子。

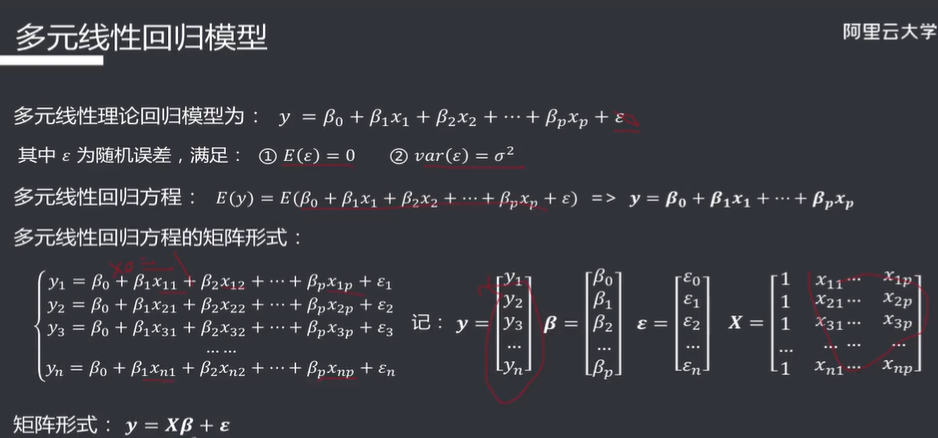

3.多元线性回归

多元线性回归模型跟一元线性回归之间的区别在于,是y与多个自变量之间的关系。本内容对多元线性的讲解较为简略。

众所周知,线性回归通常需要参数估计。在多元线性回归中也常常使用最小二乘法。

除此之外,还有最大似然估计的方法等等。

回归方程的显著性检测:

F检验:多元线性的区别在于原假设要求回归方程全部都为0,一元线性只要求一个回归方程为0即可。

4.回归模型的基本假设

线性回归的几个基本前置假设条件:

- 零均值

- 同方差

- 无自相关

- 正态分布

- 解释变量

- 解释变量之间不存在精确的线性关系

- 样本个数多于解释变量个数

常见的不满足基本假设情况:

1.异方差

异方差就是随机误差项的方差不是一个常数,而是随着自变量取值变化的值。

它在于不满足回归分析中的同方差的前提假设,异方差可能带来很多的问题。

- 显著性检验失效

- 回归方程应用不理想

其常见成因在于以下因素:

- 模型缺少某些解释变量,缺省变量本身的方差被包含在了随机误差的方差中。

- 模型本身选取有误,比如原本是非线性的,却使用了线性模型

- 样本量过少

- 测量误差

- 异常数据

- 时序分析或者使用面板数据(忽略时间的因素)

异方差的检验

残差图分析

坐标选择、判断:随机分布、无规律

等级相关系数法

等级相关系数法可以具体看后面的视频:违背基本假设-2 - 机器学习算法详解 - 阿里云全球培训中心 - 官方网站,云生态下的创新人才工场 (aliyun.com)

其他常见的检验

消除异方差

常见的消除方法有:加权最小二乘法、BOX-COX变换法、方差稳定性变换法。

2.自相关

顾名思义,就是指变量前后的数值之间存在相关关系。

自相关带来的以下问题:

常见成因:

- 模型遗漏关键变量,被遗漏变量在时间顺序上存在相关性

- 错误的回归函数形式

- 蛛网现象

- 数据加工整理人为带来的错误

检验方法:

图示检验法、自相关系数法、DW检验法

消除自相关

迭代法、差分法、BOX-COX变换法

3.异常值

标准化残差、删除残差、学生化残差

5.自变量选择

如果一个因变量受到m个因素影响,建模时选取所有的因素则成为全模型;若只选出其中若干个因素建模则称为选模型。

自变量选择的影响:

- 未选入的因素参数不全为0

- 选模型预测结果有偏预测

- 选模型参数估计、预测残差有较小的方差

自变量选择方法

前进法、后退法、逐步回归法

6.多重共线性

多重共线性是指:线性回归模型中解释变量之间由于存在精确相关关系或者高度相关关系而使得模型估计失真或者难以估计准确。

多重共线性诊断

- 直观判定法

- 方差扩大因子法

- 特征根判定法

消除多重共线性

- 删除一些不重要的解释变量

- 增大样本量

- 回归系数有偏估计

以上是简单的线性回归介绍。谢谢大家

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?