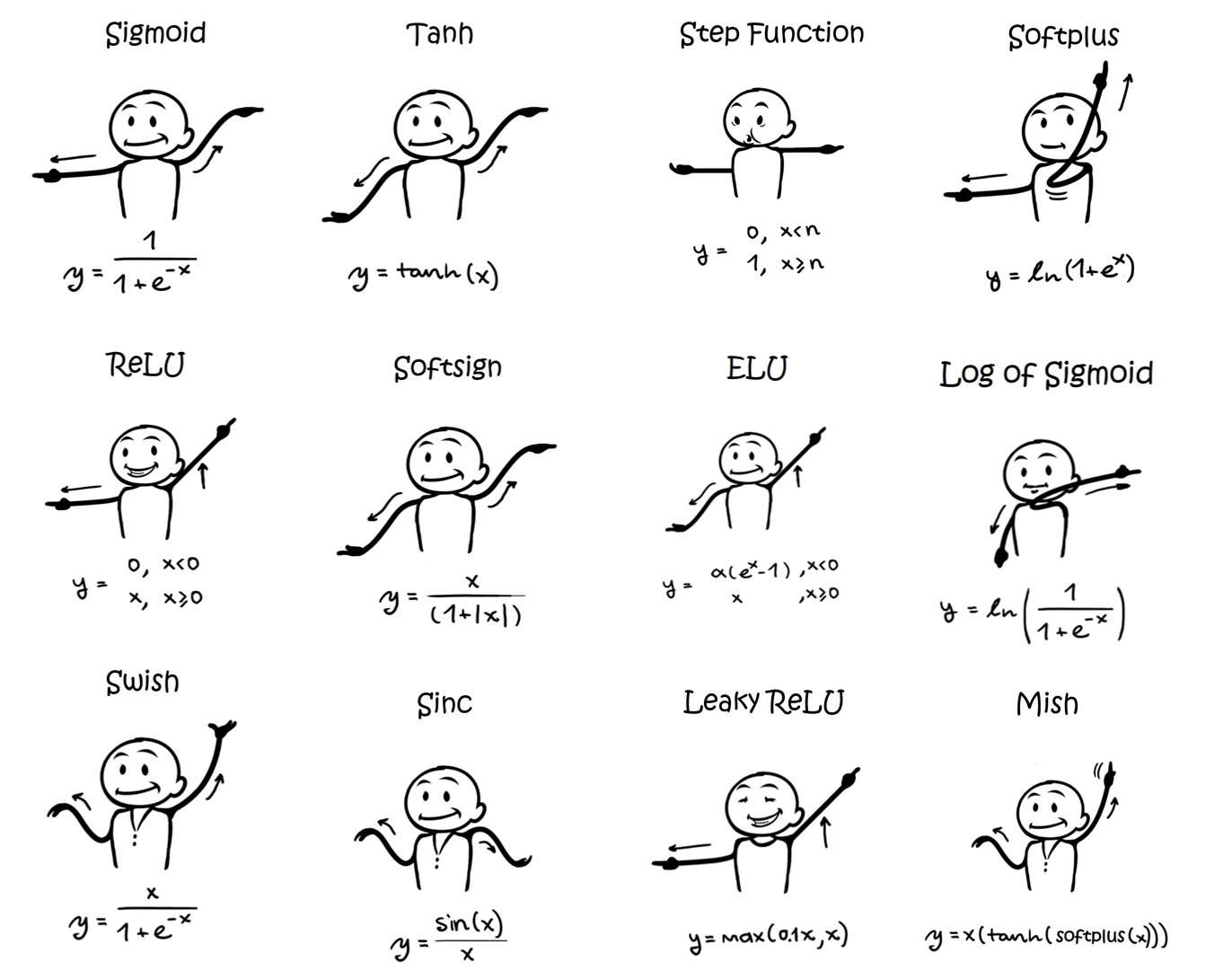

常见激活函数

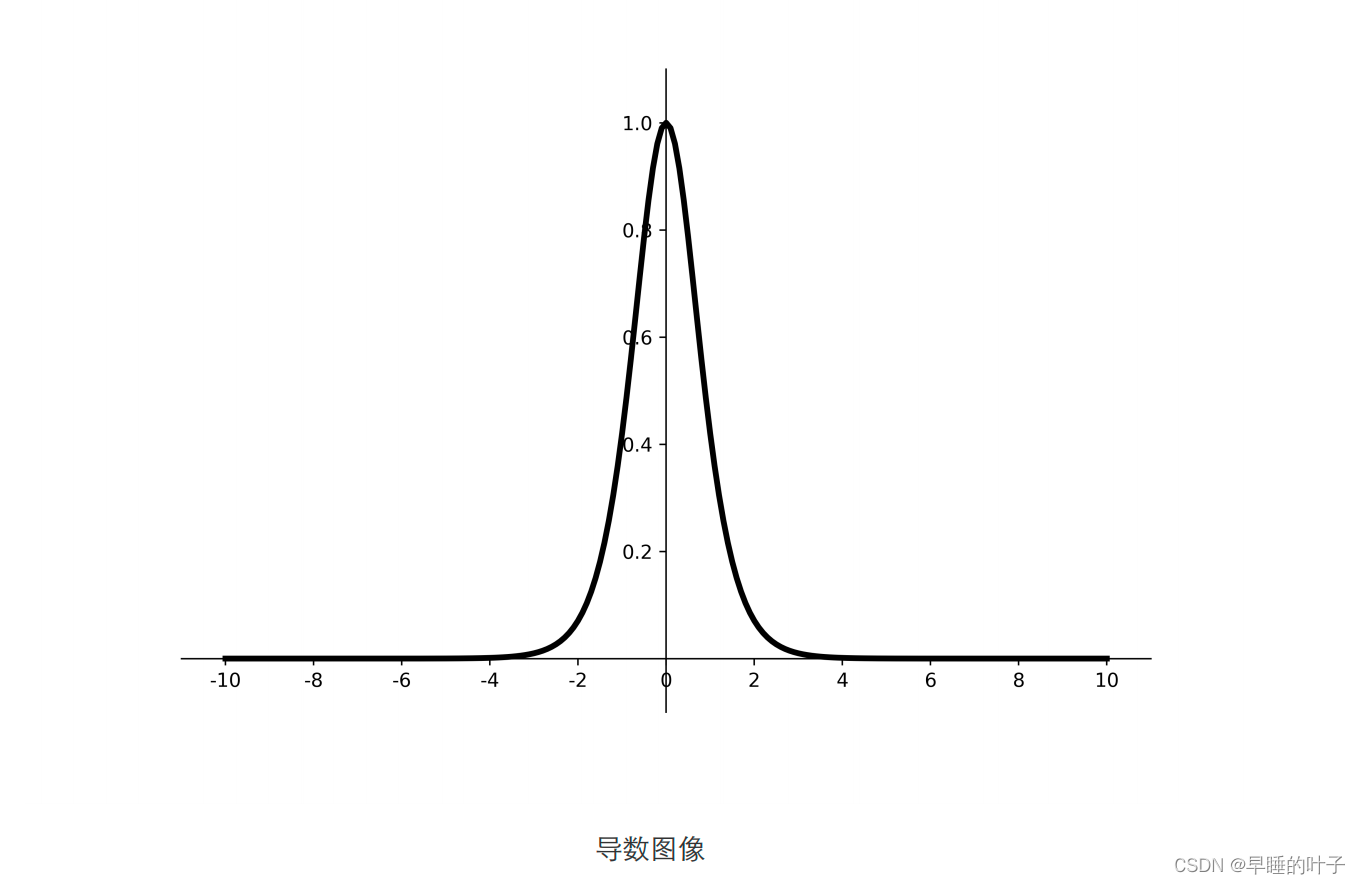

- Sigmoid激活函数

- Tanh激活函数

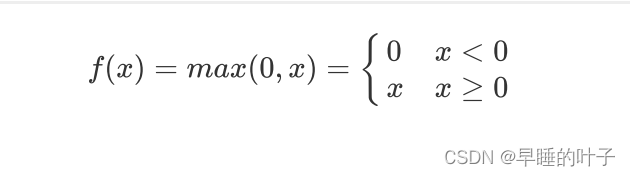

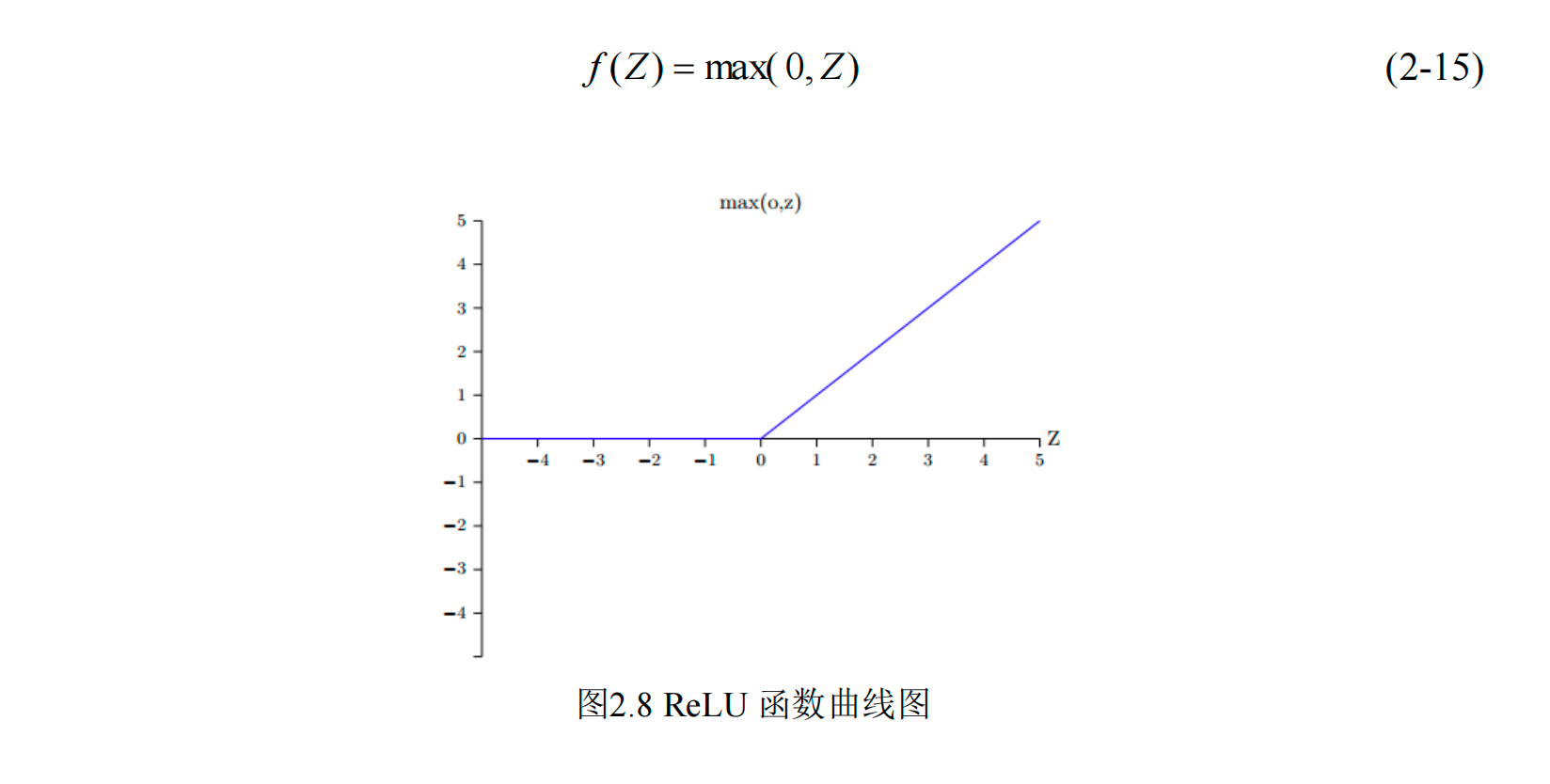

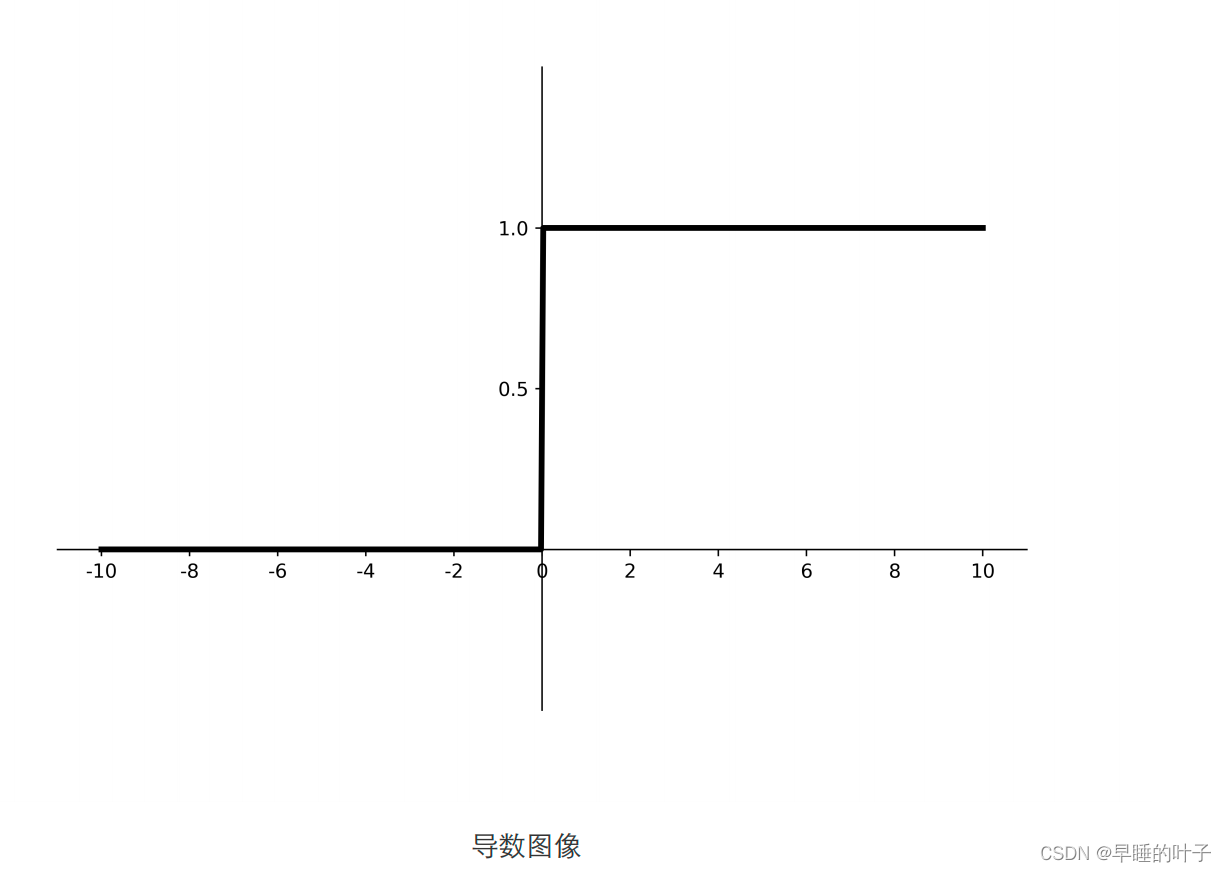

- Relu激活函数

- Leaky Relu激活函数

- P-Relu激活函数

- ELU激活函数

- R-Relu激活函数

- Gelu激活函数

- swich激活函数

- Selu激活函数

图片引用自:Dance Moves of Deep Learning Activation Functions

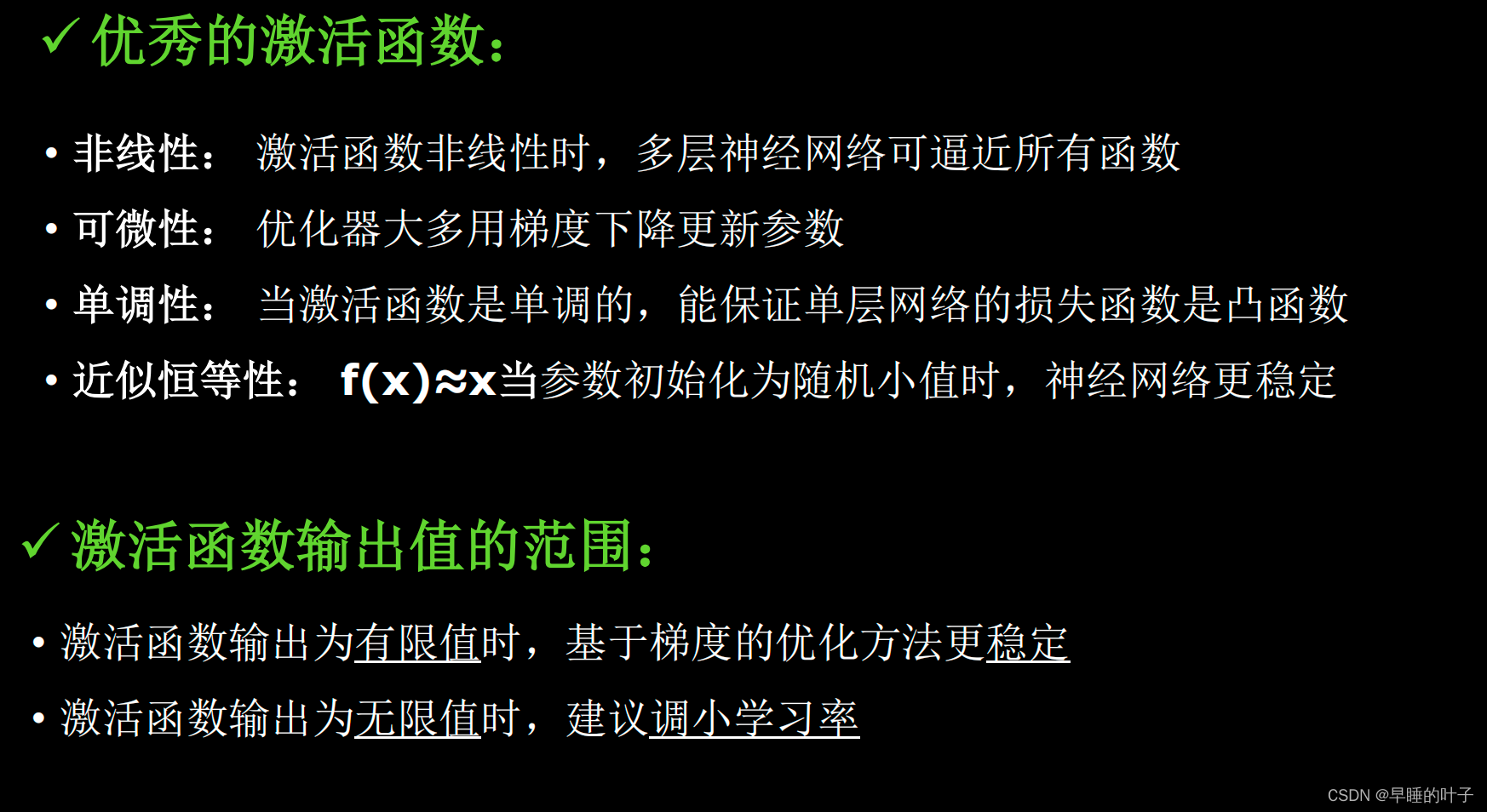

激活函数可以分为两大类 :

- 饱和激活函数:sigmoid、tanh

- 非饱和激活函数: ReLU、Leaky Relu、ELU【指数线性单元】、PReLU【参数化的ReLU 】、RReLU【随机ReLU】

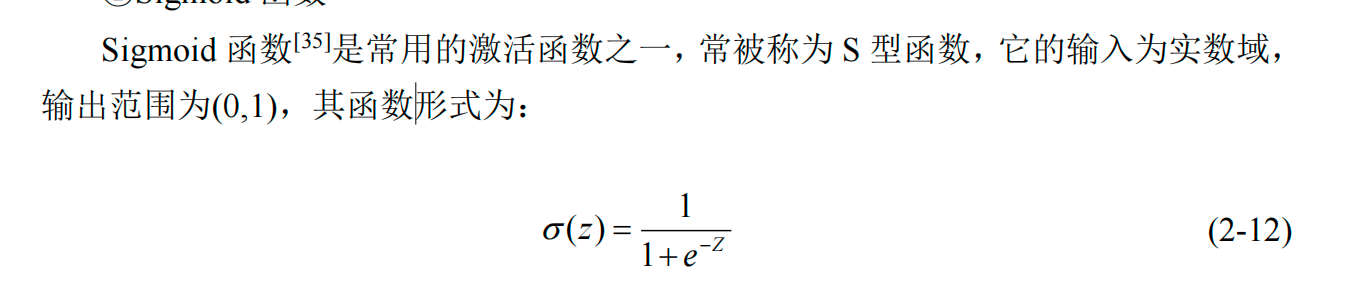

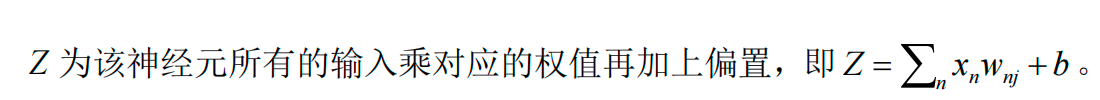

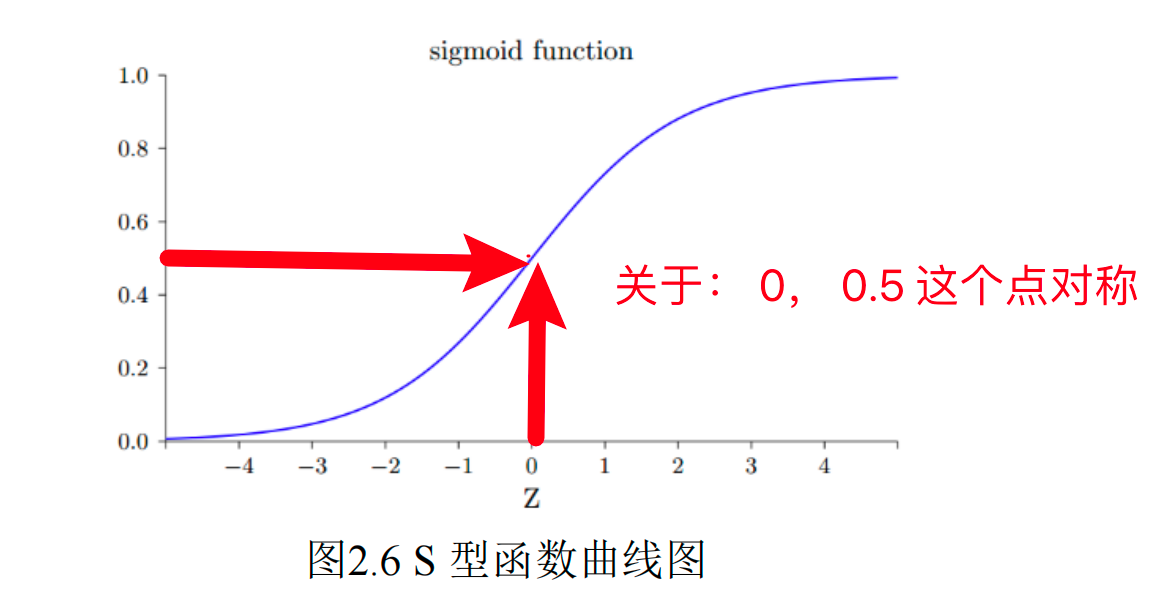

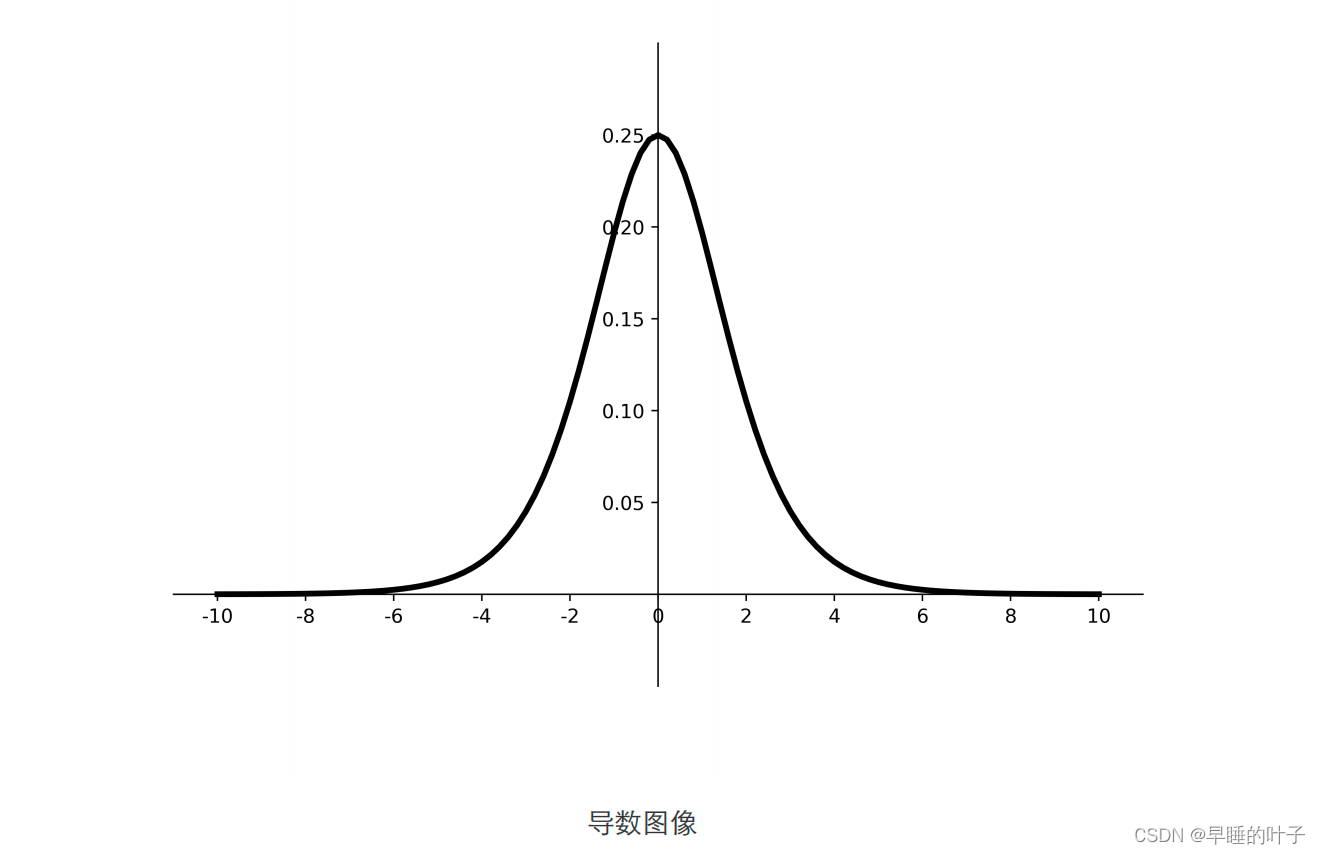

Sigmoid

可以将任何输入映射到0 - 1 之间,是一个阈值函数,近些年研究人员使用该函数的频率越来越低了,主要是因为:(缺点)

- 过饱和会丢失剃度,当输入非常大或者非常小,神经元的活跃度在0和1会饱和。这些地方的梯度趋近于零,导致该神经元的参数没有变化。

- 输出不是零均值的。影响梯度下降。

优点:

- Sigmoid 函数的输出范围是 0 到 1。由于输出值限定在 0 到 1,因此它对每个神经元的输出进行了归一化;

- 用于将预测概率作为输出的模型。由于概率的取值范围是 0 到 1,因此 Sigmoid 函数非常合适;

- 梯度平滑,避免「跳跃」的输出值;

- 函数是可微的。这意味着可以找到任意两个点的 sigmoid 曲线的斜率;

- 明确的预测,即非常接近 1 或 0

- 输出映射在(0,1)之间,单调连续,输出范围有限,优化稳定,可用作输出层;

- 求导容易。

缺点:

- 易造成梯度消失;

- 输出非0均值,收敛慢;

- 幂运算复杂,训练时间长。

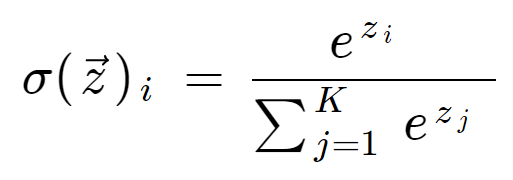

sigmoid函数可应用在训练过程中。然而,当处理分类问题作出输出时,sigmoid却无能为力。简

单地说,sigmoid函数只能处理两个类,不适用于多分类问题。而softmax可以有效解决这个问题,并

且softmax函数大都运用在神经网路中的最后一层网络中,使得值得区间在(0,1)之间,而不是二分类

的

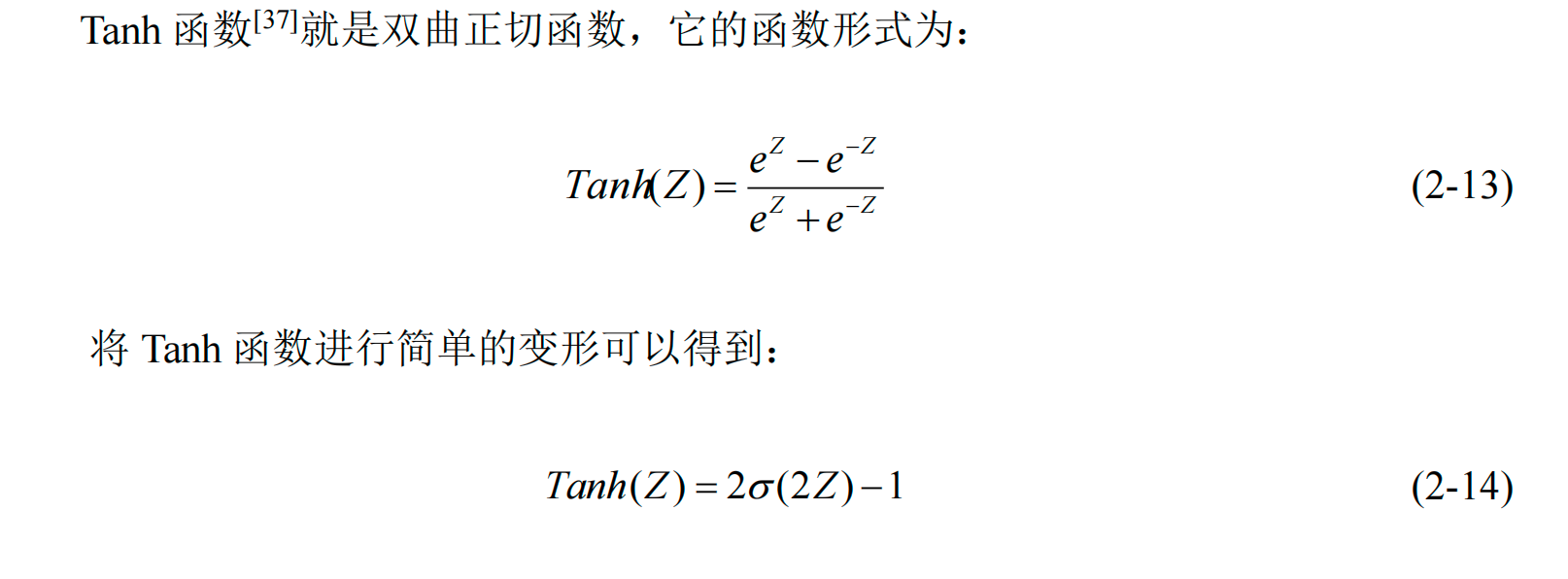

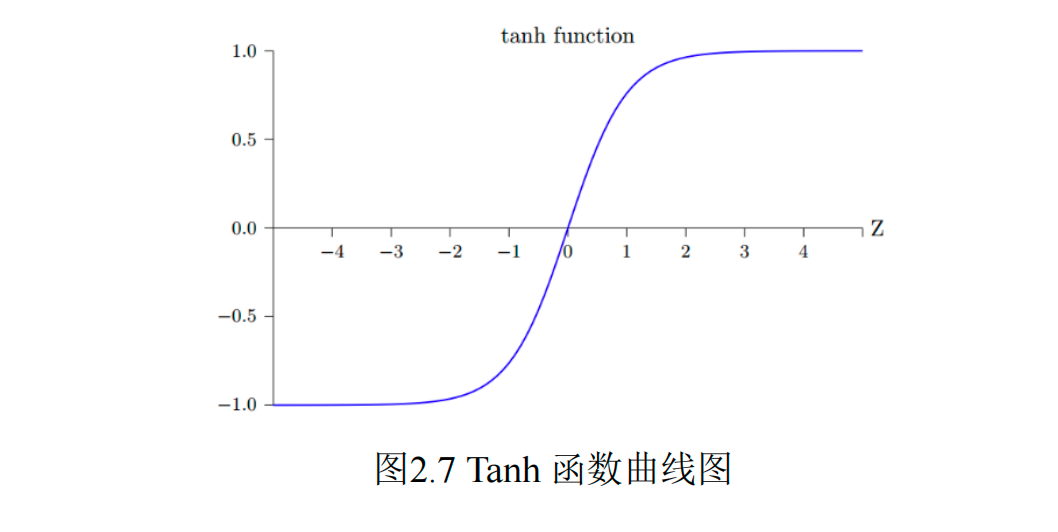

Tanh函数

输出的值域为: -1, 1。 是零均值的。

优点:

- 比sigmoid函数收敛速度更快。

- 相比sigmoid函数,其输出以0为中心。

缺点:

- 指数运算,计算速度慢。不适合嵌入式应用算法。

- 存在梯度弥散问题。

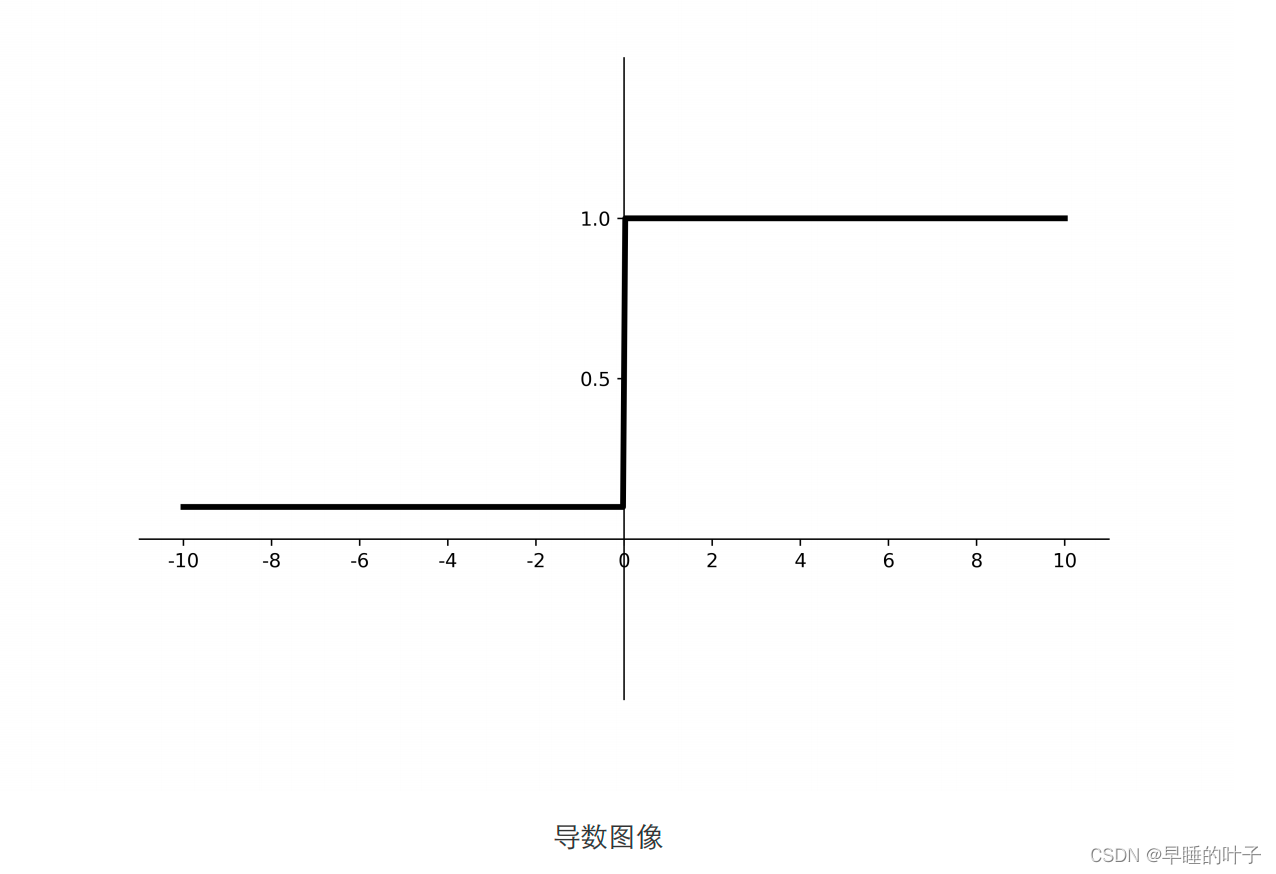

ReLU函数

近些年流行起来的激活函数。称之为修正函数:

该函数简单设置0为阈值,输出的范围为: [0, 正无穷]。

好处:

- 比前面二个函数有更快的收敛速度

- 前面的函数都是指数形式的,计算复杂,ReLU函数简单的设计为线性函数,

- 解决了梯度消失问题(在正区间);

- 只需判断输入是否大于0 算速度快;

- 收敛速度远快于sigmoid和tanh,因为sigmoid和tanh涉及很多expensive的操作;

- 提供了神经网络的稀疏表达能力

缺点:

- 神经元十分脆弱,可能在训练中变成无用的激活函数,大梯度经过ReLU可能会导致权值更新错误。

- 输出非0均值,收敛慢;

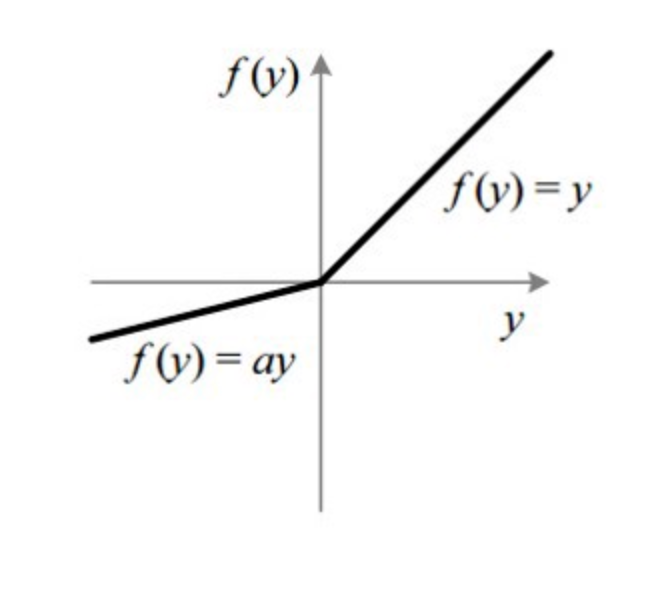

Leaky ReLU

理论上来讲,Leaky ReLU有ReLU的所有优点,外加不会有Dead ReLU问题,但是在实际操作当

中,并没有完全证明Leaky ReLU总是好于ReLU。

PReLU - Parametric ReLU

Softmax

对神经网络全连接层输出进行变换,使其服从概率分布,即每个值都位于[0,1]区间且和为1。

tf.nn.softmax(

logits, axis=None, name=None

)

| Args | |

|---|---|

logits | A non-empty Tensor. Must be one of the following types: half, float32, float64. 注意这里,输入必须为浮点数 |

axis | The dimension softmax would be performed on. The default is -1 which indicates the last dimension. |

name | A name for the operation (optional). |

选用激活函数建议

对于初学者的建议:

- 首选ReLU激活函数;

- 学习率设置较小值;

- 输入特征标准化,即让输入特征满足以0为均值,1为标准差的正态分布;

- 初始化问题:初始参数中心化,即让随机生成的参数满足以0为均值, 当 前 层 输 入 特 征 个 数 为标准差的

正态分布

4170

4170

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?