大型语言模型 (LLM) 一直处于生成式 AI 革命的前沿,尤其是自 ChatGPT 出现以来。然而,它们的全部潜力尚未得到释放,而一个重大障碍是成本。将 LLM 纳入应用程序的费用范围从按需用例的几美分到在云环境中托管单个 LLM 实例的每月 20,000 美元以上。此外,微调、训练、向量搜索和扩展也会产生大量成本。

在这篇博文中,我将探讨导致 LLM 应用程序费用的因素,并将成本分解为主要组成部分。

NSDT工具推荐: Three.js AI纹理开发包 - YOLO合成数据生成器 - GLTF/GLB在线编辑 - 3D模型格式在线转换 - 可编程3D场景编辑器 - REVIT导出3D模型插件 - 3D模型语义搜索引擎 - AI模型在线查看 - Three.js虚拟轴心开发包 - 3D模型在线减面 - STL模型在线切割 - 3D道路快速建模

1、分解 AI 和大模型的成本

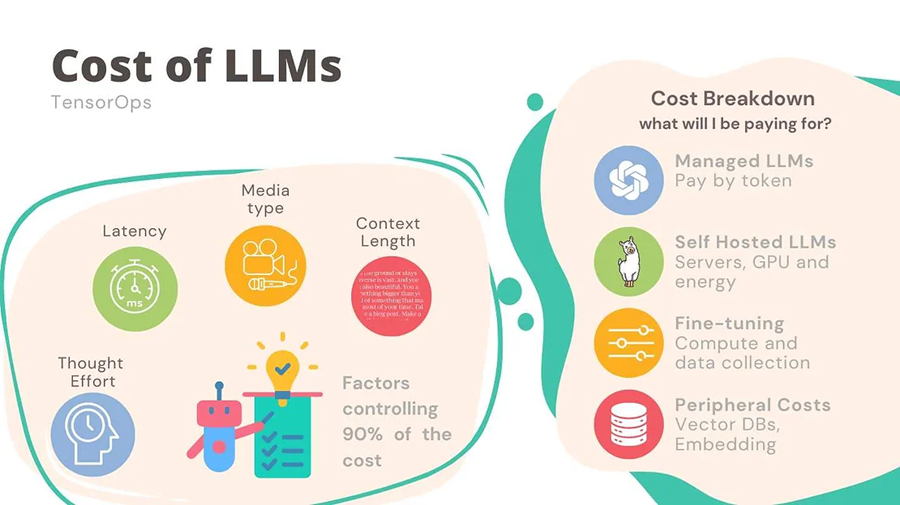

在分析 LLM 的成本时,考虑两个主要角度很有用:可能使 LLM 更昂贵的因素和所涉及的各个成本组成部分。让我们首先概述一下这些因素。

导致 LLM 和 AI 模型更昂贵的因素:

- 模型复杂度(思考努力):这指的是你希望模型有多复杂。提高模型的智能通常需要使用更复杂的架构或更大的模型,例如从 70 亿个参数扩展到 3000 亿个参数,或者在混合专家 (MoE) 模型中同时雇用更多专家。更高的思考努力会增加计算需求和成本。显然,更智能的模型更昂贵。

- 输入大小:你发送到模型和从模型接收的令牌数量会影响处理时间和计算资源。更大的输入和输出需要更多的处理能力,从而增加成本。输入和输出越多,你支付的费用就越多。

- 媒体类型:模型处理的媒体类型(无论是文本、音频还是视频)都会影响成本。由于数据量更大、复杂性更高,处理音频和视频通常比文本需要更多的资源。

- 延迟要求:你需要多快的响应会影响成本。更低的延迟需要更多的计算资源或优化的基础设施,而维护起来可能会更加昂贵。

LLM 和 AI 模型的成本 - 细分和组件

你如何支付运行 LLM 的费用?

通常,你会发现自己以两种主要方式之一支付生产中的 LLM 费用:

- 托管自己的基础设施:你可以构建和管理自己的基础设施来托管 LLM,无论是在本地还是在云中。例如

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?