参考文献:机器学习与数据挖掘参考文献

一、二项逻辑斯谛回归模型

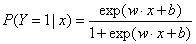

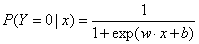

二项逻辑斯谛回归模型是如下的条件概率分布:

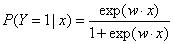

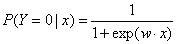

这里,x∈Rn是输入,Y∈{0,1}是输出,w∈Rn和b∈R是参数,w称为权值向量,b称为偏置,w·x为w和x的内积。有时为了方便,将权值向量和输入向量加以扩充,仍记作w,x,即w=(w(1),w(2),...,w(n),b)T,x=(x(1),x(2),...,x(n),1)T。这时,逻辑斯谛回归模型如下:

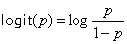

一个事件的几率是指该事件发生的概率与该事件不发生的概率的比值。如果事件发生的概率是p,那么该事件的几率是p/(1-p),该事件的对数几率或logit函数是

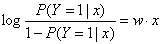

对逻辑斯谛回归而言,由上式得

这就是说,在逻辑斯谛回归模型中,输出Y=1的对数几率是输入x的线性模型。或者说,输出Y=1的对数几率是输入x的线性函数表示的模型,即逻辑斯谛回归模型。线性函数的值越接近正无穷,P(Y=1|x)的概率值就越接近1;线性函数的值越接近负无穷,概率值就越接近0。

二、模型参数估计

逻辑斯谛回归模型学习时,对于给定的训练数据集,可以应用极大似然估计法估计模型参数,从而得到逻辑斯谛回归模型。

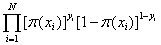

设P(Y=1|x)=π(x),P(Y=0|x)=1-π(x),似然函数为

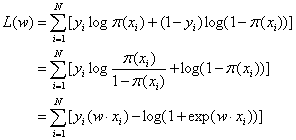

对数似然函数为

对L(w)求极大值,得到w的估计值。

这样,问题就变成了以对数似然函数为目标函数的最优化问题。逻辑斯谛回归学习中通常采用的方法是梯度下降法及拟牛顿法。

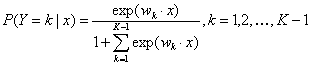

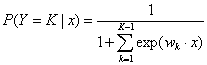

三、多项逻辑斯谛回归

假设离散型随机变量Y的取值集合是{1,2,...,K},那么多项逻辑斯谛回归模型是

这里,x∈Rn+1,wk∈Rn+1。

721

721

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?