本文文字内容来自于《Transformer模型的可视化介绍|深度学习什么是 GPT|探索流经大模型的数据》,该视频由CDA数据科学研究院赵安豆博士重磅推出,有兴趣的小伙伴可以点击下方链接观看,了解更多关于Transformer模型的内容

https://edu.cda.cn/goods/show/3645

引言

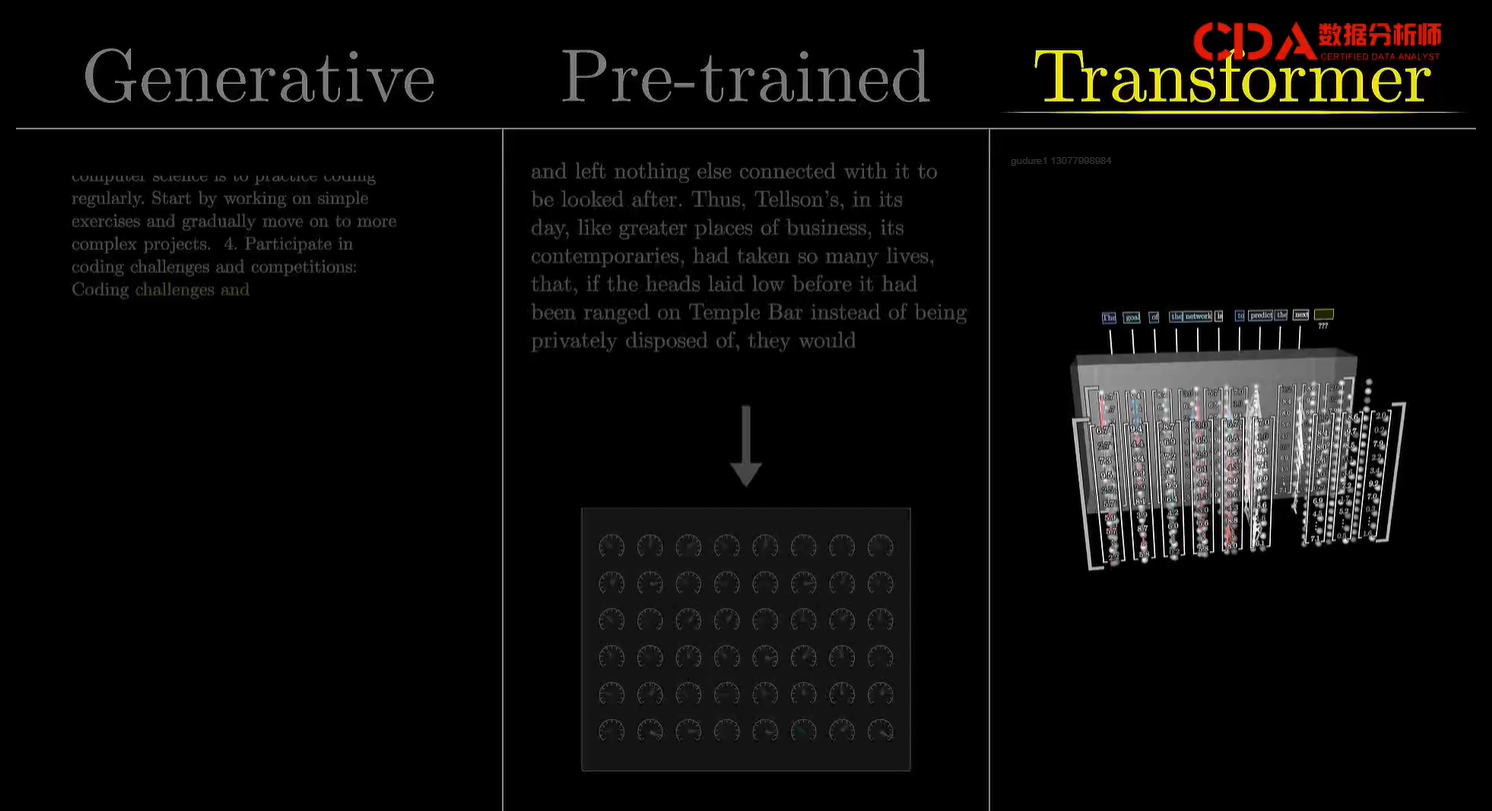

本文将深入探讨GPT及其背后的Transformer模型。GPT,即Generative Pre-trained Transformer,是一种用于生成新文本的强大模型,从基础开始,逐步理解Transformer的工作原理,并探索数据在其中的流转过程。

GPT与Transformer简介

GPT概述

GPT,全称为Generative Pre-trained Transformer,是一种基于Transformer结构的预训练语言模型。利用大量文本数据进行学习,能够生成连贯且富有逻辑性的文本。GPT系列模型,如GPT-2、GPT-3等,通过不断增大模型规模和训练数据量,显著提升了文本生成的质量和应用能力。

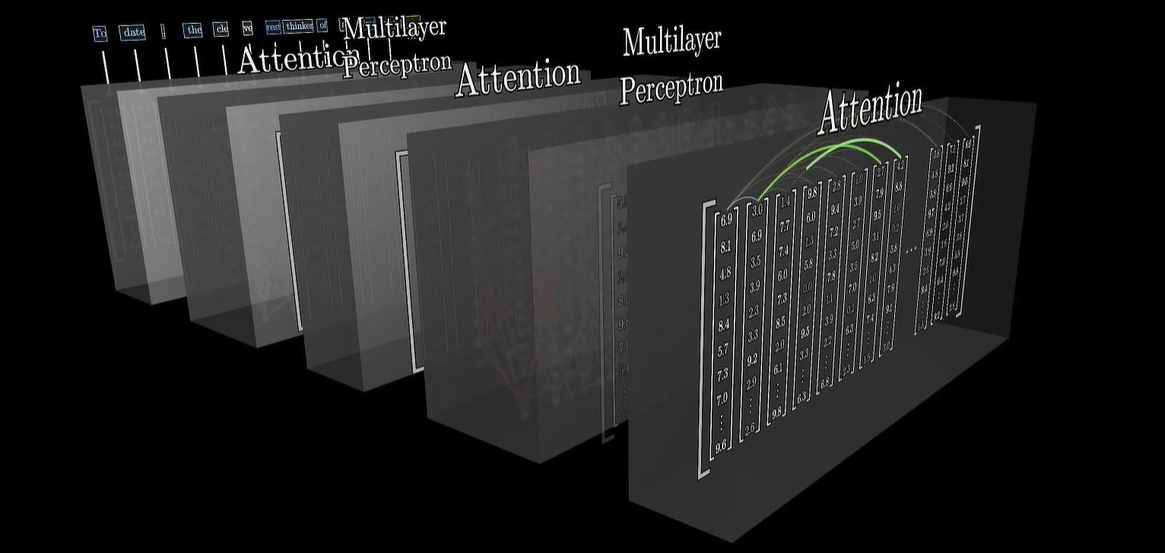

Transformer模型

Transformer是一种基于自注意力机制的神经网络模型,由Google在2017年提出。与传统的RNN或LSTM相比,Transformer能够并行处理输入数据,大大提高了计算效率。Transformer的核心组件包括注意力模块(Attention Block)和前馈神经网络(Feed-forward Neural Network)。

Transformer的工作原理

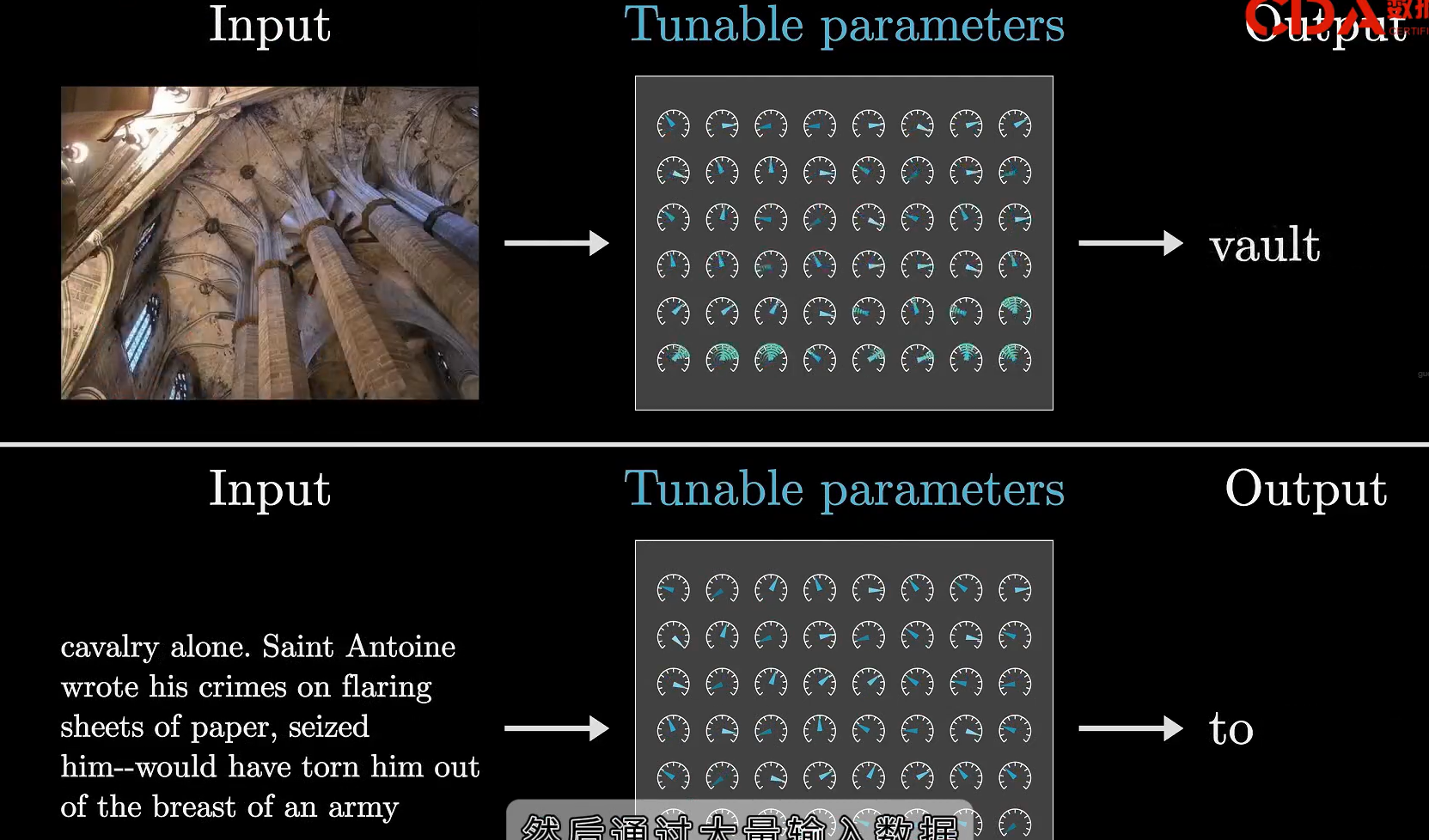

数据输入与处理

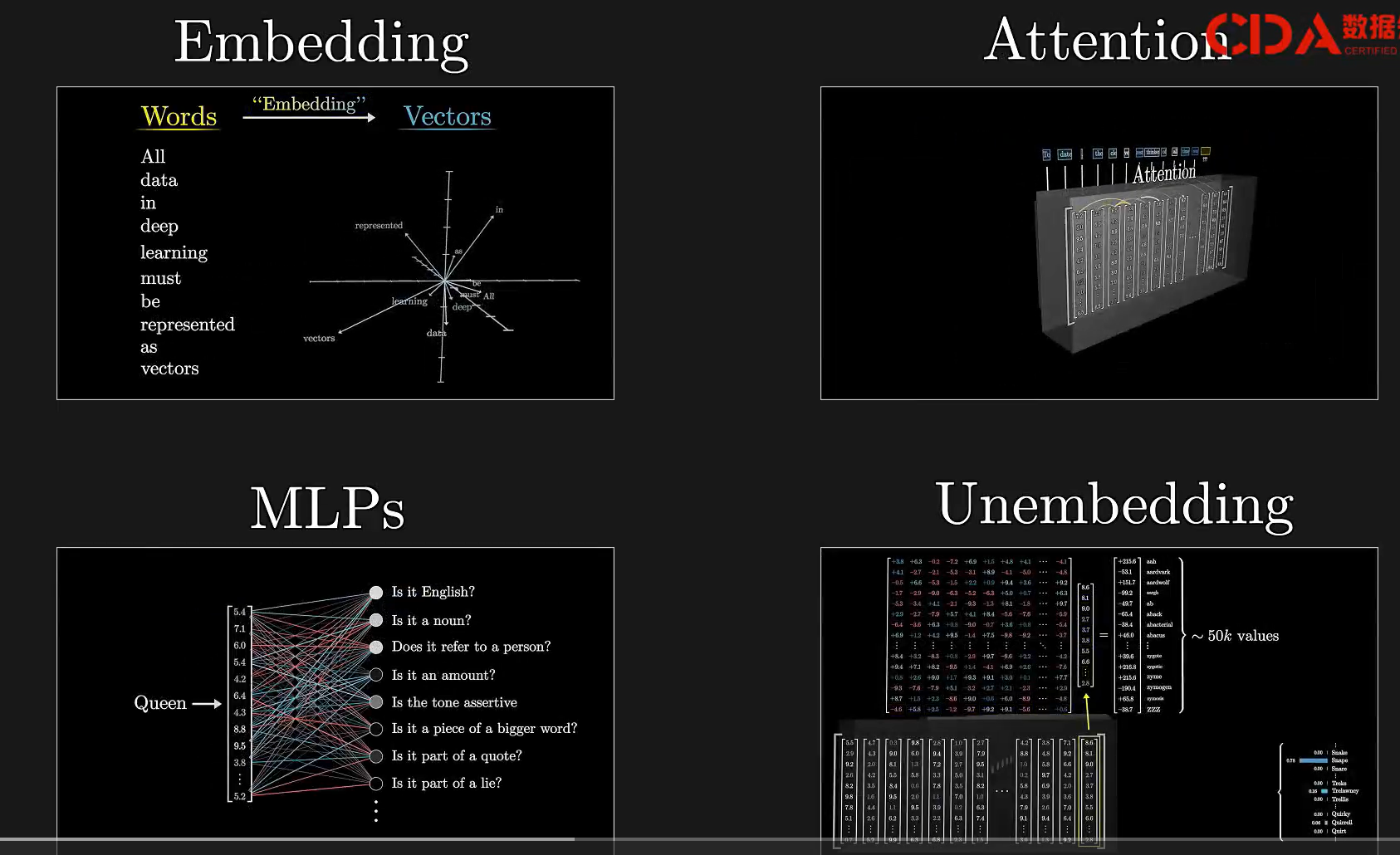

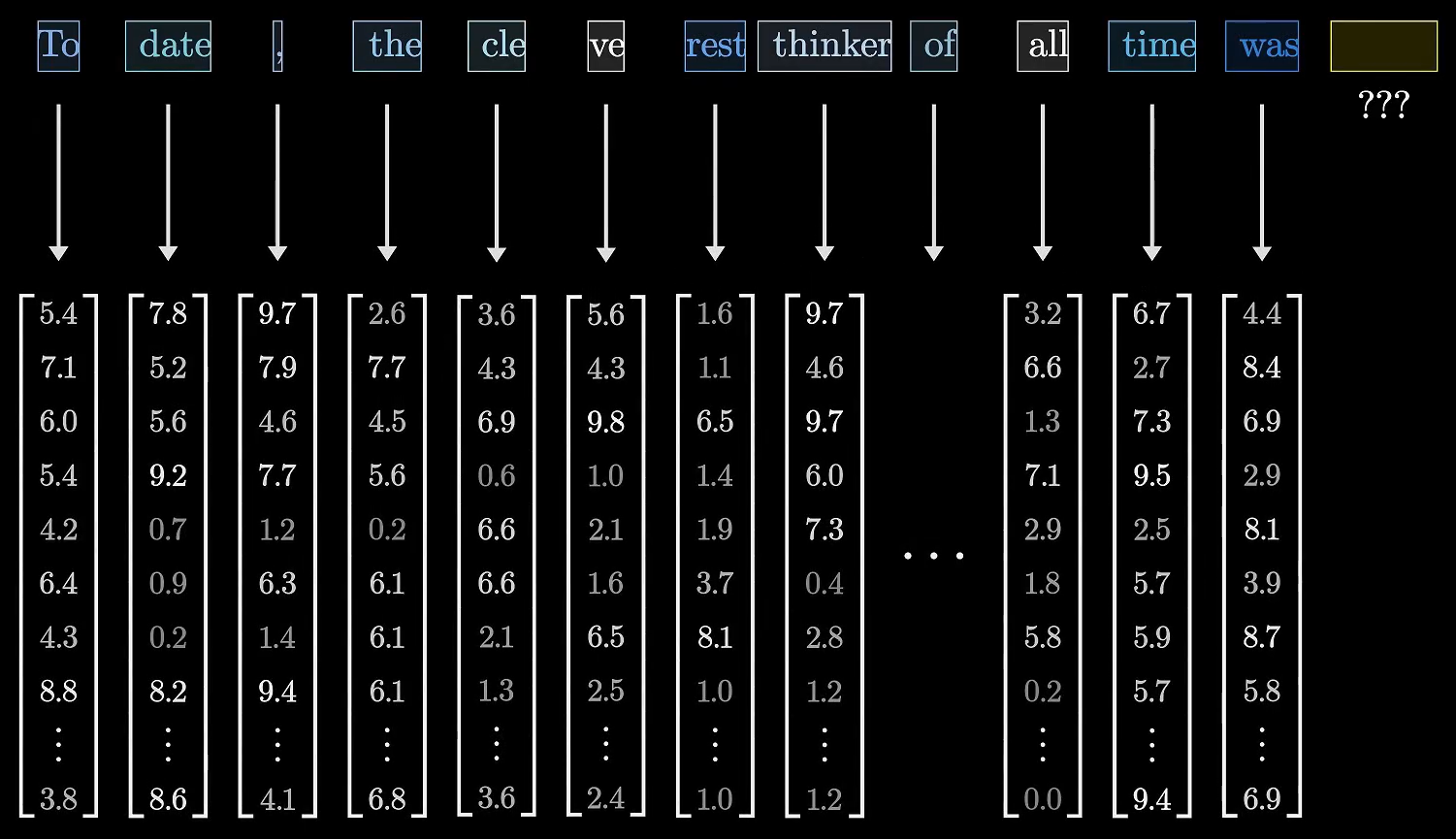

在Transformer模型中,输入的数据首先被拆分成一系列的词元(Tokens),每个Token对应一个向量。这些向量表示了Token在特定上下文中的含义。对于文本输入,Token通常是单词或单词的一部分;对于图像或声音输入,Token则可能代表图像的小块或声音的小片段。

注意力模块

注意力模块是Transformer模型的核心。在这一阶段,每个Token的向量都会与其他Token的向量进行交互,以更新自身的值。这种交互过程通过自注意力机制实现,能够捕捉Token之间的依赖关系。注意力机制使得模型能够更好地理解文本的含义和上下文。

前馈神经网络

经过注意力模块处理后,Token的向量会进入前馈神经网络(也称为多层感知机,MLP)。在这一阶段,每个向量都会并行地经历一系列的非线性变换,以进一步增强模型的表达能力和特征提取能力。前馈神经网络的作用类似于对每个Token的向量进行“精细化处理”。

重复处理与输出

上述过程(注意力模块+前馈神经网络)会在Transformer模型中重复多次,以确保每个Token的向量都能够充分融合上下文信息。最后,模型会输出一个包含所有可能Token的概率分布。这个概率分布表示了接下来可能出现的任何小段文本。

GPT模型的生成能力

GPT模型的强大之处在于其生成能力。通过给模型一个初始片段,它可以基于概率分布预测并生成下一个词或短语。通过不断重复这个过程,GPT可以生成一个连贯且富有逻辑性的文本序列。GPT系列模型,尤其是GPT-3,由于其庞大的规模和训练数据量,能够生成更加复杂和多样化的文本内容。

故事生成示例

在演示中,可以看到GPT模型如何根据一个初始片段生成一个故事。例如,给GPT模型一个关于“π生物”的简短描述,能够生成一个充满想象力和逻辑性的故事,描述这些生物如何生活在一个充满数学和计算的世界里。这种生成能力不仅展示了GPT模型的强大,也提供了无限的创作可能性。

Transformer在AI中的应用

Transformer模型不仅在语言生成领域取得了巨大成功,还在其他多个AI领域得到了广泛应用。例如:

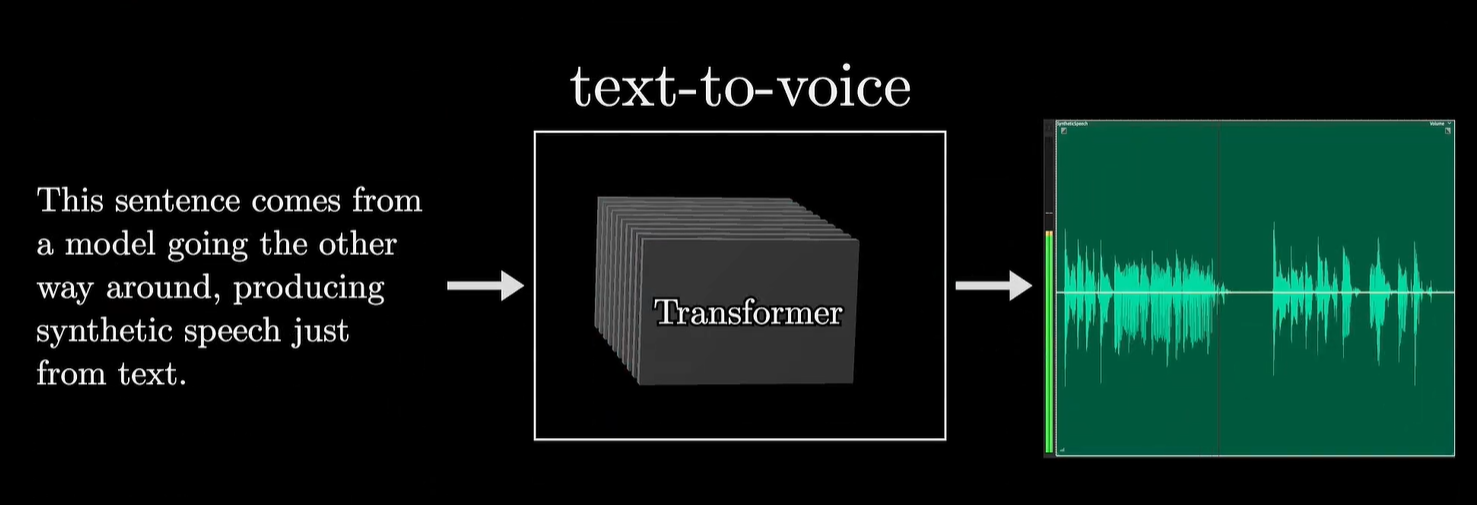

- 文本到语音:利用Transformer模型将文本转换成自然流畅的语音。

- 图像生成:如DALL-E和MidJourney等工具,能够将文本描述转化为逼真的图像。

- 机器翻译:最初的Transformer模型就是用于机器翻译任务的,并取得了显著成效。

总结与展望

Transformer模型及其衍生的GPT系列模型是AI领域的重要里程碑。不仅推动了自然语言处理技术的进步,还提供了更多创新和应用的可能性。随着技术的不断发展,相信Transformer模型将在更多领域展现出其独特的魅力和价值。

通过本文的介绍,希望能够帮助大家更好地理解GPT和Transformer模型的工作原理和应用场景。同时,也期待在未来的研究和实践中不断探索和发现更多关于Transformer模型的奥秘和价值。

最后,有兴趣的小伙伴可以点击下方链接观看视频,了解更多关于Transformer模型的内容

2863

2863

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?