目录

2.2 Convolutional Architecture

论文地址 《Convolutional Sequence to Sequence Learning》

1 Introduction

众所周知,RNN本身的一个缺陷:由于下一个时刻的输出要依赖于上一个时刻的输出,从而导致无法在整个序列上进行并行处理,这会引起训练时间过长的问题。针对这一问题,ConvS2S的做法是将CNN引入到Seq2Seq中,这样既可以处理序列变长的问题,又可以实现在序列不同位置的并行计算。

以前典型的seq2seq任务中,大多数都是使用RNN来实现的。RNN链式结构,可以很好的序列结构信息。FB一直执着于使用CNN来解决问题也正是因为RNN存在上units之间的时序传递,不可以并行计算,计算速度很慢,还有就是RNN中只依赖于最后state的状态很难利用句子中的结构信息,以及对于句子中的初始单词的信息保留的程度不够,很难把握很复杂句子结构中的信息。相比较CNN而言以上这几个缺点都可以很好的被解决。一方面CNN可以并行计算,效率变高。另一方面CNN可以通过层级结构捕获句子中词语之间的远距离依赖关系,也就可以处理复杂句子信息。

2 Network

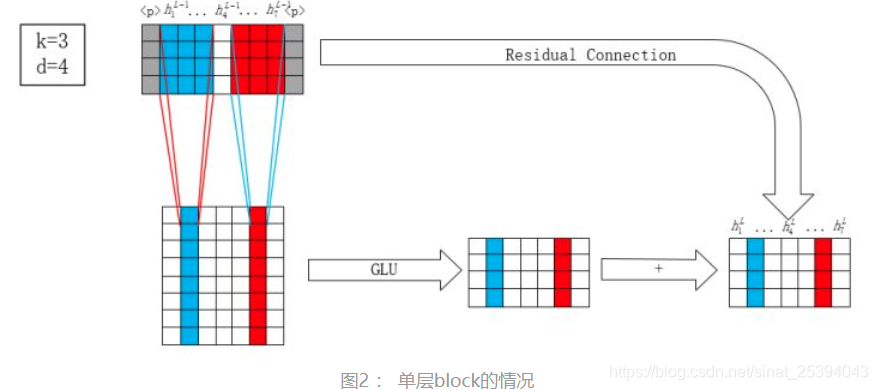

上左encoder部分:通过层叠的卷积抽取输入源语言(英语)sequence的特征,图中直进行了一层卷积。卷积之后经过GLU激活做为encoder输出。

下左decoder部分:采用层叠卷积抽取输出目标语言(德语)sequence的特征,经过GLU激活做为decoder输出。

中左attention部分:把decoder和encoder的输出做点乘,做为输入源语言(英语)sequence中每个词权重。

中右Residualconnection:把attention计算的权重与输入序列相乘,加入到decoder的输出中输出输出序列。

2.1 Symbols

2.2 Convolutional Architecture

2.3 Multi-step Attention

2.4 Generation

References

从《Convolutional Sequence to Sequence Learning》到《Attention Is All You Need》

论文笔记<1> ConvS2S:Convolutional Seq to Seq Learning

543

543

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?