Logistic回归

1. Logistc回归模型

回归:用一条直线对给定数据进行拟合(最佳拟合直线)

Logistic 回归:根据现有数据对分类边界建立回归方程,以此直线进行分类

给定数据集 \( [(x_{1},y_{1}),(x_{2},y_{2}),…,(x_{m},y_{m})] \) ,每个样本 x 有 d 个属性 \( x=[x_{1},x_{2},…,x_{d}] \) 。

对于给定数据集,该数据集的线性拟合公式为:

f ( x ) = w 0 x 0 + w 1 x 1 + w 2 x 2 + . . . + w d x d f(x) = w_{0}x_{0}+w_{1}x_{1}+w_{2}x_{2}+...+w_{d}x_{d} f(x)=w0x0+w1x1+w2x2+...+wdxd

f ( x ) = w T x f(x) = w^{T}x f(x)=wTx

其中 \( w^{T}=[w_{0},w_{1},w_{2},…,w_{d}] \)

若要进行分类任务(以二分类为例),需要找到一个单调可微的函数将分类任务的真实标记 y 和线性回归模型的预测值关联起来。

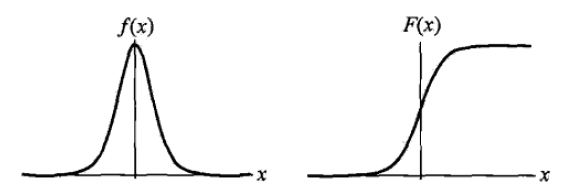

分类输出标记 y = {0 , 1} , 回归模型的预测值 \( z = w^{T}x \) , 因此需要一个函数将 z 转化为 0 / 1 值。 最理想的函数是 “ 单位阶跃函数 ”,但是这个函数是不连续的函数,它的跳跃点从0到1的跳跃过程很难处理。需要一个近似单位阶跃的函数,更容易处理且单调可微,这就是 “ 对几率函数(logistic function) ” 函数 ,它是“Sigmoid函数”的一种 。

y w ( x ) = 1 1 + z − 1 = 1 1 + ( w T x ) − 1 y_{w}(x) = \frac{1}{1+z^{-1} }= \frac{1}{1+(w^{T}x)^{-1}} yw(x)=1+z−11=1+(wTx)−11

y = { 1 if z > 0 0.5 if z = 0 0 if z < 0 y = \begin{cases} 1 & \text{ if } z>0 \\ 0.5 & \text{ if } z=0 \\ 0 & \text{ if } z<0 \end{cases} y=⎩⎪⎨⎪⎧10.50 if z>0 if z=0 if

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3807

3807

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?