1.简介:

组织机构:Meta(Facebook)

代码仓:https://github.com/facebookresearch/llama https://github.com/ymcui/Chinese-LLaMA-Alpaca-2

模型:chinese-alpaca-2-7b-hf

下载:使用百度网盘下载

硬件环境:暗影精灵7Plus

Ubuntu版本:18.04

内存 32G

GPU显卡:Nvidia GTX 3080 Laptop (16G)

2.代码和模型下载

chinese-alpaca-2-7b-hf的模型从官网下载:

将chinese-alpaca-2-7b-hf的模型传到 ~/models目录下:

3.安装依赖

conda create -n vllm310 python=3.10 -y

conda activate vllm310

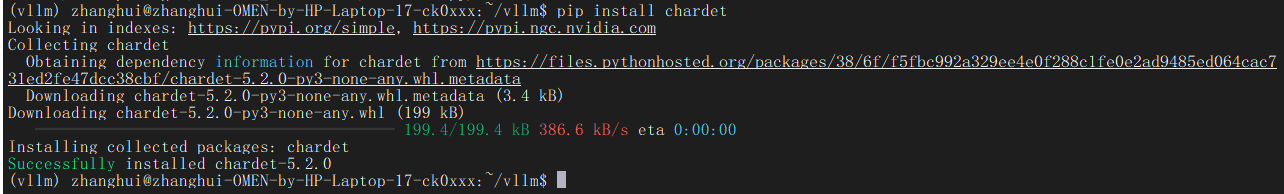

pip install chardet

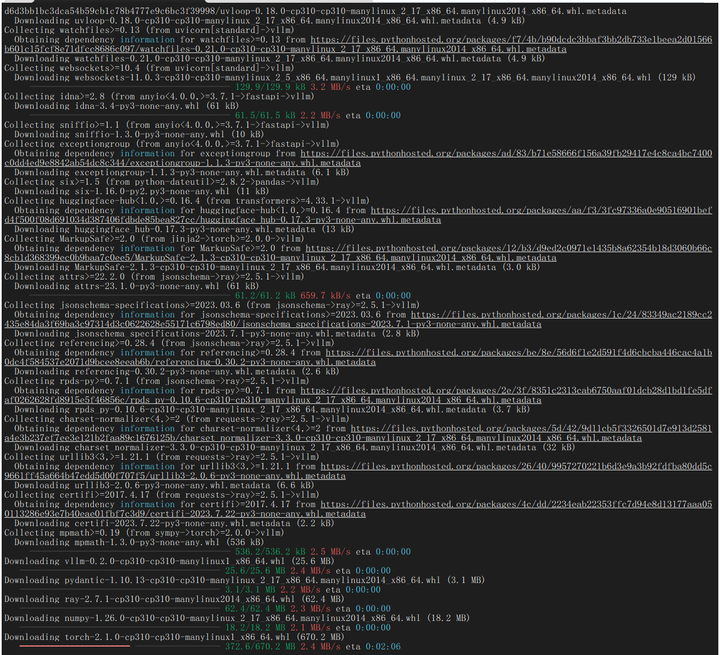

pip install vllm

4.部署验证

准备脚本:

cd ~/vllm

vi test_vllm.py

# 导入 vLLM 所需的库

from vllm import LLM, SamplingParams

# 定义输入提示的列表,这些提示会被用来生成文本

prompts = [

"[INST] <<SYS>>\nYou are a helpful assistant. 你是一个乐于助人的助手。\n<</SYS>>\n\n [/INST] 你好,我叫",

"[INST] <<SYS>>\nYou are a helpful assistant. 你是一个乐于助人的助手。\n<</SYS>>\n\n [/INST] 意大利国的总统是",

"[INST] <<SYS>>\nYou are a helpful assistant. 你是一个乐于助人的助手。\n<</SYS>>\n\n [/INST] 尼日利亚的首都是",

"[INST] <<SYS>>\nYou are a helpful assistant. 你是一个乐于助人的助手。\n<</SYS>>\n\n [/INST] 人工智能的未来是",

]

# 定义采样参数,temperature 控制生成文本的多样性,top_p 控制核心采样的概率

sampling_params = SamplingParams(temperature=0.8, top_p=0.95, max_tokens=512)

# 初始化 vLLM 的离线推理引擎,这里选择的是 "/root/chinese-llama2" 模型

llm = LLM(model="/home/zhanghui/models/chinese-alpaca-2-7b-hf")

# 使用 llm.generate 方法生成输出文本。

# 这会将输入提示加入 vLLM 引擎的等待队列,并执行引擎以高效地生成输出

outputs = llm.generate(prompts, sampling_params)

# 打印生成的文本输出

for output in outputs:

prompt = output.prompt # 获取原始的输入提示

generated_text = output.outputs[0].text # 从输出对象中获取生成的文本

print(f"Prompt: {prompt!r}, Generated text: {generated_text!r}")运行脚本:

python test_vllm.py

运行成功。

482

482

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?