目录

1. 例子介绍

上次我们知道了 RL 之中的 Q-learning 方法是在做什么事, 今天我们就来说说一个更具体的例子. 让探索者学会走迷宫. 黄色的是天堂 (reward 1), 黑色的地狱 (reward -1). 大多数 RL 是由 reward 导向的, 所以定义 reward 是 RL 中比较重要的一点.

2. 算法

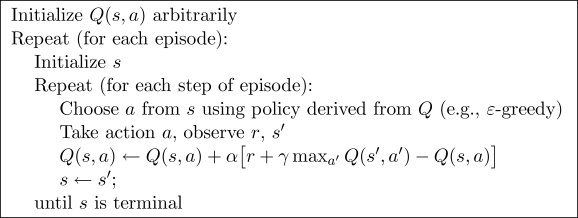

整个算法就是一直不断更新 Q table 里的值, 然后再根据新的值来判断要在某个 state 采取怎样的 action. Qlearning 是一个 off-policy 的算法, 因为里面的 max action 让 Q table 的更新可以不基于正在经历的经验(可以是现在学习着很久以前的经验,甚至是学习他人的经验). 不过这一次的例子, 我们没有运用到 off-policy, 而是把 Qlearning 用在了 on-policy 上, 也就是现学现卖, 将现在经历的直接当场学习并运用. On-policy 和 off-policy 的差别我们会在之后的 Deep Q network (off-policy) 学习中见识到. 而之后的教程也会讲到一个 on-policy (Sarsa) 的形式, 我们之后再对比.

2.1 算法的代码形式

这一节我们先来编写算法部分(如上图所示),下一节再来编写Q table或者说是agent如何思考的(Q table如何更新)。

首先我们先 import 两个模块, maze_env 是我们的环境模块, 已经编写好了, 大家可以直接在这里下载, maze_env 模块我们可以不深入研究, 如果你对编辑环境感兴趣, 可以去看看如何使用 python 自带的简单 GUI 模块 tkinter 来编写虚拟环境. 莫烦也有对应的教程. maze_env 就是用 tkinter 编写的. 而 RL_brain 这个模块是 RL 的大脑部分, 我们下节会讲.

from maze_env import Maze

from RL_brain import QLearningTable下面的代码, 我们可以根据上面的图片中的算法对应起来, 这就是整个 Qlearning 最重要的迭代更新部分啦.

def update():

# 学习 100 回合

for episode in range(100):

# 初始化 state 的观测值

observation = env.reset()

while True:

# 更新可视化环境

env.render()

# RL 大脑根据 state 的观测值挑选 action

action = RL.choose_action(str(observation))

# 探索者在环境中实施这个 action, 并得到环境返回的下一个 state 观测值, reward 和 done (是否是掉下地狱或者升上天堂)

observation_, reward, done = env.step(action)

# RL 从这个序列 (state, action, reward, state_) 中学习

RL.learn(str(observation), action, reward, str(observation_))

# 将下一个 state 的值传到下一次循环

observation = observation_

# 如果掉下地狱或者升上天堂, 这回合就结束了

if done:

break

# 结束游戏并关闭窗口

print('game over')

env.destroy()

if __name__ == "__main__":

# 定义环境 env 和 RL 方式

env = Maze()

RL = QLearningTable(actions=list(range(env.n_actions)))

# 开始可视化环境 env

env.after(100, update)

env.mainloop()2.2 Q Table主程序

与上回不一样的地方是, 我们将要以一个 class 形式定义 Q learning, 并把这种 tabular q learning 方法叫做 QLearningTable.

class QLearningTable:

# 初始化

def __init__(self, actions, learning_rate=0.01, reward_decay=0.9, e_greedy=0.9):

# 选行为

def choose_action(self, observation):

# 学习更新参数

def learn(self, s, a, r, s_):

# 检测 state 是否存在

def check_state_exist(self, state):2.2.1 预设值

初始的参数意义不会在这里提及了, 请参考这个快速了解通道机器学习系列之Q-Learning

import numpy as np

import pandas as pd

class QLearningTable:

def __init__(self, actions, learning_rate=0.01, reward_decay=0.9, e_greedy=0.9):

self.actions = actions # a list

self.lr = learning_rate # 学习率

self.gamma = reward_decay # 奖励衰减

self.epsilon = e_greedy # 贪婪度

self.q_table = pd.DataFrame(columns=self.actions, dtype=np.float64) # 初始 q_table2.2.2 决定行为

这里是定义如何根据所在的 state, 或者是在这个 state 上的 观测值 (observation) 来决策. 在上一个例子中(2.2 Q-Learning简单例子),状态的个数是设定好的,我们在这个例子中不设定状态的个数。

def choose_action(self, observation):

self.check_state_exist(observation) # 检测本 state 是否在 q_table 中存在(见后面标题内容)

# 选择 action

if np.random.uniform() < self.epsilon: # 选择 Q value 最高的 action

state_action = self.q_table.loc[observation, :]

# 同一个 state, 可能会有多个相同的 Q action value, 所以我们乱序一下

action = np.random.choice(state_action[state_action == np.max(state_action)].index)

else: # 随机选择 action

action = np.random.choice(self.actions)

return action2.2.3 学习

同上一个简单的Q Learning例子 一样, 我们根据是否是 terminal state (回合终止符) 来判断应该如何更行 q_table. 更新的方式是不是很熟悉呢:

update = self.lr * (q_target - q_predict)

这可以理解成神经网络中的更新方式, 学习率 * (真实值 - 预测值). 将判断误差传递回去, 有着和神经网络更新的异曲同工之处.

def learn(self, s, a, r, s_):

self.check_state_exist(s_) # 检测 q_table 中是否存在 s_ (见后面标题内容)

q_predict = self.q_table.loc[s, a]

if s_ != 'terminal':

q_target = r + self.gamma * self.q_table.loc[s_, :].max() # 下个 state 不是 终止符

else:

q_target = r # 下个 state 是终止符

self.q_table.loc[s, a] += self.lr * (q_target - q_predict) # 更新对应的 state-action 值2.2.4 检测 state 是否存在

这个功能就是检测 q_table 中有没有当前 state 的步骤了, 如果还没有当前 state, 那我我们就插入一组全 0 数据, 当做这个 state 的所有 action 初始 values.

def check_state_exist(self, state):

if state not in self.q_table.index:

# append new state to q table

self.q_table = self.q_table.append(

pd.Series(

[0]*len(self.actions),

index=self.q_table.columns,

name=state,

)

)如果想一次性看到全部代码, 请去我的 Github

3126

3126

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?