来源:专知

本文约3000字,建议阅读5分钟在本论文中,我们将描述贯穿整个机器学习流程的研究,这些研究桥接了这些方法,并利用社会影响来指导技术工作。

随着机器学习的广泛普及,社会效益的机会与潜在的风险并存。负责任的机器学习难以实现,因为技术方法可能优先考虑便利性,并采用数学定义的公平性,这种定义往往忽略了现实世界中相关的公平概念。相反,社会方法和理论可能会产生过于抽象的结果,难以有效转化为实践。在本论文中,我们将描述贯穿整个机器学习流程的研究,这些研究桥接了这些方法,并利用社会影响来指导技术工作。

首先,我们将讨论数据集偏差的含义,特别是考虑视觉图像数据集。然后,我们将探讨这种偏差在模型训练中的影响,特别是在微调和引入交叉性时的背景下。最后,我们将讨论公平性测量的复杂问题。我们将通过涵盖偏差放大的复杂性、思考刻板印象带来的实际危害,以及展示如何在图像描述任务中测量多种表现性伤害,来实现这一目标。在这些工作中,我们将展示,尽管从技术上便利地将平等置于无上下文的考虑中,但更深入地参与社会背景,使我们能够实现更为公平的操作化形式。总体而言,我们将探索如何将负责任的机器学习中对平等的狭隘关注扩展为涵盖更广泛的公平性理解,从而更实质性地与社会背景互动。

随着机器学习(ML)从研究阶段走向现实世界,它正在改变社会。这种转变带来了巨大的潜在利益,但同时也引发了重大担忧,尤其是关于这些应用的公平性问题:表现差异 [68]、不公平的风险预测 [15]、刻板印象的搜索结果 [333] 等等。到目前为止,我们往往以平等的角度来思考公平性,这在数学上便于表达(例如,各群体之间的准确率相等)。然而,现在负责任的机器学习问题已受到广泛关注,并且也有了推动这些问题的动力,我们需要更接近公平的表述。公平作为一种衡量标准,考虑了社会背景和历史不公,通过认识到不同人有不同的境况,因此需要不同的需求。这也使得将公平作为衡量标准在机器学习模型中变得更难以量化和操作化。然而,这一点至关重要,因为只有这样,我们才能确保技术进步不会像历史上那样将边缘化群体抛在身后。

在关于算法偏见的社会科学和人文学科方面,已有广泛的文献和整个研究领域在进行重要工作。然而,“正义”和“公平”等概念如何在机器学习中实现并不总是清晰的,这或许可以部分解释为什么现有的技术方法往往倾向于选择数学上方便的平等概念。尽管这些社会背景的概念远不能完全量化,也不能指望技术会成为解决这些问题的途径,但认为这些概念过于定性和主观,因而无法量化的想法是有害的,并导致了它们的忽视。接下来,我将描述一个研究议程,旨在将这些关键的社会构建操作化到机器学习中。在此过程中,必然会有取舍,每种方法都有其自身的局限性。然而,只有通过全面应对和参与现实世界中的复杂现实,我们才能构建更接近公平的机器学习系统。

这一点在机器学习的各个方面都具有相关性——换句话说,不仅仅是构建机器学习系统时,还要考虑该系统所嵌入的结构、允许的使用案例和问题定义。然而,出于本论文的范围限制,我们将主要关注机器学习系统本身的各个方面,同时承认有时最重要的问题是是否应该构建某个特定系统。

在本论文中,我们将介绍为实现这一负责任机器学习操作化目标所做的研究,从数据集开始,逐步进入模型训练,最后以模型评估作为结尾。

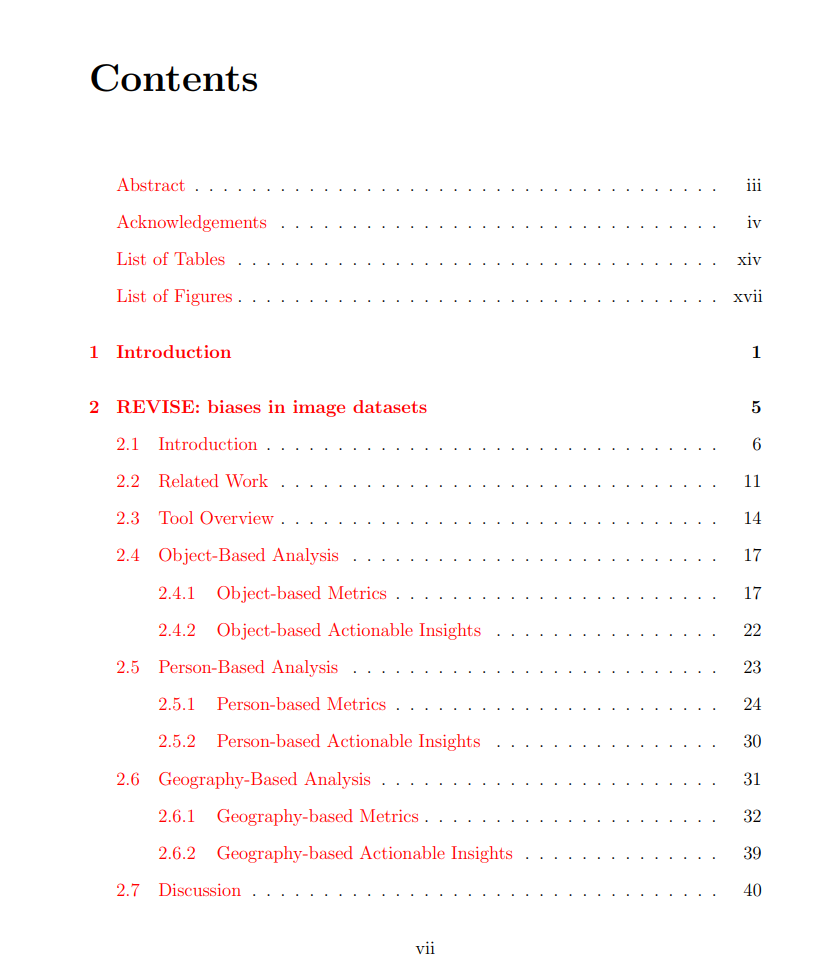

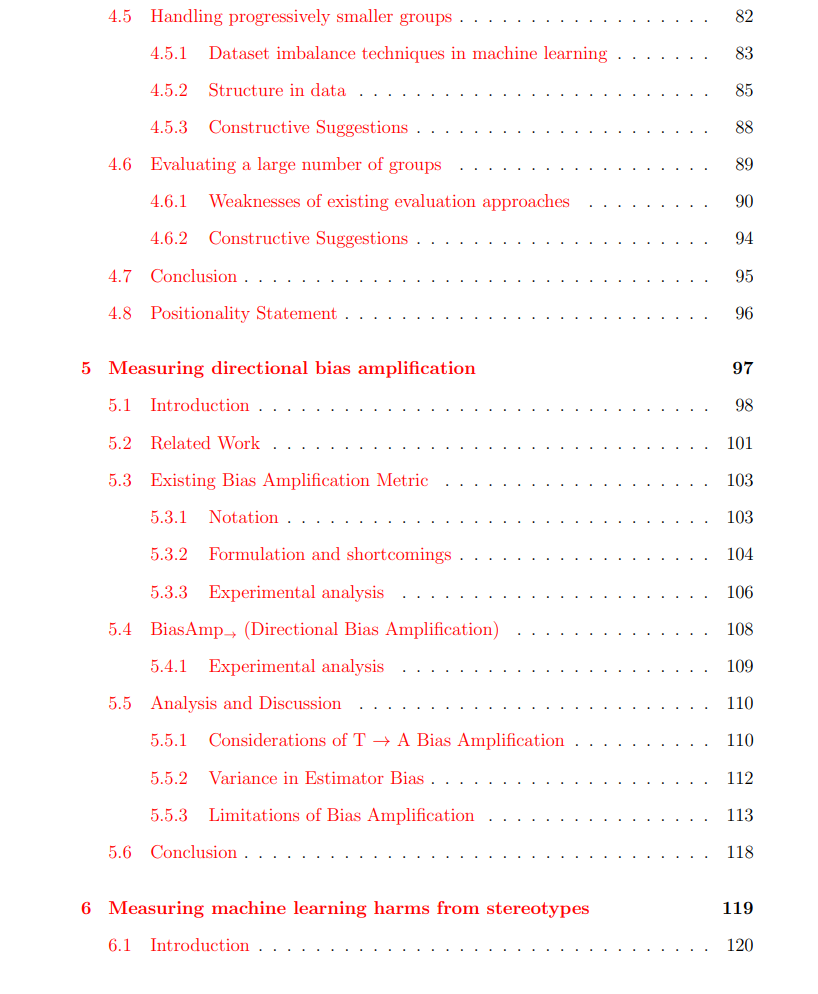

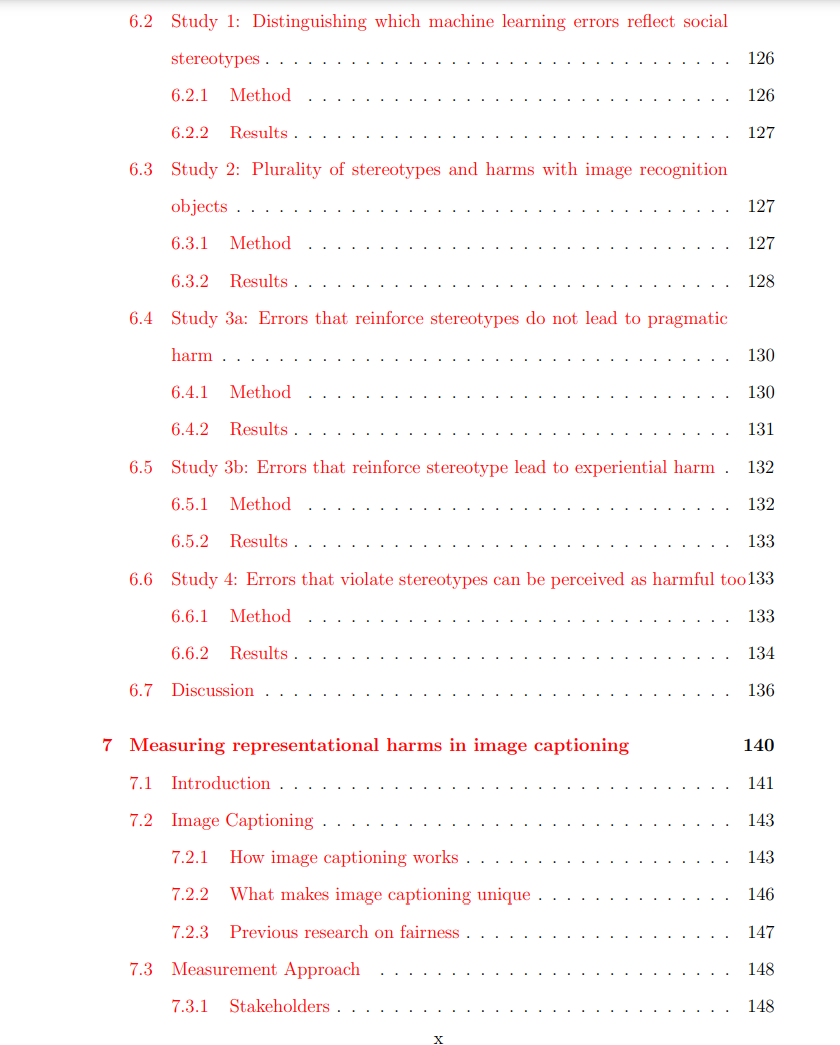

首先,在第二章中,我们将讨论机器学习数据集中的偏见。具体来说,我们将考虑图像数据集。数据集是所有机器学习模型的基础,并且不可避免地在如何表示世界方面包含偏见。究竟哪种偏见最终会造成危害,取决于下游应用,但对于数据集的创建者和使用者来说,了解他们构建和使用的数据集具有哪种偏见特征非常重要。鉴于这些数据集的规模和其潜在的偏见,我们提出了一种工具,可以半自动化地发现这些偏见。

接下来,我们将转向ML模型的训练。在第三章中,我们将讨论数据集在预训练和微调中的作用。目前,模型和数据集的规模过大,无法每次都从头开始合理地训练。相反,我们利用迁移学习的力量,首先在更大的数据集上对模型进行预训练,然后再对较小的、更特定于应用的数据集进行微调。人们常常担心用于预训练的大规模数据集中存在的偏见,但在这项工作中,我们表明,通过对微调数据集的相对较小的调整,可以克服这种预训练偏见,且对性能的影响微乎其微。考虑到模型训练的另一个相关因素,在第四章中,我们将讨论公平性方法通常只关注两个群体,例如男性和女性、白人和黑人。然而,现实世界远比这复杂得多,需要理解和参与交叉性。在这项工作中,我们不仅提供了包含交叉性的指导,还具体说明了如何做到这一点。

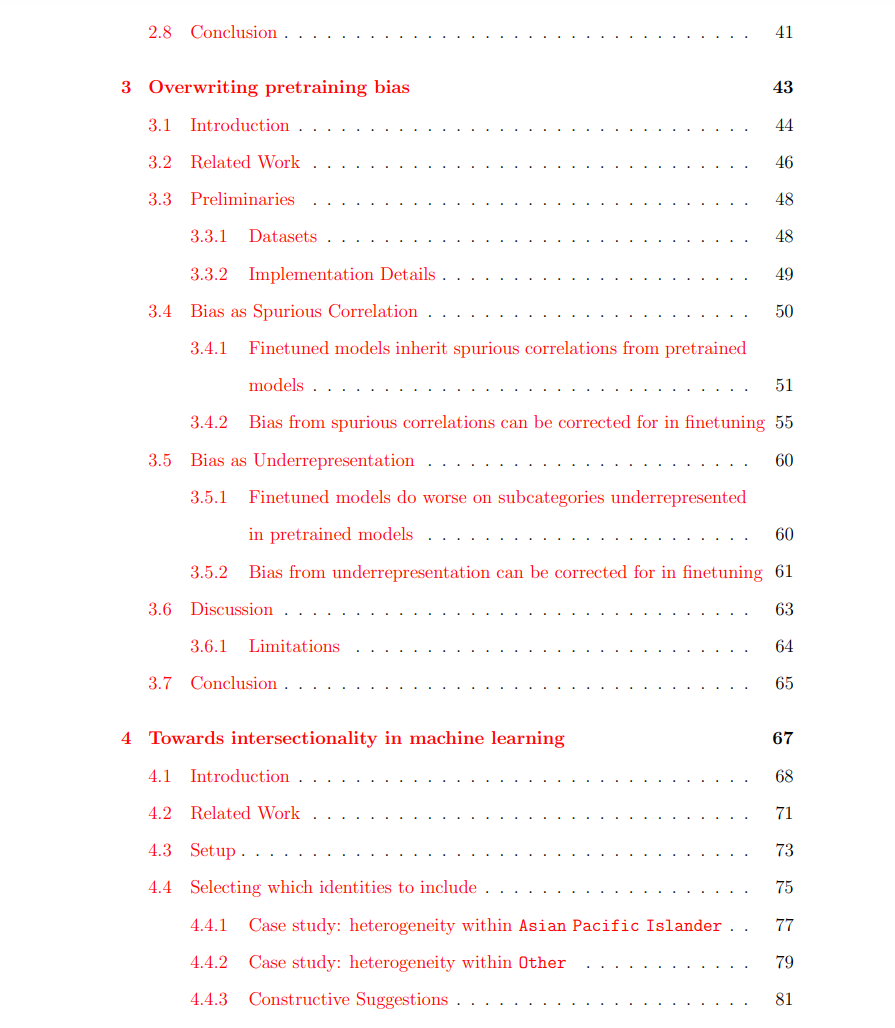

继续沿着机器学习管道向前推进,最后三章将讨论公平性评估,特别关注这一常常被忽视的步骤。在这三章中,我们将首先在第五章中讨论操作化社会偏见放大的方法。在此过程中,我们将展示我们在技术工作中习以为常的假设如何不总能转化为社会环境,因为破坏这些假设会带来新的道德影响。社会偏见放大可以被认为是由刻板印象驱动的,因此在第六章中,我们将探讨机器学习误分类对人们造成的实际危害,这些危害可能会强化或打破刻板印象。在此过程中,我们将明确测量危害的标准,并提出实际危害和体验性危害的不同类别。我们的实证人类研究结果显示性别刻板印象在不同性别群体中的差异性危害,这促使我们思考社会身份在认知权威方面的相关性。最后,在第七章中,我们将综合这些主题,提出一套全面的测量技术,用于评估图像描述系统可能产生的表现性危害。许多这些测量之间可能存在冲突,即无法同时提高。因此,通过提出一大套测量方法,而不是集中于单一或多个平均值,我们希望直接揭示这些张力,并展示模型选择和训练将如何需要处理我们对公平机器学习系统的具体期望。

总而言之,我们将走过整个机器学习管道,从数据集开始,最终以评估为结尾,同时展示如何通过更实质性地参与社会背景,来构建更加公平的机器学习系统。

关于我们

数据派THU作为数据科学类公众号,背靠清华大学大数据研究中心,分享前沿数据科学与大数据技术创新研究动态、持续传播数据科学知识,努力建设数据人才聚集平台、打造中国大数据最强集团军。

新浪微博:@数据派THU

微信视频号:数据派THU

今日头条:数据派THU

1947

1947

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?